朱玉可团队

朱玉可是德克萨斯大学奥斯汀分校计算机科学系的助理教授,也是机器人感知与学习 (RPL) 实验室的主任。还是 NVIDIA 研究部门的首席研究科学家,在那里朱玉可共同领导了通用具身代理研究 (GEAR) 小组。他于2019年9月在斯坦福大学获得博士学位,与李飞飞教授和西尔维奥·萨瓦雷兹教授一起在斯坦福大学视觉与学习实验室工作。

朱教授的目标是为自主机器人和具身代理构建算法和系统,使其能够推理并与现实世界互动。他的研究涉及机器人技术、机器学习和计算机视觉的交叉领域;专注于开发感知和决策的方法和原理,以实现野外通用机器人的自主性。

主题相关作品

- HARMON

- OKAMI

HARMON

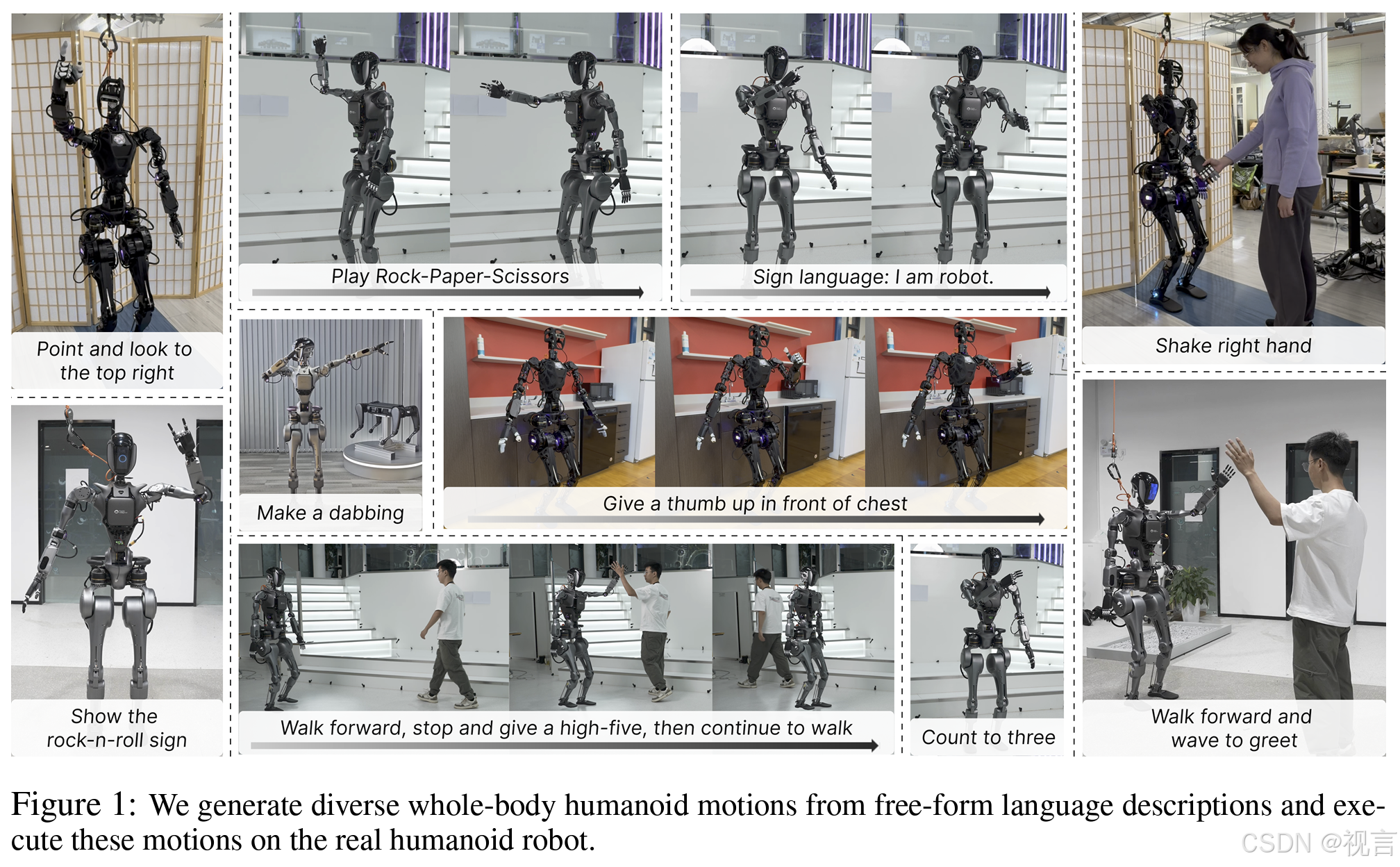

人形机器人由于其类似人类的外形,具有无缝融入人类环境的潜力。为了与人类共存并进行合作,关键在于它们能够理解自然语言交流并展示类似人类的行为。本研究的重点是从语言描述中生成多样化的人形机器人全身运动。本文利用大量人类运动数据集中的人类运动先验来初始化人形机器人的动作,并运用视觉语言模型(VLMs)的常识推理能力来编辑和优化这些动作。通过模拟和现实实验验证,本文的方法展示了生成自然、富有表现力且与文本对齐的人形机器人运动的能力。

方法

人形机器人由于其类似人类的体型,在无缝融入人类世界方面具有巨大的潜力。我们设想这些机器人能够在以人为中心的环境中运行,并与人类在共享的物理空间中共存。为了使人形机器人能够在工作和生活中与我们共处,这些机器人应具备理解类似我们日常对话的自然语言指令的能力。此外,展示出类似人类的行为将使这些机器人更加具备社交性和可预测性,从而增强人与机器人之间的高效、安全合作。为此,本研究致力于开发一种从文本描述中生成人形机器人多样化行为的方法。本文的方法以自然语言描述所需的动作为输入,并生成相应的全身运动。

从语言描述中训练模型生成自然的人形机器人运动具有挑战性,因为缺乏大规模的语言-运动对照数据集。幸运的是,由于人类与人形机器人之间的体态差距较小,可以利用大量以人为中心的数据源进行模型训练。尤其是,现有的大规模人类运动数据非常丰富[1–5]。这些数据与语言描述相结合,涵盖了广泛的人类运动。这些人类运动可以映射到人形机器人上,作为运动生成的先验信息。然而,人类模型与人形机器人之间的差异阻碍了直接运动重定向的有效性。首先,人类运动数据集中通常缺少头部和手指的运动数据,因此无法生成这些身体部位的人形机器人动作。然而,这些动作对于机器人全身运动的表现力至关重要。此外,由于人形机器人的运动学约束,重定向过程无法精确地在机器人上复制人类运动,可能会改变动作的语义含义和清晰度。

在本研究中,本文提出了HARMON(Humanoid Robot Motion Generation),通过结合人类运动先验,从自由形式的语言描述中生成人形机器人全身运动。本文采用了PhysDiff [6],一种基于扩散的生成模型,该模型在大规模人类运动数据集上进行训练,能够根据语言描述生成人类运动。PhysDiff在扩散过程中融入了物理约束,生成物理上合理的人类运动,并以SMPL [7]参数序列的形式输出人类运动。随后,本文使用逆运动学方法将生成的人类运动重定向到模拟的人形机器人上。如前所述,PhysDiff生成的运动不涉及手部和手指的动作,重定向过程中的误差可能导致运动与语言描述不一致。为了解决这些问题,本文利用视觉语言模型(VLMs)的常识推理能力来编辑人形机器人的运动。给定人形机器人运动的渲染图像及其语言描述,VLM生成头部和手指的动作,并优化手臂的运动。为了在真实机器人上实现全身运动,本文将上半身和下半身的运动分开处理,独立控制行走和上半身的动作。借助人类运动先验和基于VLM的运动编辑,本文能够生成与语言描述一致的自然人形机器人运动,并在模拟和真实的人形机器人上执行这些动作。

本文使用Fourier GR1人形机器人进行模拟和现实实验。本文从HumanML3D测试集以及由大型语言模型(LLM)生成的动作描述中整理了一个测试集,并开展了一项人类研究,以评估生成运动的质量。HARMON展示了自然且与文本对齐的人形机器人运动,在86.7%的测试案例中得到了人类评估者的认可。此外,本文还在物理机器人上执行了生成的动作,展示了多样化且富有表现力的现实世界中的人形机器人运动。

图2展示了本文提出的方法HARMON。首先,本文根据语言描述生成人类运动,并将其重定向为初步的人形机器人运动。为了提高人形机器人运动与语言描述之间的对齐度,本文使用视觉语言模型(VLM)生成手指和头部的动作,并迭代调整身体动作。最后,本文在真实的人形机器人上执行生成的动作。

图2:HARMON的概览。给定运动的语言描述,本文首先生成相应的人类运动,并使用逆运动学将其重定向到人形机器人。接着,本文利用视觉语言模型(VLM)来优化人形机器人的运动。该过程包括从初始语言描述中提取手指和头部的动作描述,并使用VLM生成相应的动作。基于人形机器人运动的渲染图像,VLM迭代地评估并调整运动,以确保其与语言描述一致。最终,HARMON生成与语言描述精确对齐的全身人形机器人运动。

图3:基于VLM的运动编辑。左上角:GPT-4根据渲染的人形机器人运动和手指动作描述,在关键帧生成手指动作。右上角:GPT-4识别关键帧,并根据头部动作描述生成头部动作。下方:GPT-4通过评估渲染的人形机器人帧,基于动作描述迭代调整手臂动作并进行优化。

实验

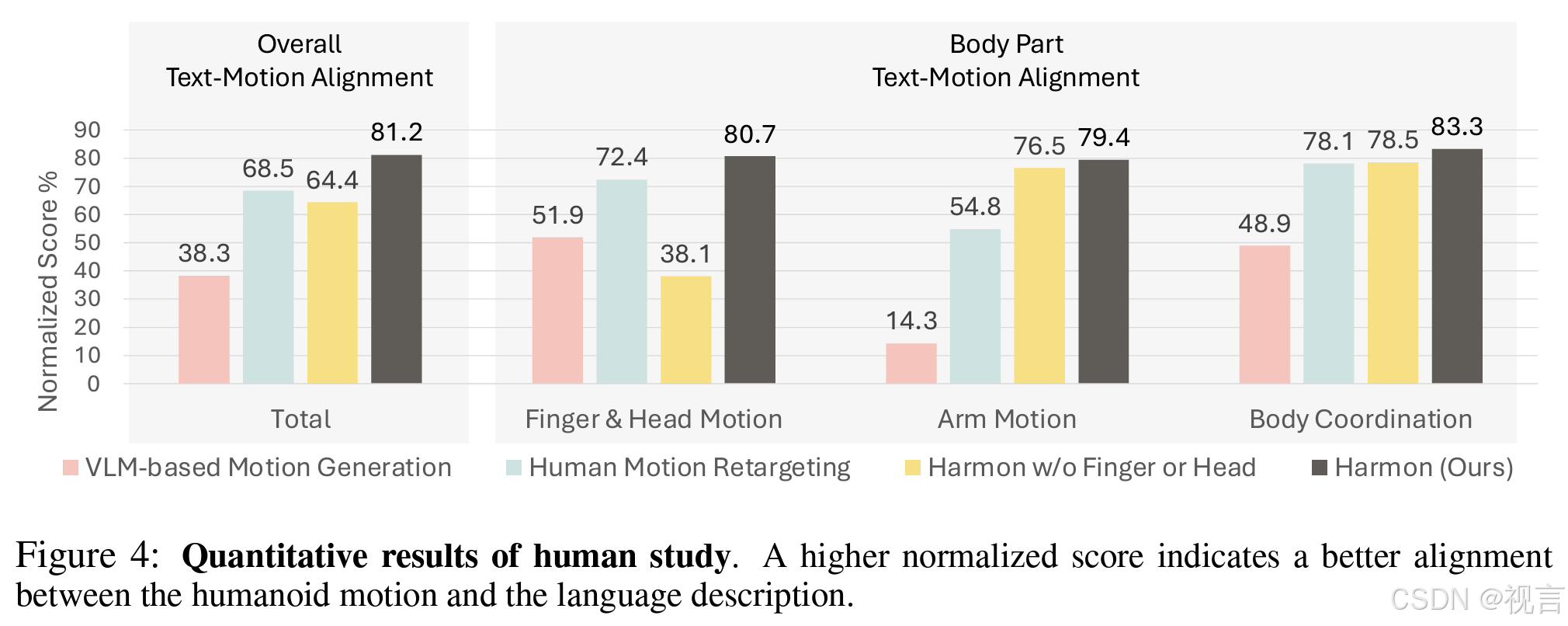

评估全身人形机器人运动生成是具有挑战性的,因为缺少包含语言与人形机器人运动配对数据的数据集。本文通过开展一项人类研究来评估生成的动作。本文整理了一个包含约50个动作语言描述的测试集。测试集的第一部分由从HumanML3D [1] 测试集中随机抽取的文本组成,主要侧重于身体动作,不涉及头部和手指的运动。为了评估全身人形机器人运动,本文使用GPT-4生成包含头部和手指动作的描述,构成测试集的第二部分。

图4:人类研究的量化结果。较高的归一化得分表示人形机器人运动与语言描述之间的对齐程度更好。

图5:HARMON的定性结果。本文用红色圆圈突出显示生成的头部和手指动作,用红色箭头标注动作调整。

总结

本研究解决了从自由形式语言描述生成人形机器人运动的问题。本文提出了HARMON,利用人类运动先验和视觉语言模型(VLM)的常识推理能力来生成人形机器人运动。结果表明,HARMON能够生成自然、富有表现力且与文本对齐的人形机器人运动,并能够在真实的人形机器人上执行。本文的迭代运动调整过程依赖于一组固定的直观控制原语。然而,当生成的人类运动与语言描述严重偏离时,尤其是针对高频运动时,这些控制原语难以应对。未来的一个研究方向是让VLM生成自由形式的控制原语。在本研究中,本文对真实机器人进行了上下半身的分离控制。因此,某些生成的动作可能导致机器人失去平衡或与自身发生碰撞。本文计划在未来工作中引入基于强化学习(RL)的全身控制,以便在真实机器人上实现更稳健的执行。

OKAMI

OKAMI 是一个缩写词,全称是 Object-aware Kinematic retArgeting for huManoid Imitation,即用于人形机器人模仿的物体感知型动力学重定向。

顾名思义,这是一种物体感知型重定向方法,可以让具有两个灵巧机器手的双手型人形机器人基于单个 RGB-D 视频演示模仿其中的操作行为。

方法详解

OKAMI 采用了一种两阶段过程,可将人类运动重新定向成人形机器人的运动,从而可在不同初始条件下完成任务。

在第一个阶段,OKAMI 会处理视频并生成一个参考操作规划。

在第二个阶段,OKAMI 会使用该规划来合成人形机器人的运动,这个过程会用到运动重定向,其作用是适应目标环境中的物体位置。

问题描述

首先,该团队将人形机器人操作任务描述成了一个离散时间马尔可夫决策过程,并将其定义成了一个元组 M = (S, A, P, R, γ, µ)。其中 S 是状态空间、A 是动作空间、P (・|s, a) 是转移概率、R (s) 是奖励函数、γ ∈ [0, 1) 是折扣因子、µ 是初始状态分布。

在这里,S 就是原始 RGB-D 观察的空间,其中包含机器人和物体的状态;A 则是人形机器人的运动指令的空间;R 是一个稀疏的奖励函数 —— 当任务完成时,返回 1。对于一个任务,其目标是找到一个策略 π,使其可以在测试时间最大化大量不同的初始配置下的预期任务成功率。

他们考虑了「基于观察的开放世界模仿」设置。在该设置中,这个机器人系统会获得一段录制的 RGB-D 人类视频 V,然后其需要返回一个人形机器人操作策略 π,使机器人可以完成视频演示的任务。

参考规划生成

为了实现物体感知型重新定向,OKAMI 首先会为人形机器人生成一个参考规划。规划生成需要了解有哪些与任务相关的物体以及人类如何操作它们。

识别和定位与任务相关的物体

为了模仿视频 V 中的操作任务,OKAMI 必须识别要交互的物体。之前的方法需要具有简单背景的无监督方法或需要额外的人工标注,而 OKAMI 则不一样,其使用了现成可用的视觉 - 语言模型(VLM)GPT-4V 来识别 V 中与任务相关的物体;这自然是用到了该模型中内化的常识性知识

具体来说,OKAMI 会通过采样 RGB 帧并使用 GPT-4V 来获取与任务相关的物体的名称。使用这些名称,OKAMI 再使用 Grounded-SAM 来分割第一帧中的物体并使用视频目标分割模型 Cutie 来跟踪这些物体的位置。

重建人类运动

为了将人类运动重新定向成机器人运动,OKAMI 会重建来自 V 的人类运动以获取运动轨迹。为此,他们采用了改进版的 SLAHMR,这是一种用于重建人类运动序列的迭代式优化算法。虽然 SLAHMR 假设双手平放,而新的扩展优化了 SMPL-H 模型的手部姿势,这些姿势使用来自 HaMeR 的估计手部姿势进行初始化。此修改使得单目视频中的身体和手部姿势可以进行联合优化。其输出是一个获取了全身和手部姿势的 SMPL-H 模型序列,让 OKAMI 可以将人类动作重新定向到人形机器人。

此外,SMPL-H 模型还能表示不同人类外观的人类姿势,从而可以轻松地将人类演示者的运动映射到人形机器人。

基于视频生成规划

有了任务相关的物体和重建出来的人类运动,OKAMI 就可以基于 V 生成用于完成每个子目标的参考规划了。

OKAMI 识别子目标的方式是基于以下流程执行时间分割:

- 首先使用 CoTracker 跟踪关键点,并检测关键点的速度变化以确定关键帧,这些关键帧对应于子目标状态。

- 对于每个子目标,都确定一个目标物体(会因为操作而运动)和一个参考物体(通过接触或非接触关系作为目标物体运动的空间参考)。目标物体是根据每个物体的平均关键点速度确定的,而参考物体则通过 GPT-4V 预测的几何启发式或语义关系来识别。

- 确定子目标和相关物体后,生成一个参考规划 l_0, l_1, . . . , l_N,其中每一步 l_i 都对应于一个关键帧,并且包含目标物体 o_target、参考物体 o_reference 和 SMPL-H 轨迹段 图片的点云。

物体感知型重定向

有了来自演示视频的参考规划后,OKAMI 便可以让人形机器人模仿 V 中的任务。机器人会遵循规划中的每个步骤 l_i。然后经过重新定向的轨迹会被转换成关节指令。这个过程一直重复直到任务完成,之后基于任务特定的条件来评估是否成功。

在测试时间定位物体

为了在测试时间环境中执行规划,OKAMI 必须定位机器人观察中的相关物体,提取 3D 点云来跟踪物体位置。通过关注与任务相关的物体,OKAMI 策略可以泛化用于各不相同的视觉背景,包括不同的背景或任务相关物体新实例。

将人类运动重新定位到人形机器人

物体感知的关键是使运动适应新的物体位置。在定位物体后,OKAMI 会采用一种分解式重新定位过程,即分别合成手臂和手部运动。

OKAMI 首先根据物体位置调整手臂运动,以便将手指置于以物体为中心的坐标系内。然后,OKAMI 只需在关节配置中重新定位手指,以模仿演示者用手与物体交互的方式。

具体来说,首先将人体运动映射到人形机器人的任务空间,缩放和调整轨迹以考虑尺寸和比例的差异。然后,OKAMI 扭曲变形(warp)重新定位的轨迹,以便机器人的手臂到达新的物体位置。该团队考虑了两种轨迹变形情况 —— 当目标和参考物体之间的关系状态不变时以及当关系状态发生变化时,相应地调整变形。

在第一种情况下,仅基于目标物体位置执行轨迹变形。在第二种情况下,基于参考物体位置执行变形。

变形之后,使用逆动力学计算机器臂的关节配置序列,同时平衡逆运动学计算中的位置和旋转目标的权重以保持自然姿势。同时,将人类手部姿势重新定位到机器人的手指关节,使机器人能够执行精细的操作。

最后,可得到一套全身关节配置轨迹。由于机器臂运动重新定向是仿射式的,因此这个过程可以自然地适应不同演示者的情况。通过调整手臂轨迹以适应物体位置并独立重新定位手部姿势,OKAMI 可实现跨各种空间布局的泛化。

实验及结果

研究者在实验部分主要回答了以下四个研究问题:

- OKAMI 能否有效地让人形机器人基于单个人类演示视频来模仿各种操作任务?

- 在 OKAMI 中,将演示者的身体动作重新定位到人形机器人身上是否重要,以及为什么没有选择仅根据物体位置进行- 重新定位?

- OKAMI 能否在多样化人体统计学特征的人类演示视频中始终保持自身性能?

- OKAMI 生成的展示(rollout)是否可以用来训练闭环视觉运动策略?

任务设计。研究者在实验中执行了六项任务,分别如下:

- 将毛绒玩具放入篮子里(Plush-toy-in-basket)

- 将少许盐撒入碗中(Sprinkle-salt)

- 关上抽屉(Close-the-drawer)

- 合上笔记本电脑的盖子(Close-the-laptop)

- 将一袋零食放在盘子上(Place-snacks-on-plate)

- 将薯片袋放入购物袋中(Bagging)

硬件设置。研究者使用 Fourier GR1 机器人作为自己的硬件平台,配备了两个 6 自由度(DoF)的 Inspire 灵巧手以及一个用来录制视频和进行测试时观察的 D435i Intel RealSense 摄像头。此外还实现了一个以 400Hz 运行的关节位置控制器。为了避免出现抖动,研究者以 40Hz 来计算关节位置命令,并将命令插入 400Hz 轨迹。

评估方案。研究者针对每项任务运行了 12 次试验。过程中,物体的位置在机器人摄像头视野和人形手臂可触及范围的交点内进行随机初始化。

基线。研究者将 OKAMI 与基线 ORION 进行了比较。

定性结果

为了回答问题 1),研究者评估了 OKAMI 在所有任务中的策略,覆盖日常取放、倾倒和操纵铰接物体等多样性行为。结果如下图 4(a)所示,实验中随机初始化了物体位置,这样做让机器人需要适应物体的位置。从结果来看,OKAMI 可以有效地泛化到不同的视觉和空间条件。

为了回答问题 2),研究者在两项代表性任务上将 OKAMI 与 ORION 进行比较,分别是将 Place-snacks-on-plate 和 Close-the-laptop。二者的不同之处在于 ORION 不以人类身体姿态为条件。结果显示,OKAMI 在两项任务上分别实现了 75.0% 和 83.3% 的成功率,而 ORION 分别只有 0.0% 和 41.2%,拉开了很大的差距。

为了回答问题 3),研究者进行了一项受控实验,记录了不同演示者的视频,并测试 OKAMI 策略是否对所有视频输入都能保持良好的性能。同样地,他们选择的任务是 Place-snacks-on-plate 和 Close-the-laptop,结果如图 4(b)所示。

总体而言,OKAMI 能够在处理不同演示者的视频时保持相当不错的性能,不过处理这类多样性的视觉 pipeline 仍有改进的空间。

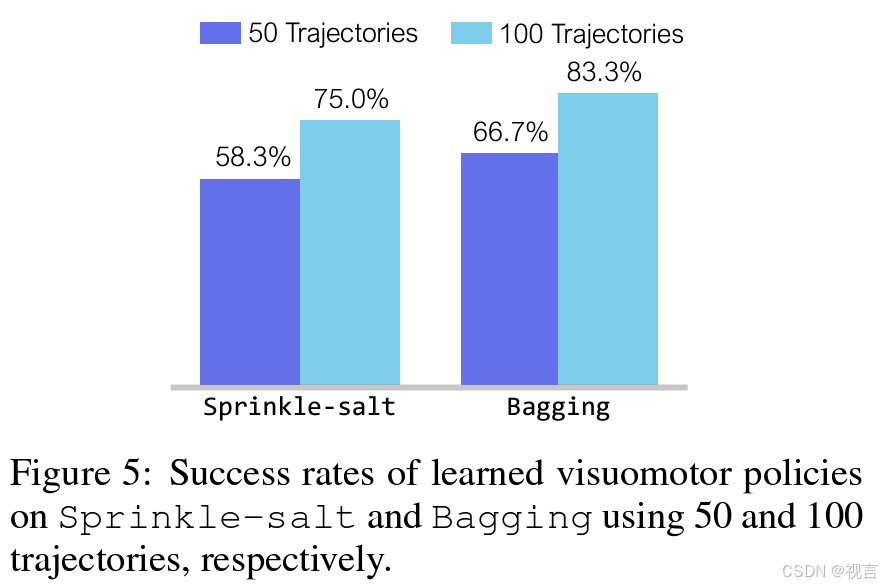

利用 OKAMI Rollout 数据学习视觉运动策略

为了解决问题 4),研究者在 OKAMI rollout 上训练了神经视觉运动策略。他们首先在随机初始化的物体 rollout 上运行 OKAMI,并在收集一个包含成功轨迹的数据集同时丢弃失败的轨迹。此外他们通过行为克隆算法在该数据集上训练神经网络策略,并为 Sprinkle-salt 和 Bagging 两项任务训练视觉运动策略。

下图 5 展示了这些策略的成功率,表明 OKAMI rollout 可以成为有效的训练数据源。并且,随着收集到的 rollout 增多,学习到的策略会随之改进。这些结果有望扩展数据收集范围,从而无需费力远程操作也能学习人形机器人操作技能。

局限性和未来工作

OKAMI 目前专注于人形机器人的上半身运动重定向,尤其是用于桌面工作空间的操控任务。因此未来有希望扩展到下半身重定向,以便在视频模仿期间实现运动行为。更进一步,实现全身运动操控则需要一个全身运动控制器,而不是 OKAMI 中使用的关节控制器。

此外,研究者在 OKAMI 中依赖 RGB-D 视频,这限制了他们使用以 RGB 记录的野外互联网视频。因此扩展 OKAMI 使用网络视频将是未来另一个有潜力的研究方向。最后,当前重定向的实现在面对物体的形状变化较大时表现出了较弱的稳健性。

OKAMI 虽强,但也并不完美,也有失败实例。未来的改进将是整合更强大的基础模型,使机器人能够总体了解如何与一类物体进行交互,即使这类物体的形状变化很大。

reference

- https://arxiv.org/pdf/2410.11792

- https://yukezhu.me/documents/yukez.pdf

1093

1093

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?