Texture Transform Attention for Realistic Image Inpainting

Introduction

提出了一个纹理变换注意(TTA)模块,以有效地将纹理信息传递给结果。基于补丁的网络方法通过Channel方向softmax计算每个补丁的相似性,并对每个权重求和。但是,如果背景中有许多相似的面片,则基于相似的权重对多个面片求和,结果会显得模糊。为了解决这个问题,我们搜索最相似的补丁,并仅使用补丁上的索引和相似性权重来反映在结果中。我们的方法还将相同大小的核应用于每个层的不同分辨率,并改变感受野大小来提取视觉信息,如下层的语义上下文和上层的纹理细节。

Approach

Texture Transform Attention

提出的纹理变换注意力是通过使用具有各种精细特征的编码信息来补偿模糊的解码上下文信息。传统的注意方法通常使用相似权重的总和,但是如果有许多相似的斑块(地面,沙子,灌木丛等)相似的权重会重叠,导致模糊。为了克服模糊问题,我们参考了一种参考SR 方法,该方法与粗糙图像交换或向粗糙图像添加精细纹理分量。当应用于网络修复时,我们可以假设粗图像是由扩张卷积或上采样产生的上下文特征Q,而细纹理是从编码器提取的未受损特征P。因此,我们旨在比较两个不同的特征,如图所示,重组语义相似的纹理特征P,并将其合成为上下文特征Q。

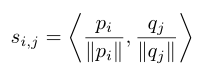

Relevance Embedding(相关性嵌入):相关性嵌入旨在通过计算匹配分数来嵌入编码Encoder后的纹理特征P和解码Decoder后的上下文特征Q之间的相关性。通过将不同的分辨率展开成相同大小的小块,并改变每一层的感受野,可以创建不同的注意力图,从而有助于即使在创建新的语义上下文时也能保持修复性能。

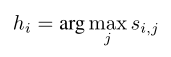

Feature Swapping:提出了一种创建重组纹理图T的方法,该方法以语义特征Q的形式重建精细纹理P的细节。传统的注意力方法采用通道方向面片的加权和,但是这削弱了精细纹理的传输性能并且缺乏细节。在Q_i的位置单独合成最相关的补丁P_j在细节表达上表现得更好。首先,对每个补丁执行相似性S_i、j的通道比较,以找到与Q_i最相似的P_j,并为位置生成索引图H。

Similarity weight texture synthesis

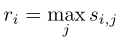

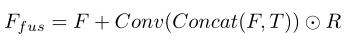

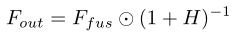

Fusion ration map.在解码器中创建的上下文特征可能在背景中没有相似的补丁或具有低相似性,因此我们需要确保不是所有补丁都以相同的比率合成,以防止重影效果。我们的方法参考上面计算的相似性权重值s_i,j,并进行通道方向比较来搜索融合的最高比率。比率图R表示在T中每个位置的重组纹理图的置信度。

Similarity Fusion:

然而,由于每个补丁简单地乘以不同的比率R_i并加到F上,就会出现颜色失真,导致棋盘效果,如图7所示。为了解决这个问题,我们使用了归一化因子(1+R)并逐个元素地乘以F_fus.

总之,纹理变换注意力有效地将相关的精细纹理P转移到语义上下文特征Q,使得结果图像更加逼真

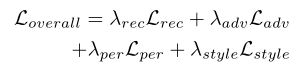

Loss

Experimental Results

消融实验

是否使用归一化因子:

我们在合成模块中加入了归一化因子。如果我们简单地按像素乘以相似性权重,结果将对每个区域有不同的颜色级别,从而产生棋盘式伪像。当我们应用归一化因子时,可以根据每个面片的融合比例进行颜色归一化,这样可以获得自然的结果。在图7中,我们可以看到根据归一化因子的使用结果的比较。

1290

1290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?