最近我正在开发基于LangChain的知识库。为了降低tokens的费用,需要完成接口替换。将原来调用OpenAI接口的方式改为使用ChatGLM2-6B接口。这样的改变不仅可以节省成本,还能提高文本输出速度。以下是我们在实践中取得的成果,现在与大家分享!

一、环境配置:

下载chatglm2-6B库:https://github.com/THUDM/ChatGLM2-6B.git

启动python openai_api.py

监听端口为8000。

二、代码编写:

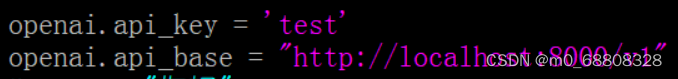

1、首先要有一个“openai.api_key”,这里直接输入个test进行测试即可。

2、还要有一个域名,这里设置的是“http://localhost:8000/v1”

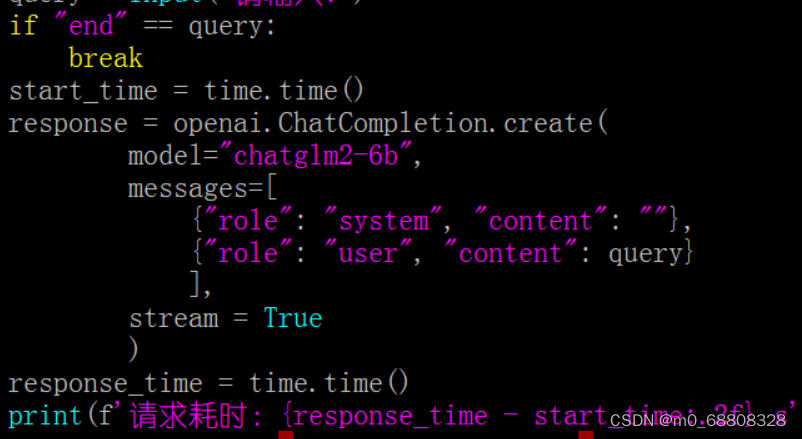

3、用chatglm2-6b查询输入的文字

(4、输出总耗时)

总代码如下:

import openai

import time

import json

openai.api_key = 'test'

openai.api_base

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?