什么是线性回归和逻辑回归 ?参考:https://blog.csdn.net/jiaoyangwm/article/details/81139362

1、有监督学习和无监督学习区别?

简单来讲:

有数据,有标签 (有监督学习)

有数据,无标签 (无监督学习)

有监督学习:对具有标记的训练样本进行学习,以尽可能对训练样本集外的数据进行分类预

测。

无监督学习:对未标记的样本进行训练学习,比发现这些样本中的结构知识。

2、分类和回归区别?

回归的输出是连续的,比如:1、2、3、4、5、6。注意,所谓“连续”意味着是有序的,是排序的。比如输出为3,那么我们可以肯定真实为3、4、5、6的可能性顺序减小,真实为2、1的可能性也是顺序减小。

分类的输出是:A类、B类、C类。注意,所谓“分类”意味着ABC之间不存在排序,不存在谁比谁更亲密或更远、可能或更不可能。输出为A,那么不意味着真实为B的可能性比C更大。

3、线性回归方程用向量化可以表示为?

f ( x ) = θ T x f(\mathbf{x})=\theta^{T} \mathbf{x} f(x)=θTx

4、写一下线性回归损失函数,并理解下损失函数的目标?

目标是找到最好的能拟合输入数据的权重参数。我们用最小二乘法来评估拟合效果。

J

(

θ

0

,

θ

1

,

…

,

θ

n

)

=

1

2

m

∑

i

=

1

m

(

h

θ

(

x

(

i

)

)

−

y

(

i

)

)

2

J\left(\theta_{0}, \theta_{1}, \ldots, \theta_{n}\right)=\frac{1}{2 m} \sum_{i=1}^{m}\left(h_{\theta}\left(x^{(i)}\right)-y^{(i)}\right)^{2}

J(θ0,θ1,…,θn)=2m1i=1∑m(hθ(x(i))−y(i))2

5、过拟合和欠拟合各有什么问题?

欠拟合问题:模型本身能力不够,没有学习到数据的规律。

过拟合问题:模型能力很强,数据的每个点包括噪声点都能学习到,但是对新的数据预测效果很差。

6、模型的过拟合问题可以怎么解决?

有很多方法:比如获取更多数据,使用更简单的模型等等

另一种方法是使用正则化项,因为过拟合是因为模型太复杂了,对应于线性回归,说明某些权重参数对模型的影响过大或者多余了,我们可以通过加一个正则化项,模型训练时,相当于最小化下面公式的损失函数时,会把一些对模型复杂度影响很大的权重参数的权重数值变小,这样曲线就变得比较平滑了,可以消减模型的复杂度。

J

(

θ

)

=

1

2

m

[

∑

i

=

1

m

(

h

θ

(

x

(

i

)

)

−

y

(

i

)

)

2

+

λ

∑

j

=

1

n

θ

j

2

]

J(\theta)=\frac{1}{2 m}\left[\sum_{i=1}^{m}\left(h_{\theta}\left(x^{(i)}\right)-y^{(i)}\right)^{2}+\lambda \sum_{j=1}^{n} \theta_{j}^{2}\right]

J(θ)=2m1[i=1∑m(hθ(x(i))−y(i))2+λj=1∑nθj2]

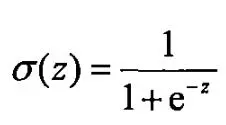

7、逻辑回归明明是分类问题,为什么又叫回归?

因为逻辑回归还是以线性回归为基础的,只是加了一个sigmoid函数,才具有了分类的功能。sigmoid函数表达式如下

8、逻辑回归为什么不用平方损失函数?

因为逻辑回归的平方损失函数是非凸函数,梯度下降时很难得到全局极值点。

9、写一下逻辑回归损失函数,并理解是怎么来的?

这个损失函数是凸函数,梯度下降可以找到全局极值点。

J

(

θ

)

=

−

1

m

[

∑

i

=

1

m

y

(

i

)

log

h

θ

(

x

(

i

)

)

+

(

1

−

y

(

i

)

)

log

(

1

−

h

θ

(

x

(

i

)

)

)

]

+

λ

2

m

∑

j

=

1

n

θ

j

2

J(\theta)=-\frac{1}{m} \left[ \sum_{i=1}^{m} y^{(i)} \log h_{\theta}\left(x^{(i)}\right)+\left(1-y^{(i)}\right) \log \left(1-h_{\theta}\left(x^{(i)}\right)\right)\right]+\frac{\lambda}{2 m} \sum_{j=1}^{n} \theta_{j}^{2}

J(θ)=−m1[i=1∑my(i)loghθ(x(i))+(1−y(i))log(1−hθ(x(i)))]+2mλj=1∑nθj2

其中

λ

2

m

∑

j

=

1

n

θ

j

2

\frac{\lambda}{2 m} \sum_{j=1}^{n} \theta_{j}^{2}

2mλj=1∑nθj2 是一个正则化项

10、LR逻辑回归这个模型有什么优势?

- LR能以概率的形式输出结果,而非只是0,1判定

- LR的可解释性强,可控度高

- 训练快,feature engineering之后效果赞

- 因为结果是概率,可以做ranking model

- 添加feature太简单…

409

409

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?