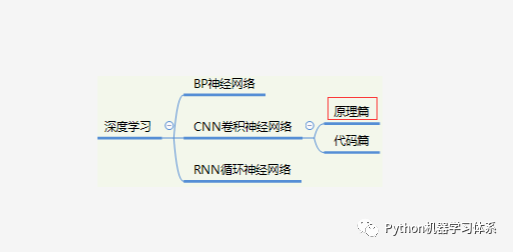

0.学习路径示意图

Hello,各位小伙伴大家晚上好呀,你们期待已久的CNN卷积神经网络原理篇要来咯。上期我们讲到神经网络已经逐步成为人类智能生活的璀璨明珠,并介绍了BP神经网络的整个训练过程,整个流程紧凑而又科学,似乎BP神经网络已经能解决很多问题了,但细心的小伙伴会发现博主并没有提及BP神经网络的缺点,是的,博主并没有提及,其实是博主忘记了....

But,这并不影响我们CNN的教学,这期内容博主正好通过BP神经网络的缺点来开展CNN的教学,换个角度想,这还起到承上启下的作用,刺不刺激,惊不惊喜?这都能被博主圆了过来。

好了,废话不多说,这期内容主要分为以下几点:

BP神经网络的局限性

CNN卷积神经网络的原理

CNN卷积神经网络的超参数设置

总结

1.BP神经网络的局限性

相信看过上期的内容的小伙伴们应该都会比较熟悉BP神经网络了。没有看过的小伙伴也可以去看一看,BP神经网络虽然我们不常用,但是它的原理是CNN,RNN,乃至于其他网络结构都会涉及的。

阿力阿哩哩,公众号:Python机器学习体系深度学习开端---BP神经网络

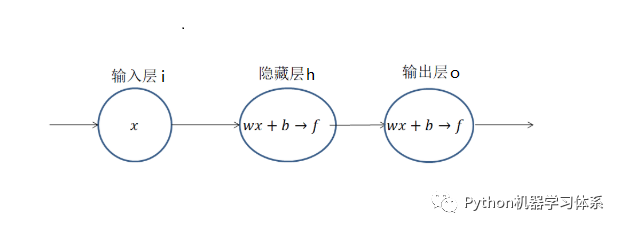

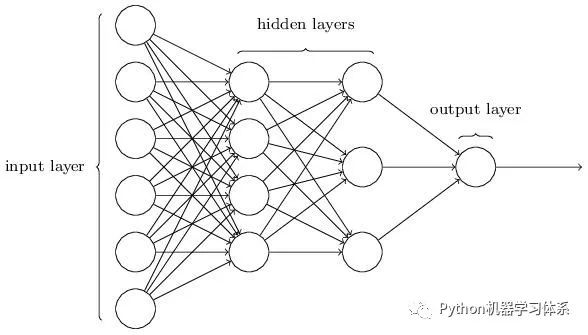

为了讲清BP网络的局限性,博主还是拿出上期画的最简单的BP网络结构图来讲解,相信小伙伴们对这个图也不陌生了把。想一下,上一期我们为了求解损失Loss 列出了关于w,b 的方程,并通过梯度下降的方法去求解最佳的(w , b),从而得到最小的损失Loss。换言之,上一期的内容我们简单来讲就是站在山上找最陡峭的地方(梯度),不断地往下走,一直走到山谷,这时候的我们所在坐标(w , b)就是Loss方程的最优解。

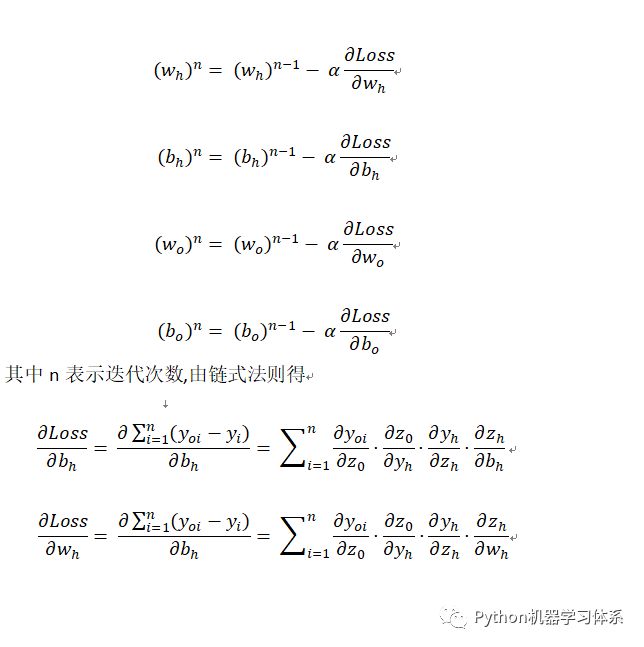

为此,针对上面的这个网络结构,我们要对隐藏层和输出层求4个偏导,又因为隐藏层的输出作为输出层的输入,这时我们就要用到求偏导的链式法则,公式如下:

由上面的公式,我们可以看出,两个神经元,为了求出隐藏层和输出层最佳的(w , b),我们就要求四个偏导,期间还得为链式求导付出4次连乘的代价。

现在,重点来了,如上图,倘若我们的网络层次越深,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1151

1151

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?