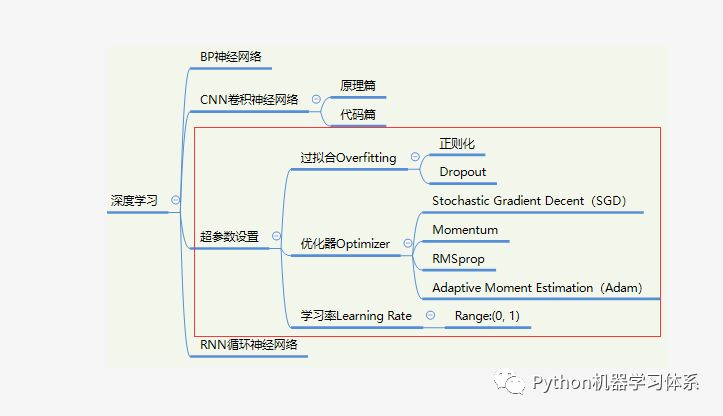

0.学习路径示意图

Hello,各位小伙伴大家晚上好呀!经过上期的CNN卷积神经网络原理篇的讲解,小伙伴们是不是已经迫不及待地想利用TensorFlow来搭建属于自己的神经网络来训练啦?诶,戳多马爹(且慢)!在组网之前,博主还是有一些东西要给大家交代的。那就是神经网络的超参数(Hyperparameters),记忆力好的小伙伴会发现博主在之前更新的文章中都有提及超参数。

But,这一期分享的超参数设置与往期不同,它是所有网络共有的超参数,也就是说我们不管组什么网络,都可以对这些超参数进行设置。不像上期介绍的CNN网络,它的一些特有超参数如Padding其他网络并不具备。当然了,有些小伙伴可能并没有看过之前的文章,在这博主也给大家说下啥是超参数,通俗易懂来说就是小伙伴们在训练神经网络前必须人工设定的参数。

前期内容

阿力阿哩哩,公众号:Python机器学习体系深度学习开端---BP神经网络

阿力阿哩哩,公众号:Python机器学习体系什么?卷积层会变胖?人工智能之光---CNN卷积神经网络(原理篇)

好了,废话不多说,这期我们主要讲这几方面:

应对过拟合的两种方案:正则化(Regularization)与Dropout

优化器(Optimizer)

学习率(Learning Rate)

总结

1.应对过拟合的两种方案

在此之前,博主先给大家科普下啥是过拟合。举个最简单的例子,小伙伴们一般在考试前都会做题去复习,假如我们当晚做的题都在第二天考场上见到了,那么咱们的分数就会高很多,但是其实出别的题目,小伙伴们可能就答不上来了,这时候我们就把这种情况叫过拟合,因为小伙伴们只是记住了一些题目的特征,但是并没有很好地了解题目最本质的真理。

这时候博主顺带给小伙伴们科普下泛化性,泛化就像是学神,不管他当晚有没有复习到第二天考试的题目,依旧能拿高分,本质上是学神已经将所有题目最本质的真理都学会了,所以不管出啥题目他都能通过已经掌握的真理去解答,这就是泛化。

那我们训练模型也一样,当然希望我们弄的模型能和学神一般,不管碰到什么题目都能迎刃

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

222

222

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?