KL散度(Kullback-Leibler divergence)是描述两个概率分布 P 和 Q 差异的一种方法。在概率论或信息论中,又称相对熵(relative entropy)。它是非对称的,这意味着 D(P||Q) ≠ D(Q||P) 。特别的,在信息论中,D(P||Q) 表示当用概率分布 Q 来拟合真实分布 P 时,产生的信息损耗,其中 P 表示真实分布,Q 表示 P 的拟合分布。

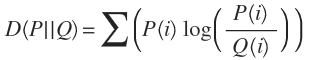

对于一个离散型随机变量的两个概率分布 P 和 Q 来说,他们的 KL 散度定义为:

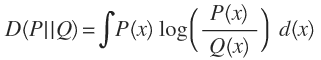

对于一个连续型的随机变量,可以定义为:

利用 Tensorflow 实现一个散列型的KL散度,代码如下:

#!/usr/bin/env python

# -*- coding: utf-8 -*-

import tensorflow as tf

def KLD(p, q):

return tf.reduce_sum(tf.mul(p, tf.log(tf.div(p,q))))

with tf.Session() as sess:

p=tf.constant([1,2,3,4], tf.float32)

q=tf.constant([1.0001,2.00009,2.999991,3.99998], tf.float32)

print sess.run(KLD(p,q))

3663

3663

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?