原报告作者:Xiaogang Wang

作者提出了一部分人的一个想法:Deep learning is NOT simple as fitting acomplex model to a dataset -- 意思是说:深度学习模型仅仅是一个带有大量参数的并且利用大数据train出来的复杂模型。作者为了解这个迷思,在自己实验的网络DeepID2上 的实验并用实验得到一些有意思的现象

- Moderate Sparse -- 中等程度的稀释

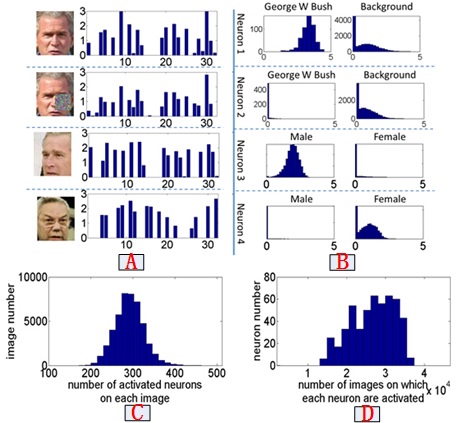

如上四幅图所示,作者将网络结构的最上层神经元节点的响应可视化之后,得出一些结论:

- 对于一张图像,500个神经元有一半的神经元有响应,这一点可以从C图得到验证,也就是说,他是中等程度稀释的;

- 从A图知,对于同样一个人,比如布什,无论他是否有遮挡,还是是否对齐,虽然响应幅度不同但其响应模式是稳定的,就是说,他是响应还是不响应是一样的,但是,如果是图像换成另外一个人,比如换成鲍威尔的话,其响应模式便不一样;

- 单看一个神经元,一个神经元在有的图像上响应,有的图像上不响应,统计出有多少图像在这个神经元上响应,如图D所示,大概有一般的图像在这个神经元是响应的,大概另一半是不响应的。对于同一张图像他的神经元一半响应一般不响应,我们可以知道他的距离是最大的,也就是说,图像之间的辨别度比较好。如果一幅图像他的神经元不响应话,那么这些神经元的模式有可能是重叠的,单看一个神经元一半图像响应,一半图像不响应,他的熵是最大的,从这个角度来说,模型的表达能力是最大的;

- Selectiveto Identities and Attributes 对人的identity和attribute有很强的选择性,一个神经元 对于某一个神经元对布什的500+张图像全部响应,还有的神经元对布什的500+张图像都不响应,所以,如果做布什的分类的话,我们用一个神经元也能达到90+%的正确率;

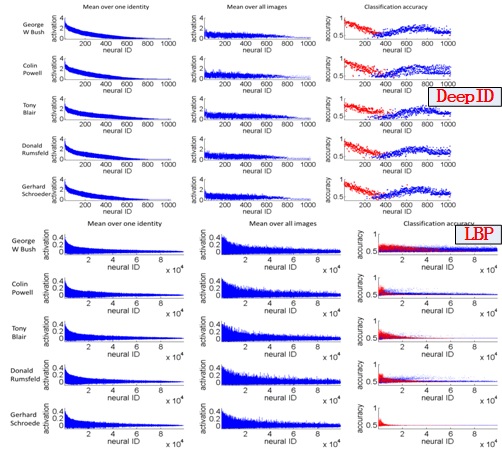

还有一组跟LBP作对比的实验,实验结果如图

对所有节点的平均响应排序,同样神经元对其他图像的响应,其结果如上图,可见响应度低或者高对布什图像具有很好的分辨能力,但是中间的结点,其分辨能力就没有那么好了,可能是有些响应,有些不响应,但是LBP是呈均匀分布的形态,对布什图像响应的结点,对其他图像也是响应也强,所以相较而言,Deep 效果更好

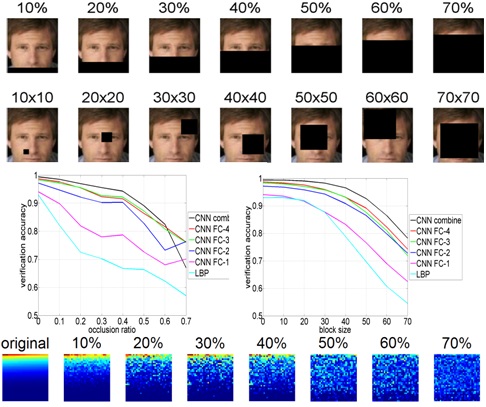

- Robustto Occlusion 对遮挡具有鲁棒性

还是一组对比实验,将遮挡图像的识别率比较稳定,可见用LBP识别下降比较快,我们知道有不同曾四的特征,每一层次的特征拿出来,看是不是具有鲁棒性,可以看出,随着层数增加,识别结果的鲁棒性比较强,最底层的特征跟LBP特征差不多对遮挡比较敏感,说以我们知道网络底层学习到的都是局部特征,高层学到的是全局特征。遮挡的幅度在一个范围之内,其pattern是稳定的,只是幅度有不同程度的变化。

所以作者得出三个结论:

- Moderate Sparse

- Selective to Identities and Attributes

- Robust to Occlusion

6295

6295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?