1、在SVM基本型的讨论中,我们一直假定样本在样本空间或特征空间中是线性可分的,即存在一个超平面能将不同类的样本完全划分开

2、然而现实任务中往往很难确定合适的核函数使得训练样本在特征空间中线性可分,即使恰好找到某个核函数使训练集样本在特征空间中线性可分,也很难判断是否是过拟合造成的

3、缓解该问题的一个方法是允许支持向量机在一些样本上出错,为此要引入“软间隔”的概念

a) 软间隔则是允许某些样本不满足约束

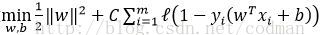

b) 故而可在原优化目标中加入损失函数

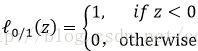

4、常用损失函数

a) hinge损失:

b) 指数损失:

c) 对率损失:

d) 0/1损失函数:

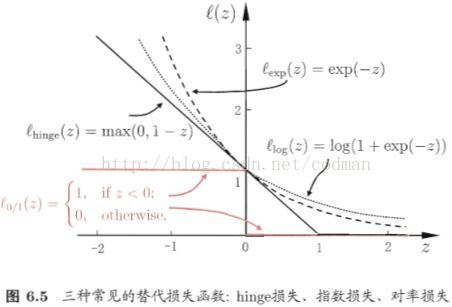

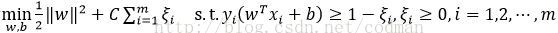

5、软间隔支持向量机

a) 相对于支持向量机基本型,引入了“松弛变量”

b) 优化目标可重写为

c) 每个样本都有一个对应的松弛变量,用以表征该样本不满足原约束的程度

6、拉格朗日函数

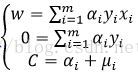

7、拉格朗日函数分别对w,b,求偏导得

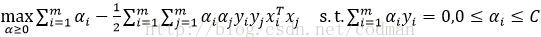

8、对偶问题

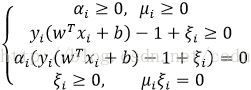

9、软间隔支持向量机的KKT条件

a) 若 ,则该样本不会对f(x)有任何影响;若 ,则必有 ,该样本为支持向量

b) 若 ,则有 ,进而有 ,即该样本恰在最大间隔边界上;若 ,则有 ,进而有 ,即该样本落在最大间隔内部,若 则被样本被错误分类

c) 软间隔支持向量机的最终模型仅与支持向量相关

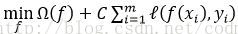

10、优化目标的更一般形式:

a) 其中 称为“结构风险”,用于描述模型f的某些性质,同时也是正则化项

b) 第二项 称为“经验风险”,用于描述模型与训练数据的契合程度

c) C系数用于对二者进行折中,称作正则化系数

,即该样本恰在最大间隔边界上;若

,即该样本恰在最大间隔边界上;若  ,进而有

,进而有  ,即该样本落在最大间隔内部,若

,即该样本落在最大间隔内部,若  则被样本被错误分类

则被样本被错误分类

称为“结构风险”,用于描述模型f的某些性质,同时也是正则化项

称为“结构风险”,用于描述模型f的某些性质,同时也是正则化项

8727

8727

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?