1.2 例子

理解强化学习的一个好方法是考虑一些指导其发展的示例和可能的应用。

- 大师级国际象棋选手采取行动。通过考虑可能的落子和反击这种计划来做出选择,以及对特定位置和落子的可取性采取果断的直接的判断。

- 自适应控制器实时调整炼油厂操作的参数。控制器在此基础上优化产量/成本/质量权衡指定的边际成本,而不是严格遵守最初工程师建议的设定点。

- 一只瞪羚小牛出生后几分钟就挣扎着。 半小时后呢?它以每小时20英里的速度奔跑。

- 移动机器人决定是否应该进入新房间以寻找和收集更多垃圾或开始尝试找回其电池充电站的路。根据电池的当前充电水平和速度做出决定,它很容易就能找到过去的充电器位置。

- 菲尔准备他的早餐。仔细检查,即使这个看似平凡的活动也揭示了一个复杂的条件行为网和互锁目标关系:走到橱柜,打开它,选择一个麦片盒,然后伸手去拿,抓住并取回盒子。再通过其他一系列复杂的,调整的,互动的,必须的行为来获得碗,勺子和牛奶壶。每个步骤都涉及一系列眼球运动,以获取信息到达大脑并指导和协调肢体动作。菲尔对于如何携带物品,或者在获得其他物品之前将它们中的一些运送到餐桌上是否更好的,在不停地进行快速判断。每个步骤都以目标为指导,例如抓勺子或到达冰箱,并且服务于其他目标,例如一旦准备好谷物并且最终可以获得营养,那么菲尔拿起勺子就吃。无论他是否意识到这一点,菲尔都在获取有关他身体状况的信息,这些信息决定了他的营养需求,饥饿程度和食物偏好。

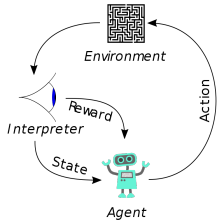

这些示例共享的功能非常基本,很容易被忽略。 所有涉及主动决策的智能体与其环境之间的相互作用,智能体在其中寻求实现目标,尽管其环境存在不确定性。允许智能体的行为影响未来的环境状态(例如,下一个国际象棋位置,炼油厂的水库水平,机器人的下一个位置以及其电池的未来充电水平),从而影响那些以后提供给智能体可用的选项和机会。 正确的选择需要考虑到行动的间接延迟后果,因此可能需要预见或规划。

同时,在所有这些例子中,行动的影响无法完全预测; 因此,智能体必须经常监控其环境并做出适当的反应。例如,菲尔必须观察他倒入谷物碗中的牛奶以防止溢出。所有这些例子都涉及明确的目标,即智能体可以根据其直接感知的内容来判断其目标的进展。国际象棋选手知道他是否获胜,炼油厂控制员知道生产了多少石油,瞪羚小牛知道它奔跑时何时落下,移动机器人知道它的电池何时耗尽,菲尔知道他是否正在享用他的早餐。

在所有这些示例中,智能体可以使用其经验来改善其表现。随着时间的推移。国际象棋选手改进了他用来评估位置的直觉,从而改善了他的发挥; 瞪羚小牛提高了它的奔跑效率; 菲尔学会精简他的早餐。智能体在开始时为任务带来的知识,无论是从以前的相关任务经验,还是通过设计或演变构建到任务中,对于有用或易于学习的内容都是有影响的。但是,对于调整行为以利用任务的特定功能来说,与环境的交互至关重要。

714

714

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?