先做个总结

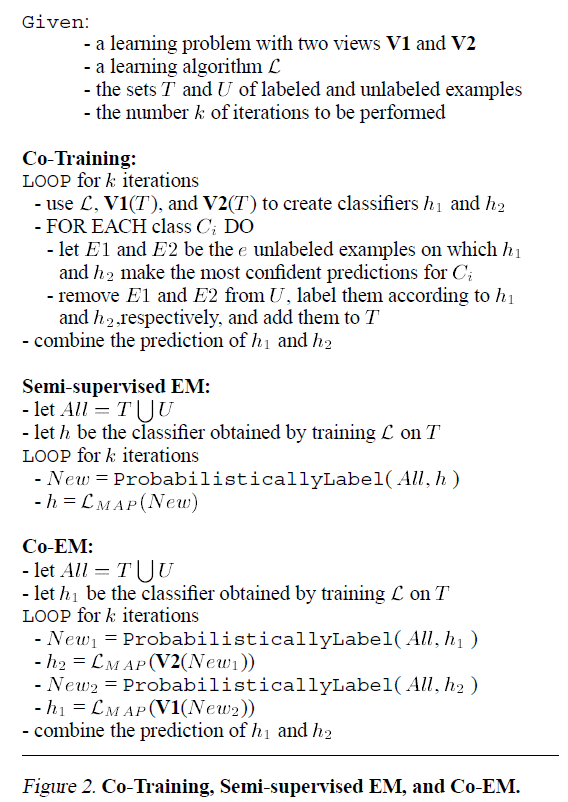

- co-training方法是一类半监督方法,是一个框架,核心就是利用少量已标记样本,通过两个(或多个)模型去学习,对未标记样本进行标记,挑选most confidently的样本加入已标记样本阵营。

- 目前主要存在两种方法:single-view 和 multi-view。最开始提出的是multi-view,就是对特征进行拆分,使用相同的模型,来保证模型间的差异性。后来论证了single-view方法,也就是采用不同种类的模型,但是采用全部特征,也是可以的。基于后一种方法,好多开始做集成方法,采用boosting方式,加入更多分类器,当然也是可以同时做特征的采样。

- co-training的性能是受选定的模型的影响的,比如分类任务,虽然是用多个弱分类器集成co-train,但是太弱也不行。要知道是把分类器对未知样本进行分类的结果作为label放入标记训练集里,分类器的结果不能代表ground truth,加进去后性能可想而知。下文有篇论文给出了Navie Bayes和SVM的差异,一个用co-training性能下降,起反作用,一个能提升性能(虽然很有可能是鬼扯)。

- 主要是处理数据集中,已标记样本少,或者标记不均衡,又想利用全部数据(未标记的样本)

以下是具体看论文的笔记,由于专注于了解这个领域,很多都略过,直接看任务和方法,处理什么问题,怎么处理之类的。

Active + Semi-Supervised Learning = Robust Multi-View Learning

I Muslea

,

S Minton

,

CA Knoblock

- ICML, 2002 - researchgate.net

We first show that existing semi-supervised algorithms are not robust over the whole spectrum of parameterized problems. Then we introduce a new multi-view algorithm, Co-EMT, which combines semi-supervised and active learning. Co-EMT outperforms the other algorithms both on the parameterized problems and on two additional real world domains. Our experiments suggest that Co-EMT’s robustness comes from active learning compensating for the correlation of the views.

相关方法的列举

Co-EM比较有意思,一个模型的M步得到的模型(其实是很调参),给另一个模型作为E步

Co-Training是一种半监督学习方法,利用少量标记样本与多个模型交互来学习并标记未标记样本。文章探讨了single-view和multi-view方法,指出模型选择对性能的影响,并介绍了结合主动学习的Co-EMT算法。此外,提到了在电子邮件分类和DCPE分类中的应用。

Co-Training是一种半监督学习方法,利用少量标记样本与多个模型交互来学习并标记未标记样本。文章探讨了single-view和multi-view方法,指出模型选择对性能的影响,并介绍了结合主动学习的Co-EMT算法。此外,提到了在电子邮件分类和DCPE分类中的应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1887

1887

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?