目录

ollama架构图

在当今快速发展的技术领域,AI 工具已经成为提升开发效率的重要帮手。VSCode 作为一款广受欢迎的代码编辑器,结合 Ollama 和 Twinny,可以为开发者提供一个强大的 AI 编程环境。本文将详细介绍如何在 VSCode 中集成 Ollama 和 Twinny,实现代码生成、问题解答和复杂任务处理。

一、什么是 Ollama 和 Twinny?

(一)Ollama

Ollama 是一个开源的 AI 模型管理工具,允许你在本地运行和管理各种 AI 模型,如 DeepSeek、Claude 等。它提供了简单易用的命令行接口,可以快速加载和使用模型,同时支持 GPU 加速,适合需要高性能计算的场景。

(二)Twinny

Twinny 是一个基于 AI 的开发工具,专注于代码生成和复杂任务处理。它通过自然语言交互,帮助开发者快速实现代码逻辑、修复错误、优化性能,并支持多种编程语言。Twinny 的特点是能够理解复杂的上下文,并生成高质量的代码。

二、安装与配置

(一)安装 VSCode

-

访问 VSCode 官方网站:Visual Studio Code - Code Editing. Redefined。

-

下载并安装适合你操作系统的版本。

-

启动 VSCode,安装 Python 扩展(由 Microsoft 提供),以便更好地支持 Python 开发。

(二)安装 Ollama

-

访问 Ollama 官方网站:Ollama。

-

下载并安装 Ollama。

-

启动 Ollama 服务:

ollama serve -

下载并加载 Twinny 模型:

ollama run twinny

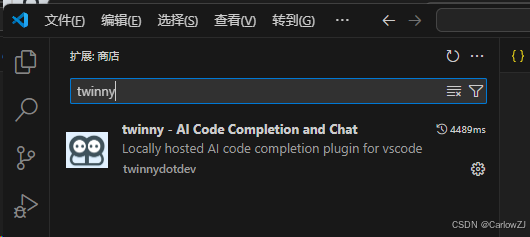

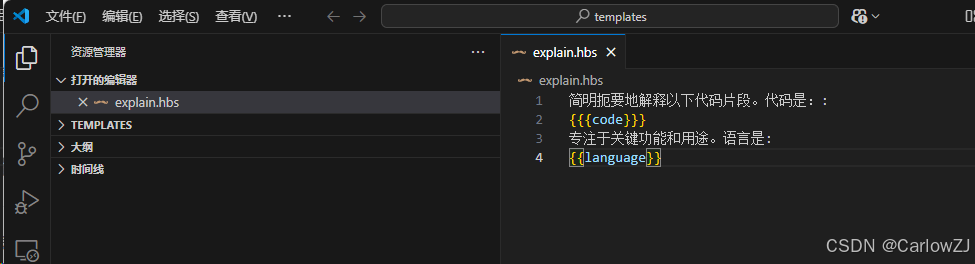

在vscode中安装twinny插件

(三)配置 VSCode

-

安装 Twinny 插件:

-

打开 VSCode,点击左侧的扩展图标。

-

搜索

Twinny并安装 Twinny 插件。 -

重启 VSCode 以确保插件生效。

-

-

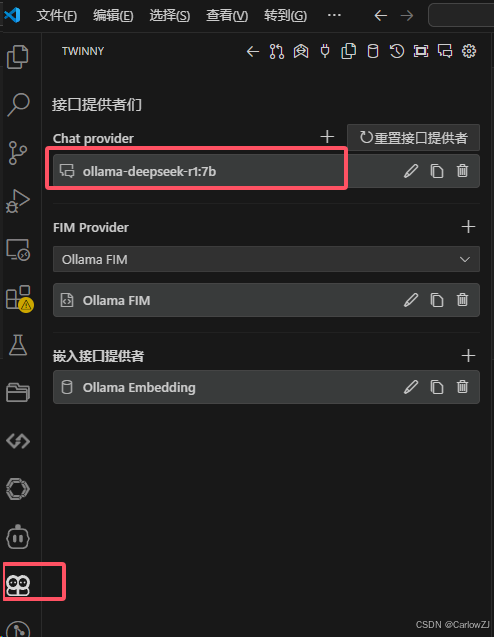

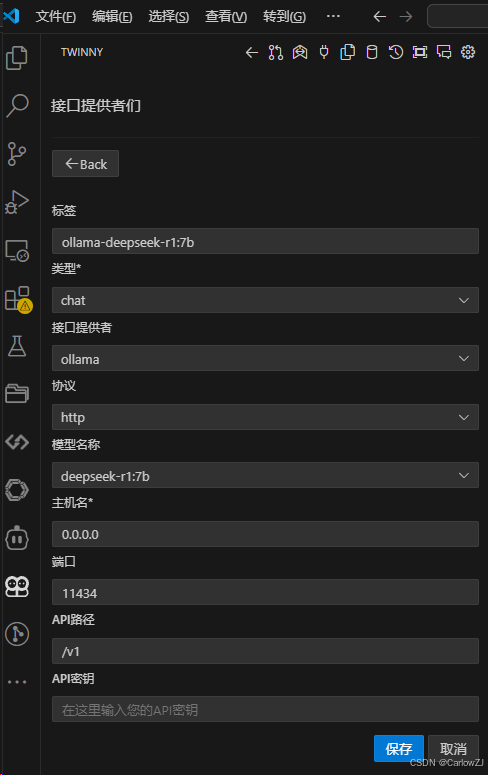

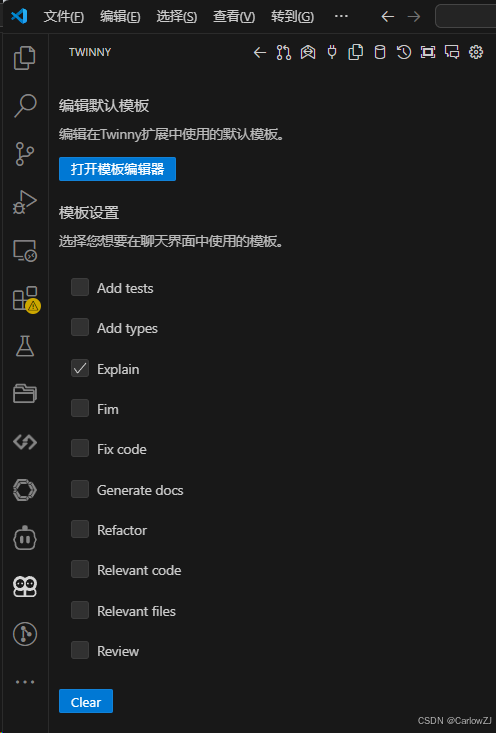

配置 Twinny 插件:

-

打开 VSCode 的设置(

Ctrl + ,或点击左下角的齿轮图标)。 -

搜索

Twinny,找到插件配置选项。 -

设置

Twinny API Key(如果需要)和Ollama Endpoint(通常是http://localhost:11434)。

-

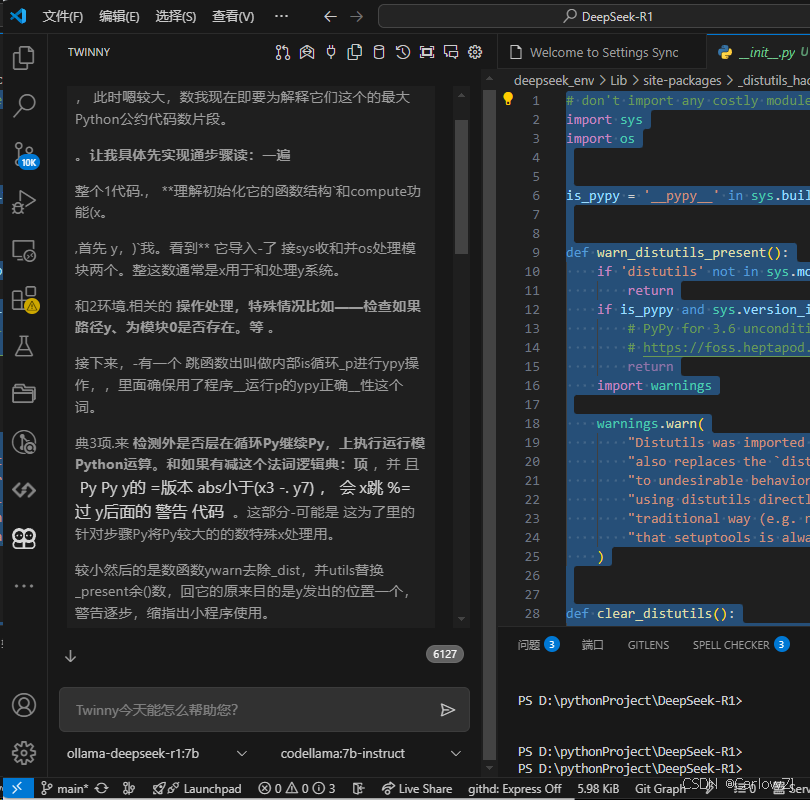

三、使用 VSCode + Ollama + Twinny

(一)代码生成

-

打开 VSCode 中的 Twinny 面板(通常在右侧)。

-

输入你的需求,例如:

请用 Python 写一个简单的 Web 服务器。 -

Twinny 会调用 Ollama 加载的 Twinny 模型,生成相应的代码,并直接显示在 VSCode 中。

(二)复杂任务处理

-

输入更复杂的任务,例如:

请优化这段代码的性能,并修复潜在的错误。 -

Twinny 会逐步分析代码,提出优化建议,并生成修复后的代码。

(三)文件操作

-

Twinny 支持直接在 VSCode 中创建和编辑文件。

-

输入:

创建一个名为 `main.py` 的文件,并写入以下内容:... -

Twinny 会自动在当前项目中创建文件并写入内容。

(四)终端命令执行

-

如果需要执行终端命令,输入:

请运行测试用例。 -

Twinny 会请求你的授权,然后在 VSCode 的终端中执行命令。

四、实际案例

(一)生成一个简单的 Python 项目

-

输入:

创建一个名为 `my_project` 的 Python 项目,包含以下文件: - main.py:包含一个简单的函数。 - tests.py:包含测试用例。 -

Twinny 会自动创建项目结构,并生成相应的代码。

(二)优化代码

-

将一段代码粘贴到 Twinny 面板中。

-

输入:

优化这段代码的性能。 -

Twinny 会分析代码并提供优化建议。

五、总结

通过 VSCode + Ollama + Twinny 的组合,开发者可以获得一个强大的 AI 编程环境。Twinny 提供了代码生成、复杂任务处理和文件操作的能力,而 Ollama 则确保了高性能的模型运行。这种组合不仅提升了开发效率,还降低了代码实现的复杂性。

如果你在使用过程中遇到任何问题,欢迎在评论区留言,我会及时为你解答。

版权声明

本文为原创文章,未经授权不得转载。如需转载,请联系作者获取授权。

另外优秀的博客:

1804

1804

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?