本文来源公众号“Coggle数据科学”,仅用于学术分享,侵权删,干货满满。

原文链接:https://mp.weixin.qq.com/s/rQWMRSDqkxIr27idpZCLzA

Tongyi DeepResearch 是由 通义实验室 (Tongyi Lab) 开发的一款智能体大语言模型,专门为长程、深度信息检索任务而设计。该模型总参数为 305 亿,但在每个 token 激活的参数仅有 33 亿。

WebWalker

https://arxiv.org/pdf/2501.07572

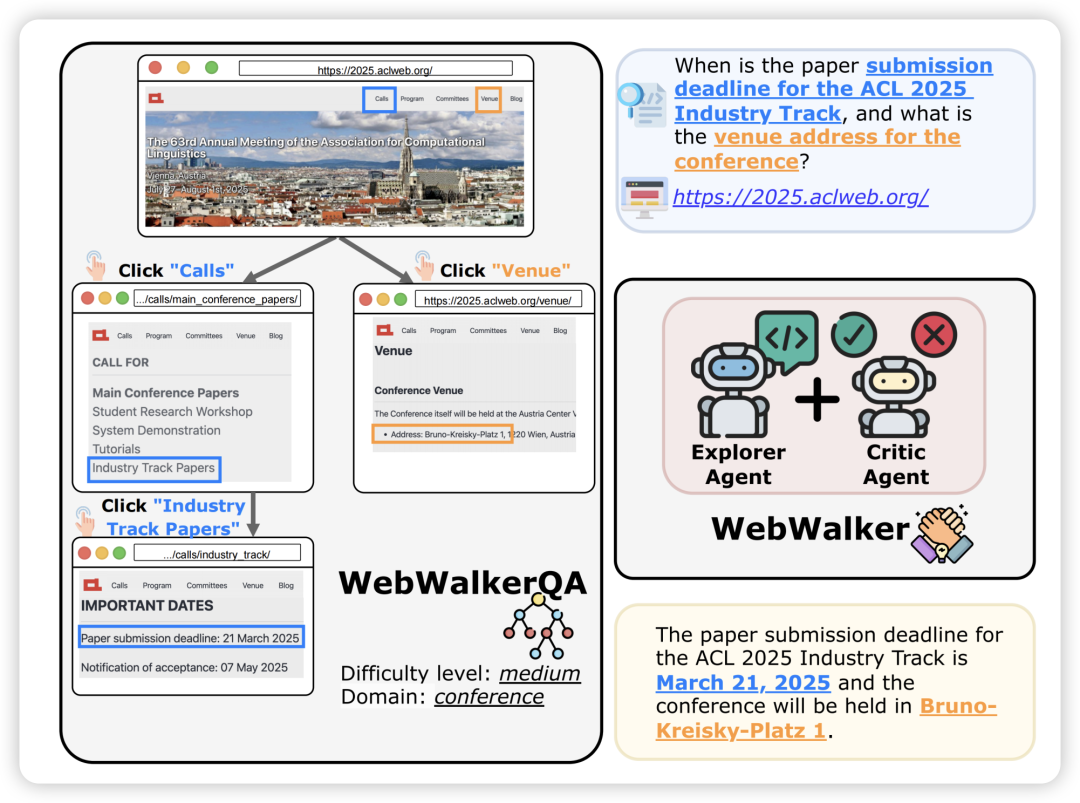

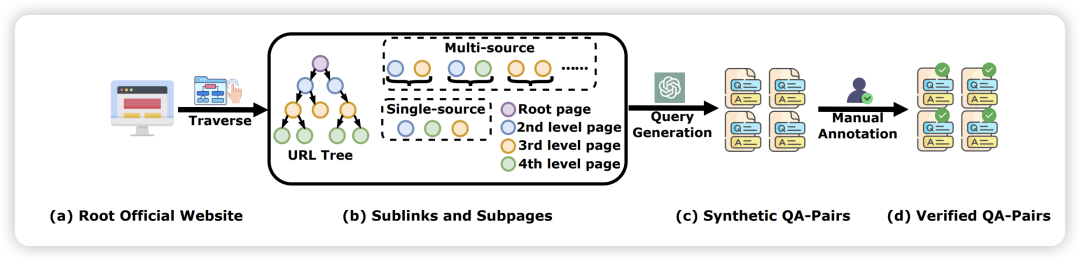

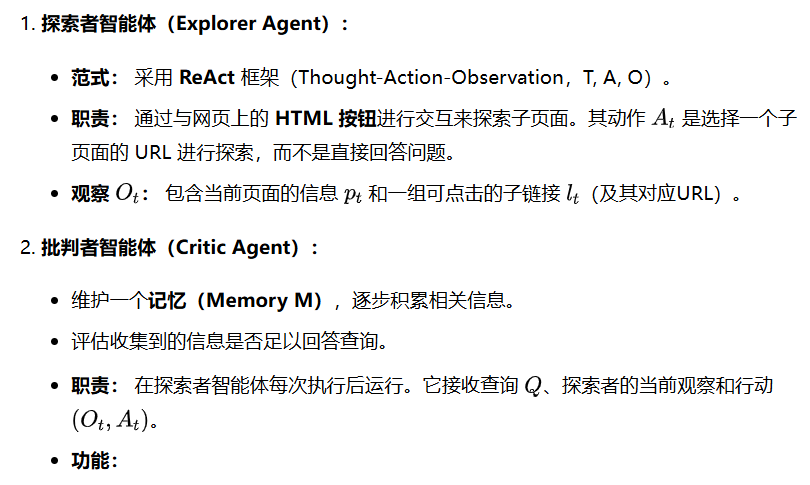

WebWalkerQA 是一个用于评估LLMs网络遍历能力的具有挑战性的基准。WebWalker 作为一个多智能体框架,有效地模仿了人类的网络导航。实验证明,将 RAG 与 WebWalker 结合,能显著提高网络导航任务的性能。这项工作强调了在基于网络的任务中进行深度、垂直探索的重要性。

WebWalker 是一个多智能体框架,通过垂直探索来模拟人类的网络导航,专门用于信息搜寻。

在所有骨干模型上,WebWalker 框架的性能均优于 Reflexion 和 ReAct 基线。结合 WebWalker 后,RAG 系统的性能在所有难度级别上都有所改善,尤其是在多源查询类别中。WebWalker 可以作为智能体 RAG 系统中的一个模块,实现垂直探索。

WebDancer

https://arxiv.org/pdf/2505.22648

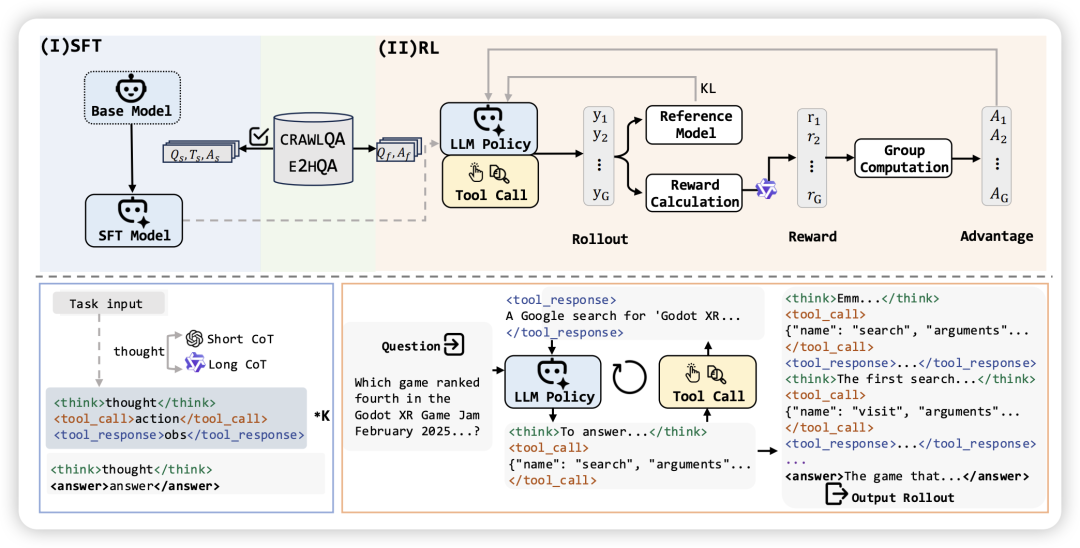

WebDancer 是一篇关于构建端到端自主信息搜寻智能体(End-to-end Agentic Information Seeking Agents)的论文,借鉴了 ChatGPT Deep Research 等系统的成功经验,提出了一个系统化的数据驱动和训练阶段范式。

WebDancer 的构建抽象为四个关键阶段,涵盖了数据构建、轨迹采样、SFT 冷启动和 RL 泛化增强。

-

第一阶段:构建深度信息搜寻数据集(Deep Information Seeking Dataset Construction)

-

第二阶段:智能体轨迹拒绝采样(Agent Trajectories Rejection Sampling)

-

第三阶段:智能体监督微调(Agent Supervised Fine-Tuning, SFT)

-

第四阶段:智能体强化学习(Agent Reinforcement Learning, RL)

WebSailor

https://arxiv.org/pdf/2507.02592

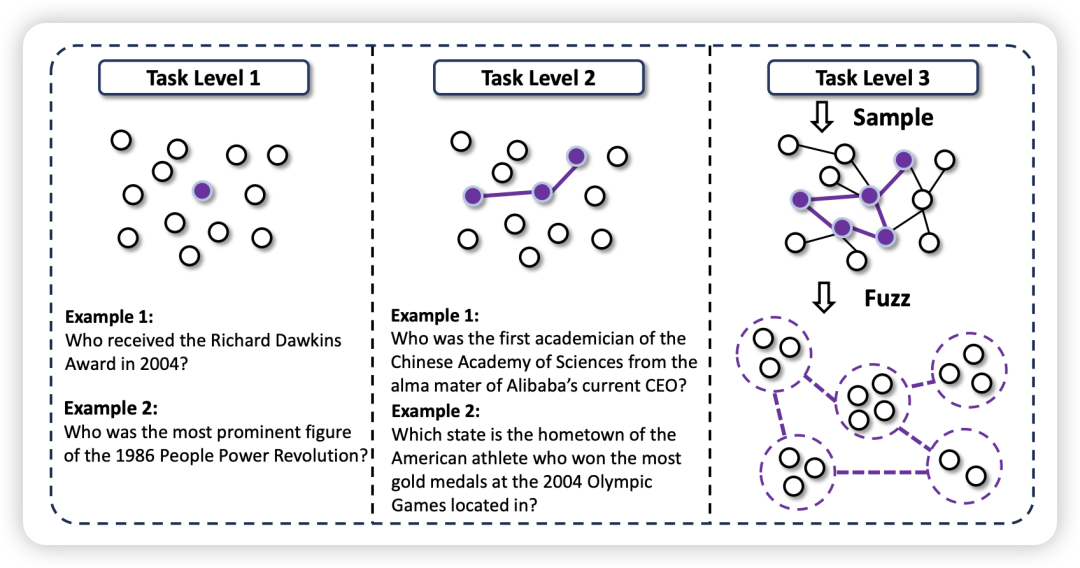

WebSailor 提出了一个完整的后训练(post-training)方法论,旨在将这种超人级的复杂推理能力植入到开源智能体中:

-

SailorFog-QA 数据集: 通过结构化采样和信息模糊化(Information Obfuscation),生成具有高、难减少的不确定性的 Level 3 任务。

-

推理轨迹重建: 利用强大的 LRM 专家生成行动-观察轨迹,然后重建简洁、面向行动的推理(Thought),作为高质量的 SFT 监督信号。

-

DUPO 强化学习算法: 提出 **Duplicating Sampling Policy Optimization (DUPO)**,一种高效的智能体 RL 训练算法,以解决多轮交互带来的训练速度慢的问题。

WebShaper

https://arxiv.org/pdf/2507.15061

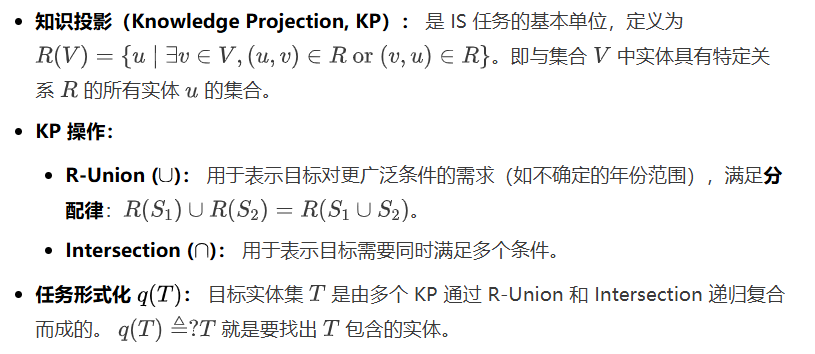

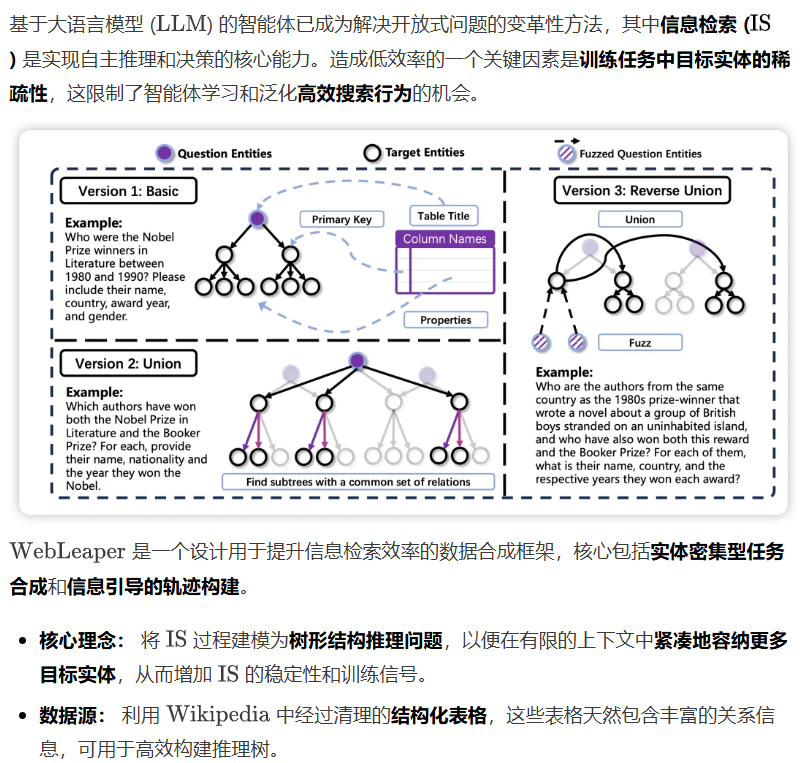

WebShaper 是一篇关于解决信息搜寻智能体(Information-Seeking Agents, IS Agents) 训练数据稀缺和质量问题的方法论论文。

WebShaper 的核心在于:首先系统性地形式化信息搜寻任务(使用集合论),然后以此形式化指导数据合成过程。

作者将信息搜寻任务视为一个统一的问题空间,并基于集合论(Set Theory)首次提出了信息搜寻任务的形式化。

WebWatcher

https://arxiv.org/pdf/2508.05748

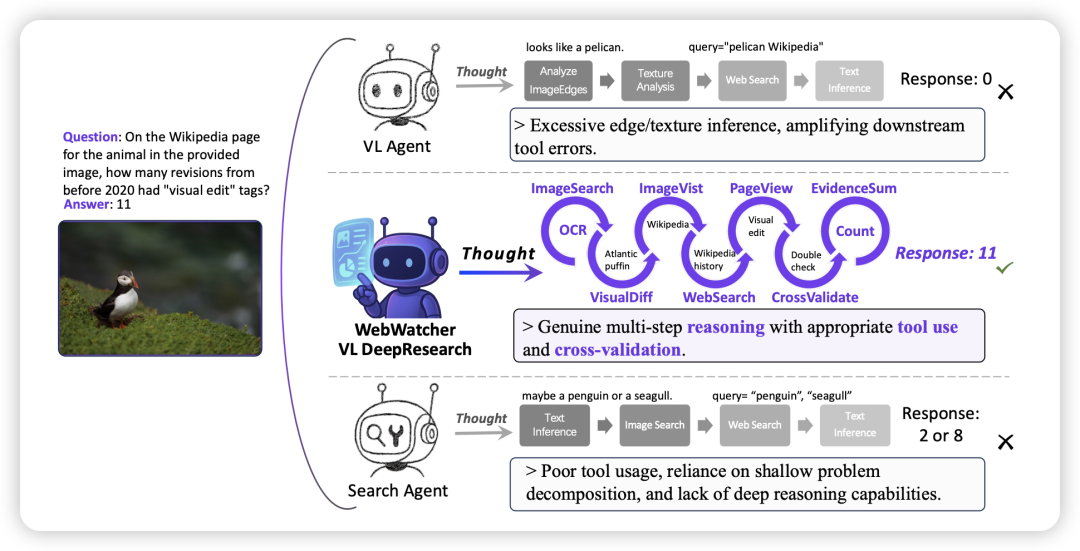

大多数研究仍以文本为中心,忽略了现实世界中无处不在的视觉信息。这使得多模态深度研究成为一个巨大的挑战,因为它不仅要求感知能力,还要求在逻辑、知识和工具使用方面具备更强大的推理能力。

WebWatcher 引入了一个具备增强的视觉-语言推理能力的多模态深度研究智能体。

-

BrowseComp-VL 基准: 提出了一个新的、高难度的多模态 VQA 基准,要求复杂的跨模态信息检索和超人级规划。

-

数据合成管线: 提出一套生成高难度、多步推理多模态轨迹的管线,实现高效的冷启动训练。

-

多工具集成: 集成网络图像搜索、文本搜索、网页访问、代码解释器和内部 OCR 等多种工具,支持深层推理。

-

强化学习优化: 通过 GRPO(Group-Relative Policy Optimization)算法进一步提升泛化能力。

WebWatcher 集成了强大的工具集,包括:

-

Web Image Search: 检索相关图像、标题和 URL。

-

Web Text Search: 检索文本信息。

-

Visit: 访问 URL 并总结网页内容(基于 Jina)。

-

Code Interpreter: 支持符号计算和数值推理。

-

OCR:内部工具,通过 SFT 数据激活,用于从输入图像中提取文本。

WebResearcher

https://arxiv.org/pdf/2509.13309

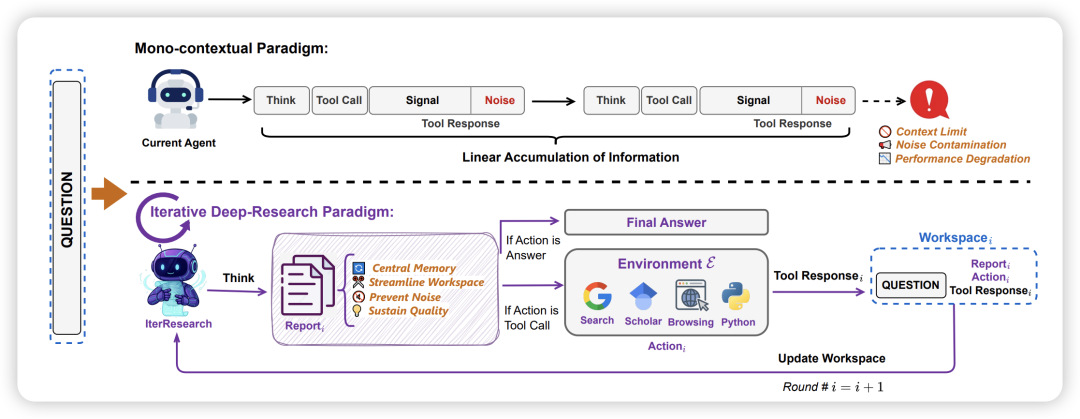

现有开源智能体范式(Mono-contextual Paradigm):** 当前主流的开源和早期专有系统(如 WebThinker, WebShaper)都采用单上下文范式,即将所有检索到的信息和中间推理步骤线性积累到一个不断膨胀的上下文窗口中。WebResearcher 提出了一个全新的框架,通过两个关键组件来解决单上下文范式的根本限制:

| 组件 | 描述 | 目标 |

|---|---|---|

| IterResearch | 迭代深度研究范式 ,将深度研究重新表述为马尔可夫决策过程(MDP)。 | 通过周期性报告整合和工作空间重构,实现无界的研究深度和持续的高质量推理。 |

| WebFrontier | 可扩展数据合成引擎 ,通过工具增强的复杂性升级,系统性地生成高质量、高复杂度的训练数据。 | 弥合被动知识回忆与主动知识构建之间的能力鸿沟,解决数据稀缺瓶颈。 |

| Research-Synthesis | 推理-合成框架 ,利用并行研究和集成合成实现测试时扩展。 | 在长程复杂任务中,充分利用多智能体的发散探索优势,得出更可靠结论。 |

智能体在每回合生成一个结构化的三元组,指导其决策:

-

Think: 智能体的认知草稿,用于内部推理、评估前一步结果、反思进展,并制定下一步计划(不保留到下一回合,防止干扰)。

-

Report(核心): 智能体的中央记忆。它不只是附加原始数据,而是综合新发现和现有知识,生成连贯、高密度的摘要。这个更新后的报告用于构建下一回合的工作空间。

-

Action: 具体行动,包括:

-

Tool Call: 调用外部工具(搜索、浏览、Python 等)。

-

Final Answer: 终结行动,认为有足够证据解决问题。

-

WebWeaver

https://arxiv.org/pdf/2509.13312

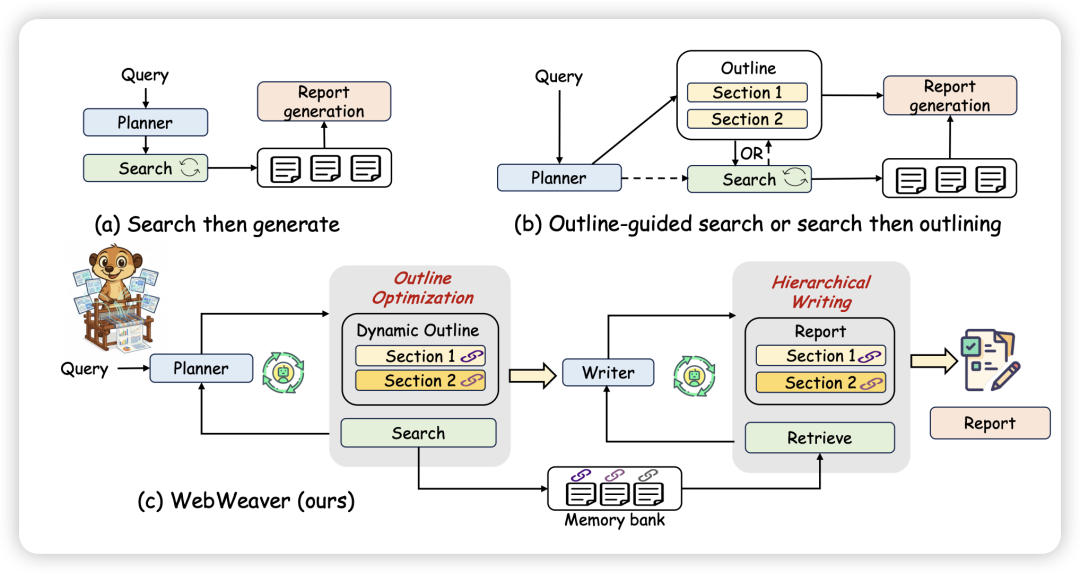

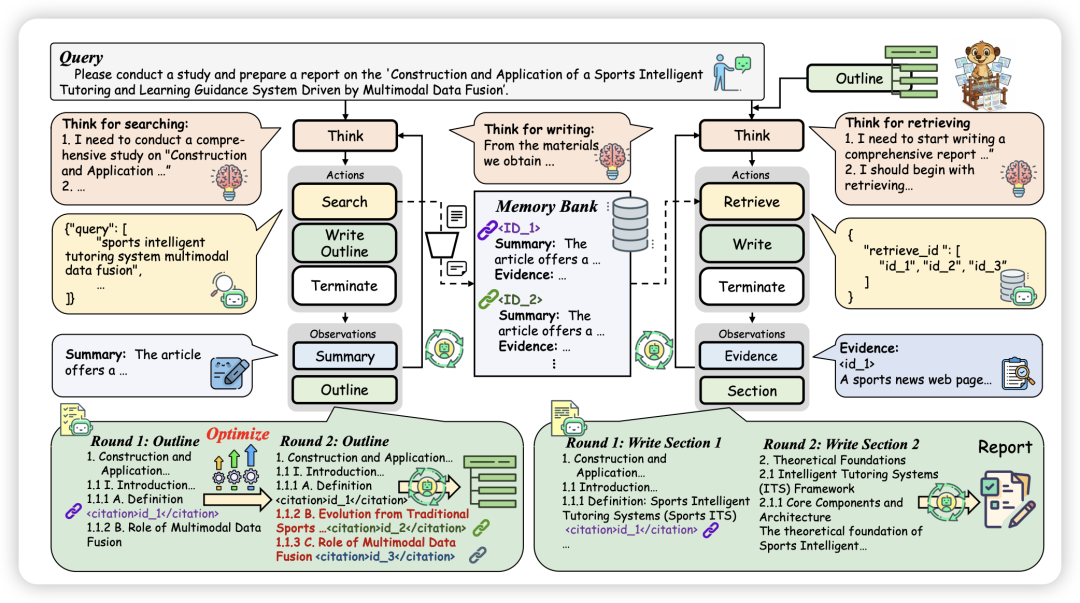

多数方法遵循静态研究管道,将规划(大纲)与证据获取(搜索)解耦,例如:“先搜索后生成”或“先静态大纲后搜索”。这导致大纲基于过时的内部知识或受限于初次搜索范围,缺乏适应性。WebWeaver 引入了一种双智能体框架,模仿人类研究过程,以解决上述挑战。

| 智能体 | 核心功能 | 解决问题 |

|---|---|---|

| Planner (规划者) | 动态研究周期 :交错进行证据获取和大纲优化。输出一个带引用的综合大纲,链接到证据记忆库。 | 解决了静态规划问题,确保大纲适应最新的发现;提高了证据搜集的针对性。 |

| Writer (撰写者) | 分层检索与写作 :逐节撰写报告,通过大纲中的引用,从记忆库中精准检索仅需的证据。 | 解决了长上下文问题、注意力分散和引用幻觉,确保证据可靠性和报告结构。 |

WebWeaver 的工作流分为规划阶段(Planner)和合成阶段(Writer)。Planner 负责探索性研究,其核心是动态研究周期,模仿人类专家允许草稿和搜索共同演进。

Planner 迭代地选择三个行动之一:搜索、撰写大纲、终止。

-

证据获取 (Search): 当证据不足时,执行搜索。

-

LLM 根据标题和片段选择相关 URL。

-

对选定页面:LLM 提炼出查询相关的简短摘要(用于 Planner 的上下文)和可验证的详细证据(用于存储到记忆库)。

-

初次检索: 查询搜索引擎,返回 URL、片段和标题。

-

两阶段过滤:

-

-

大纲优化 (Write Outline): 收集到新证据后,Planner 持续细化和优化报告大纲。

-

结构调整: 根据新信息扩展章节、添加论点或重组整体结构。

-

引用填充: 最关键的一步是,在大纲的每个部分填充引用 ID,将其映射到记忆库中存储的相应证据。

-

-

终止 (Terminate): 当大纲足够全面并有证据支撑时,Planner 输出 $\text{}$ 动作,结束规划。

Writer 负责合成报告,其策略是分层、引用驱动、目标注意力写作。

-

确定子任务: 识别当前要撰写的章节。

-

目标检索 (Retrieve): 根据大纲中的引用 ID,从记忆库中提取相关证据。

-

内部推理 (Think): 接收检索到的证据后,Writer 进行关键的推理分析。它分析证据、综合见解、选择最具说服力的论据,并制定连贯的叙事结构。

-

撰写 (Write): 根据推理结果撰写章节内容。

-

上下文剪枝: 章节完成后,对应的源材料被显式地从上下文窗口中移除,并替换为占位符。

WebReSum

https://arxiv.org/pdf/2509.13313

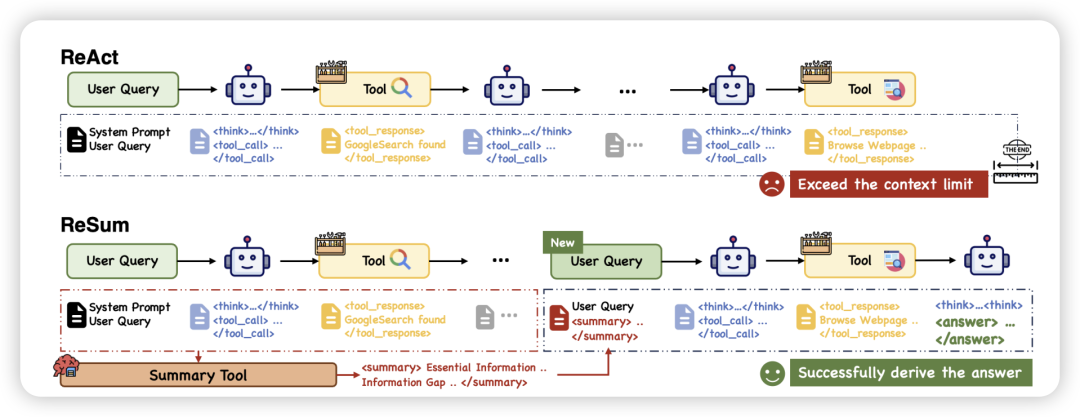

上下文窗口限制是 ReAct 范式的致命缺陷。复杂的查询(涉及多个实体、交织关系、高不确定性)需要多轮探索才能找到答案。

ReSum 是一种新颖的范式,通过周期性上下文摘要实现无限期探索,从而克服了上下文约束。

| 组件 | 描述 | 目标 |

|---|---|---|

| ReSum 范式 | 定期 调用摘要工具,将不断增长的交互历史转化为紧凑的推理状态(结构化摘要),并从摘要状态恢复推理。 | 绕过上下文约束 ,实现长程、无限制的探索。 |

| ReSumTool-30B | 一个专业化的摘要模型,通过目标训练,专门用于提取关键证据、识别信息缺口和指导下一步行动。 | 提供高效、高质量、目标导向的摘要,克服通用 LLM 在 Web 搜索上下文中的不足。 |

| ReSum-GRPO | 一种定制的强化学习(RL)算法,通过分割轨迹训练和优势广播,使智能体适应摘要条件推理。 | 使智能体掌握 ReSum 范式,无需昂贵的专家数据,并保留其固有推理能力。 |

ReSum 旨在最大限度地减少对 ReAct 架构的修改,确保即插即用的兼容性。

ReSum 自然地将长轨迹分割成多个训练片段(Episodes):

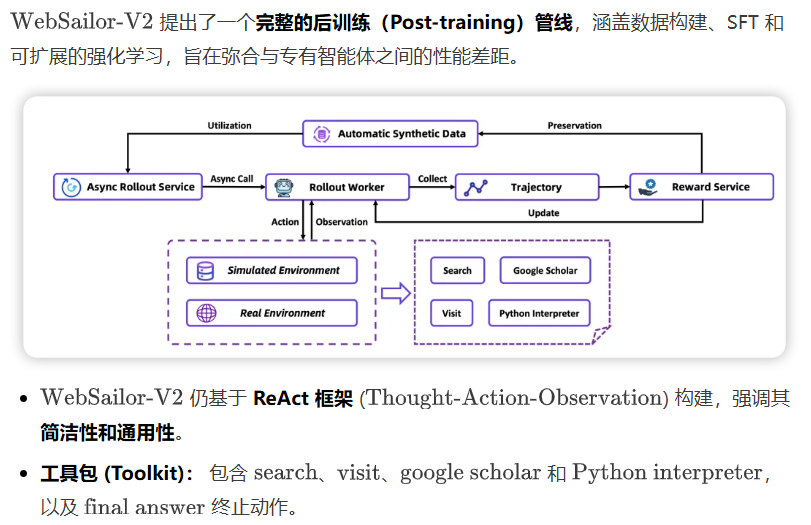

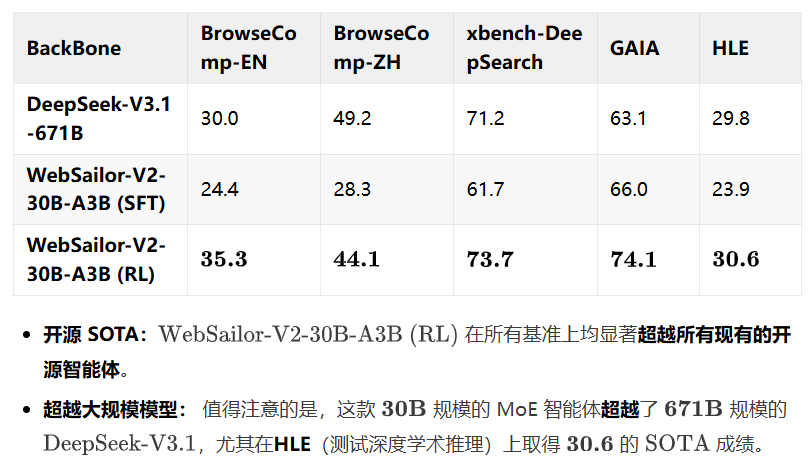

WebSailor-V2

https://arxiv.org/pdf/2509.13305

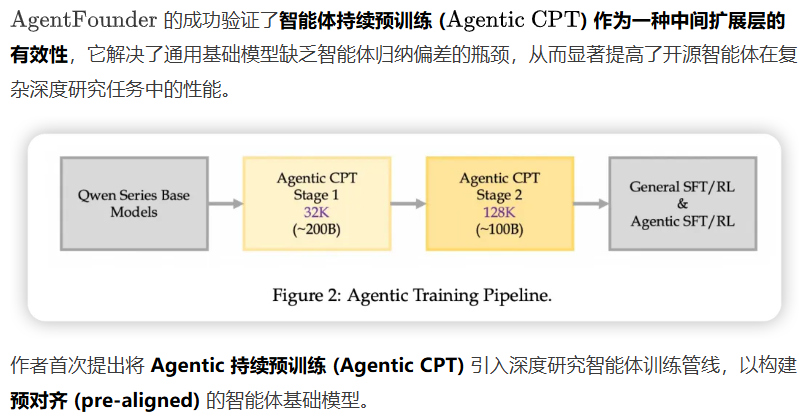

AgentFounder

https://arxiv.org/pdf/2509.13310

AgentScaler

https://arxiv.org/pdf/2509.13311

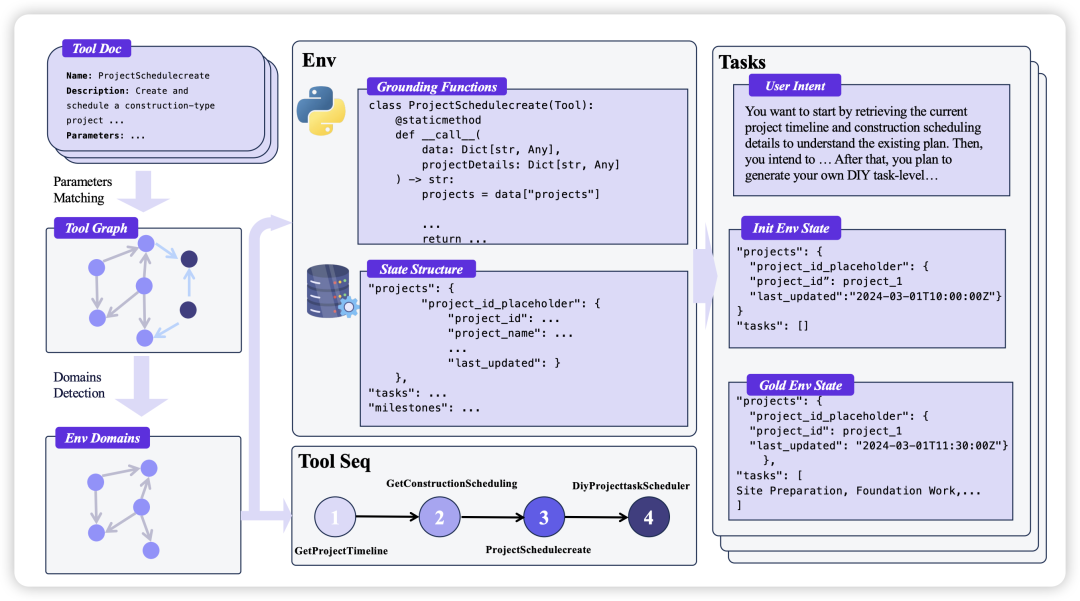

通用智能体智能的进步受到智能体数据稀缺性的制约。智能体必须在多样的环境中通过交互发展其功能调用能力,因此,功能调用能力的广度与训练环境的多样性密切相关。

AgentScaler通过系统性地扩展环境来推进通用智能体智能的发展,提出了一个两阶段的、可扩展的框架:

任何函数调用都可以抽象为对底层环境数据库 D 的读写操作。同一领域的工具具有结构相似的读写模式,可由共同的数据库模式 S_k 捕获。

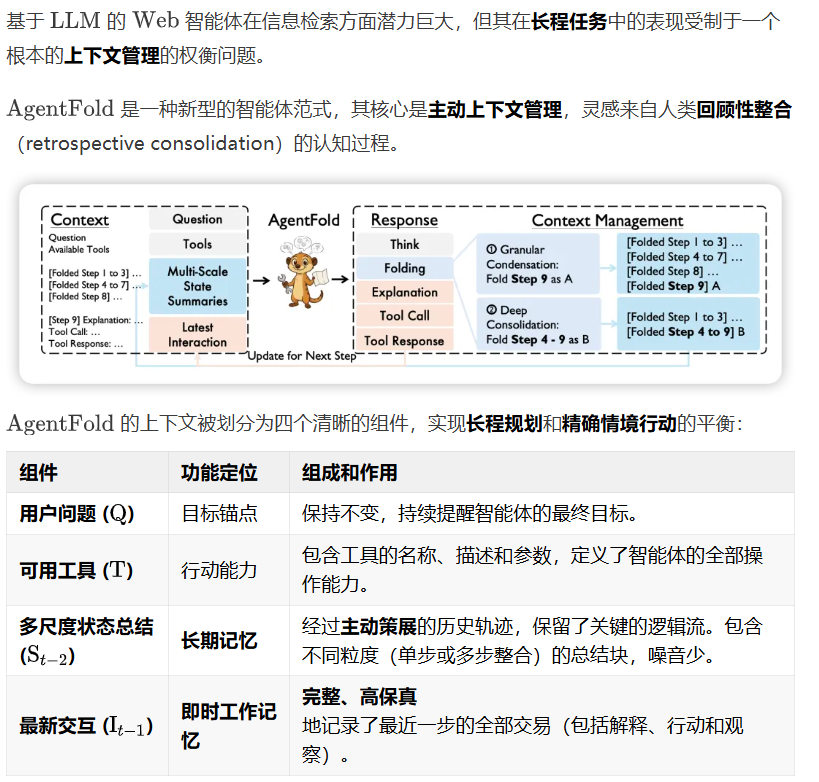

AgentFold

https://arxiv.org/pdf/2510.24699

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

2423

2423

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?