文章目录

四、 DML(Data Manipulation Language)数据操作

4.1 Load

Load语句可将文件导入到Hive表中。

1)语法

hive>

LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE

tablename [PARTITION (partcol1=val1, partcol2=val2 ...)];

关键字说明:

(1)local:表示从本地加载数据到Hive表;否则从HDFS加载数据到Hive表。

(2)overwrite:表示覆盖表中已有数据,否则表示追加。

(3)partition:表示上传到指定分区,若目标是分区表,需指定分区。

2)实操案例

(1)创建一张表

hive (default)>

create table student(

id int,

name string

)

row format delimited fields terminated by '\t';

(2)加载本地文件到hive

hive (default)> load data local inpath

'/opt/module/datas/student.txt' into table student;

(3)加载HDFS文件到hive中

①上传文件到HDFS

[atguigu@hadoop102 ~]$ hadoop fs -put

/opt/module/datas/student.txt /user/atguigu

②加载HDFS上数据,导入完成后去HDFS上查看文件是否还存在

hive (default)>

load data inpath '/user/atguigu/student.txt'

into table student;

(4)加载数据覆盖表中已有的数据

①上传文件到HDFS

hive (default)> dfs -put

/opt/module/datas/student.txt /user/atguigu;

②加载数据覆盖表中已有的数据

hive (default)>

load data inpath '/user/atguigu/student.txt'

overwrite into table student;

4.2 Insert

4.2.1 将查询结果插入表中

1)语法

INSERT (INTO | OVERWRITE) TABLE tablename [PARTITION

(partcol1=val1, partcol2=val2 ...)] select_statement;

关键字说明:

(1)INTO:将结果追加到目标表

(2)OVERWRITE:用结果覆盖原有数据

2)案例

(1)新建一张表

hive (default)>

create table student1(

id int,

name string

)

row format delimited fields terminated by '\t';

(2)根据查询结果插入数据

hive (default)> insert overwrite table student3

select

id,

name

from student;

4.2.2 将给定Values插入表中

1)语法

INSERT (INTO | OVERWRITE) TABLE tablename [PARTITION

(partcol1[=val1], partcol2[=val2] ...)] VALUES values_row [, values_row ...]

2)案例

hive (default)> insert into table student1 values(1,'wangwu'),(2,'zhaoliu');

4.2.3 将查询结果写入目标路径

1)语法

INSERT OVERWRITE [LOCAL] DIRECTORY directory

[ROW FORMAT row_format] [STORED AS

file_format] select_statement;

2)案例

insert overwrite local directory '/opt/module/datas/student' ROW FORMAT SERDE

'org.apache.hadoop.hive.serde2.JsonSerDe'

select id,name from student;

4.3 Export&Import

Export导出语句可将表的数据和元数据信息一并到处的HDFS路径,Import可将Export导出的内容导入Hive,表的数据和元数据信息都会恢复。Export和Import可用于两个Hive实例之间的数据迁移。

1)语法

--导出

EXPORT TABLE tablename TO 'export_target_path'

--导入

IMPORT [EXTERNAL] TABLE new_or_original_tablename FROM 'source_path' [LOCATION 'import_target_path']

2)案例

--导出

hive>

export table default.student to '/user/hive/warehouse/export/student';

--导入

hive>

import table student2 from '/user/hive/warehouse/export/student';

五、 查询

5.1 基础语法

1)官网地址

https://cwiki.apache.org/confluence/display/Hive/LanguageManual+Select

2)查询语句语法:

SELECT [ALL | DISTINCT] select_expr, select_expr, ...

FROM table_reference -- 从什么表查

[WHERE where_condition] -- 过滤

[GROUP BY col_list] -- 分组查询

[HAVING col_list] -- 分组后过滤

[ORDER BY col_list] -- 排序

[CLUSTER BY col_list

| [DISTRIBUTE BY col_list] [SORT BY col_list]

]

[LIMIT number] -- 限制输出的行数

5.2 基本查询(Select…From)

5.2.1 数据准备

(1)原始数据

①在/opt/module/hive/datas/路径上创建dept.txt文件,并赋值如下内容:

部门编号 部门名称 部门位置id

[atguigu@hadoop102 datas]$ vim dept.txt

10 行政部 1700

20 财务部 1800

30 教学部 1900

40 销售部 1700

②在/opt/module/hive/datas/路径上创建emp.txt文件,并赋值如下内容:

员工编号 姓名 岗位 薪资 部门

[atguigu@hadoop102 datas]$ vim emp.txt

7369 张三 研发 800.00 30

7499 李四 财务 1600.00 20

7521 王五 行政 1250.00 10

7566 赵六 销售 2975.00 40

7654 侯七 研发 1250.00 30

7698 马八 研发 2850.00 30

7782 金九 \N 2450.0 30

7788 银十 行政 3000.00 10

7839 小芳 销售 5000.00 40

7844 小明 销售 1500.00 40

7876 小李 行政 1100.00 10

7900 小元 讲师 950.00 30

7902 小海 行政 3000.00 10

7934 小红明 讲师 1300.00 30

(1)创建部门表

hive (default)>

create table if not exists dept(

deptno int, -- 部门编号

dname string, -- 部门名称

loc int -- 部门位置

)

row format delimited fields terminated by '\t';

(2)创建员工表

hive (default)>

create table if not exists emp(

empno int, -- 员工编号

ename string, -- 员工姓名

job string, -- 员工岗位(大数据工程师、前端工程师、java工程师)

sal double, -- 员工薪资

deptno int -- 部门编号

)

row format delimited fields terminated by '\t';

(3)导入数据

hive (default)>

load data local inpath '/opt/module/hive/datas/dept.txt' into table dept;

load data local inpath '/opt/module/hive/datas/emp.txt' into table emp;

5.2.2 全表和特定列查询

1)全表查询

hive (default)> select * from emp;

2)选择特定列查询

hive (default)> select empno, ename from emp;

注意:

(1)SQL 语言大小写不敏感。

(2)SQL 可以写在一行或者多行。

(3)关键字不能被缩写也不能分行。

(4)各子句一般要分行写。

(5)使用缩进提高语句的可读性。

5.2.3 列别名

1)重命名一个列

2)便于计算

3)紧跟列名,也可以在列名和别名之间加入关键字‘AS’

4)案例实操

- 查询名称和部门。

hive (default)>

select

ename AS name,

deptno dn

from emp;

5.2.4 Limit语句

典型的查询会返回多行数据。limit子句用于限制返回的行数。

hive (default)> select * from emp limit 5;

hive (default)> select * from emp limit 2,3; -- 表示从第2行开始,向下抓取3行

5.2.5 Where语句

1)使用where子句,将不满足条件的行过滤掉

2)where子句紧随from子句

3)案例实操

- 查询出薪水大于1000的所有员工。

hive (default)> select * from emp where sal > 1000;

注意:where子句中不能使用字段别名。

5.2.6 关系运算函数

1)基本语法

如下操作符主要用于where和having语句中。

| 操作符 | 支持的数据类型 | 描述 |

|---|---|---|

| A=B | 基本数据类型 | 如果A等于B则返回true,反之返回false |

| A<=>B | 基本数据类型 | 如果A和B都为null或者都不为null,则返回true,如果只有一边为null,返回false |

| A<>B, A!=B | 基本数据类型 | A或者B为null则返回null;如果A不等于B,则返回true,反之返回false |

| A<B | 基本数据类型 | A或者B为null,则返回null;如果A小于B,则返回true,反之返回false |

| A<=B | 基本数据类型 | A或者B为null,则返回null;如果A小于等于B,则返回true,反之返回false |

| A>B | 基本数据类型 | A或者B为null,则返回null;如果A大于B,则返回true,反之返回false |

| A>=B | 基本数据类型 | A或者B为null,则返回null;如果A大于等于B,则返回true,反之返回false |

| A [not] between B and C | 基本数据类型 | 如果A,B或者C任一为null,则结果为null。如果A的值大于等于B而且小于或等于C,则结果为true,反之为false。如果使用not关键字则可达到相反的效果。 |

| A is null | 所有数据类型 | 如果A等于null,则返回true,反之返回false |

| A is not null | 所有数据类型 | 如果A不等于null,则返回true,反之返回false |

| in(数值1,数值2) | 所有数据类型 | 使用 in运算显示列表中的值 |

| A [not] like B | string 类型 | B是一个SQL下的简单正则表达式,也叫通配符模式,如果A与其匹配的话,则返回true;反之返回false。B的表达式说明如下:‘x%’表示A必须以字母‘x’开头,‘%x’表示A必须以字母‘x’结尾,而‘%x%’表示A包含有字母‘x’,可以位于开头,结尾或者字符串中间。如果使用not关键字则可达到相反的效果。 |

| A rlike B, A regexp B | string 类型 | B是基于java的正则表达式,如果A与其匹配,则返回true;反之返回false。匹配使用的是JDK中的正则表达式接口实现的,因为正则也依据其中的规则。例如,正则表达式必须和整个字符串A相匹配,而不是只需与其字符串匹配。 |

5.2.7 逻辑运算函数

1)基本语法(and/or/not)

| 操作符 | 含义 |

|---|---|

| and | 逻辑并 |

| or | 逻辑或 |

| not | 逻辑否 |

2)案例实操

(1)查询薪水大于1000,部门是30

hive (default)>

select

*

from emp

where sal > 1000 and deptno = 30;

(2)查询薪水大于1000,或者部门是30

hive (default)>

select

*

from emp

where sal>1000 or deptno=30;

(3)查询除了20部门和30部门以外的员工信息

hive (default)>

select

*

from emp

where deptno not in(30, 20);

5.2.8 聚合函数

1)语法

count(*),表示统计所有行数,包含null值;

count(某列),表示该列一共有多少行,不包含null值;

max(),求最大值,不包含null,除非所有值都是null;

min(),求最小值,不包含null,除非所有值都是null;

sum(),求和,不包含null。

avg(),求平均值,不包含null。

2)案例实操

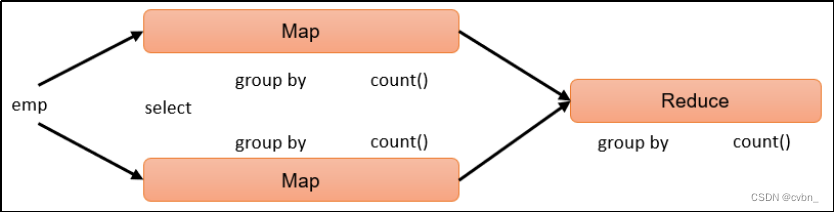

(1)求总行数(count)

hive (default)> select count(*) cnt from emp;

hive sql执行过程:

(2)求工资的最大值(max)

hive (default)> select max(sal) max_sal from emp;

hive sql执行过程:

(3)求工资的最小值(min)

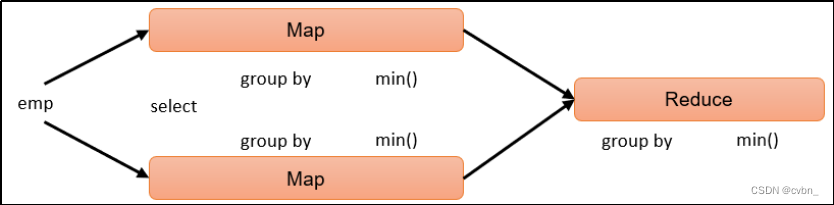

hive (default)> select min(sal) min_sal from emp;

hive sql执行过程:

(4)求工资的总和(sum)

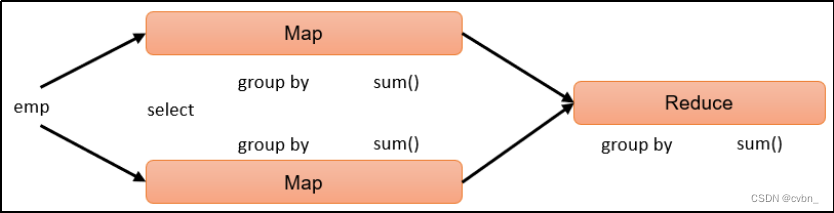

hive (default)> select sum(sal) sum_sal from emp;

hive sql执行过程:

(5)求工资的平均值(avg)

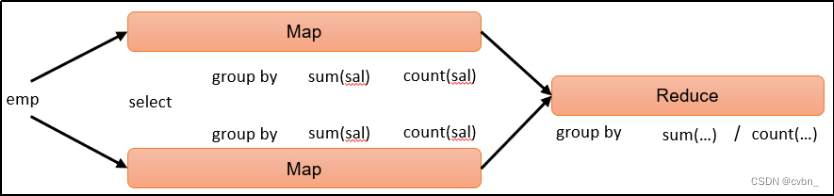

hive (default)> select avg(sal) avg_sal from emp;

hive sql执行过程:

5.3 分组

5.3.1 Group By语句

Group By语句通常会和聚合函数一起使用,按照一个或者多个列队结果进行分组,然后对每个组执行聚合操作。

1)案例实操:

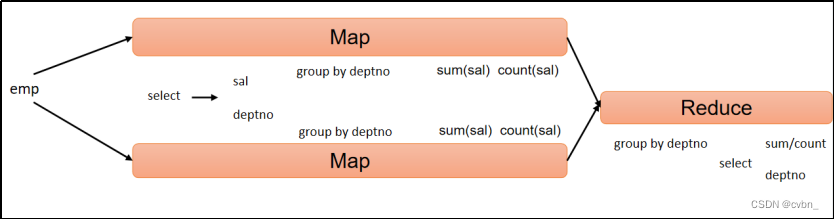

(1)计算emp表每个部门的平均工资。

hive (default)>

select

t.deptno,

avg(t.sal) avg_sal

from emp t

group by t.deptno;

hive sql执行过程:

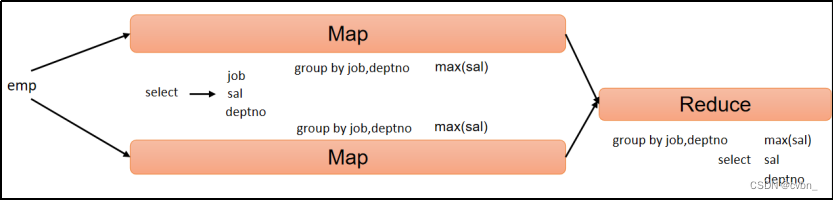

(2)计算emp每个部门中每个岗位的最高薪水。

hive (default)>

select

t.deptno,

t.job,

max(t.sal) max_sal

from emp t

group by t.deptno, t.job;

hive sql执行过程:

5.3.2 Having语句

1)having与where不同点

(1)where后面不能写分组聚合函数,而having后面可以使用分组聚合函数。

(2)having只用于group by分组统计语句。

2)案例实操

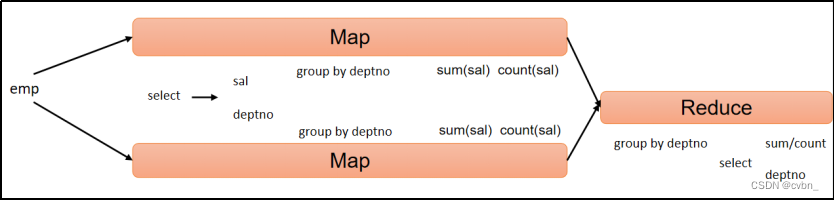

(1)求每个部门的平均薪水大于2000的部门

①求每个部门的平均工资。

hive (default)>

select

deptno,

avg(sal)

from emp

group by deptno;

hive sql执行过程:

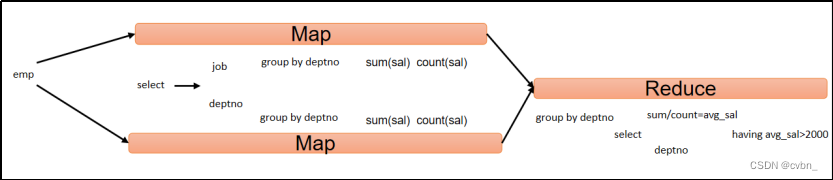

②求每个部门的平均薪水大于2000的部门。

hive (default)>

select

deptno,

avg(sal) avg_sal

from emp

group by deptno

having avg_sal > 2000;

hive sql执行过程:

5.4 Join语句

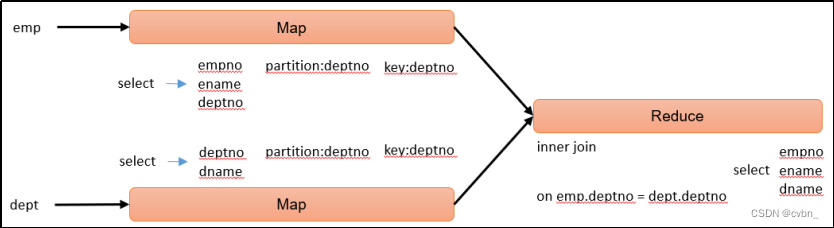

5.4.1 等值Join

Hive支持通常的sql join语句,但是只支持等值连接,不支持非等值连接。

1)案例实操

(1)根据员工表和部门表中的部门编号相等,查询员工编号、员工名称和部门名称。

hive (default)>

select

e.empno,

e.ename,

d.dname

from emp e

join dept d

on e.deptno = d.deptno;

hive sql执行过程:

5.4.2 表的别名

1)好处

(1)使用别名可以简化查询。

(2)区分字段的来源。

2)案例实操

- 合并员工表和部门表。

hive (default)>

select

e.*,

d.*

from emp e

join dept d

on e.deptno = d.deptno;

5.4.3 内连接

- 内连接:只有进行连接的两个表中都存在与连接条件相匹配的数据才会被保留下来。

hive (default)>

select

e.empno,

e.ename,

d.deptno

from emp e

join dept d

on e.deptno = d.deptno;

5.4.4 左外连接

- 左外连接:join操作符左边表中符合where子句的所有记录将会被返回。

hive (default)>

select

e.empno,

e.ename,

d.deptno

from emp e

left join dept d

on e.deptno = d.deptno;

6.4.5 右外连接

- 右外连接:join操作符右边表中符合where子句的所有记录将会被返回。

hive (default)>

select

e.empno,

e.ename,

d.deptno

from emp e

right join dept d

on e.deptno = d.deptno;

5.4.6 满外连接

满外连接:将会返回所有表中符合where语句条件的所有记录。如果任一表的指定字段没有符合条件的值的话,那么就使用null值替代。

hive (default)>

select

e.empno,

e.ename,

d.deptno

from emp e

full join dept d

on e.deptno = d.deptno;

5.4.7 多表连接

注意:连接n个表,至少需要n-1个连接条件。例如:连接三个表,至少需要两个连接条件。

数据准备,在/opt/module/hive/datas/下:vim location.txt

部门位置id 部门位置

[atguigu@hadoop102 datas]$ vim location.txt

1700 北京

1800 上海

1900 深圳

1)创建位置表

hive (default)>

create table if not exists location(

loc int, -- 部门位置id

loc_name string -- 部门位置

)

row format delimited fields terminated by '\t';

2)导入数据

hive (default)> load data local inpath '/opt/module/hive/datas/location.txt' into table location;

3)多表连接查询

hive (default)>

select

e.ename,

d.dname,

l.loc_name

from emp e

join dept d

on d.deptno = e.deptno

join location l

on d.loc = l.loc;

大多数情况下,Hive会对每对join连接对象启动一个MapReduce任务。本例中会首先启动一个MapReduce

job对表e和表d进行连接操作,然后会再启动一个MapReduce job将第一个MapReduce job的输出和表l进行连接操作。

注意:为什么不是表d和表l先进行连接操作呢?这是因为Hive总是按照从左到右的顺序执行的。

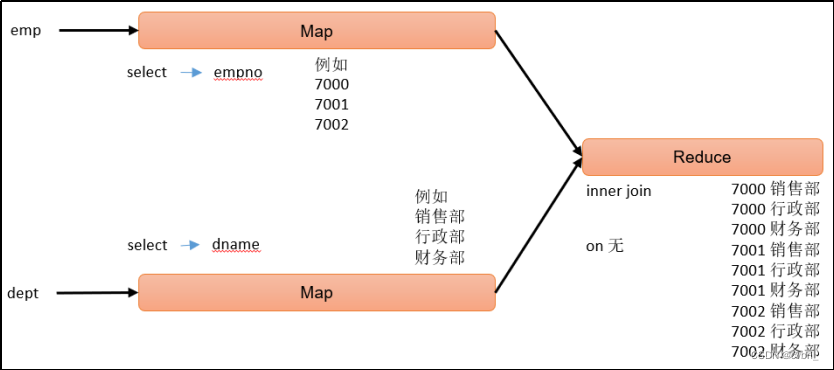

5.4.8 笛卡尔集

1)笛卡尔集会在下面条件下产生

(1)省略连接条件

(2)连接条件无效

(3)所有表中的所有行互相连接

2)案例实操

hive (default)>

select

empno,

dname

from emp, dept;

hive sql执行过程:

5.4.9 联合(union & union all)

1)union&union all上下拼接

union和union all都是上下拼接sql的结果,这点是和join有区别的,join是左右关联,union和union all是上下拼接。union去重,union all不去重。

union和union all在上下拼接sql结果时有两个要求:

(1)两个sql的结果,列的个数必须相同

(2)两个sql的结果,上下所对应列的类型必须一致

2)案例实操

将员工表30部门的员工信息和40部门的员工信息,利用union进行拼接显示。

hive (default)>

select

*

from emp

where deptno=30

union

select

*

from emp

where deptno=40;

5.5 排序

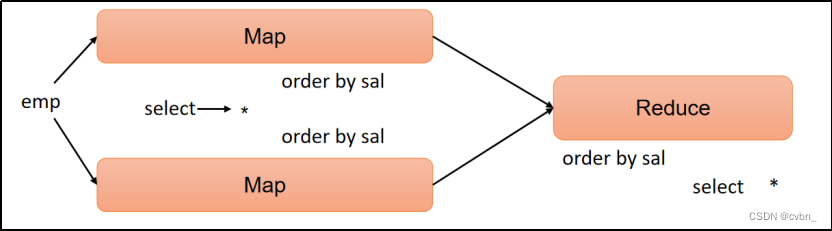

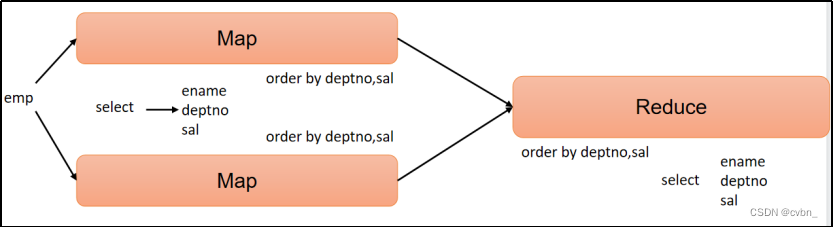

5.5.1 全局排序(Order By)

Order By:全局排序,只有一个Reduce。

1)使用Order By子句排序

asc(ascend):升序(默认)

desc(descend):降序

2)Order By子句在select语句的结尾

3)基础案例实操

(1)查询员工信息按工资升序排列

hive (default)>

select

*

from emp

order by sal;

hive sql执行过程:

(2)查询员工信息按工资降序排列

hive (default)>

select

*

from emp

order by sal desc;

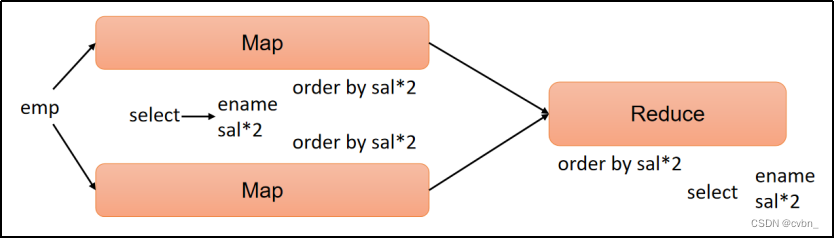

4)按照别名排序案例实操

按照员工薪水的2倍排序。

hive (default)>

select

ename,

sal * 2 twosal

from emp

order by twosal;

hive sql执行过程:

5)多个列排序案例实操

按照部门和工资升序排序。

hive (default)>

select

ename,

deptno,

sal

from emp

order by deptno, sal;

hive sql执行过程:

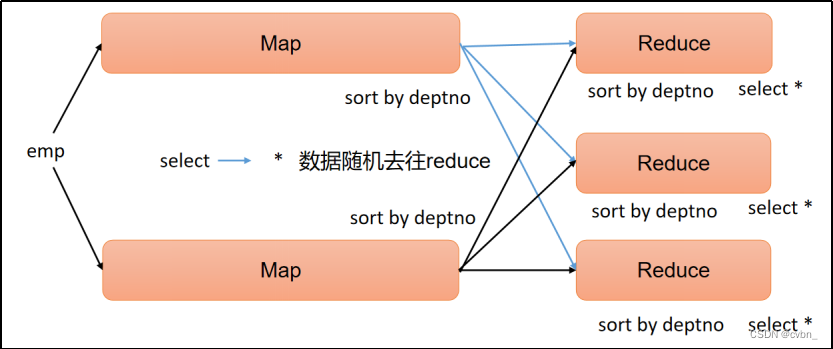

5.5.2 每个Reduce内部排序(Sort By)

Sort By:对于大规模的数据集order by的效率非常低。在很多情况下,并不需要全局排序,此时可以使用Sort by。

Sort by为每个reduce产生一个排序文件。每个Reduce内部进行排序,对全局结果集来说不是排序。

1)设置reduce个数

hive (default)> set mapreduce.job.reduces=3;

2)查看设置reduce个数

hive (default)> set mapreduce.job.reduces;

3)根据部门编号降序查看员工信息

hive (default)>

select

*

from emp

sort by deptno desc;

hive sql执行过程:

4)将查询结果导入到文件中(按照部门编号降序排序)

hive (default)> insert overwrite local directory

'/opt/module/hive/datas/sortby-result'

select * from emp sort by deptno desc;

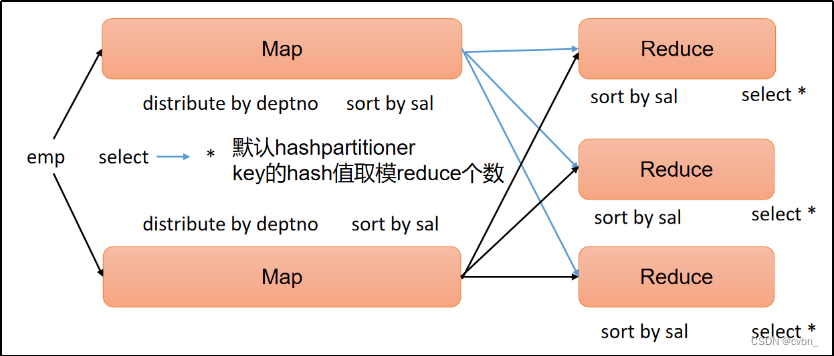

5.5.3 分区(Distribute By)

Distribute By:在有些情况下,我们需要控制某个特定行应该到哪个Reducer,通常是为了进行后续的聚集操作。distribute by子句可以做这件事。distribute by类似MapReduce中partition(自定义分区),进行分区,结合sort by使用。

对于distribute by进行测试,一定要分配多reduce进行处理,否则无法看到distribute by的效果。

1)案例实操:

(1)先按照部门编号分区,再按照员工编号薪资排序

hive (default)> set mapreduce.job.reduces=3;

hive (default)>

insert overwrite local directory

'/opt/module/hive/datas/distribute-result'

select

*

from emp

distribute by deptno

sort by sal desc;

注意:

- distribute by的分区规则是根据分区字段的hash码与reduce的个数进行相除后,余数相同的分到一个区。

- Hive要求distribute by语句要写在sort by语句之前。

- 演示完以后mapreduce.job.reduces的值要设置回-1,否则下面分区or分桶表load跑MapReduce的时候会报错。

hive sql执行过程:

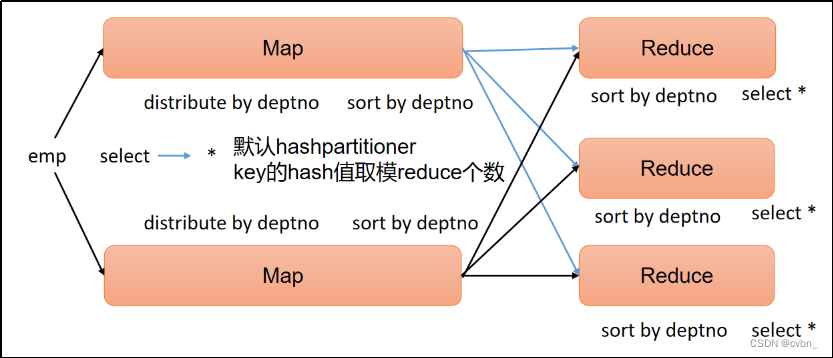

5.5.4 分区排序(Cluster By)

当distribute by和sort by字段相同时,可以使用cluster by方式。

cluster by除了具有distribute by的功能外还兼具sort by的功能。但是排序只能是升序排序,不能指定排序规则为asc或者desc。

(1)以下两种写法等价

hive (default)>

select

*

from emp

cluster by deptno;

hive (default)>

select

*

from emp

distribute by deptno

sort by deptno;

注意:按照部门编号分区,不一定就是固定死的数值,可以是20号和30号部门分到一个分区里面去。

hive sql执行过程:

六、 函数

6.1 函数简介

Hive会将常用的逻辑封装成函数给用户进行使用,类似于Java中的函数。

好处:避免用户反复写逻辑,可以直接拿来使用。

重点:用户需要知道函数叫什么,能做什么。

Hive提供了大量的内置函数,按照其特点可大致分为如下几类:单行函数、聚合函数、炸裂函数、窗口函数。

以下命令可用于查询所有内置函数的相关信息。

1)查看系统内置函数

hive> show functions;

2)查看内置函数用法

hive> desc function upper;

3)查看内置函数详细信息

hive> desc function extended upper;

6.2 单行函数

单行函数的特点是一进一出,即输入一行,输出一行。

单行函数按照功能可分为如下几类:日期函数、字符串函数、集合函数、数学函数、流程控制函数等。

6.2.1 算术运算函数

| 运算符 | 描述 |

|---|---|

| A+B | A和B 相加 |

| A-B | A减去B |

| A*B | A和B 相乘 |

| A/B | A除以B |

| A%B | A对B取余 |

| A&B | A和B按位取与 |

AB | A和B按位取或 |

| A^B | A和B按位取异或 |

| ~A | A按位取反 |

- 案例实操:查询出所有员工的薪水后加1显示。

hive (default)> select sal + 1 from emp;

6.2.2 数值函数

1)round:四舍五入

hive> select round(3.3); 3

2)ceil:向上取整

hive> select ceil(3.1) ; 4

3)floor:向下取整

hive> select floor(4.8); 4

6.2.3 字符串函数

1)substring:截取字符串

语法一:substring(string A, int start)

返回值:string

说明:返回字符串A从start位置到结尾的字符串 语法二:substring(string A, int start, int len)

返回值:string

说明:返回字符串A从start位置开始,长度为len的字符串

案例实操:

(1)获取第二个字符以后的所有字符

hive> select substring("atguigu",2);

输出:

tguigu

(2)获取倒数第三个字符以后的所有字符

hive> select substring("atguigu",-3);

输出:

igu

(3)从第3个字符开始,向后获取2个字符

hive> select substring("atguigu",3,2);

输出:

gu

2)replace :替换

语法:replace(string A, string B, string C)

返回值:string

说明:将字符串A中的子字符串B替换为C。

hive> select replace('atguigu', 'a', 'A')

输出:

hive> Atguigu

3)regexp_replace:正则替换

语法:regexp_replace(string A, string B, string C)

返回值:string

说明:将字符串A中的符合java正则表达式B的部分替换为C。注意,在有些情况下要使用转义字符。

- 案例实操:

hive> select regexp_replace('100-200', '(\\d+)', 'num')

输出:

hive> num-num

4)regexp:正则匹配

语法:字符串 regexp 正则表达式

返回值:boolean

说明:若字符串符合正则表达式,则返回true,否则返回false。

(1)正则匹配成功,输出true

hive> select 'dfsaaaa' regexp 'dfsa+'

输出:

hive> true

(2)正则匹配失败,输出false

hive> select 'dfsaaaa' regexp 'dfsb+';

输出:

hive> false

5)repeat:重复字符串

语法:repeat(string A, int n)

返回值:string

说明:将字符串A重复n遍。

hive> select repeat('123', 3);

输出:

hive> 123123123

6)split :字符串切割

语法:split(string str, string pat)

返回值:array

说明:按照正则表达式pat匹配到的内容分割str,分割后的字符串,以数组的形式返回。

hive> select split('a-b-c-d','-');

输出:

hive> ["a","b","c","d"]

7)nvl :替换null值

语法:nvl(A,B)

说明:若A的值不为null,则返回A,否则返回B。

hive> select nvl(null,1);

输出:

hive> 1

8)concat :拼接字符串

语法:concat(string A, string B, string C, ……)

返回:string

说明:将A,B,C……等字符拼接为一个字符串

hive> select concat('beijing','-','shanghai','-','shenzhen');

输出:

hive> beijing-shanghai-shenzhen

9)concat_ws:以指定分隔符拼接字符串或者字符串数组

语法:concat_ws(string A, string…| array(string))

返回值:string

说明:使用分隔符A拼接多个字符串,或者一个数组的所有元素。

hive>select concat_ws('-','beijing','shanghai','shenzhen');

输出:

hive> beijing-shanghai-shenzhen

hive> select concat_ws('-',array('beijing','shenzhen','shanghai'));

输出:

hive> beijing-shanghai-shenzhen

10)get_json_object:解析json字符串

语法:get_json_object(string json_string, string path)

返回值:string

说明:解析json的字符串json_string,返回path指定的内容。如果输入的json字符串无效,那么返回NULL。

案例实操:

(1)获取json数组里面的json具体数据

hive> select get_json_object('[{"name":"大海海","sex":"男","age":"25"},{"name":"小宋宋","sex":"男","age":"47"}]','$.[0].name');

输出:

hive> 大海海

(2)获取json数组里面的数据

hive> select get_json_object('[{"name":"大海海","sex":"男","age":"25"},{"name":"小宋宋","sex":"男","age":"47"}]','$.[0]');

输出:

hive> {"name":"大海海","sex":"男","age":"25"}

6.2.4 日期函数

1)unix_timestamp:返回当前或指定时间的时间戳

语法:unix_timestamp()

返回值:bigint

案例实操:

hive> select unix_timestamp('2022/08/08 08-08-08','yyyy/MM/dd HH-mm-ss');

输出:

1659946088

说明:-前面是日期后面是指,日期传进来的具体格式

2)from_unixtime:转化UNIX时间戳(从 1970-01-01 00:00:00 UTC 到指定时间的秒数)到当前时区的时间格式

语法:from_unixtime(bigint unixtime[, string format])

返回值:string

案例实操:

hive> select from_unixtime(1659946088);

输出:

2022-08-08 08:08:08

3)current_date:当前日期

hive> select current_date;

输出:

2022-07-11

4)current_timestamp:当前的日期加时间,并且精确的毫秒

hive> select current_timestamp;

输出:

2022-07-11 15:32:22.402

5)month:获取日期中的月

语法:month (string date)

返回值:int

案例实操:

hive> select month('2022-08-08 08:08:08');

输出:

8

6)day:获取日期中的日

语法:day (string date)

返回值:int

案例实操:

hive> select day('2022-08-08 08:08:08')

输出:

8

7)hour:获取日期中的小时

语法:hour (string date)

返回值:int

案例实操:

hive> select hour('2022-08-08 08:08:08');

输出:

8

8)datediff:两个日期相差的天数(结束日期减去开始日期的天数)

语法:datediff(string enddate, string startdate)

返回值:int

案例实操:

hive> select datediff('2021-08-08','2022-10-09');

输出:

-427

9)date_add:日期加天数

语法:date_add(string startdate, int days)

返回值:string

说明:返回开始日期 startdate 增加 days 天后的日期

案例实操:

hive> select date_add('2022-08-08',2);

输出:

2022-08-10

10)date_sub:日期减天数

语法:date_sub (string startdate, int days)

返回值:string

说明:返回开始日期startdate减少days天后的日期。

案例实操:

hive> select date_sub('2022-08-08',2);

输出:

2022-08-06

11)date_format:将标准日期解析成指定格式字符串

hive> select date_format('2022-08-08','yyyy年-MM月-dd日')

输出:

2022年-08月-08日

6.2.5 流程控制函数

1)case when:条件判断函数

语法一:case when a then b [when c then d]* [else e] end

返回值:T

说明:如果a为true,则返回b;如果c为true,则返回d;否则返回 e

hive> select case when 1=2 then 'tom' when 2=2 then 'mary' else 'tim' end from tabl eName;

mary

语法二: case a when b then c [when d then e]* [else f] end

返回值: T

说明:如果a等于b,那么返回c;如果a等于d,那么返回e;否则返回f

hive> select case 100 when 50 then 'tom' when 100 then 'mary' else 'tim' end from t ableName;

mary

2)if: 条件判断,类似于Java中三元运算符

语法:if(boolean testCondition, T valueTrue, T valueFalseOrNull)

返回值:T

说明:当条件testCondition为true时,返回valueTrue;否则返回valueFalseOrNull

(1)条件满足,输出正确

hive> select if(10 > 5,'正确','错误');

输出:正确

(2)条件满足,输出错误

hive> select if(10 < 5,'正确','错误');

输出:错误

6.2.6 集合函数

1)size:集合中元素的个数

hive> select size(friends) from test; --2/2 每一行数据中的friends集合里的个数

2)map:创建map集合

语法:map (key1, value1, key2, value2, …)

说明:根据输入的key和value对构建map类型

- 案例实操:

hive> select map('xiaohai',1,'dahai',2);

输出:

hive> {“xiaohai”:1,“dahai”:2}

3)map_keys: 返回map中的key

hive> select map_keys(map('xiaohai',1,'dahai',2));

输出:

hive>["xiaohai","dahai"]

4)map_values: 返回map中的value

hive> select map_values(map('xiaohai',1,'dahai',2));

输出:

hive>[1,2]

5)array 声明array集合

语法:array(val1, val2, …)

说明:根据输入的参数构建数组array类

- 案例实操:

hive> select array('1','2','3','4');

输出:

hive>["1","2","3","4"]

6)array_contains: 判断array中是否包含某个元素

hive> select array_contains(array('a','b','c','d'),'a');

输出:

hive> true

7)sort_array:将array中的元素排序

hive> select sort_array(array('a','d','c'));

输出:

hive> ["a","c","d"]

8)struct声明struct中的各属性

语法:struct(val1, val2, val3, …)

说明:根据输入的参数构建结构体struct类

- 案例实操:

hive> select struct('name','age','weight');

输出:

hive> {"col1":"name","col2":"age","col3":"weight"}

9)named_struct声明struct的属性和值

hive> select named_struct('name','xiaosong','age',18,'weight',80);

输出:

hive> {"name":"xiaosong","age":18,"weight":80}

6.2.7 案例演示

1. 数据准备

1)表结构

| name | sex | birthday | hiredate | job | salary | bonus | friends | children |

|---|---|---|---|---|---|---|---|---|

| 张无忌 | 男 | 1980/02/12 | 2022/08/09 | 销售 | 3000 | 12000 | [阿朱,小昭] | {张小无:8,张小忌:9} |

| 赵敏 | 女 | 1982/05/18 | 2022/09/10 | 行政 | 9000 | 2000 | [阿三,阿四] | {赵小敏:8} |

| 黄蓉 | 女 | 1982/04/13 | 2022/06/11 | 行政 | 12000 | Null | [东邪,西毒] | {郭芙:5,郭襄:4} |

2)建表语句

hive>

create table employee(

name string, --姓名

sex string, --性别

birthday string, --出生年月

hiredate string, --入职日期

job string, --岗位

salary double, --薪资

bonus double, --奖金

friends array<string>, --朋友

children map<string,int> --孩子

)

3)插入数据

hive> insert into employee

values('张无忌','男','1980/02/12','2022/08/09','销售',3000,12000,array('阿朱','小昭'),map('张小无',8,'张小忌',9)),

('赵敏','女','1982/05/18','2022/09/10','行政',9000,2000,array('阿三','阿四'),map('赵小敏',8)),

('宋青书','男','1981/03/15','2022/04/09','研发',18000,1000,array('王五','赵六'),map('宋小青',7,'宋小书',5)),

('周芷若','女','1981/03/17','2022/04/10','研发',18000,1000,array('王五','赵六'),map('宋小青',7,'宋小书',5)),

('郭靖','男','1985/03/11','2022/07/19','销售',2000,13000,array('南帝','北丐'),map('郭芙',5,'郭襄',4)),

('黄蓉','女','1982/12/13','2022/06/11','行政',12000,null,array('东邪','西毒'),map('郭芙',5,'郭襄',4)),

('杨过','男','1988/01/30','2022/08/13','前台',5000,null,array('郭靖','黄蓉'),map('杨小过',2)),

('小龙女','女','1985/02/12','2022/09/24','前台',6000,null,array('张三','李四'),map('杨小过',2))

2. 需求

1)统计每个月的入职人数

(1)期望结果

| month | cnt |

|---|---|

| 4 | 2 |

| 6 | 1 |

| 7 | 1 |

| 8 | 2 |

| 9 | 2 |

(2)需求实现

select

month(replace(hiredate,'/','-')) as month,

count(*) as cn

from

employee

group by

month(replace(hiredate,'/','-'))

2)查询每个人的年龄(年 + 月)

(1)期望结果

| name | age |

|---|---|

| 张无忌 | 42年8月 |

| 赵敏 | 40年5月 |

| 宋青书 | 41年7月 |

| 周芷若 41年7月 | |

| 郭靖 | 37年7月 |

| 黄蓉 | 39年10月 |

| 杨过 | 34年9月 |

| 小龙女 | 37年8月 |

(2)需求实现

-- 转换日期

select

name,

replace(birthday,'/','-') birthday

from

employee t1

-- 求出年和月

select

name,

year(current_date())-year(t1.birthday) year,

month(current_date())-month(t1.birthday) month

from

(

select

name,

replace(birthday,'/','-') birthday

from

employee

)t1 t2

-- 根据月份正负决定年龄

select

name,

concat(if(month>=0,year,year-1),'年',if(month>=0,month,12+month),'月') age

from

(

select

name,

year(current_date())-year(t1.birthday) year,

month(current_date())-month(t1.birthday) month

from

(

select

name,

replace(birthday,'/','-') birthday

from

employee

)t1

)t2

3)按照薪资,奖金的和进行倒序排序,如果奖金为null,置位0

(1)期望结果

| name | sal |

|---|---|

| 周芷若 | 19000 |

| 宋青书 | 19000 |

| 郭靖 | 15000 |

| 张无忌 | 15000 |

| 黄蓉 | 12000 |

| 赵敏 | 11000 |

| 小龙女 | 6000 |

| 杨过 | 5000 |

(2)需求实现

select

name,

salary + nvl(bonus,0) sal

from

employee

order by

sal desc

4)查询每个人有多少个朋友

(1)期望结果

| name | cnt |

|---|---|

| 张无忌 | 2 |

| 赵敏 | 2 |

| 宋青书 | 2 |

| 周芷若 | 2 |

| 郭靖 | 2 |

| 黄蓉 | 2 |

| 杨过 | 2 |

| 小龙女 | 2 |

(2)需求实现

select

name,

size(friends) cnt

from

employee;

5)查询每个人的孩子的姓名

(1)期望结果

| name | ch_name |

|---|---|

| 张无忌 | [“张小无”,“张小忌”] |

| 赵敏 | [“赵小敏”] |

| 宋青书 | [“宋小青”,“宋小书”] |

| 周芷若 | [“宋小青”,“宋小书”] |

| 郭靖 | [“郭芙”,“郭襄”] |

| 黄蓉 | [“郭芙”,“郭襄”] |

| 杨过 | [“杨小过”] |

| 小龙女 | [“杨小过”] |

(2)需求实现

hive>

select

name,

map_keys(children) ch_name

from

employee;

6)查询每个岗位男女各多少人

(1)期望结果

| job | male | female |

|---|---|---|

| 前台 | 1 | 1 |

| 研发 | 1 | 1 |

| 行政 | 0 | 2 |

| 销售 | 2 | 0 |

(2)需求实现

select

job,

sum(if(sex='男',1,0)) male,

sum(if(sex='女',1,0)) female

from

employee

group by

job

6.3 高级聚合函数

多进一出 (多行传入,一个行输出)。

1)普通聚合为 count/sum… 等

2)collect_list 收集并形成list集合,结果不去重

hive>

select

sex,

collect_list(job)

from

employee

group by

sex

结果:

女 ["行政","研发","行政","前台"]

男 ["销售","研发","销售","前台"]

3)collect_set 收集并形成set集合,结果去重

hive>

select

sex,

collect_set(job)

from

employee

group by

sex

结果:

女 ["行政","研发","前台"]

男 ["销售","研发","前台"]

6.3.1 案例演示

1)每个月的入职人数以及姓名

hive>

select

month(replace(hiredate,'/','-')) as month,

count(*) as cn,

Collect_list(name) as name_list

from

employee

group by

month(replace(hiredate,'/','-'))

结果:

month cn name_list

4 2 ["宋青书","周芷若"]

6 1 ["黄蓉"]

7 1 ["郭靖"]

8 2 ["张无忌","杨过"]

9 2 ["赵敏","小龙女"]

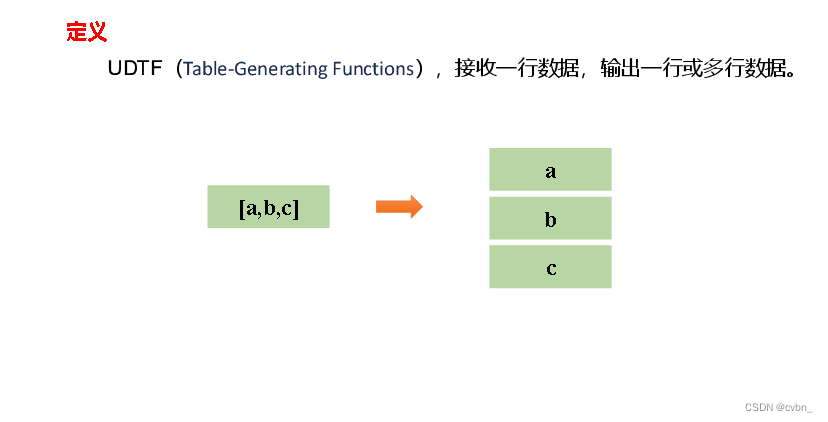

6.4 炸裂函数

6.4.1 概述

6.4.2 案例演示

1.数据准备

1)表结构

| movie | category |

|---|---|

| 《疑犯追踪》 | 悬疑,动作,科幻,剧情 |

| 《Lie to me》 | 悬疑,警匪,动作,心理,剧情 |

| 《战狼2》 | 战争,动作,灾难 |

2)建表语句

hive (default)>

create table movie_info(

movie string, --电影名称

category string --电影分类

)

row format delimited fields terminated by "\t";

3)装载语句

insert overwrite table movie_info

values ("《疑犯追踪》", "悬疑,动作,科幻,剧情"),

("《Lie to me》", "悬疑,警匪,动作,心理,剧情"),

("《战狼2》", "战争,动作,灾难");

2. 需求

1)需求说明

根据上述电影信息表,统计各分类的电影数量,期望结果如下:

| 剧情 | 2 |

|---|---|

| 动作 | 3 |

| 心理 | 1 |

| 悬疑 | 2 |

| 战争 | 1 |

| 灾难 | 1 |

| 科幻 | 1 |

| 警匪 | 1 |

2)答案

select

cate,

count(*)

from

(

select

movie,

cate

from

(

select

movie,

split(category,',') cates

from movie_info

)t1 lateral view explode(cates) tmp as cate

)t2

group by cate;

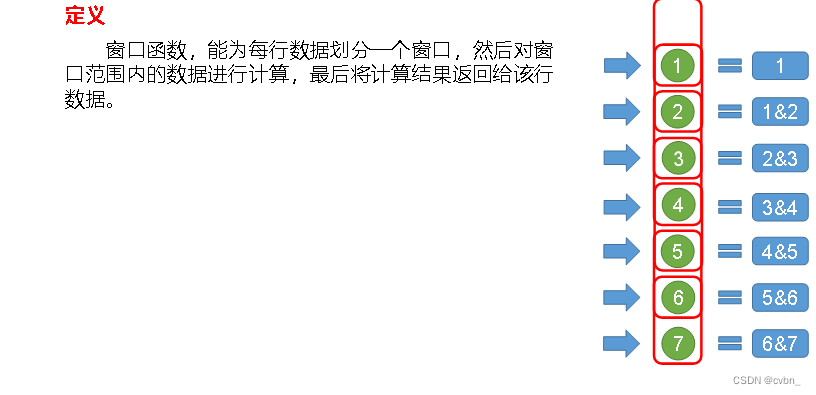

6.5 窗口函数(开窗函数)

6.5.1 概述

6.5.2 常用窗口函数

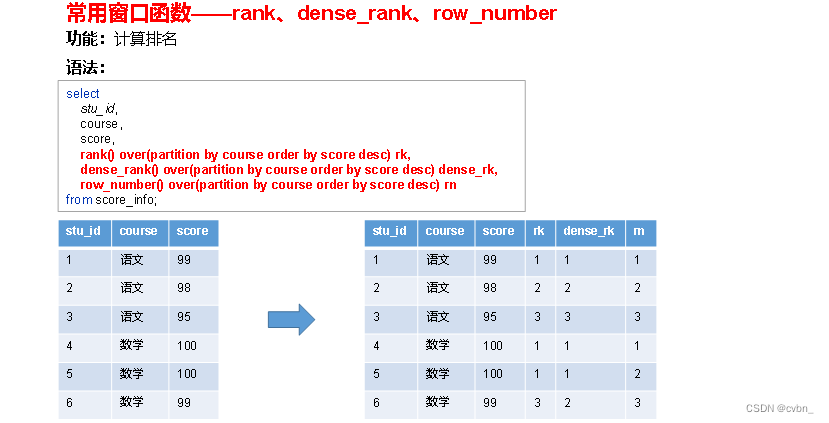

按照功能,常用窗口可划分为如下几类:聚合函数、跨行取值函数、排名函数。

1)聚合函数

max:最大值。

min:最小值。

sum:求和。

avg:平均值。

count:计数。

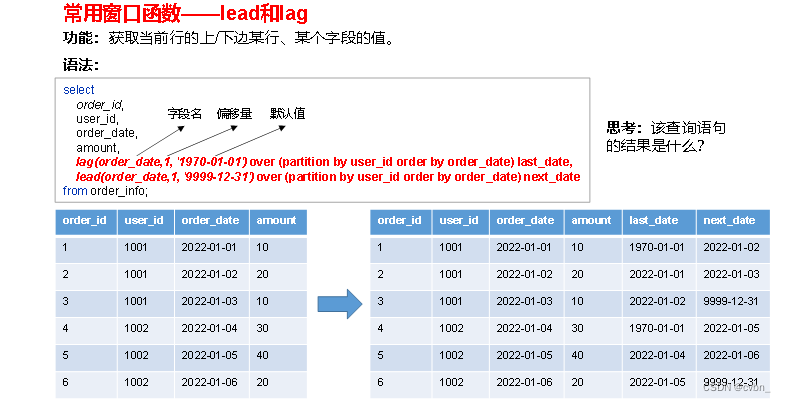

2)跨行取值函数

(1)lead和lag

注:lag和lead函数不支持自定义窗口。

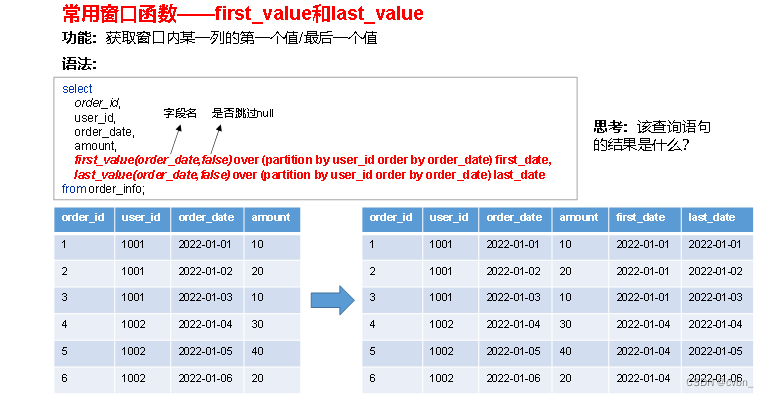

(2)first_value和last_value

3)排名函数

注:rank 、dense_rank、row_number不支持自定义窗口。

6.5.3 案例演示

1.数据准备

1)表结构

| order_id | user_id | user_name | order_date | order_amount |

|---|---|---|---|---|

| 1 | 1001 | 小元 | 2022-01-01 | 10 |

| 2 | 1002 | 小海 | 2022-01-02 | 15 |

| 3 | 1001 | 小元 | 2022-02-03 | 23 |

| 4 | 1002 | 小海 | 2022-01-04 | 29 |

| 5 | 1001 | 小元 | 2022-01-05 | 46 |

2)建表语句

create table order_info

(

order_id string, --订单id

user_id string, -- 用户id

user_name string, -- 用户姓名

order_date string, -- 下单日期

order_amount int -- 订单金额

);

3)装载语句

insert overwrite table order_info

values ('1', '1001', '小元', '2022-01-01', '10'),

('2', '1002', '小海', '2022-01-02', '15'),

('3', '1001', '小元', '2022-02-03', '23'),

('4', '1002', '小海', '2022-01-04', '29'),

('5', '1001', '小元', '2022-01-05', '46'),

('6', '1001', '小元', '2022-04-06', '42'),

('7', '1002', '小海', '2022-01-07', '50'),

('8', '1001', '小元', '2022-01-08', '50'),

('9', '1003', '小辉', '2022-04-08', '62'),

('10', '1003', '小辉', '2022-04-09', '62'),

('11', '1004', '小猛', '2022-05-10', '12'),

('12', '1003', '小辉', '2022-04-11', '75'),

('13', '1004', '小猛', '2022-06-12', '80'),

('14', '1003', '小辉', '2022-04-13', '94');

2. 需求

1)统计每个用户截至每次下单的累积下单总额

(1)期望结果

| order_id | user_id | user_name | order_date | order_amount | sum_so_far |

|---|---|---|---|---|---|

| 1 | 1001 | 小元 | 2022-01-01 | 10 | 10 |

| 5 | 1001 | 小元 | 2022-01-05 | 46 | 56 |

| 8 | 1001 | 小元 | 2022-01-08 | 50 | 106 |

| 3 | 1001 | 小元 | 2022-02-03 | 23 | 129 |

| 6 | 1001 | 小元 | 2022-04-06 | 42 | 171 |

| 2 | 1002 | 小海 | 2022-01-02 | 15 | 15 |

| 4 | 1002 | 小海 | 2022-01-04 | 29 | 44 |

| 7 | 1002 | 小海 | 2022-01-07 | 50 | 94 |

| 9 | 1003 | 小辉 | 2022-04-08 | 62 | 62 |

| 10 | 1003 | 小辉 | 2022-04-09 | 62 | 124 |

| 12 | 1003 | 小辉 | 2022-04-11 | 75 | 199 |

| 14 | 1003 | 小辉 | 2022-04-13 | 94 | 293 |

| 11 | 1004 | 小猛 | 2022-05-10 | 12 | 12 |

| 13 | 1004 | 小猛 | 2022-06-12 | 80 | 92 |

(2)需求实现

select

order_id,

user_id,

user_name,

order_date,

order_amount,

sum(order_amount) over(partition by user_id order by order_date rows between unbounded preceding and current row) sum_so_far

from order_info;

2)统计每个用户截至每次下单的当月累积下单总额

- 需求实现

select

order_id,

user_id,

user_name,

order_date,

order_amount,

sum(order_amount) over(partition by user_id,substring(order_date,1,7) order by order_date rows between unbounded preceding and current row) sum_so_far

from order_info;

3)统计每个用户每次下单距离上次下单相隔的天数(首次下单按0天算)

- 需求实现

select

order_id,

user_id,

user_name,

order_date,

order_amount,

nvl(datediff(order_date,last_order_date),0) diff

from

(

select

order_id,

user_id,

user_name,

order_date,

order_amount,

lag(order_date,1,null) over(partition by user_id order by order_date) last_order_date

from order_info

)t1

4)查询所有下单记录以及每个用户的每个下单记录所在月份的首/末次下单日期

- 需求实现

select

order_id,

user_id,

user_name,

order_date,

order_amount,

first_value(order_date) over(partition by user_id,substring(order_date,1,7) order by order_date) first_date,

last_value(order_date) over(partition by user_id,substring(order_date,1,7) order by order_date rows between unbounded preceding and unbounded following) last_date

from order_info;

5)为每个用户的所有下单记录按照订单金额进行排名

- 需求实现

select

order_id,

user_id,

user_name,

order_date,

order_amount,

rank() over(partition by user_id order by order_amount desc) rk,

dense_rank() over(partition by user_id order by order_amount desc) drk,

row_number() over(partition by user_id order by order_amount desc) rn

from order_info;

699

699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?