Spark

快如闪电的集群计算

是快速和通用的大规模数据处理技术

【speed】

执行mr作业程序在内存比hadoop快100倍,磁盘上快10倍

spark有着DAG(有向无环图)执行引擎,支持离散数据流和内存计算

【易于使用】

多种语言编写

Java scala python R

【Generality】

合成SQL,流计算,复杂分析

spark有自己的集群计算技术,扩展了hadoop mr模型用于高效计算,包括交互式查询和流计算。主要的特性就是内存的集群计算提升计算速度。

Spark部署三种模式

1.standalone,独立模式

在HDFS之上分配空间,spark和mr同时运行,覆盖到所有job

2.hadoop yarn(hadoop v2)

在yarn上运行,不需要预先安装或者要求root访问。

有助于spark和hadoop生态系统进行集成(hadoop 栈)也允许其他组件在stack之上运行。

3.spark in mapreduce (hadoop v1.x)

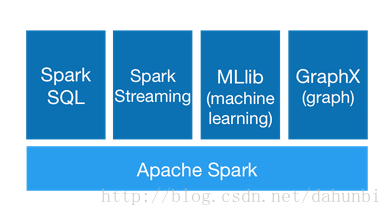

Spark 组件:如图

1. Spark core (内核)

内核位于执行引擎之上,所有功能都在其上进行构建,提供内存计算以及外部存储系统的数据集引用

2.Spark SQL

在core之上引入的一个新的数据集抽象(SchemaRDD),支持结构和半结构的数据

3. Spark Steaming

平衡Spark内核的快速调度功能执行流分析

4. MLLib

Machine Learning 的 lib比基于磁盘技术的机器学习框架mahout快9倍

5. GraphX

Spark之上的分布式土处理框架,提供了运行时运行优化的抽象API

源代码spark的编译与部署

http://spark.apache.org/docs/latest/building-spark.html

通过spark源代码使用maven进行编译安装

1. 下载spark源代码

2. 使用maven命令

a) 启动maven本地仓库服务器

b) 使用maven编译时,需要扩大相应内存区的大小,否则出现内存溢出,编译失败。

c) 使用命令进行编译

Build/mvn

时间几个小时以上

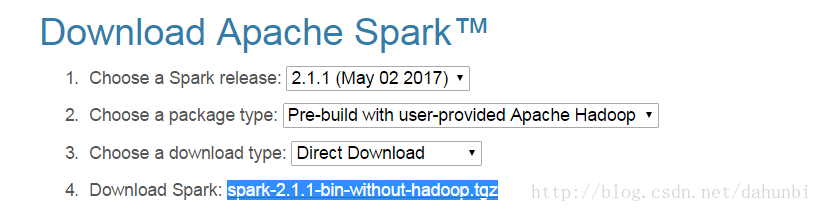

另一种方法: hadoop-free build,更快

使用spark-2.1.1-bin-without-hadoop.tgz,配置spark的环境变量

a) 下载spark-2.1.1-bin-without-hadoop.tgz

b) tar

c) Mv

d) ln

e) 配置环境变量http://spark.apache.org/docs/latest/hadoop-provided.html

f) 配置linux环境变量 SPARK_HOME, PATH

g) 即可生效:source /etc/environment

h) 启动spark-shell

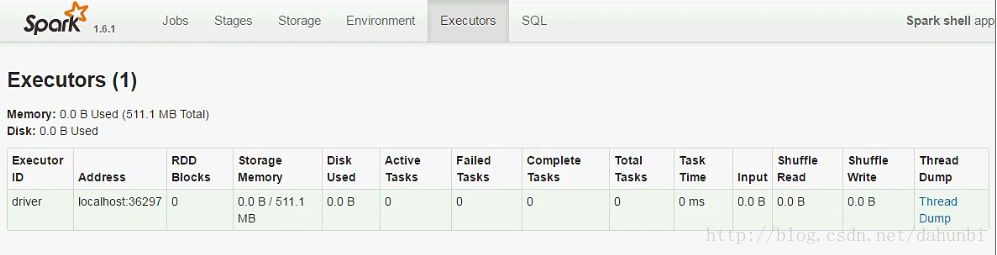

$>spark-shell 进入scala,

在打印出的信息中,可以看到一行:

浏览器中打开Spark UI地址,可看到

435

435

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?