前言

Ollama 是一个开源工具,旨在简化大型语言模型(LLM)在本地环境中的部署和管理。它通过类 Docker 的操作方式,支持用户快速下载、运行和定制多种开源模型,如 Llama 2、DeepSeek、Mistral 等,同时提供 API 接口和丰富的社区支持。

Ollama 允许用户在本地计算机上运行模型,无需依赖云端服务,确保数据隐私和安全18。例如,通过命令 ollama run llama2 即可启动 Llama 2 模型。

Ollama 现在作为本机 Windows 应用程序运行,包括 NVIDIA 和 AMD Radeon GPU 支持。 安装 Ollama for Windows 后,Ollama 将在后台运行,并且 命令行位于 中,或者您的收藏夹 终端应用程序。像往常一样,Ollama api 将在 .ollamacmdpowershellhttp://localhost:11434

一.安装Ollama

下载:Ollama下载地址 :https://ollama.com/download

点击download,选择自己想要下载的系统,这里我选择windows系统

点击"Install",安装Ollama

Ollama安装好后没有提示,需要自己打开一个终端窗口,输入指令“Ollama”

出现这个界面就说明安装成功

二.更改安装位置

如果要将 Ollama 应用程序安装在主目录以外的位置,就请使用以下标志启动安装程序 打开“Docs”,进入Ollama的Windows文档,我们可以查询到一条指令更改存储位置ollama/docs/windows.md at main · ollama/ollama (github.com)

打开“Docs”,进入Ollama的Windows文档,我们可以查询到一条指令更改存储位置ollama/docs/windows.md at main · ollama/ollama (github.com)

OllamaSetup.exe /DIR="d:\some\location"

更改模型位置

要更改 Ollama 存储下载模型的位置而不是使用您的主目录,请在您的用户帐户中设置环境变量。OLLAMA_MODELS

-

启动设置 (Windows 11) 或控制面板 (Windows 10) 应用程序并搜索环境变量。

-

单击 Edit environment variables(编辑您账户的环境变量)。

-

为您的用户帐户编辑或创建新变量,以用于存储模型的位置

OLLAMA_MODELS -

单击 确定/应用 保存。

如果 Ollama 已在运行,请退出托盘应用程序并从 Start 菜单重新启动它,或者在保存环境变量后启动新终端。

打开存放OllamaSetup.exe的路径,打开终端,将后面的路径改为D盘存放的路径

后面,会重新弹出一个下载界面

点击“Install”,下载

打开D盘位置的Ollama,就可以看到相关文件都转移过来了

三、安装大模型

1.修改环境变量,安装大模型到D盘(默认是C盘)。Win+i进入设置,搜索【查看高级系统设置】,进入【环境变量】

环境配置完成,我们回到Ollama官网

点击“Models”,这里有大量的语言模型,比如近期大火的deepseek-r1模型、llama3.3

点击自己想要下载的大语言模型,这里我下载的是“deepseek-r1” 大家根据电脑配置自行下载

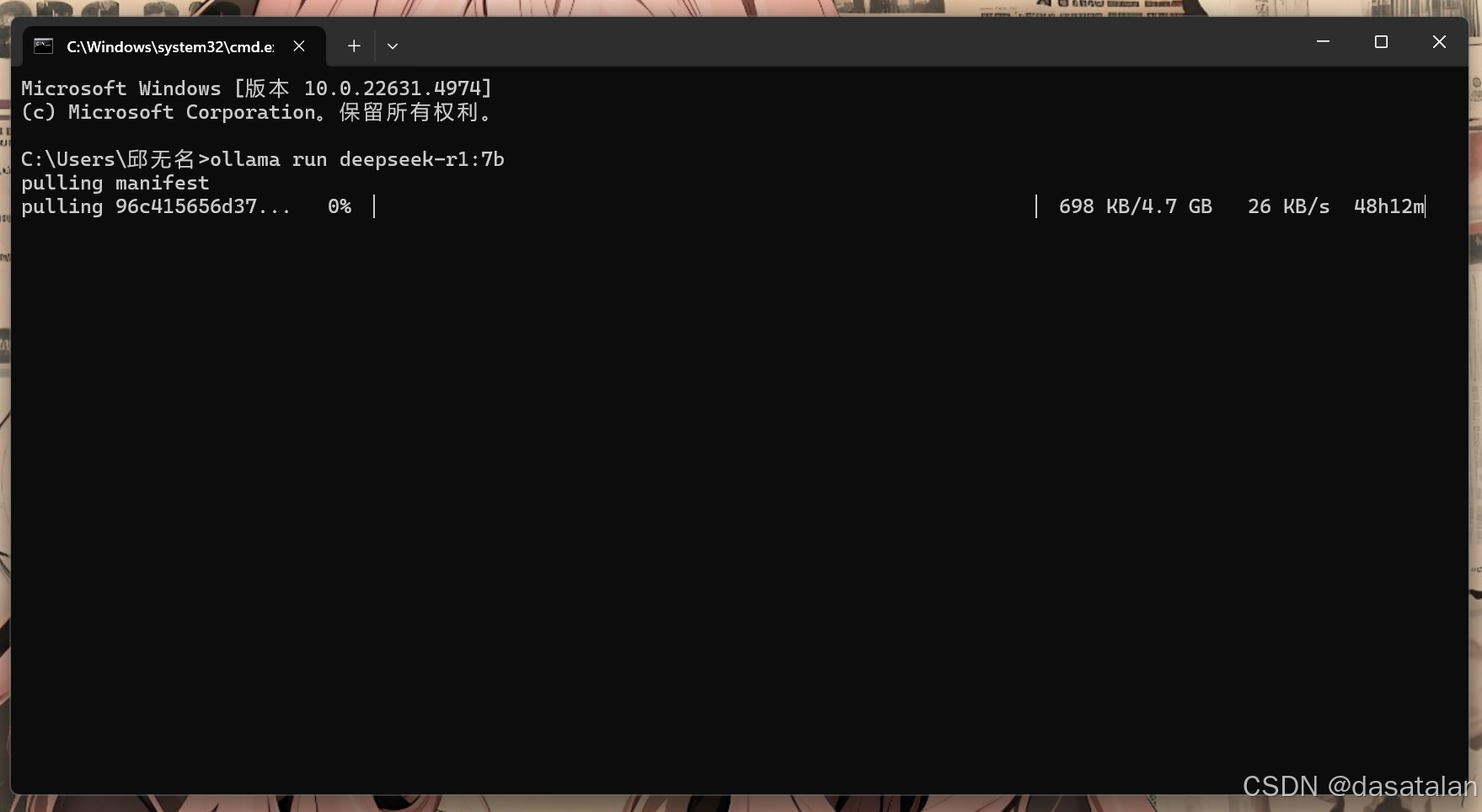

大家根据电脑配置自行下载 这里,我们打开一个终端窗口,输入指令

这里,我们打开一个终端窗口,输入指令

ollama run deepseek-r1:7b

下载模型

下载好后,输入指令查看下载的模型

Ollama list然后,输入指令Ollama run + 模型,运行模型

Ollama run deepseek-r1:7b

到这里就结束了,希望对大家的学习有所帮助!!!

600

600

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?