Deep Cauchy Hashing for Hamming Space Retrieva 阅读笔记

(2018年,由清华大学软件学院曹越,龙明盛教授著)

背景:

由于其计算效率和检索质量,散列已被广泛应用于近似最近邻搜索的大规模图像检索,而深度散列通过端到端表示学习和散列编码进一步提高了检索质量。通过紧凑的哈希码,汉明空间检索能够实现最有效的恒定时间搜索,通过哈希表查找而不是线性扫描,将给定汉明半径内的数据点返回到每个查询。

问题:

由于错误指定的损失函数,且将相关图像集中在小的汉明球内的能力弱,所以现有的深度哈希方法对于汉明空间检索可能表现不佳。

方法:

项工作提出了Deep Cauchy Hashing(DCH),这是一种新颖的深度哈希模型,可生成紧凑且集中的二进制哈希码,以实现高效和有效的汉明空间检索。主要思想是基于Cauchy分布设计成对的交叉熵损失,其在汉明距离大于给定汉明半径阈值的类似图像对上显着地惩罚。我们进一步提出了基于Cauchy分布的量化损失,这使得能够学习几乎无损的哈希码。两个损失函数都可以在贝叶斯学习框架中导出,并且对汉明空间检索有明确的说明。建议的DCH模型可以通过反向传播进行端到端训练。

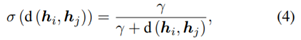

提出了一种基于Cauchy分布的新概率函数:

MAP:

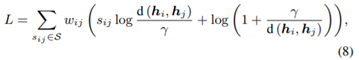

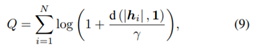

Cauchy cross-entropy loss (L)和Cauchy quantization loss (Q)

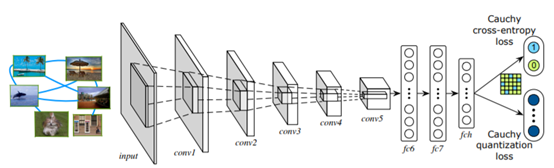

AlexNet网络架构,贝叶斯框架。

1.学习每个图像xi的卷积网络CNN

2. fully-connected hash layer(fch)将特征变换成k-bit hash code

3. Cauchy cross-entropy loss;(汉明空间中相似性保持学习)

4.Cauchy quantization loss;(控制二值化误差和汉明空间的散列质量)

5.本文中是在fc7后面接了一个fch层,通过h(x)=sgn(x)量化特征,但是在实际优化过程中,sgn函数的梯度不可定义,因此先用Tanh(双曲正切)函数将特征数值压缩到[-1,1]区间,再做后续处理。

实验

实验结果明显优越于基于hashing的其他方法。

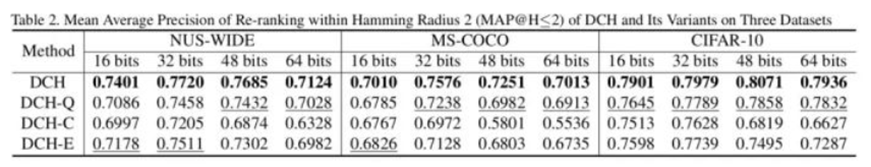

实验部分作者在NUS-WIDE,MS-COCO,CIFAR-10 三个图像数据集上做了验证,直接看图

作者设置了对比实验,验证了Cauchy Cross-Entropy Loss与Cauchy Quantization Loss的重要性

DCH-Q是不是用新的cauchy量化损失

DCH-C是s型交叉熵损失代替cauchy交叉熵损失

DCH-E是将d(hi,hj)替换

本文核心一句话总结,考虑一个急剧变化的分布(通常更具判别能力),用cauchy分布代替logistic 分布。

842

842

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?