🎁个人主页:我们的五年

🔍系列专栏:Linux网络编程

🌷追光的人,终会万丈光芒

🎉欢迎大家点赞👍评论📝收藏⭐文章

前言:

2025年02月21日 14:23,蓝耘科技股份有限公司公布,蓝耘元生代推理引擎现已上线满血版 DeepSeek R1/V3,支持在线体验&API调用,采用按token计费、按小时整点结算模式,还可享500万不限时的免费tokens!

目录

蓝耘科技股份有限公司的介绍

蓝耘科技集团股份有限公司专注于GPU算力云服务

企业概况

蓝耘科技集团股份有限公司成立于2004年,总部位于北京,在上海、广州、厦门等地设有分子

司,于2017年挂牌新三板,是一家专注于提供GPU算力解决方案与算力云服务的科技公司。

公司拥有一支专业的技术团队,从IT基础架构建设到云计算,从实施到售后,均有丰富的经验。公

司为国家高新技术企业、中关村高新技术企业、国家级专精特新“小巨人”企业称号。

发展至今,蓝耘已经形成了以GPU算力解决方案为基础,GPU算力云服务为核心的业务版图,依

托多年实践积累的技术经验,为相关高校、科研院所、企事业单位等有高性能计算需求的客户,提

供随时随地可获取的低成本高质量的GPU算力云服务,满足客户业务应用和GPU算力随需扩展的

双重需求。

DeepSeek R1/V3满血版:性能与功能的突破

DeepSeek R1和V3满血版在性能和功能上实现了重大突破,为用户带来了更高效、更智能的AI体验。

模型性能升级

推理效率提升:在千亿参数规模下,单机推理速度提升40%,响应延迟低至300ms以内。

多模态能力扩展:支持图像描述生成、音视频摘要(最长支持2小时内容压缩至5分钟精炼文本)

2025年Q2将开放跨模态问答功能。

全场景适配

云端API调用:提供OpenAI兼容接口,支持Python、Node.js、Java、CURL等多种语言。

混合部署方案:结合蓝耘智算云平台,可本地化部署模型,满足数据隐私敏感型企业需求。

成本控制革新

动态资源调度:根据请求量自动扩缩容,空闲时段资源释放率高达90%,较传统GPU租赁方案节

省60%成本。

免费资源池:新用户赠送500万Tokens(永久有效),足够完成约10万次常规问答交互。

from openai import OpenAI

# 构造 client

client = OpenAI(

api_key="sk-xxxxxxxxxxxxxx", # 替换为你的 API Key

base_url="https://maas-api.lanyun.net/v1",

)

# 流式响应

stream = True

# 发送请求

chat_completion = client.chat.completions.create(

model="/maas/deepseek-ai/DeepSeek-R1",

messages=[

{

"role": "user",

"content": "你是谁",

}

],

stream=stream,

)

if stream:

for chunk in chat_completion:

# 打印思维链内容

if hasattr(chunk.choices[0].delta, 'reasoning_content'):

print(f"{chunk.choices[0].delta.reasoning_content}", end="")

# 打印模型最终返回的内容

if hasattr(chunk.choices[0].delta, 'content'):

if chunk.choices[0].delta.content is not None and len(chunk.choices[0].delta.content) != 0:

print(chunk.choices[0].delta.content, end="")

else:

result = chat_completion.choices[0].message.content

print(result)快速上手使用

官网链接:

https://maas.lanyun.net

首先进入登录蓝耘元生代智算云平台。

在这里就可以输入问题,就能马上得到回复。

1.根据需要,使用API KEY调用对应接口,即可开始使用。

2. 使用后,可进入“资源包管理”,选择接口查看使用情况。

OpenAI兼容接口

以下是基于OpenAI兼容接口的代码示例,适用于不同编程语言,帮助开发者快速接入和使用相关服务:

Python 示例

import openai

# 设置API密钥和基础URL(根据实际服务提供商修改)

openai.api_key = "YOUR_API_KEY"

openai.api_base = "https://api.example.com/v1" # 替换为实际的API基础URL[^51^]

# 调用接口生成文本

response = openai.ChatCompletion.create(

model="model_name", # 替换为实际模型名称,如 "deepseek-r1"

messages=[

{"role": "user", "content": "请介绍一下人工智能的发展历程"}

],

max_tokens=500

)

print(response.choices[0].message.content)JavaScript 示例

import OpenAI from "openai";

const openai = new OpenAI({

apiKey: "YOUR_API_KEY",

baseURL: "https://api.example.com/v1" // 替换为实际的API基础URL[^52^]

});

const completion = await openai.chat.completions.create({

model: "model_name", // 替换为实际模型名称

messages: [

{ role: "user", content: "请介绍一下人工智能的发展历程" }

],

max_tokens: 500

});

console.log(completion.choices[0].message.content);使用 curl 的示例

curl https://api.example.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "model_name", # 替换为实际模型名称

"messages": [

{ "role": "user", "content": "请介绍一下人工智能的发展历程" }

],

"max_tokens": 500

}'[^52^]Go 示例

package main

import (

"bytes"

"encoding/json"

"fmt"

"io/ioutil"

"net/http"

"os"

)

const OPENAI_API_URL = "https://api.example.com/v1/chat/completions" // 替换为实际的API基础URL[^54^]

func main() {

apiKey := os.Getenv("OPENAI_API_KEY")

requestBody, err := json.Marshal(map[string]interface{}{

"model": "model_name", // 替换为实际模型名称

"messages": []map[string]string{

{"role": "user", "content": "请介绍一下人工智能的发展历程"},

},

})

if err != nil {

panic(err)

}

req, err := http.NewRequest("POST", OPENAI_API_URL, bytes.NewBuffer(requestBody))

if err != nil {

panic(err)

}

req.Header.Set("Authorization", "Bearer "+apiKey)

req.Header.Set("Content-Type", "application/json")

client := &http.Client{}

resp, err := client.Do(req)

if err != nil {

panic(err)

}

defer resp.Body.Close()

body, err := ioutil.ReadAll(resp.Body)

if err != nil {

panic(err)

}

fmt.Println("Response from API:")

fmt.Println(string(body))

}注意事项

-

API Key:请确保使用正确的API密钥,通常在服务提供商的控制台中获取。

-

基础URL:根据实际服务提供商的API文档,替换为正确的基础URL。

-

模型名称:根据实际支持的模型名称进行替换,例如

deepseek-r1或其他模型。

与chatbox工具搭配使用

-

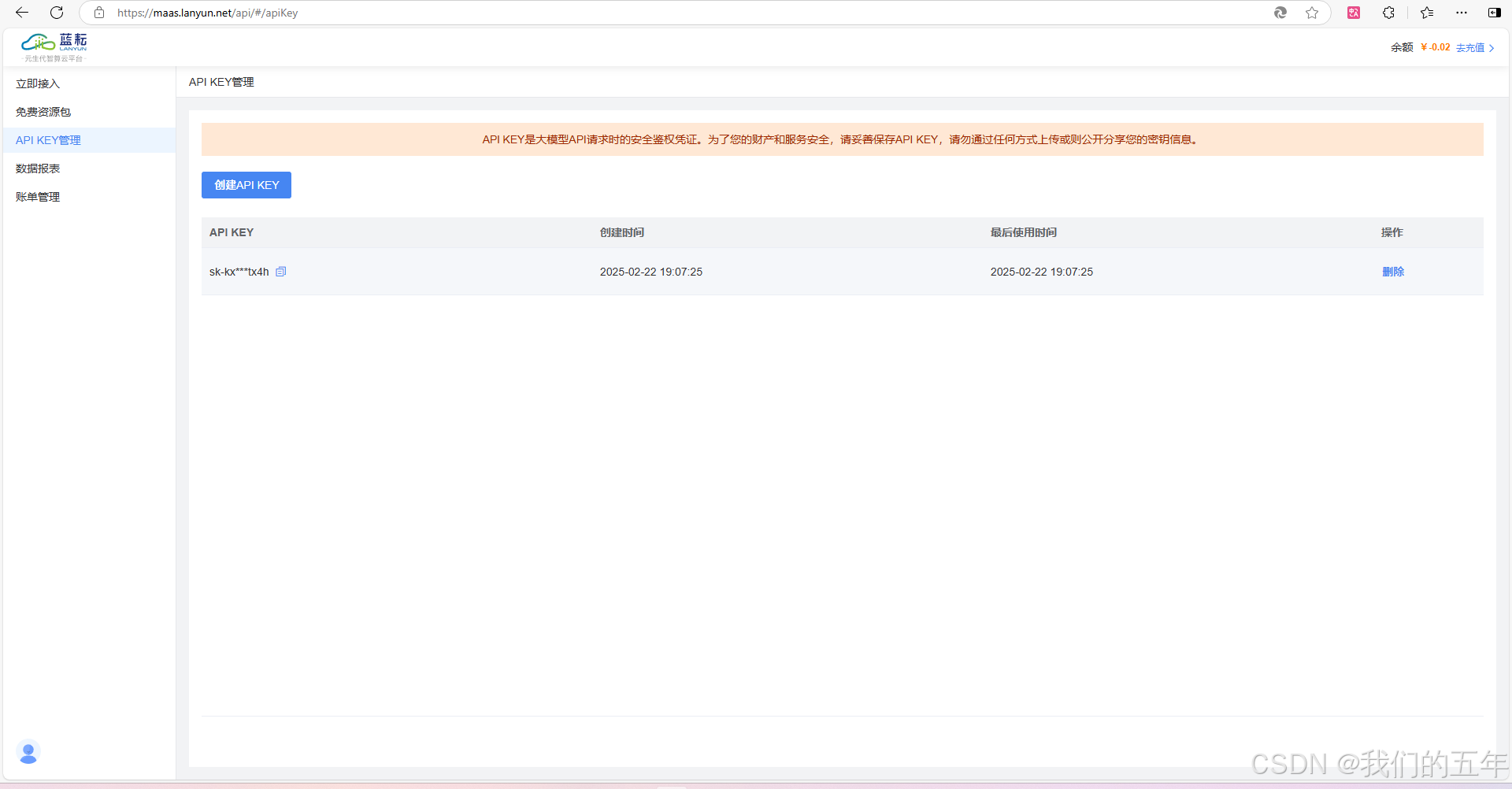

获取API KEY:从API KEY管理中复制密钥

-

下载Chatbox:访问官网 https://chatboxai.app/zh 获取各平台版本(支持Windows/Mac/iOS/Android/Web)

-

配置Chatbox:以Windows版本为例进行操作

-

启动设置:打开Chatbox应用,进入设置界面

总结:

在当今数字化浪潮中,人工智能已成为推动各行业变革的核心力量。而蓝耘科技,作为国内领先的GPU算力云服务提供商,凭借其强大的技术实力和创新精神,正成为AI时代的中流砥柱。

蓝耘科技深耕行业近20年,专注于为AI训练、推理、视觉特效、科研等计算密集型场景提供弹性、高效的GPU算力支持。其自研的“元生代”智算云平台,不仅集成了先进的Kubernetes架构,还实现了大规模GPU任务调度与自动化运维,为企业和开发者提供了前所未有的便利与高效。

2025年,蓝耘科技再次引领行业潮流,正式上线DeepSeek R1和V3满血版。这一全新升级的模型不仅在推理效率上实现了质的飞跃,更在多模态能力上进行了深度拓展,支持图像描述生成、音视频摘要等多种功能。同时,蓝耘科技还为每位新用户提供了500万不限时的免费Tokens,助力开发者快速上手,开启AI应用开发的新篇章。

蓝耘科技的DeepSeek R1/V3满血版,不仅支持网页版和API调用,更提供了零代码智能应用搭建、企业级API服务、高阶参数配置、模型精调实验室、资源监控体系以及生态工具集成等六大核心功能。无论是科研论文辅助写作,还是跨境电商智能运营,DeepSeek都能为用户提供高效、智能的解决方案。

选择蓝耘科技,就是选择未来。我们强烈推荐蓝耘科技及其DeepSeek R1/V3满血版,为您的企业或项目提供强大的AI算力支持。让我们携手蓝耘科技,共同开启智能算力的新时代!

蓝耘元生代智算云:https://cloud.lanyun.net//#/registerPage?promoterCode=0131

3819

3819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?