离线用户召回集与排序计算

3.1 用户画像计算更新

学习目标

- 目标

- 知道用户画像建立的流程

- 应用

- 无

3.1.1 为什么要进行用户画像

要做精准推送同样可以使用多种推荐算法,例如:基于用户协同推荐、基于内容协同的推荐等其他的推荐方式,但是以上方式多是基于相似进行推荐。而构建用户画像,不仅可以满足根据分析用户进行推荐,更可以运用在全APP所有功能上。

建立用户画像确实是一个一劳多得的事情,不仅可以运用于精准推送、精准推荐、精准营销,更可以作为网站的用户属性分析,用户行为分析,商业化转化分析等。同时网站共用一套用户画像,可以对用户有统一的认知。

3.1.2 用户画像计算设计

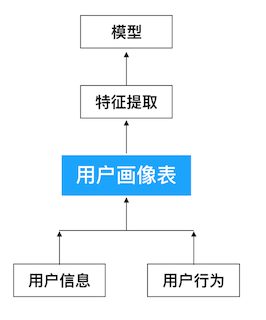

3.1.2.1 用户画像流程

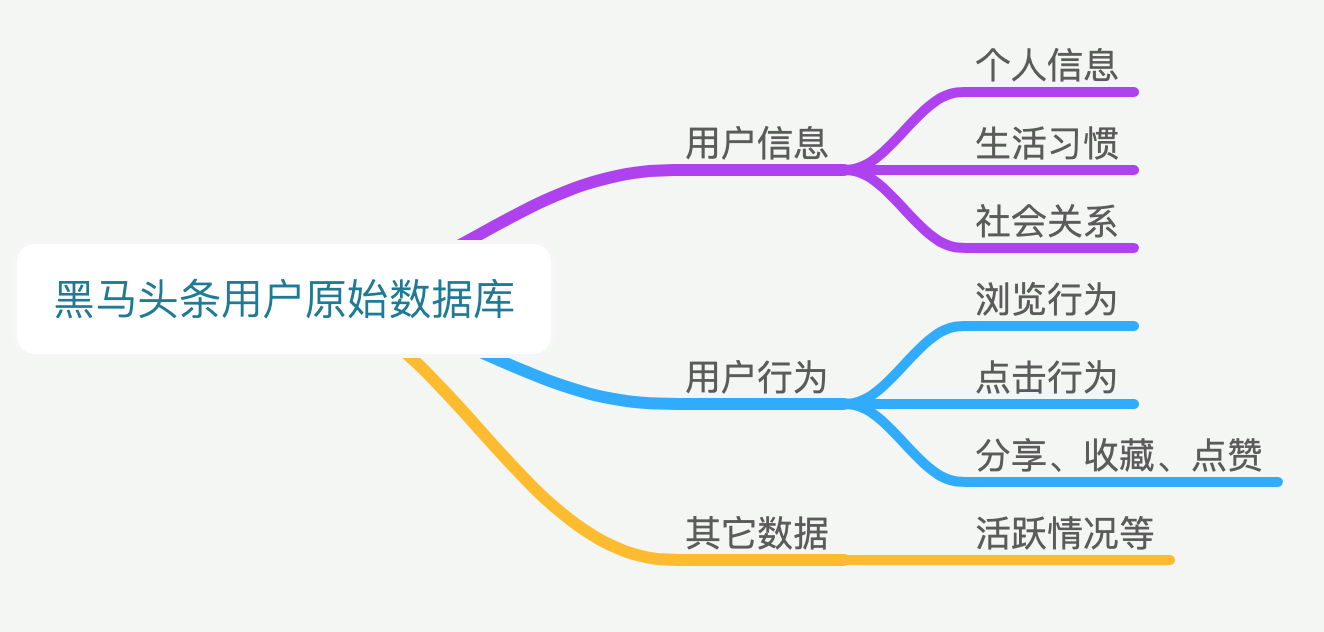

用户画像的第一层主要是原始数据库,此数据库主要囊括后续分析所需要的所有原始数据。也是通过大量数据的分析和处理,后面能提炼成用户的画像得以运用。

- 头条画像原始数据

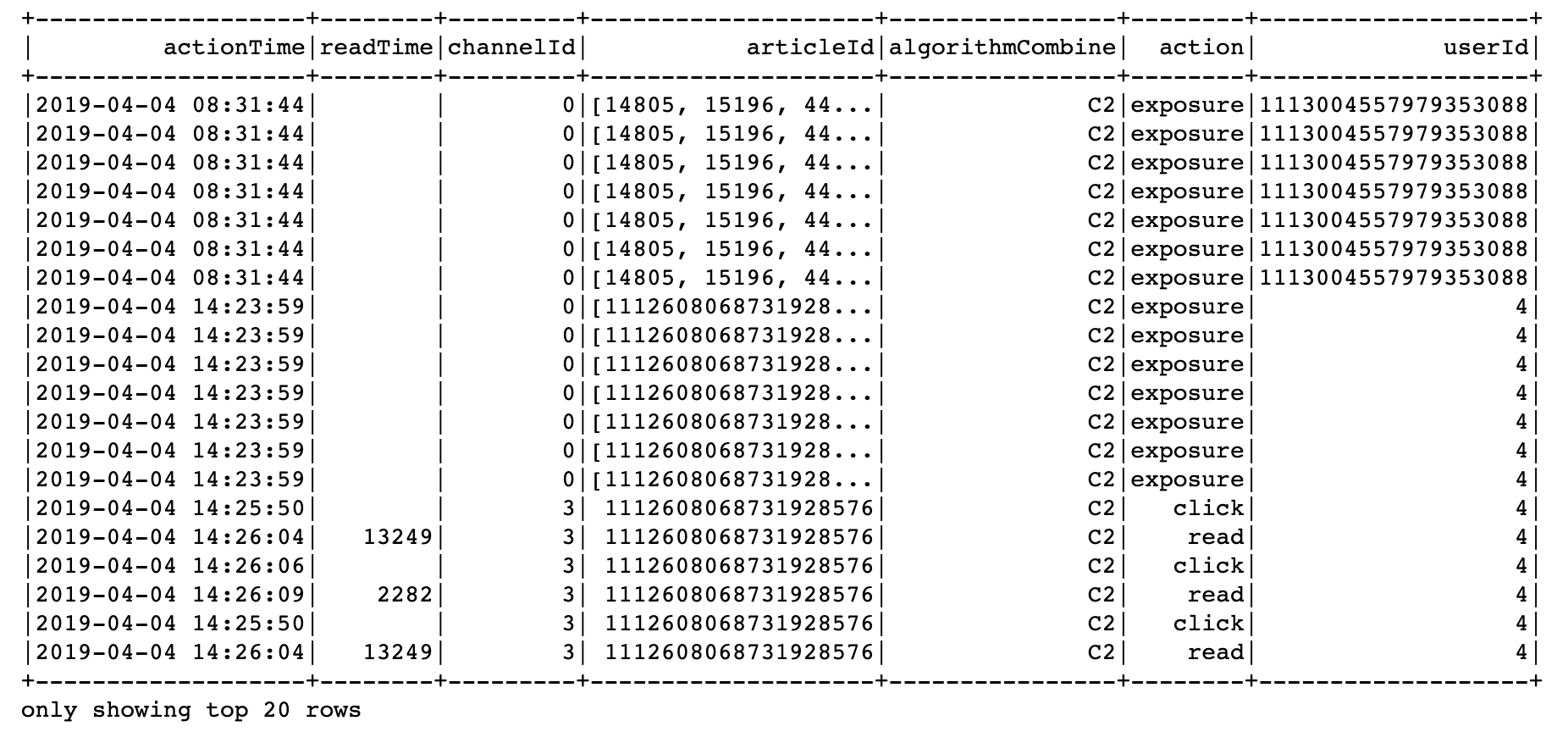

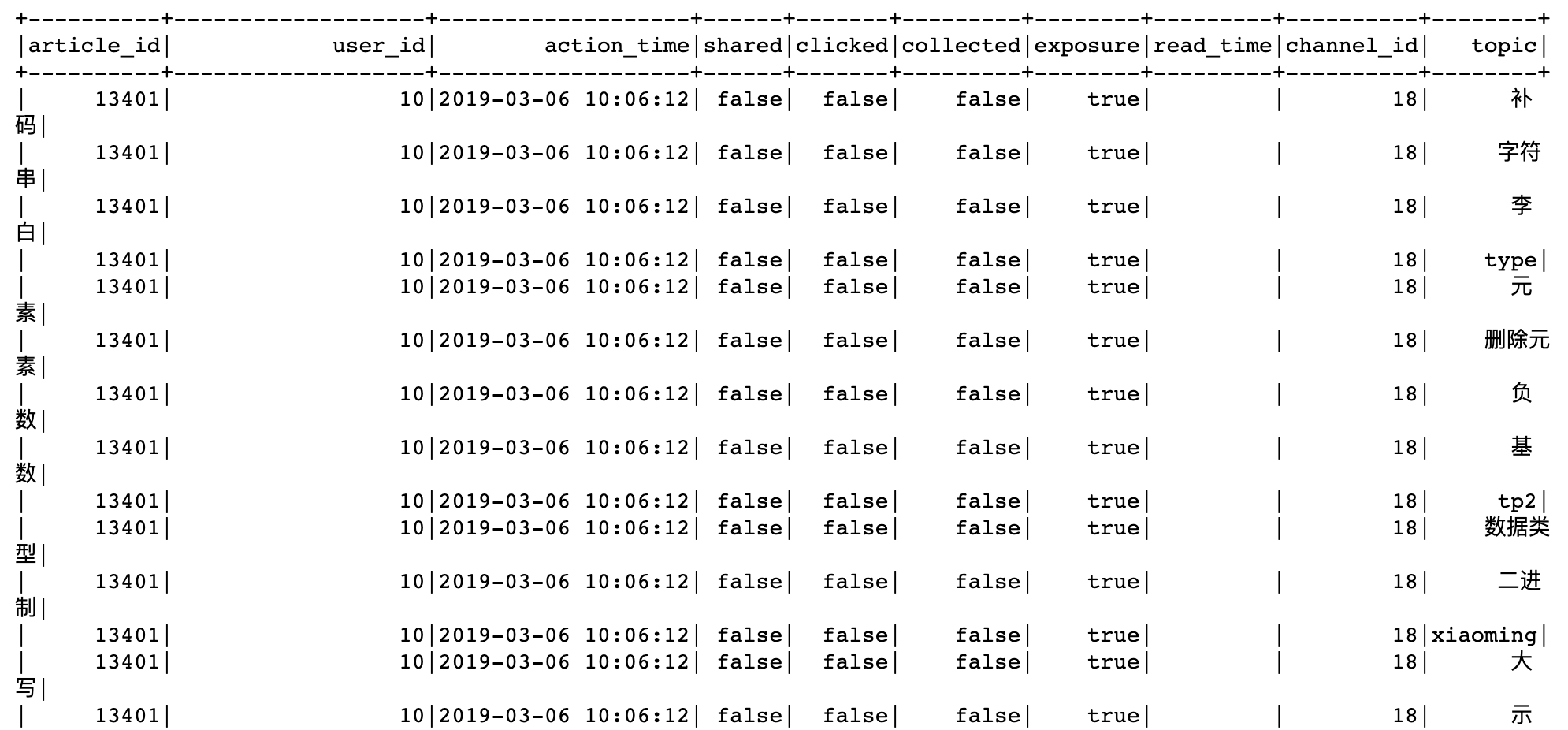

如数据库查询结果

hive> select * from user_action limit 1;

OK

2019-03-05 10:19:40 0 {"action":"exposure","userId":"2","articleId":"[16000, 44371, 16421, 16181, 17454]","algorithmCombine":"C2"} 2019-03-05

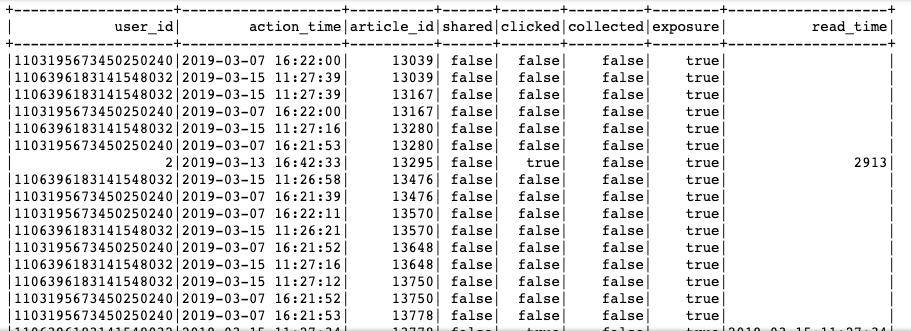

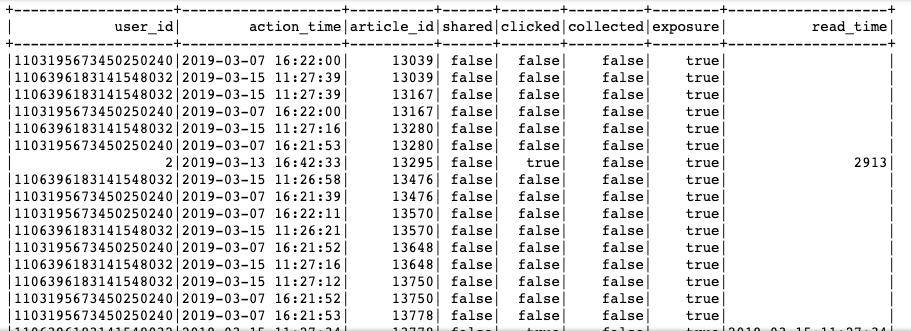

对于这样的数据,我们希望处理成一个完成统计基本表格,如下

- 用户画像标签建立

用户行为原始数据,我们得到了一张庞大的行为记录表。但是想要把这个表格的内容运用起来,我们需要把用户行为更为具象化,也就是需要把用户画像构建起来。

其实用户标签并不等同于用户画像,只是用户标签是用户画像直观的呈现,并且是比较好且常用的运用方式。

构建用户标签库其实比较简单,因为我们在上述采集用户行为过程中,已经把用户喜好的内容采集下来了,所以基础标签并可以直接运用内容的标签。也就是通过用户喜欢的内容给用户贴标签。

文章标签化

文章标签化,即之前我们建立好的文章标签,利用这些标签给用户贴上相应标签

| 频道1 | 频道2 | 频道3 | 频道4 | … | 性别 | 年龄 | |

|---|---|---|---|---|---|---|---|

| 用户1 | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | … | 1 | 10 |

| 用户2 | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | … | 1 | 20 |

| 用户3 | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | 标签weights,标签,标签…. | … | 0 | 30 |

3.2 用户画像增量更新

学习目标

- 目标

- 知道用户行为日志的处理过程

- 知道用户画像标签权重的计算公式

- 知道用户画像的HBase存储与Hive关联

- 应用

- 应用Spark完成用户画像的增量定时更新

3.2.1 增量用户行为日志处理

这里我们对用户画像更新的频率,

- 目的:首先对用户基础行为日志进行处理过滤,解析参数,从user_action—>user_article_basic表。

日志数据分析结果:

- 步骤:

- 1、创建HIVE基本数据表

- 2、读取固定时间内的用户行为日志

- 3、进行用户日志数据处理

- 4、存储到user_article_basic表中

创建HIVE基本数据表

create table user_article_basic(

user_id BIGINT comment "userID",

action_time STRING comment "user actions time",

article_id BIGINT comment "articleid",

channel_id INT comment "channel_id",

shared BOOLEAN comment "is shared",

clicked BOOLEAN comment "is clicked",

collected BOOLEAN comment "is collected",

exposure BOOLEAN comment "is exposured",

read_time STRING comment "reading time")

COMMENT "user_article_basic"

CLUSTERED by (user_id) into 2 buckets

STORED as textfile

LOCATION '/user/hive/warehouse/profile.db/user_article_basic';

读取固定时间内的用户行为日志

import os

import sys

# 如果当前代码文件运行测试需要加入修改路径,避免出现后导包问题

BASE_DIR = os.path.dirname(os.path.dirname(os.getcwd()))

sys.path.insert(0, os.path.join(BASE_DIR))

PYSPARK_PYTHON = "/miniconda2/envs/reco_sys/bin/python"

# 当存在多个版本时,不指定很可能会导致出错

os.environ["PYSPARK_PYTHON"] = PYSPARK_PYTHON

os.environ["PYSPARK_DRIVER_PYTHON"] = PYSPARK_PYTHON

from offline import SparkSessionBase

import pyhdfs

import time

class UpdateUserProfile(SparkSessionBase):

"""离线相关处理程序

"""

SPARK_APP_NAME = "updateUser"

ENABLE_HIVE_SUPPORT = True

SPARK_EXECUTOR_MEMORY = "7g"

def __init__(self):

self.spark = self._create_spark_session()

在进行日志信息的处理之前,先将我们之前建立的user_action表之间进行所有日期关联,spark hive不会自动关联

# 手动关联所有日期文件

import pandas as pd

from datetime import datetime

def datelist(beginDate, endDate):

date_list=[datetime.strftime(x,'%Y-%m-%d') for x in list(pd.date_range(start=beginDate, end=endDate))]

return date_list

dl = datelist("2019-03-05", time.strftime("%Y-%m-%d", time.localtime()))

fs = pyhdfs.HdfsClient(hosts='hadoop-master:50070')

for d in dl:

try:

_localions = '/user/hive/warehouse/profile.db/user_action/' + d

if fs.exists(_localions):

uup.spark.sql("alter table user_action add partition (dt='%s') location '%s'" % (d, _localions))

except Exception as e:

# 已经关联过的异常忽略,partition与hdfs文件不直接关联

pass

读取固定时间内的用户行为日志

注意每天有数据都要关联一次日期文件与HIVE表

# 如果hadoop没有今天该日期文件,则没有日志数据,结束

time_str = time.strftime("%Y-%m-%d", time.localtime())

_localions = '/user/hive/warehouse/profile.db/user_action/' + time_str

if fs.exists(_localions):

# 如果有该文件直接关联,捕获关联重复异常

try:

uup.spark.sql("alter table user_action add partition (dt='%s') location '%s'" % (time_str, _localions))

except Exception as e:

pass

sqlDF = uup.spark.sql(

"select actionTime, readTime, channelId, param.articleId, param.algorithmCombine, param.action, param.userId from user_action where dt={}".format(time_str))

else:

pass

为了进行测试防止没有数据,我们选定某个时间后的行为数据

sqlDF = uup.spark.sql(

"select actionTime, readTime, channelId, param.articleId, param.algorithmCombine, param.action, param.userId from user_action where dt>='2018-01-01'")

进行用户日志数据处理

原始日志数据

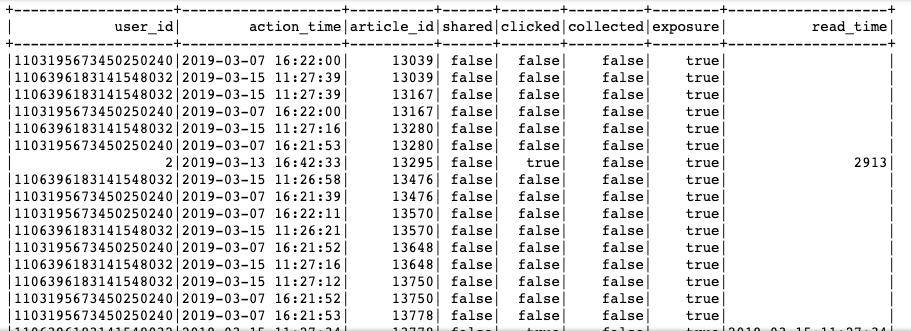

结果:

思路:按照user_id的行为一条条处理,根据用户的行为类型判别。

- 由于sqlDF每条数据可能会返回多条结果,我们可以使用rdd.flatMap函数或者yield

- 格式:[“user_id”, “action_time”,“article_id”, “channel_id”, “shared”, “clicked”, “collected”, “exposure”, “read_time”]

if sqlDF.collect():

def _compute(row):

# 进行判断行为类型

_list = []

if row.action == "exposure":

for article_id in eval(row.articleId):

_list.append(

[row.userId, row.actionTime, article_id, row.channelId, False, False, False, True, row.readTime])

return _list

else:

class Temp(object):

shared = False

clicked = False

collected = False

read_time = ""

_tp = Temp()

if row.action == "share":

_tp.shared = True

elif row.action == "click":

_tp.clicked = True

elif row.action == "collect":

_tp.collected = True

elif row.action == "read":

_tp.clicked = True

else:

pass

_list.append(

[row.userId, row.actionTime, int(row.articleId), row.channelId, _tp.shared, _tp.clicked, _tp.collected,

True,

row.readTime])

return _list

# 进行处理

# 查询内容,将原始日志表数据进行处理

_res = sqlDF.rdd.flatMap(_compute)

data = _res.toDF(["user_id", "action_time","article_id", "channel_id", "shared", "clicked", "collected", "exposure", "read_time"])

合并历史数据,存储到user_article_basic表中

# 合并历史数据,插入表中

old = uup.spark.sql("select * from user_article_basic")

# 由于合并的结果中不是对于user_id和article_id唯一的,一个用户会对文章多种操作

new_old = old.unionAll(data)

- HIVE目前支持hive终端操作ACID,不支持python的pyspark原子性操作,并且开启配置中开启原子性相关配置也不行。

new_old.registerTempTable("temptable")

# 按照用户,文章分组存放进去

uup.spark.sql(

"insert overwrite table user_article_basic select user_id, max(action_time) as action_time, "

"article_id, max(channel_id) as channel_id, max(shared) as shared, max(clicked) as clicked, "

"max(collected) as collected, max(exposure) as exposure, max(read_time) as read_time from temptable "

"group by user_id, article_id")

这里面需要根据用户ID和文章ID分组。

3.2.2 用户标签权重计算

3.2.2.1 画像存储

如何存储?

用户画像,作为特征提供给一些算法排序,方便与快速读取使用,选择存储在Hbase当中。如果离线分析也想要使用我们可以建立HIVE到Hbase的外部表。

- 如果存到HIVE,建立HBASE关联过去,删除Hive表对HBase没有影响,但是先删除HBase表Hive就会报TableNotFoundException

- HBase中的有同样的主键的行会被更新成最新插入的。可以依靠hbase来 新增/修改单条记录, 然后利用hive这个外表来实现hbase数据统计

HBase表设计

create 'user_profile', 'basic','partial','env'

示例:

put 'user_profile', 'user:2', 'partial:{channel_id}:{topic}': weights

put 'user_profile', 'user:2', 'basic:{info}': value

put 'user_profile', 'user:2', 'env:{info}': value

Hive关联表

create external table user_profile_hbase(

user_id STRING comment "userID",

information map<string, DOUBLE> comment "user basic information",

article_partial map<string, DOUBLE> comment "article partial",

env map<string, INT> comment "user env")

COMMENT "user profile table"

STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,basic:,partial:,env:")

TBLPROPERTIES ("hbase.table.name" = "user_profile");

3.2.2.2 Spark SQL关联表读取问题?

创建关联表之后,离线读取表内容需要一些依赖包。解决办法:

- 拷贝/root/bigdata/hbase/lib/下面hbase-*.jar 到 /root/bigdata/spark/jars/目录下

- 拷贝/root/bigdata/hive/lib/h*.jar 到 /root/bigdata/spark/jars/目录下

上述操作三台虚拟机都执行一遍。

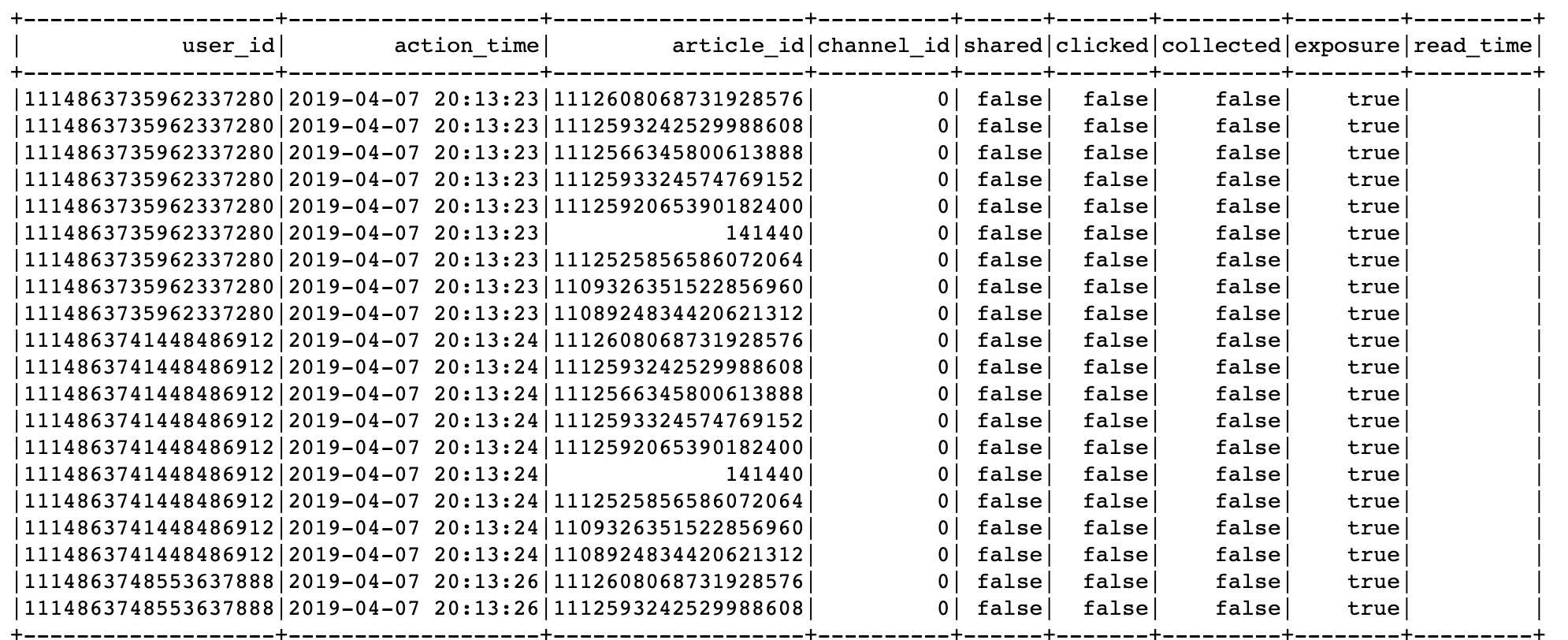

3.2.2.3 用户画像频道关键词获取与权重计算

- 目标:获取用户1~25频道(不包括推荐频道)的关键词,并计算权重

- 步骤:

- 1、读取user_article_basic表,合并行为表与文章画像中的主题词

- 2、进行用户权重计算公式、同时落地存储

读取user_article_basic表

# 获取基本用户行为信息,然后进行文章画像的主题词合并

uup.spark.sql("use profile")

# 取出日志中的channel_id

user_article_ = uup.spark.sql("select * from user_article_basic").drop('channel_id')

uup.spark.sql('use article')

article_label = uup.spark.sql("select article_id, channel_id, topics from article_profile")

# 合并使用文章中正确的channel_id

click_article_res = user_article_.join(article_label, how='left', on=['article_id'])

对channel_id进行处理的原因:日志中的频道号,是通过Web后台进行埋点,有些并没有真正对应文章所属频道(推荐频道为0号频道,获取曝光文章列表时候埋点会将文章对应的频道在日志中是0频道。)

这样的主题词列表进行计算权重不方便对于用户的每个主题词权重计算,需要进行explode

# 将字段的列表爆炸

import pyspark.sql.functions as F

click_article_res = click_article_res.withColumn('topic', F.explode('topics')).drop('topics')

进行用户权重计算公式、同时落地存储。

3.2.2.4 用户画像之标签权重算法

用户标签权重 =( 行为类型权重之和) × 时间衰减

行为类型权重

分值的确定需要整体协商

| 行为 | 分值 |

|---|---|

| 阅读时间(<1000) | 1 |

| 阅读时间(>=1000) | 2 |

| 收藏 | 2 |

| 分享 | 3 |

| 点击 | 5 |

完成对关键行为赋予权重分值后,即可开始计算,首先我们把用户浏览(收听、观看)的内容全部按照上面内容标签化的方式打散成标签

时间衰减:1/(log(t)+1) ,t为时间发生时间距离当前时间的大小。

# 计算每个用户对每篇文章的标签的权重

def compute_weights(rowpartition):

"""处理每个用户对文章的点击数据

"""

weightsOfaction = {

"read_min": 1,

"read_middle": 2,

"collect": 2,

"share": 3,

"click": 5

}

import happybase

from datetime import datetime

import numpy as np

# 用于读取hbase缓存结果配置

pool = happybase.ConnectionPool(size=10, host='192.168.19.137', port=9090)

# 读取文章的标签数据

# 计算权重值

# 时间间隔

for row in rowpartition:

t = datetime.now() - datetime.strptime(row.action_time, '%Y-%m-%d %H:%M:%S')

# 时间衰减系数

time_exp = 1 / (np.log(t.days + 1) + 1)

if row.read_time == '':

r_t = 0

else:

r_t = int(row.read_time)

# 浏览时间分数

is_read = weightsOfaction['read_middle'] if r_t > 1000 else weightsOfaction['read_min']

# 每个词的权重分数

weigths = time_exp * (

row.shared * weightsOfaction['share'] + row.collected * weightsOfaction['collect'] + row.

clicked * weightsOfaction['click'] + is_read)

# with pool.connection() as conn:

# table = conn.table('user_profile')

# table.put('user:{}'.format(row.user_id).encode(),

# {'partial:{}:{}'.format(row.channel_id, row.topic).encode(): json.dumps(

# weigths).encode()})

# conn.close()

click_article_res.foreachPartition(compute_weights)

落地Hbase中之后,在HBASE中查询,happybase或者hbase终端

import happybase

# 用于读取hbase缓存结果配置

pool = happybase.ConnectionPool(size=10, host='192.168.19.137', port=9090)

with pool.connection() as conn:

table = conn.table('user_profile')

# 获取每个键 对应的所有列的结果

data = table.row(b'user:2', columns=[b'partial'])

conn.close()

hbase(main):015:0> get 'user_profile', 'user:2'

同时在HIVE中查询

hive> select * from user_profile_hbase limit 1;

OK

user:1 {"birthday":0.0,"gender":null} {"18:##":0.25704484358604845,"18:&#":0.25704484358604845,"18:+++":0.23934588700996243,"18:+++++":0.23934588700996243,"18:AAA":0.2747964402379244,"18:Animal":0.2747964402379244,"18:Author":0.2747964402379244,"18:BASE":0.23934588700996243,"18:BBQ":0.23934588700996243,"18:Blueprint":1.6487786414275463,"18:Code":0.23934588700996243,"18:DIR....................................................

3.2.3 基础信息画像更新

同时对于用户的基础信息也需要更新到用户的画像中。

def update_user_info(self):

"""

更新用户的基础信息画像

:return:

"""

self.spark.sql("use toutiao")

user_basic = self.spark.sql("select user_id, gender, birthday from user_profile")

# 更新用户基础信息

def _udapte_user_basic(partition):

"""更新用户基本信息

"""

import happybase

# 用于读取hbase缓存结果配置

pool = happybase.ConnectionPool(size=10, host='172.17.0.134', port=9090)

for row in partition:

from datetime import date

age = 0

if row.birthday != 'null':

born = datetime.strptime(row.birthday, '%Y-%m-%d')

today = date.today()

age = today.year - born.year - ((today.month, today.day) < (born.month, born.day))

with pool.connection() as conn:

table = conn.table('user_profile')

table.put('user:{}'.format(row.user_id).encode(),

{'basic:gender'.encode(): json.dumps(row.gender).encode()})

table.put('user:{}'.format(row.user_id).encode(),

{'basic:birthday'.encode(): json.dumps(age).encode()})

conn.close()

user_basic.foreachPartition(_udapte_user_basic)

logger.info(

"{} INFO completely update infomation of basic".format(datetime.now().strftime('%Y-%m-%d %H:%M:%S')))

hbase(main):016:0> get 'user_profile', 'user:2'

3.2.4 用户画像增量更新定时开启

- 用户画像增量更新代码整理

- 添加定时任务以及进程管理

在main.py和update.py文件中增加

from offline.update_user import UpdateUserProfile

def update_user_profile():

"""

更新用户画像

"""

uup = UpdateUserProfile()

if uup.update_user_action_basic():

uup.update_user_label()

uup.update_user_info()

scheduler.add_job(update_user_profile, trigger='interval', hours=2)

添加之后,进行supervisor的update。

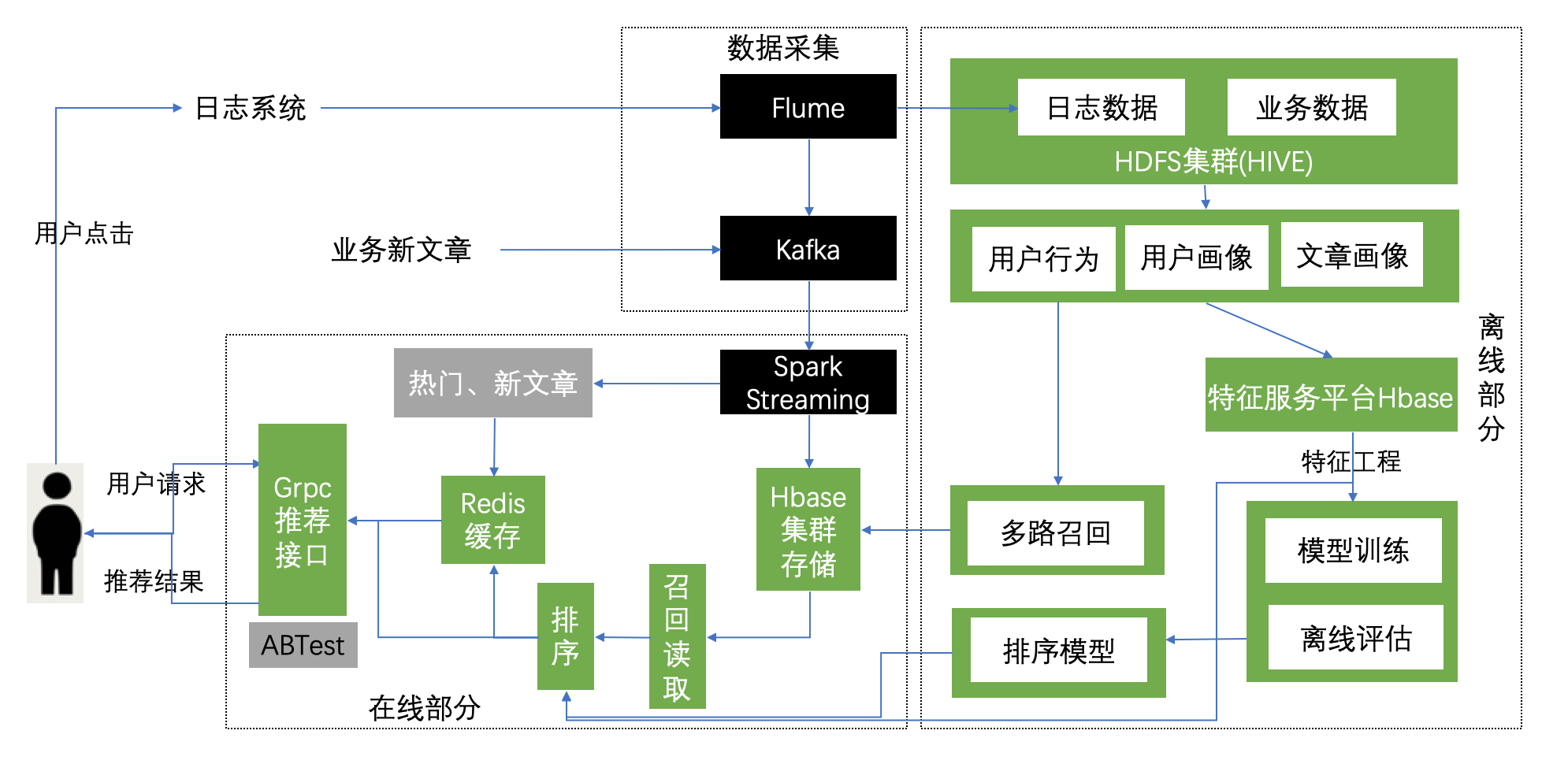

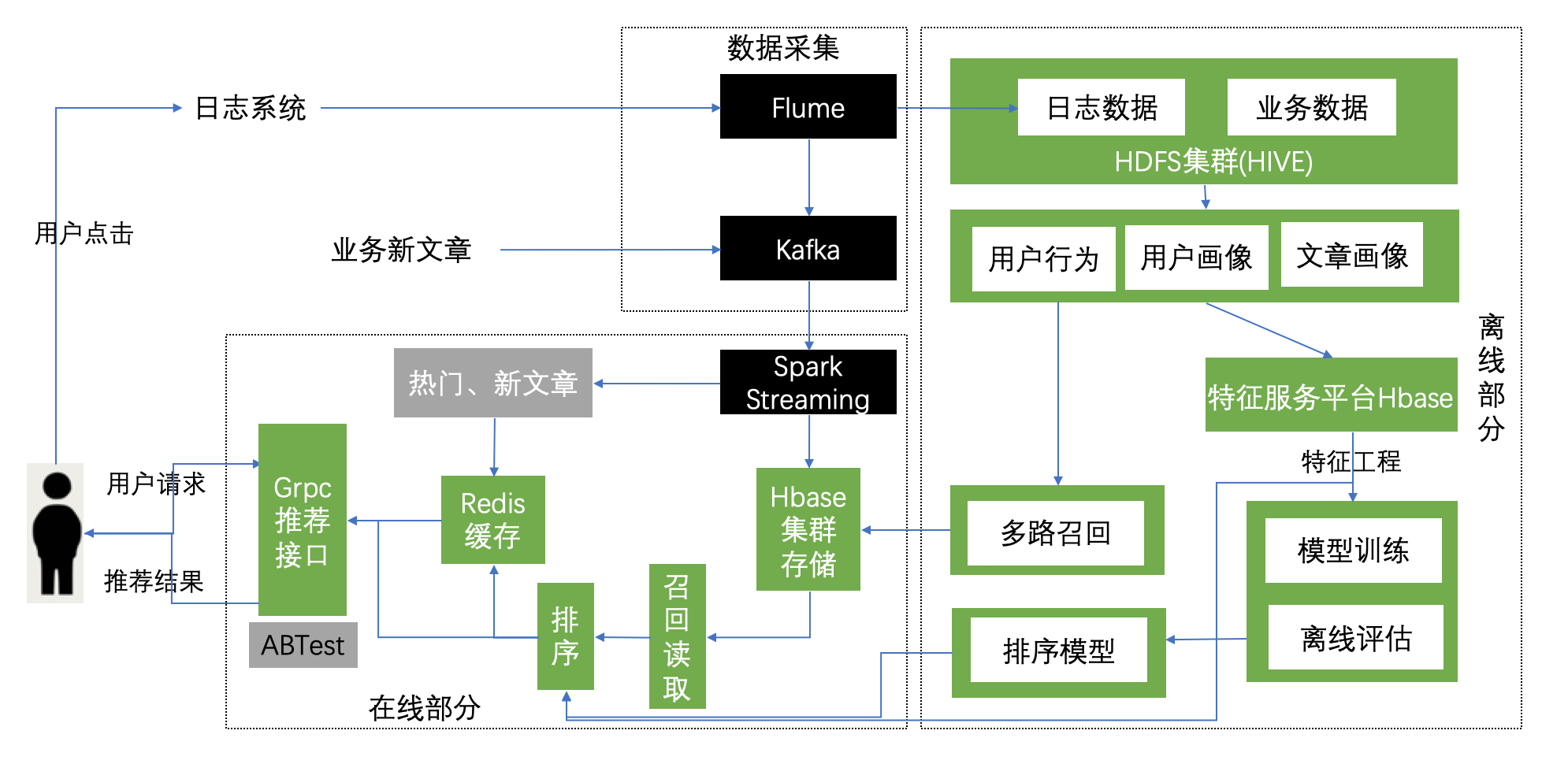

3.3 离线召回与排序介绍

学习目标

- 目标

- 了解召回排序作用

- 知道头条推荐召回排序设计

- 应用

- 无

3.3.1 召回与排序介绍

召回:从海量文章数据中得到若干候选文章召回集合(数量较多)

排序:从召回集合中读取推荐文章,构建样本特征进行排序过滤筛选

3.3.1.1 黑马召回与排序业务流程

3.3.2 黑马头条推荐的召回排序设计

- 匿名用户:

- 通常使用用户冷启动方案,区别在于user_id为匿名用户手机识别号(黑马头条不允许匿名用户)

- 所有只正针对于登录用户:

- 用户冷启动(前期点击行为较少情况)

- 非个性化推荐

- 热门召回:自定义热门规则,根据当前时间段热点定期更新维护人点文章库

- 新文章召回:为了提高新文章的曝光率,建立新文章库,进行推荐

- 个性化推荐:

- 基于内容的协同过滤在线召回:基于用户实时兴趣画像相似的召回结果用于首页的个性化推荐

- 非个性化推荐

- 后期离线部分(用户点击行为较多,用户画像完善)

- 建立用户长期兴趣画像(详细):包括用户各个维度的兴趣特征

- 训练排序模型

- LR模型、FTRL、Wide&Deep

- 离线部分的召回:

- 基于模型协同过滤推荐离线召回:ALS

- 基于内容的离线召回:或者称基于用户画像的召回

3.4 召回表设计与模型召回

学习目标

- 目标

- 知道ALS模型推荐API使用

- 知道StringIndexer的使用

- 应用

- 应用spark完成离线用户基于模型的协同过滤推荐

3.4.1 召回表设计

我们的召回方式有很多种,多路召回结果存储模型召回与内容召回的结果需要进行相应频道推荐合并。

- 方案:基于模型与基于内容的召回结果存入同一张表,避免多张表进行读取处理

- 由于HBASE有多个版本数据功能存在的支持

- TTL=>7776000, VERSIONS=>999999

create 'cb_recall', {NAME=>'als', TTL=>7776000, VERSIONS=>999999}

alter 'cb_recall', {NAME=>'content', TTL=>7776000, VERSIONS=>999999}

alter 'cb_recall', {NAME=>'online', TTL=>7776000, VERSIONS=>999999}

# 例子:

put 'cb_recall', 'recall:user:5', 'als:1',[45,3,5,10]

put 'cb_recall', 'recall:user:5', 'als:1',[289,11,65,52,109,8]

put 'cb_recall', 'recall:user:5', 'als:2',[1,2,3,4,5,6,7,8,9,10]

put 'cb_recall', 'recall:user:2', 'content:1',[45,3,5,10,289,11,65,52,109,8]

put 'cb_recall', 'recall:user:2', 'content:2',[1,2,3,4,5,6,7,8,9,10]

hbase(main):084:0> desc 'cb_recall'

Table cb_recall is ENABLED

cb_recall

COLUMN FAMILIES DESCRIPTION

{NAME => 'als', VERSIONS => '999999', EVICT_BLOCKS_ON_CLOSE => 'false', NEW_VERSION_BEHAVIOR => 'false'

, KEEP_DELETED_CELLS => 'FALSE', CACHE_DATA_ON_WRITE => 'false', DATA_BLOCK_ENCODING => 'NONE', TTL =>

'7776000 SECONDS (90 DAYS)', MIN_VERSIONS => '0', REPLICATION_SCOPE => '0', BLOOMFILTER => 'ROW', CACHE

_INDEX_ON_WRITE => 'false', IN_MEMORY => 'false', CACHE_BLOOMS_ON_WRITE => 'false', PREFETCH_BLOCKS_ON_

OPEN => 'false', COMPRESSION => 'NONE', BLOCKCACHE => 'true', BLOCKSIZE => '65536'}

{NAME => 'content', VERSIONS => '999999', EVICT_BLOCKS_ON_CLOSE => 'false', NEW_VERSION_BEHAVIOR => 'fa

lse', KEEP_DELETED_CELLS => 'FALSE', CACHE_DATA_ON_WRITE => 'false', DATA_BLOCK_ENCODING => 'NONE', TTL

=> '7776000 SECONDS (90 DAYS)', MIN_VERSIONS => '0', REPLICATION_SCOPE => '0', BLOOMFILTER => 'ROW', C

ACHE_INDEX_ON_WRITE => 'false', IN_MEMORY => 'false', CACHE_BLOOMS_ON_WRITE => 'false', PREFETCH_BLOCKS

_ON_OPEN => 'false', COMPRESSION => 'NONE', BLOCKCACHE => 'true', BLOCKSIZE => '65536'}

{NAME => 'online', VERSIONS => '999999', EVICT_BLOCKS_ON_CLOSE => 'false', NEW_VERSION_BEHAVIOR => 'fal

se', KEEP_DELETED_CELLS => 'FALSE', CACHE_DATA_ON_WRITE => 'false', DATA_BLOCK_ENCODING => 'NONE', TTL

=> '7776000 SECONDS (90 DAYS)', MIN_VERSIONS => '0', REPLICATION_SCOPE => '0', BLOOMFILTER => 'ROW', CA

CHE_INDEX_ON_WRITE => 'false', IN_MEMORY => 'false', CACHE_BLOOMS_ON_WRITE => 'false', PREFETCH_BLOCKS_

ON_OPEN => 'false', COMPRESSION => 'NONE', BLOCKCACHE => 'true', BLOCKSIZE => '65536'}

3 row(s)

在HIVE用户数据数据库下建立HIVE外部表,若hbase表有修改,则进行HIVE 表删除更新

create external table cb_recall_hbase(

user_id STRING comment "userID",

als map<string, ARRAY<BIGINT>> comment "als recall",

content map<string, ARRAY<BIGINT>> comment "content recall",

online map<string, ARRAY<BIGINT>> comment "online recall")

COMMENT "user recall table"

STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,als:,content:,online:")

TBLPROPERTIES ("hbase.table.name" = "cb_recall");

增加一个历史召回结果表

create 'history_recall', {NAME=>'channel', TTL=>7776000, VERSIONS=>999999}

put 'history_recall', 'recall:user:5', 'als:1',[1,2,3]

put 'history_recall', 'recall:user:5', 'als:1',[4,5,6,7]

put 'history_recall', 'recall:user:5', 'als:1',[8,9,10]

为什么增加历史召回表?

- 1、直接在存储召回结果部分进行过滤,比之后排序过滤,节省排序时间

- 2、防止Redis缓存没有消耗完,造成重复推荐,从源头进行过滤

3.4.2 基于模型召回集合计算

初始化信息

import os

import sys

# 如果当前代码文件运行测试需要加入修改路径,避免出现后导包问题

BASE_DIR = os.path.dirname(os.path.dirname(os.getcwd()))

sys.path.insert(0, os.path.join(BASE_DIR))

PYSPARK_PYTHON = "/miniconda2/envs/reco_sys/bin/python"

# 当存在多个版本时,不指定很可能会导致出错

os.environ["PYSPARK_PYTHON"] = PYSPARK_PYTHON

os.environ["PYSPARK_DRIVER_PYTHON"] = PYSPARK_PYTHON

from offline import SparkSessionBase

class UpdateRecall(SparkSessionBase):

SPARK_APP_NAME = "updateRecall"

ENABLE_HIVE_SUPPORT = True

def __init__(self):

self.spark = self._create_spark_session()

ur = UpdateRecall()

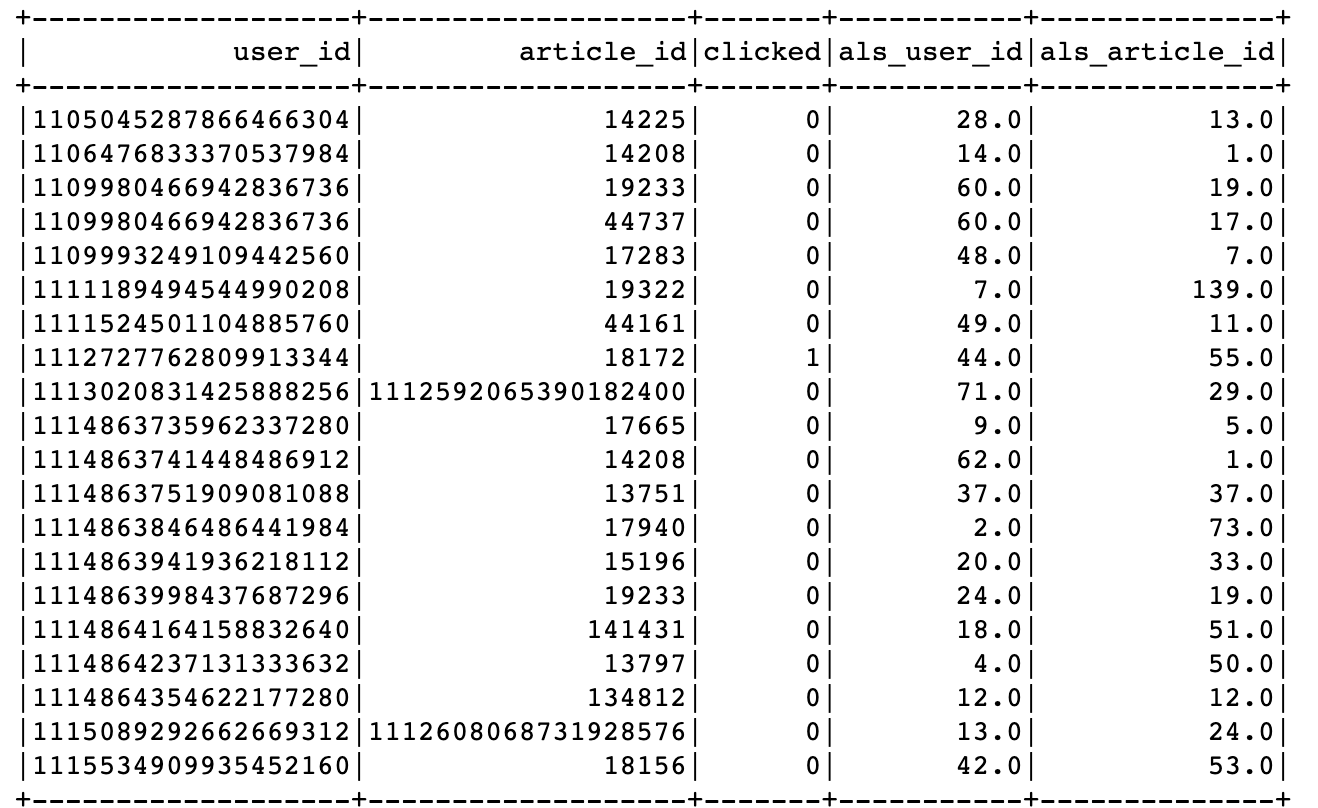

3.4.2.1 用户日志信息处理

- 目标:处理成ALS模型所需数据类型和格式

- 步骤:

- 数据类型转换,clicked

- 用户ID与文章ID处理

数据类型转换,clicked

ur.spark.sql("use profile")

user_article_click = ur.spark.sql("select * from user_article_basic").\

select(['user_id', 'article_id', 'clicked'])

# 更换类型

def change_types(row):

return row.user_id, row.article_id, int(row.clicked)

user_article_click = user_article_click.rdd.map(change_types).toDF(['user_id', 'article_id', 'clicked'])

用户ID与文章ID处理,编程ID索引

from pyspark.ml.feature import StringIndexer

from pyspark.ml import Pipeline

# 用户和文章ID超过ALS最大整数值,需要使用StringIndexer进行转换

user_id_indexer = StringIndexer(inputCol='user_id', outputCol='als_user_id')

article_id_indexer = StringIndexer(inputCol='article_id', outputCol='als_article_id')

pip = Pipeline(stages=[user_id_indexer, article_id_indexer])

pip_fit = pip.fit(user_article_click)

als_user_article_click = pip_fit.transform(user_article_click)

3.4.2.2 ALS 模型训练与推荐

ALS模型需要输出用户ID列,文章ID列以及点击列

from pyspark.ml.recommendation import ALS

# 模型训练和推荐默认每个用户固定文章个数

als = ALS(userCol='als_user_id', itemCol='als_article_id', ratingCol='clicked', checkpointInterval=1)

model = als.fit(als_user_article_click)

recall_res = model.recommendForAllUsers(100)

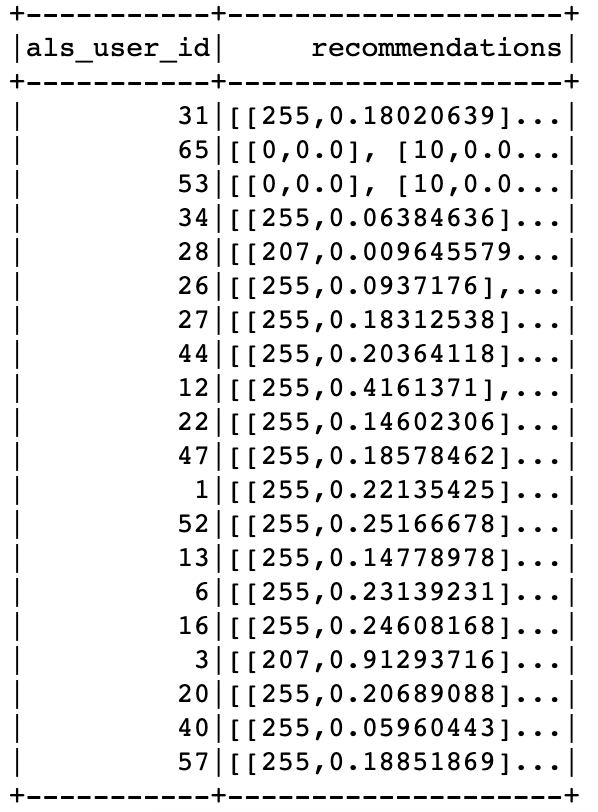

3.4.2.3 推荐结果处理

通过StringIndexer变换后的下标知道原来的和用户ID

# recall_res得到需要使用StringIndexer变换后的下标

# 保存原来的下表映射关系

refection_user = als_user_article_click.groupBy(['user_id']).max('als_user_id').withColumnRenamed(

'max(als_user_id)', 'als_user_id')

refection_article = als_user_article_click.groupBy(['article_id']).max('als_article_id').withColumnRenamed(

'max(als_article_id)', 'als_article_id')

# Join推荐结果与 refection_user映射关系表

# +-----------+--------------------+-------------------+

# | als_user_id | recommendations | user_id |

# +-----------+--------------------+-------------------+

# | 8 | [[163, 0.91328144]... | 2 |

# | 0 | [[145, 0.653115], ... | 1106476833370537984 |

recall_res = recall_res.join(refection_user, on=['als_user_id'], how='left').select(

['als_user_id', 'recommendations', 'user_id'])

对推荐文章ID后处理:得到推荐列表,获取推荐列表中的ID索引

# Join推荐结果与 refection_article映射关系表

# +-----------+-------+----------------+

# | als_user_id | user_id | als_article_id |

# +-----------+-------+----------------+

# | 8 | 2 | [163, 0.91328144] |

# | 8 | 2 | [132, 0.91328144] |

import pyspark.sql.functions as F

recall_res = recall_res.withColumn('als_article_id', F.explode('recommendations')).drop('recommendations')

# +-----------+-------+--------------+

# | als_user_id | user_id | als_article_id |

# +-----------+-------+--------------+

# | 8 | 2 | 163 |

# | 8 | 2 | 132 |

def _article_id(row):

return row.als_user_id, row.user_id, row.als_article_id[0]

进行索引对应文章ID获取

als_recall = recall_res.rdd.map(_article_id).toDF(['als_user_id', 'user_id', 'als_article_id'])

als_recall = als_recall.join(refection_article, on=['als_article_id'], how='left').select(

['user_id', 'article_id'])

# 得到每个用户ID 对应推荐文章

# +-------------------+----------+

# | user_id | article_id |

# +-------------------+----------+

# | 1106476833370537984 | 44075 |

# | 1 | 44075 |

获取每个文章对应的频道,推荐给用户时按照频道存储

ur.spark.sql("use toutiao")

news_article_basic = ur.spark.sql("select article_id, channel_id from news_article_basic")

als_recall = als_recall.join(news_article_basic, on=['article_id'], how='left')

als_recall = als_recall.groupBy(['user_id', 'channel_id']).agg(F.collect_list('article_id')).withColumnRenamed(

'collect_list(article_id)', 'article_list')

als_recall = als_recall.dropna()

3.4.2.4 召回结果存储

- 存储位置,选择HBASE

HBASE表设计:

put 'cb_recall', 'recall:user:5', 'als:1',[45,3,5,10,289,11,65,52,109,8]

put 'cb_recall', 'recall:user:5', 'als:2',[1,2,3,4,5,6,7,8,9,10]

存储代码如下:

def save_offline_recall_hbase(partition):

"""离线模型召回结果存储

"""

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master', port=9090)

for row in partition:

with pool.connection() as conn:

# 获取历史看过的该频道文章

history_table = conn.table('history_recall')

# 多个版本

data = history_table.cells('reco:his:{}'.format(row.user_id).encode(),

'channel:{}'.format(row.channel_id).encode())

history = []

if len(data) >= 2:

for l in data[:-1]:

history.extend(eval(l))

else:

history = []

# 过滤reco_article与history

reco_res = list(set(row.article_list) - set(history))

if reco_res:

table = conn.table('cb_recall')

# 默认放在推荐频道

table.put('recall:user:{}'.format(row.user_id).encode(),

{'als:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

conn.close()

# 放入历史推荐过文章

history_table.put("reco:his:{}".format(row.user_id).encode(),

{'channel:{}'.format(row.channel_id): str(reco_res).encode()})

conn.close()

als_recall.foreachPartition(save_offline_recall_hbase)

3.5 离线用户基于内容召回集

学习目标

- 目标

- 知道离线内容召回的概念

- 知道如何进行内容召回计算存储规则

- 应用

- 应用spark完成离线用户基于内容的协同过滤推荐

3.5.1 基于内容召回实现

- 目的:实现定时离线更新用户的内容召回集合

- 步骤:

- 1、过滤用户点击的文章

- 2、用户每次操作文章进行相似获取并进行推荐

过滤用户点击的文章

ur.spark.sql("use profile")

user_article_basic = ur.spark.sql("select * from user_article_basic")

user_article_basic = user_article_basic.filter('clicked=True')

用户每次操作文章进行相似获取并进行推荐

# 基于内容相似召回(画像召回)

ur.spark.sql("use profile")

user_article_basic = self.spark.sql("select * from user_article_basic")

user_article_basic = user_article_basic.filter("clicked=True")

def save_content_filter_history_to__recall(partition):

"""计算每个用户的每个操作文章的相似文章,过滤之后,写入content召回表当中(支持不同时间戳版本)

"""

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master')

# 进行为相似文章获取

with pool.connection() as conn:

# key: article_id, column: similar:article_id

similar_table = conn.table('article_similar')

# 循环partition

for row in partition:

# 获取相似文章结果表

similar_article = similar_table.row(str(row.article_id).encode(),

columns=[b'similar'])

# 相似文章相似度排序过滤,召回不需要太大的数据, 百个,千

_srt = sorted(similar_article.items(), key=lambda item: item[1], reverse=True)

if _srt:

# 每次行为推荐10篇文章

reco_article = [int(i[0].split(b':')[1]) for i in _srt][:10]

# 获取历史看过的该频道文章

history_table = conn.table('history_recall')

# 多个版本

data = history_table.cells('reco:his:{}'.format(row.user_id).encode(),

'channel:{}'.format(row.channel_id).encode())

history = []

if len(data) >= 2:

for l in data[:-1]:

history.extend(eval(l))

else:

history = []

# 过滤reco_article与history

reco_res = list(set(reco_article) - set(history))

# 进行推荐,放入基于内容的召回表当中以及历史看过的文章表当中

if reco_res:

# content_table = conn.table('cb_content_recall')

content_table = conn.table('cb_recall')

content_table.put("recall:user:{}".format(row.user_id).encode(),

{'content:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

# 放入历史推荐过文章

history_table.put("reco:his:{}".format(row.user_id).encode(),

{'channel:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

conn.close()

user_article_basic.foreachPartition(save_content_filter_history_to__recall)

- 1、获取用户点击的某文章相似文章结果并排序过滤

- 相似结果取出TOPK:根据实际场景选择大小,10或20

# 循环partition

for row in partition:

# 获取相似文章结果表

similar_article = similar_table.row(str(row.article_id).encode(),

columns=[b'similar'])

# 相似文章相似度排序过滤,召回不需要太大的数据, 百个,千

_srt = sorted(similar_article.items(), key=lambda item: item[1], reverse=True)

if _srt:

# 每次行为推荐若干篇文章

reco_article = [int(i[0].split(b':')[1]) for i in _srt][:10]

- 2、过滤历史召回的所有文章(所有的召回类型)

# 获取历史看过的该频道文章

history_table = conn.table('history_recall')

# 多个版本

data = history_table.cells('reco:his:{}'.format(row.user_id).encode(),

'channel:{}'.format(row.channel_id).encode())

history = []

if len(data) >= 2:

for l in data[:-1]:

history.extend(eval(l))

else:

history = []

# 过滤reco_article与history

reco_res = list(set(reco_article) - set(history))

- 3、对结果进行存储,历史推荐存储

# 进行推荐,放入基于内容的召回表当中以及历史看过的文章表当中

if reco_res:

# content_table = conn.table('cb_content_recall')

content_table = conn.table('cb_recall')

content_table.put("recall:user:{}".format(row.user_id).encode(),

{'content:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

# 放入历史推荐过文章

history_table.put("reco:his:{}".format(row.user_id).encode(),

{'channel:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

3.6 离线用户召回定时更新

学习目标

- 目标

- 知道离线内容召回的概念

- 知道如何进行内容召回计算存储规则

- 应用

- 应用spark完成离线用户基于内容的协同过滤推荐

3.6.1 定时更新代码

- 完整代码

import os

import sys

# 如果当前代码文件运行测试需要加入修改路径,否则后面的导包出现问题

BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__)))

sys.path.insert(0, os.path.join(BASE_DIR))

from pyspark.ml.feature import StringIndexer

from pyspark.ml import Pipeline

from pyspark.ml.recommendation import ALS

from offline import SparkSessionBase

from datetime import datetime

import time

import numpy as np

class UpdateRecall(SparkSessionBase):

SPARK_APP_NAME = "updateRecall"

ENABLE_HIVE_SUPPORT = True

def __init__(self, number):

self.spark = self._create_spark_session()

self.N = number

def update_als_recall(self):

"""

更新基于模型(ALS)的协同过滤召回集

:return:

"""

# 读取用户行为基本表

self.spark.sql("use profile")

user_article_click = self.spark.sql("select * from user_article_basic").\

select(['user_id', 'article_id', 'clicked'])

# 更换类型

def change_types(row):

return row.user_id, row.article_id, int(row.clicked)

user_article_click = user_article_click.rdd.map(change_types).toDF(['user_id', 'article_id', 'clicked'])

# 用户和文章ID超过ALS最大整数值,需要使用StringIndexer进行转换

user_id_indexer = StringIndexer(inputCol='user_id', outputCol='als_user_id')

article_id_indexer = StringIndexer(inputCol='article_id', outputCol='als_article_id')

pip = Pipeline(stages=[user_id_indexer, article_id_indexer])

pip_fit = pip.fit(user_article_click)

als_user_article_click = pip_fit.transform(user_article_click)

# 模型训练和推荐默认每个用户固定文章个数

als = ALS(userCol='als_user_id', itemCol='als_article_id', ratingCol='clicked', checkpointInterval=1)

model = als.fit(als_user_article_click)

recall_res = model.recommendForAllUsers(self.N)

# recall_res得到需要使用StringIndexer变换后的下标

# 保存原来的下表映射关系

refection_user = als_user_article_click.groupBy(['user_id']).max('als_user_id').withColumnRenamed(

'max(als_user_id)', 'als_user_id')

refection_article = als_user_article_click.groupBy(['article_id']).max('als_article_id').withColumnRenamed(

'max(als_article_id)', 'als_article_id')

# Join推荐结果与 refection_user映射关系表

# +-----------+--------------------+-------------------+

# | als_user_id | recommendations | user_id |

# +-----------+--------------------+-------------------+

# | 8 | [[163, 0.91328144]... | 2 |

# | 0 | [[145, 0.653115], ... | 1106476833370537984 |

recall_res = recall_res.join(refection_user, on=['als_user_id'], how='left').select(

['als_user_id', 'recommendations', 'user_id'])

# Join推荐结果与 refection_article映射关系表

# +-----------+-------+----------------+

# | als_user_id | user_id | als_article_id |

# +-----------+-------+----------------+

# | 8 | 2 | [163, 0.91328144] |

# | 8 | 2 | [132, 0.91328144] |

import pyspark.sql.functions as F

recall_res = recall_res.withColumn('als_article_id', F.explode('recommendations')).drop('recommendations')

# +-----------+-------+--------------+

# | als_user_id | user_id | als_article_id |

# +-----------+-------+--------------+

# | 8 | 2 | 163 |

# | 8 | 2 | 132 |

def _article_id(row):

return row.als_user_id, row.user_id, row.als_article_id[0]

als_recall = recall_res.rdd.map(_article_id).toDF(['als_user_id', 'user_id', 'als_article_id'])

als_recall = als_recall.join(refection_article, on=['als_article_id'], how='left').select(

['user_id', 'article_id'])

# 得到每个用户ID 对应推荐文章

# +-------------------+----------+

# | user_id | article_id |

# +-------------------+----------+

# | 1106476833370537984 | 44075 |

# | 1 | 44075 |

# 分组统计每个用户,推荐列表

# als_recall = als_recall.groupby('user_id').agg(F.collect_list('article_id')).withColumnRenamed(

# 'collect_list(article_id)', 'article_list')

self.spark.sql("use toutiao")

news_article_basic = self.spark.sql("select article_id, channel_id from news_article_basic")

als_recall = als_recall.join(news_article_basic, on=['article_id'], how='left')

als_recall = als_recall.groupBy(['user_id', 'channel_id']).agg(F.collect_list('article_id')).withColumnRenamed(

'collect_list(article_id)', 'article_list')

als_recall = als_recall.dropna()

# 存储

def save_offline_recall_hbase(partition):

"""离线模型召回结果存储

"""

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master', port=9090)

for row in partition:

with pool.connection() as conn:

# 获取历史看过的该频道文章

history_table = conn.table('history_recall')

# 多个版本

data = history_table.cells('reco:his:{}'.format(row.user_id).encode(),

'channel:{}'.format(row.channel_id).encode())

history = []

if len(data) >= 2:

for l in data[:-1]:

history.extend(eval(l))

else:

history = []

# 过滤reco_article与history

reco_res = list(set(row.article_list) - set(history))

if reco_res:

table = conn.table('cb_recall')

# 默认放在推荐频道

table.put('recall:user:{}'.format(row.user_id).encode(),

{'als:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

conn.close()

# 放入历史推荐过文章

history_table.put("reco:his:{}".format(row.user_id).encode(),

{'channel:{}'.format(row.channel_id): str(reco_res).encode()})

conn.close()

als_recall.foreachPartition(save_offline_recall_hbase)

def update_content_recall(self):

"""

更新基于内容(画像)的推荐召回集, word2vec相似

:return:

"""

# 基于内容相似召回(画像召回)

ur.spark.sql("use profile")

user_article_basic = self.spark.sql("select * from user_article_basic")

user_article_basic = user_article_basic.filter("clicked=True")

def save_content_filter_history_to__recall(partition):

"""计算每个用户的每个操作文章的相似文章,过滤之后,写入content召回表当中(支持不同时间戳版本)

"""

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master')

# 进行为相似文章获取

with pool.connection() as conn:

# key: article_id, column: similar:article_id

similar_table = conn.table('article_similar')

# 循环partition

for row in partition:

# 获取相似文章结果表

similar_article = similar_table.row(str(row.article_id).encode(),

columns=[b'similar'])

# 相似文章相似度排序过滤,召回不需要太大的数据, 百个,千

_srt = sorted(similar_article.items(), key=lambda item: item[1], reverse=True)

if _srt:

# 每次行为推荐10篇文章

reco_article = [int(i[0].split(b':')[1]) for i in _srt][:10]

# 获取历史看过的该频道文章

history_table = conn.table('history_recall')

# 多个版本

data = history_table.cells('reco:his:{}'.format(row.user_id).encode(),

'channel:{}'.format(row.channel_id).encode())

history = []

if len(data) >= 2:

for l in data[:-1]:

history.extend(eval(l))

else:

history = []

# 过滤reco_article与history

reco_res = list(set(reco_article) - set(history))

# 进行推荐,放入基于内容的召回表当中以及历史看过的文章表当中

if reco_res:

# content_table = conn.table('cb_content_recall')

content_table = conn.table('cb_recall')

content_table.put("recall:user:{}".format(row.user_id).encode(),

{'content:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

# 放入历史推荐过文章

history_table.put("reco:his:{}".format(row.user_id).encode(),

{'channel:{}'.format(row.channel_id).encode(): str(reco_res).encode()})

conn.close()

user_article_basic.foreachPartition(save_content_filter_history_to__recall)

if __name__ == '__main__':

ur = UpdateRecall(500)

ur.update_als_recall()

ur.update_content_recall()

- 定时更新代码,在main.py和update.py中添加以下代码:

from offline.update_recall import UpdateRecall

from schedule.update_profile import update_user_profile, update_article_profile, update_recall

def update_recall():

"""

更新用户的召回集

:return:

"""

udp = UpdateRecall(200)

udp.update_als_recall()

udp.update_content_recall()

main中添加

scheduler.add_job(update_recall, trigger='interval', hour=3)

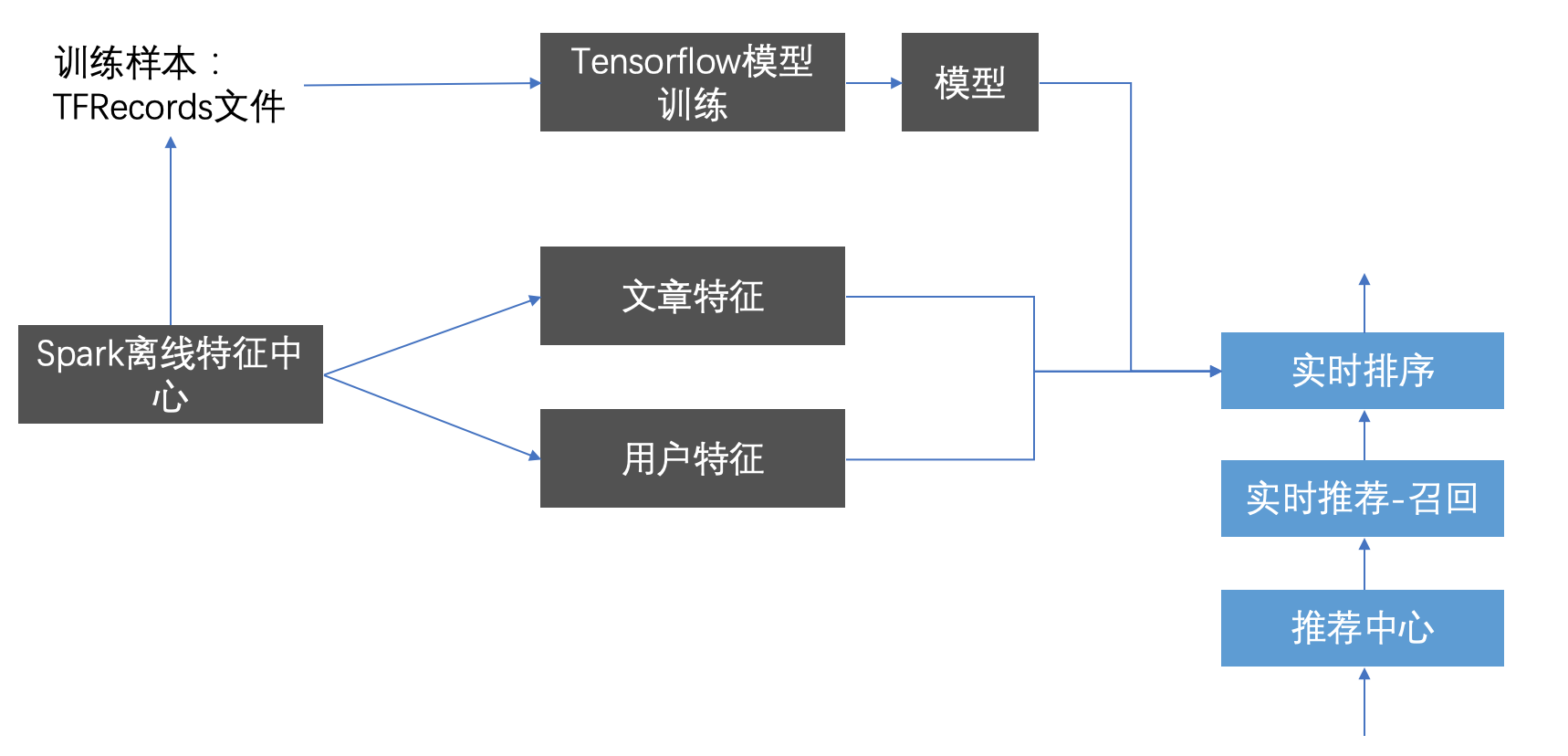

3.6 离线排序模型训练

学习目标

- 目标

- 了解文章CTR预估主要作用

- 知道常见点击率预测的种类和模型

- 知道常见CTR中特征处理方式

- 应用

- 应用spark lr完成模型训练预测评估

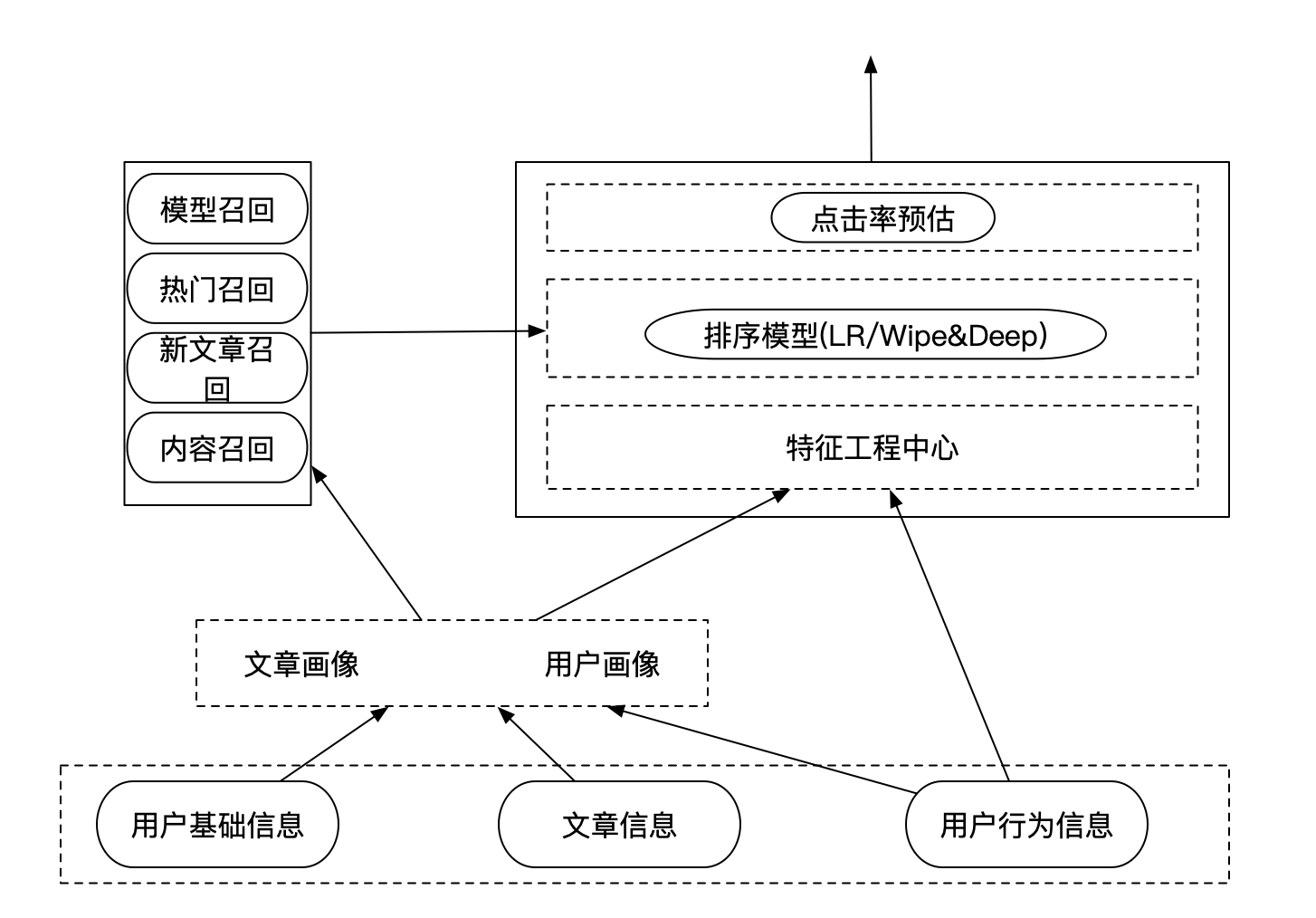

3.6.1 离线排序模型-CTR预估

- CTR(Click-Through Rate)预估:给定一个Item,预测该Item会被点击的概率

- 离线的模型训练:排序的各种模型训练评估

- 特征服务平台:为了提高模型在排序时候的特征读取处理速率,直接将处理好的特征写入HBASE

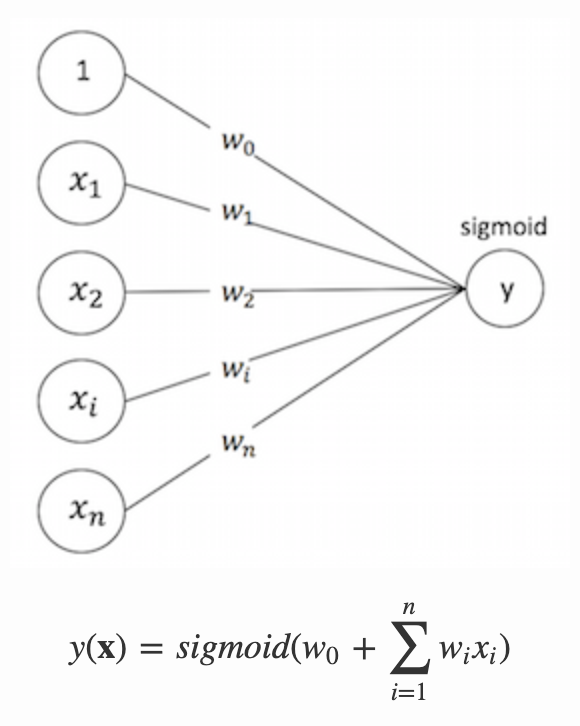

3.6.2 排序模型

最基础的模型目前都是基于LR的点击率预估策略,目前在工业使用模型做预估的有这么几种类型

- 宽模型 + 特征⼯程

- LR/MLR + 非ID类特征(⼈⼯离散/GBDT/FM)

- spark 中可以直接使用

- 宽模型 + 深模型

- wide&deep,DeepFM

- 使用TensorFlow进行训练

- 深模型:

- DNN + 特征embedding

- 使用TensorFlow进行训练

这里使用LR做基本模型使用先,去进行模型的评估,使用模型进行预测

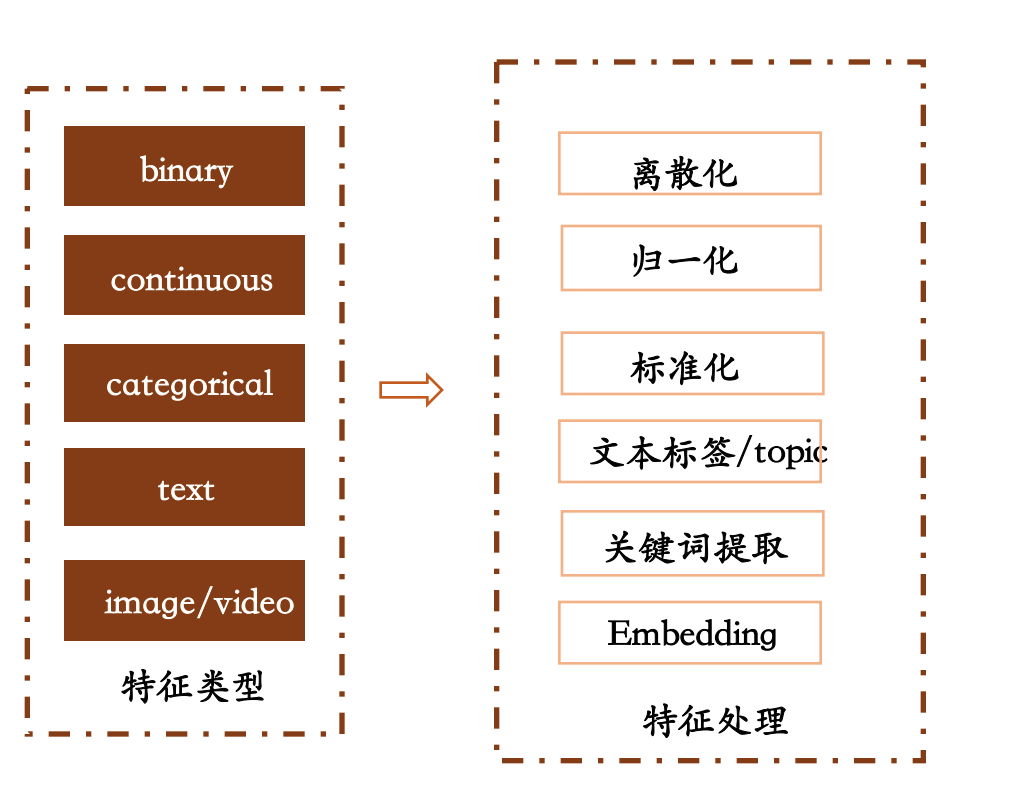

3.6.3 特征处理原则

- 离散数据

- one-hot编码

- 连续数据

- 归一化

- 图片/文本

- 文章标签/关键词提取

- embedding

3.6.4 优化训练方式

- 使用Batch SGD优化

- 加入正则化防止过拟合

3.6.5 spark LR 进行预估

- 目的:通过LR模型进行CTR预估

- 步骤:

- 1、需要通过spark读取HIVE外部表,需要新的sparksession配置

- 增加HBASE配置

- 2、读取用户点击行为表,与用户画像和文章画像,构造训练样本

- 3、LR模型进行训练

- 4、LR模型预测、结果评估

- 1、需要通过spark读取HIVE外部表,需要新的sparksession配置

创建环境

import os

import sys

# 如果当前代码文件运行测试需要加入修改路径,避免出现后导包问题

BASE_DIR = os.path.dirname(os.path.dirname(os.getcwd()))

sys.path.insert(0, os.path.join(BASE_DIR))

PYSPARK_PYTHON = "/miniconda2/envs/reco_sys/bin/python"

# 当存在多个版本时,不指定很可能会导致出错

os.environ["PYSPARK_PYTHON"] = PYSPARK_PYTHON

os.environ["PYSPARK_DRIVER_PYTHON"] = PYSPARK_PYTHON

from pyspark.ml.feature import OneHotEncoder

from pyspark.ml.feature import StringIndexer

from pyspark.ml import Pipeline

from pyspark.sql.types import *

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.classification import LogisticRegression

from pyspark.ml.classification import LogisticRegressionModel

from offline import SparkSessionBase

class CtrLogisticRegression(SparkSessionBase):

SPARK_APP_NAME = "ctrLogisticRegression"

ENABLE_HIVE_SUPPORT = True

def __init__(self):

self.spark = self._create_spark_hbase()

ctr = CtrLogisticRegression()

- 1、这里注意的是_create_spark_hbase,我们后面需要通过spark读取HIVE外部表,需要新的配置

def _create_spark_hbase(self):

conf = SparkConf() # 创建spark config对象

config = (

("spark.app.name", self.SPARK_APP_NAME), # 设置启动的spark的app名称,没有提供,将随机产生一个名称

("spark.executor.memory", self.SPARK_EXECUTOR_MEMORY), # 设置该app启动时占用的内存用量,默认2g

("spark.master", self.SPARK_URL), # spark master的地址

("spark.executor.cores", self.SPARK_EXECUTOR_CORES), # 设置spark executor使用的CPU核心数,默认是1核心

("spark.executor.instances", self.SPARK_EXECUTOR_INSTANCES),

("hbase.zookeeper.quorum", "192.168.19.137"),

("hbase.zookeeper.property.clientPort", "22181")

)

conf.setAll(config)

# 利用config对象,创建spark session

if self.ENABLE_HIVE_SUPPORT:

return SparkSession.builder.config(conf=conf).enableHiveSupport().getOrCreate()

else:

return SparkSession.builder.config(conf=conf).getOrCreate()

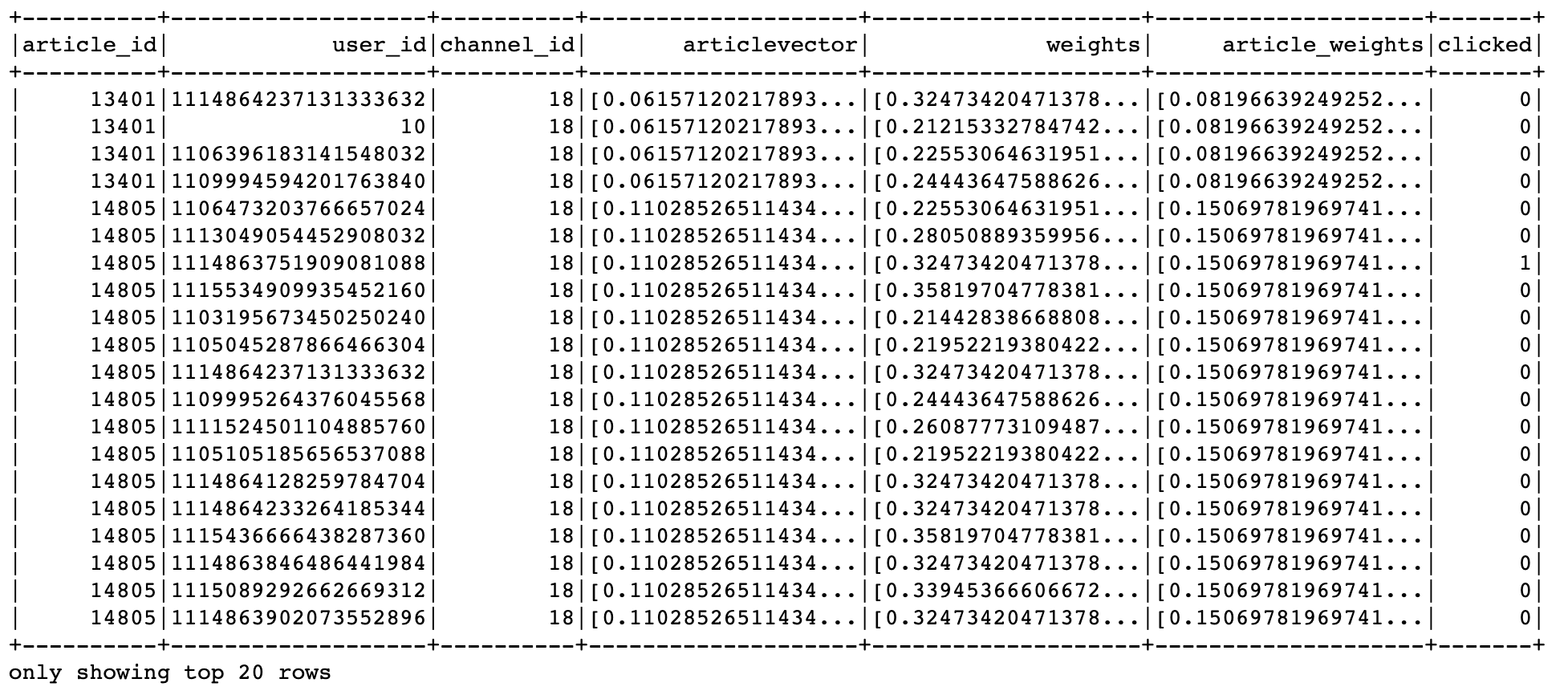

- 2、读取用户点击行为表,与用户画像和文章画像,构造训练样本

- 目标值:clicked

- 特征值:

- 用户画像关键词权重:权重值排序TOPK,这里取10个

- 文章频道号:channel_id, ID类型通常要做one_hot编码,变成25维度(25个频道)

- 这里由于我们的历史点击日志测试时候是只有18号频道,所以不进行转换

- 文章向量:articlevector

- 总共:10 + 1+ 100 = 110

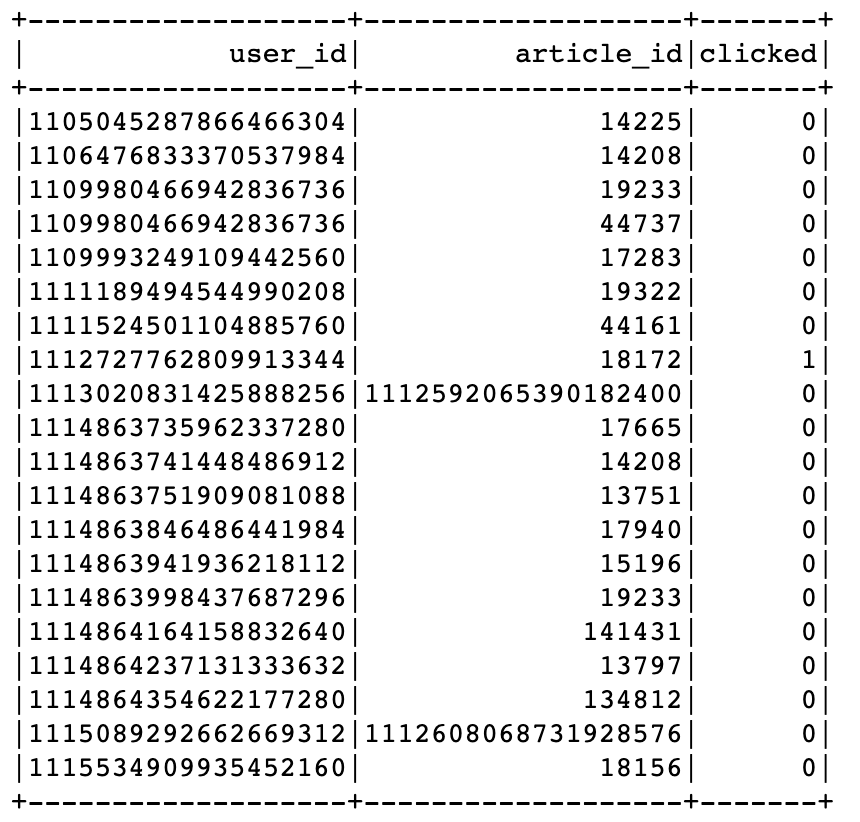

进行行为日志数据读取

ctr.spark.sql("use profile")

# +-------------------+----------+----------+-------+

# | user_id|article_id|channel_id|clicked|

# +-------------------+----------+----------+-------+

# |1105045287866466304| 14225| 0| false|

user_article_basic = ctr.spark.sql("select * from user_article_basic").select(

['user_id', 'article_id', 'channel_id', 'clicked'])

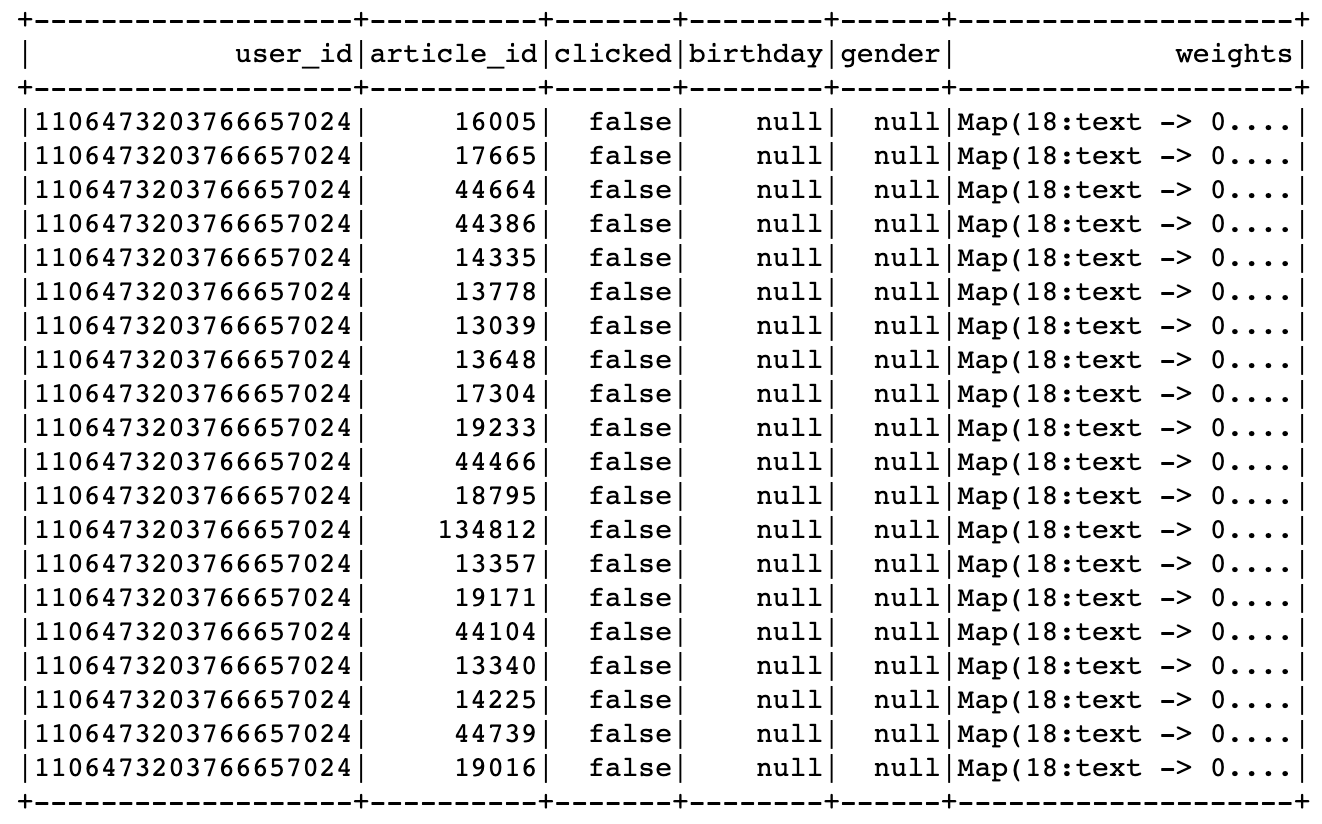

用户画像读取处理与日志数据合并

user_profile_hbase = ctr.spark.sql(

"select user_id, information.birthday, information.gender, article_partial, env from user_profile_hbase")

user_profile_hbase = user_profile_hbase.drop('env')

# +--------------------+--------+------+--------------------+

# | user_id|birthday|gender| article_partial|

# +--------------------+--------+------+--------------------+

# | user:1| 0.0| null|Map(18:Animal -> ...|

_schema = StructType([

StructField("user_id", LongType()),

StructField("birthday", DoubleType()),

StructField("gender", BooleanType()),

StructField("weights", MapType(StringType(), DoubleType()))

])

def get_user_id(row):

return int(row.user_id.split(":")[1]), row.birthday, row.gender, row.article_partial

读取用户画像HIVE的外部表,构造样本

user_profile_hbase_temp = user_profile_hbase.rdd.map(get_user_id)

user_profile_hbase_schema = ctr.spark.createDataFrame(user_profile_hbase_temp, schema=_schema)

train = user_article_basic.join(user_profile_hbase_schema, on=['user_id'], how='left').drop('channel_id')

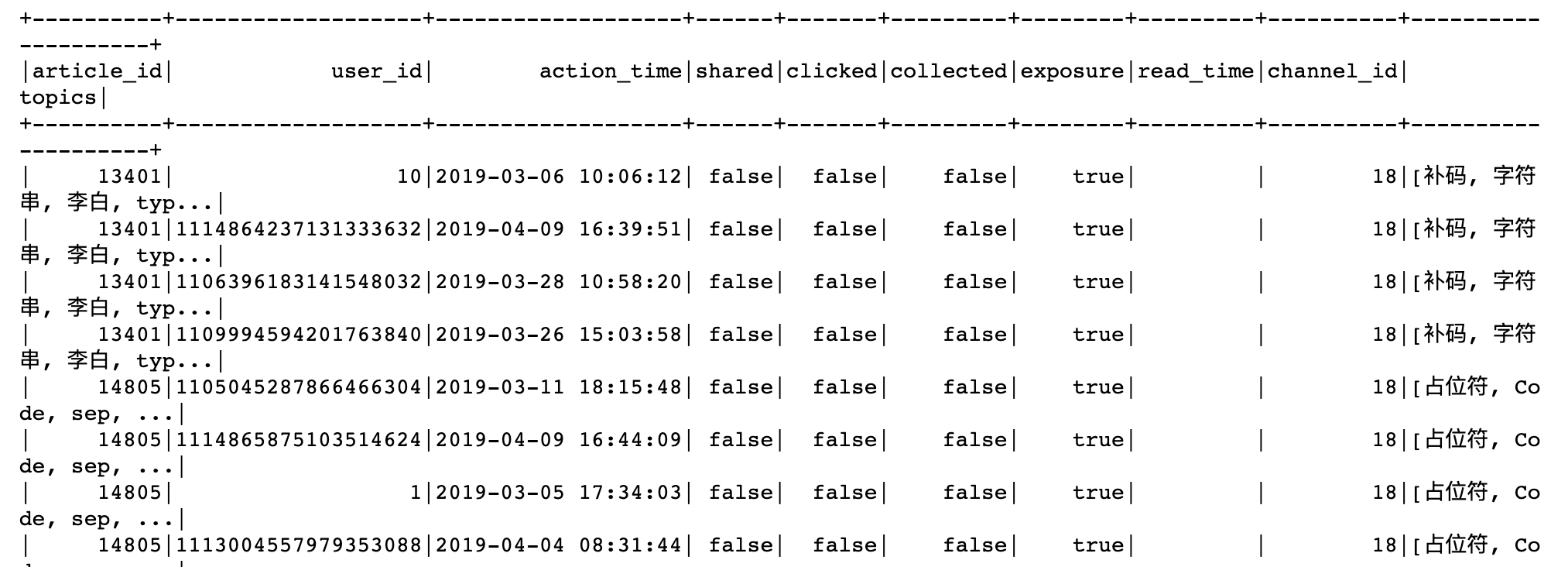

文章频道与向量读取合并,删除无用的特征

- 由于黑马用户信息中,大多数没有相关特征,直接删除

# +-------------------+----------+-------+--------+------+--------------------+

# | user_id|article_id|clicked|birthday|gender| weights|

# +-------------------+----------+-------+--------+------+--------------------+

# |1106473203766657024| 13778| false| 0.0| null|Map(18:text -> 0....|

ctr.spark.sql("use article")

article_vector = ctr.spark.sql("select * from article_vector")

train = train.join(article_vector, on=['article_id'], how='left').drop('birthday').drop('gender')

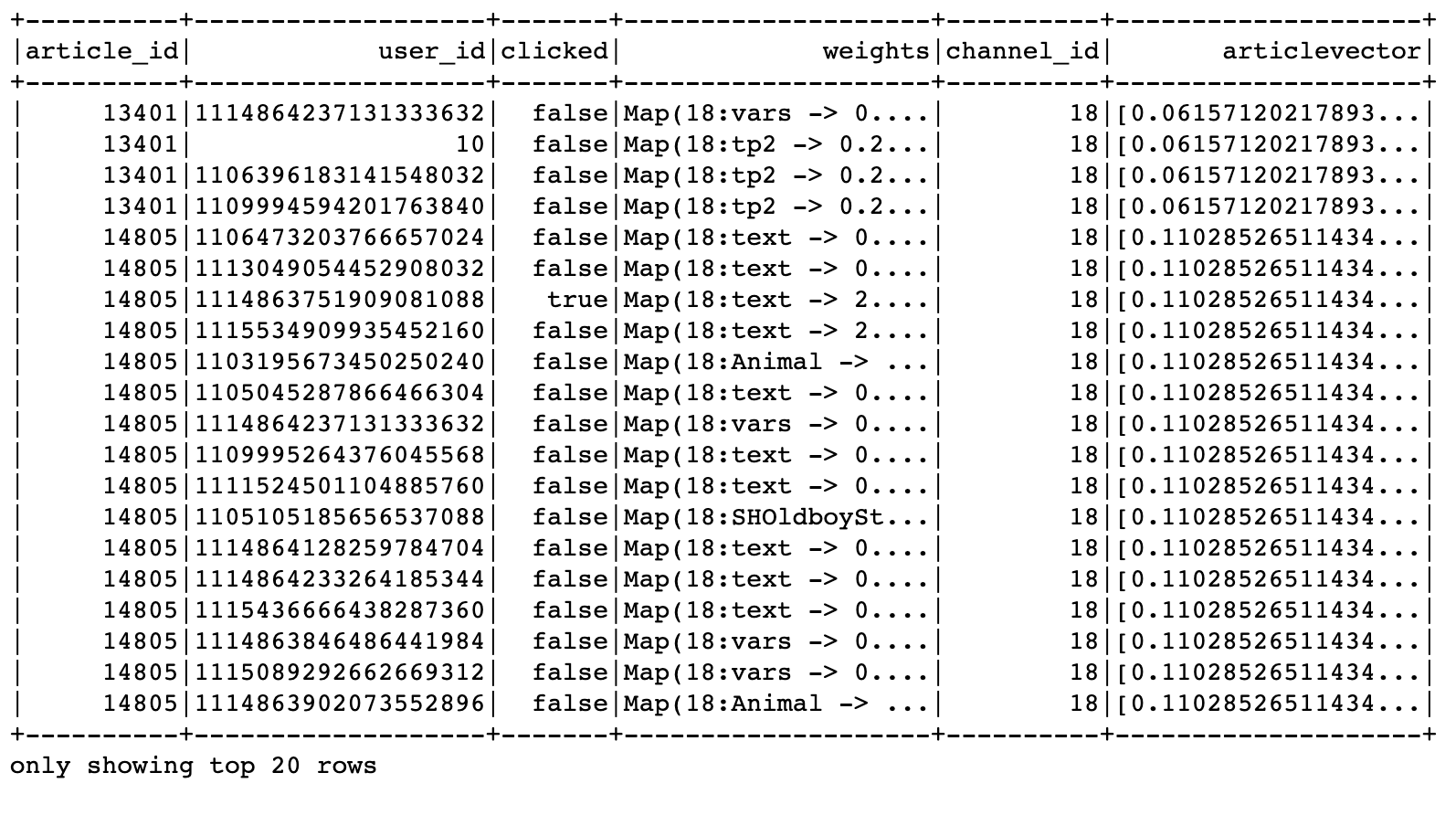

# +-------------------+-------------------+-------+--------------------+----------+--------------------+

# | article_id| user_id|clicked| weights|channel_id| articlevector|

# +-------------------+-------------------+-------+--------------------+----------+--------------------+

# | 13401| 10| false|Map(18:tp2 -> 0.2...| 18|[0.06157120217893...|

合并文章画像的权重特征

ctr.spark.sql("use article")

article_profile = ctr.spark.sql("select * from article_profile")

def article_profile_to_feature(row):

try:

weights = sorted(row.keywords.values())[:10]

except Exception as e:

weights = [0.0] * 10

return row.article_id, weights

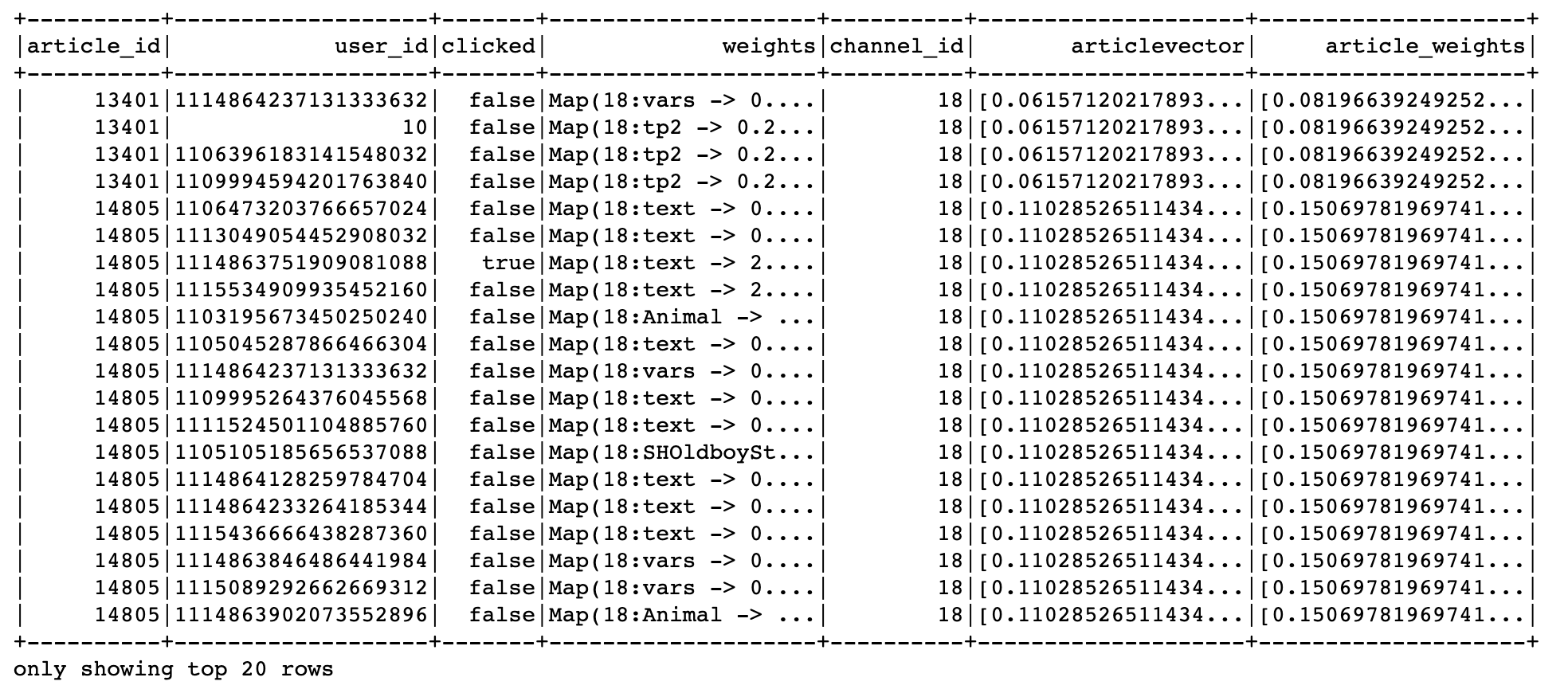

article_profile = article_profile.rdd.map(article_profile_to_feature).toDF(['article_id', 'article_weights'])

article_profile.show()

train = train.join(article_profile, on=['article_id'], how='left')

进行用户的权重特征筛选处理,类型处理

- 用户权重排序筛选,缺失值

- 获取用户对应文章频道号的关键词权重

- 若无:生成默认值

train = train.dropna()

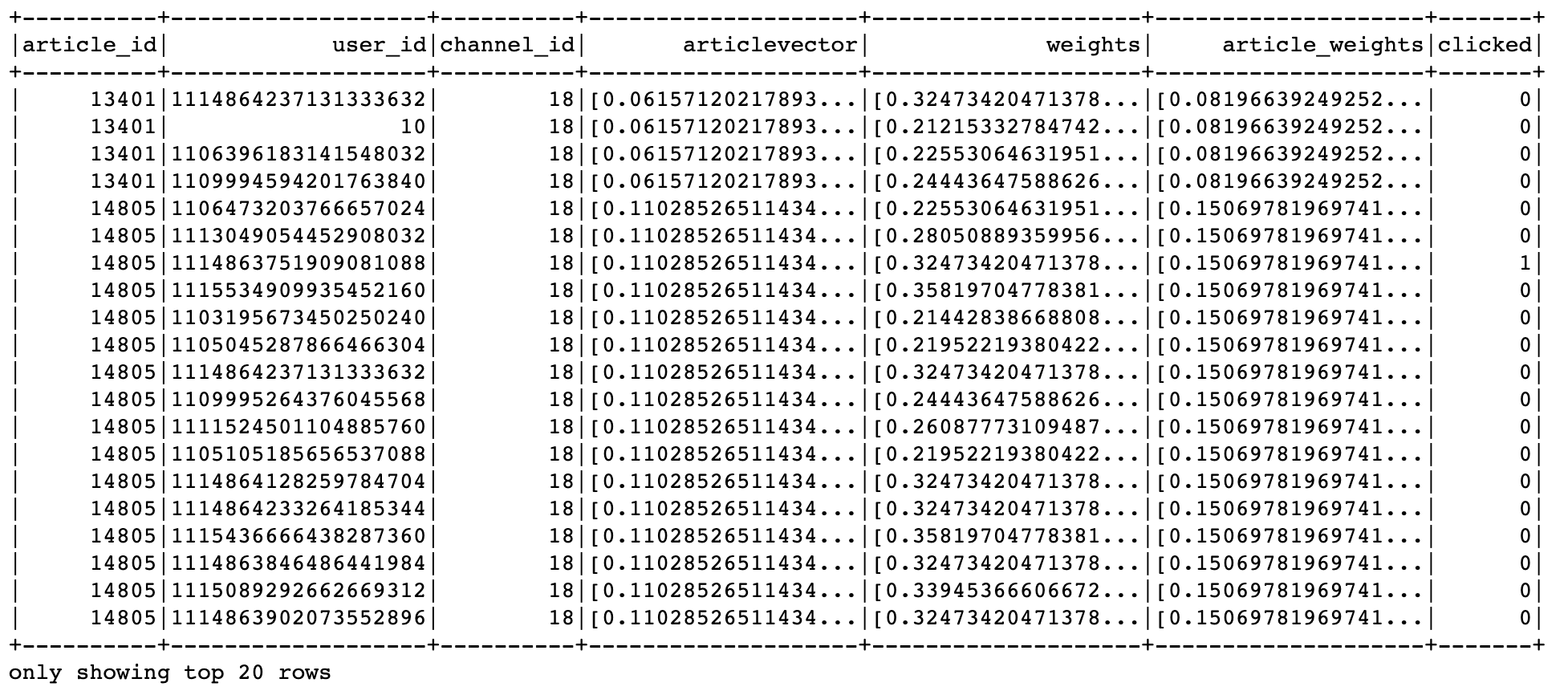

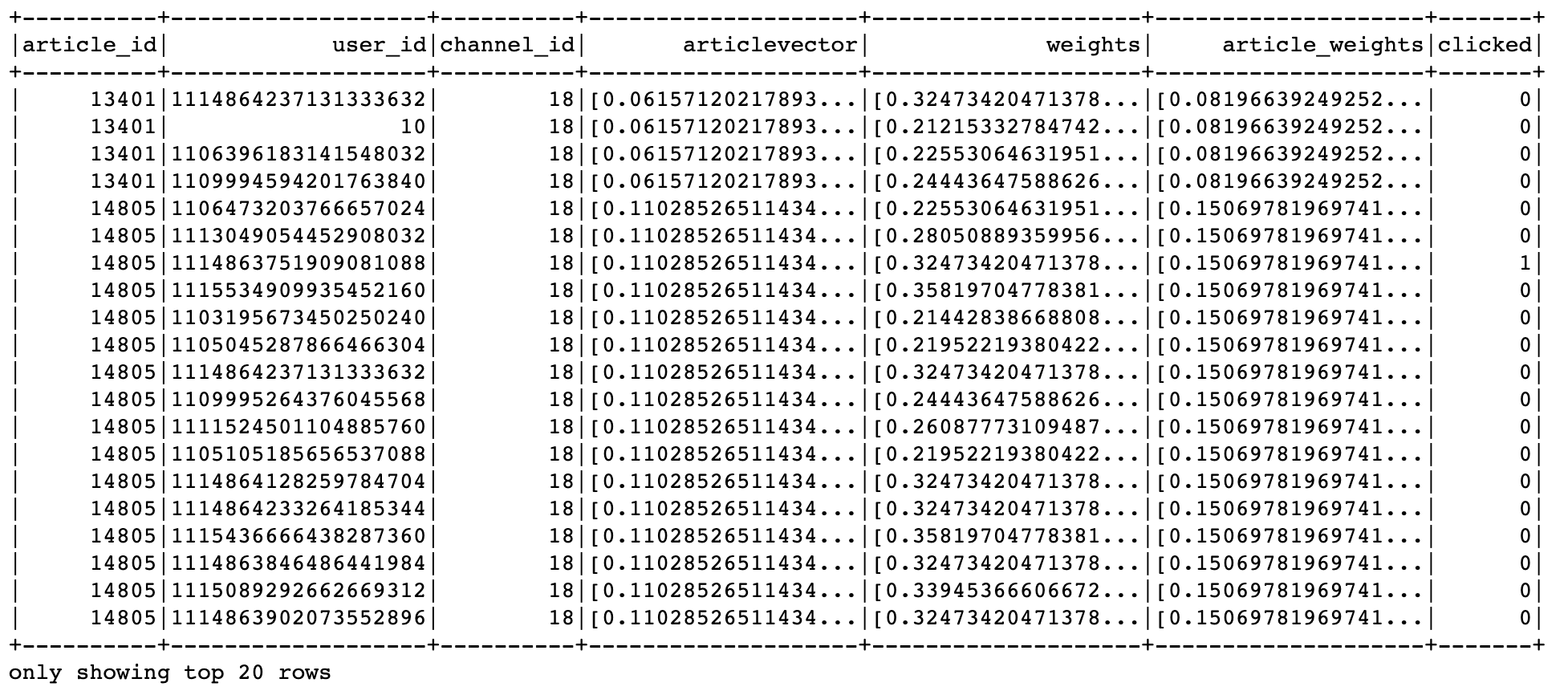

columns = ['article_id', 'user_id', 'channel_id', 'articlevector', 'weights', 'clicked']

def feature_preprocess(row):

from pyspark.ml.linalg import Vectors

try:

weights = sorted([row.weights[key] for key in row.weights.keys() if key[:2] == str(row.channel_id)])[

:10]

except Exception:

weights = [0.0] * 10

return row.article_id, row.user_id, row.channel_id, Vectors.dense(row.articlevector), Vectors.dense(

weights), int(row.clicked)

train = train.rdd.map(feature_preprocess).toDF(columns)

结果:

输入模型的特征格式指定,通过VectorAssembler()收集

cols = ['article_id', 'user_id', 'channel_id', 'articlevector', 'weights', 'article_weights', 'clicked']

train_version_two = VectorAssembler().setInputCols(cols[2:6]).setOutputCol("features").transform(train)

合并特征向量(channel_id1个+用户特征权重10个+文章向量100个+文章关键词权重) = 121个特征

lr = LogisticRegression()

model = lr.setLabelCol("clicked").setFeaturesCol("features").fit(train_version_two)

model.save("hdfs://hadoop-master:9000/headlines/models/lr.obj")

3.6.5 点击率预测结果

使用model模型加载预估

online_model = LogisticRegressionModel.load("hdfs://hadoop-master:9000/headlines/models/CtrLogistic.obj")

res_transfrom = online_model.transform(train_version_two)

res_transfrom.select(["clicked", "probability", "prediction"]).show()

probability结果中有对某个文章点击(1为目标)的概率,和不点击(0为目标)的概率

def vector_to_double(row):

return float(row.clicked), float(row.probability[1])

score_label = res_transfrom.select(["clicked", "probability"]).rdd.map(vector_to_double)

3.6.6 模型评估-Accuracy与AUC

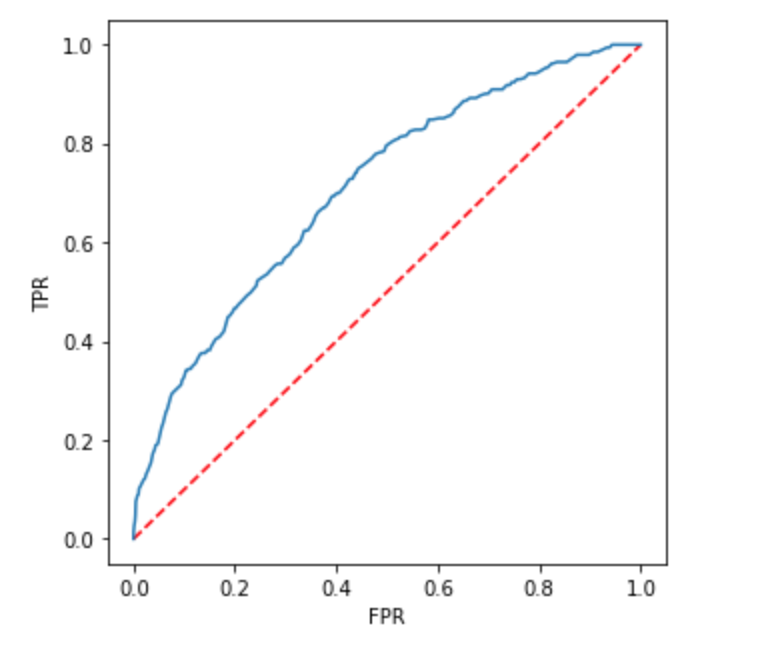

画出ROC图,使用训练的时候的模型model中会有

import matplotlib.pyplot as plt

plt.figure(figsize=(5,5))

plt.plot([0, 1], [0, 1], 'r--')

plt.plot(model.summary.roc.select('FPR').collect(),

model.summary.roc.select('TPR').collect())

plt.xlabel('FPR')

plt.ylabel('TPR')

plt.show()

结果

- from pyspark.mllib.evaluation import BinaryClassificationMetrics

from pyspark.mllib.evaluation import BinaryClassificationMetrics

metrics = BinaryClassificationMetrics(score_label)

metrics.areaUnderROC

0.7364334522585716

其它方法

from sklearn.metrics import roc_auc_score, accuracy_score

import numpy as np

arr = np.array(score_label.collect())

评估AUC与准确率

accuracy_score(arr[:, 0], arr[:, 1].round())

0.9051438053097345

roc_auc_score(arr[:, 0], arr[:, 1])

0.719274521004087

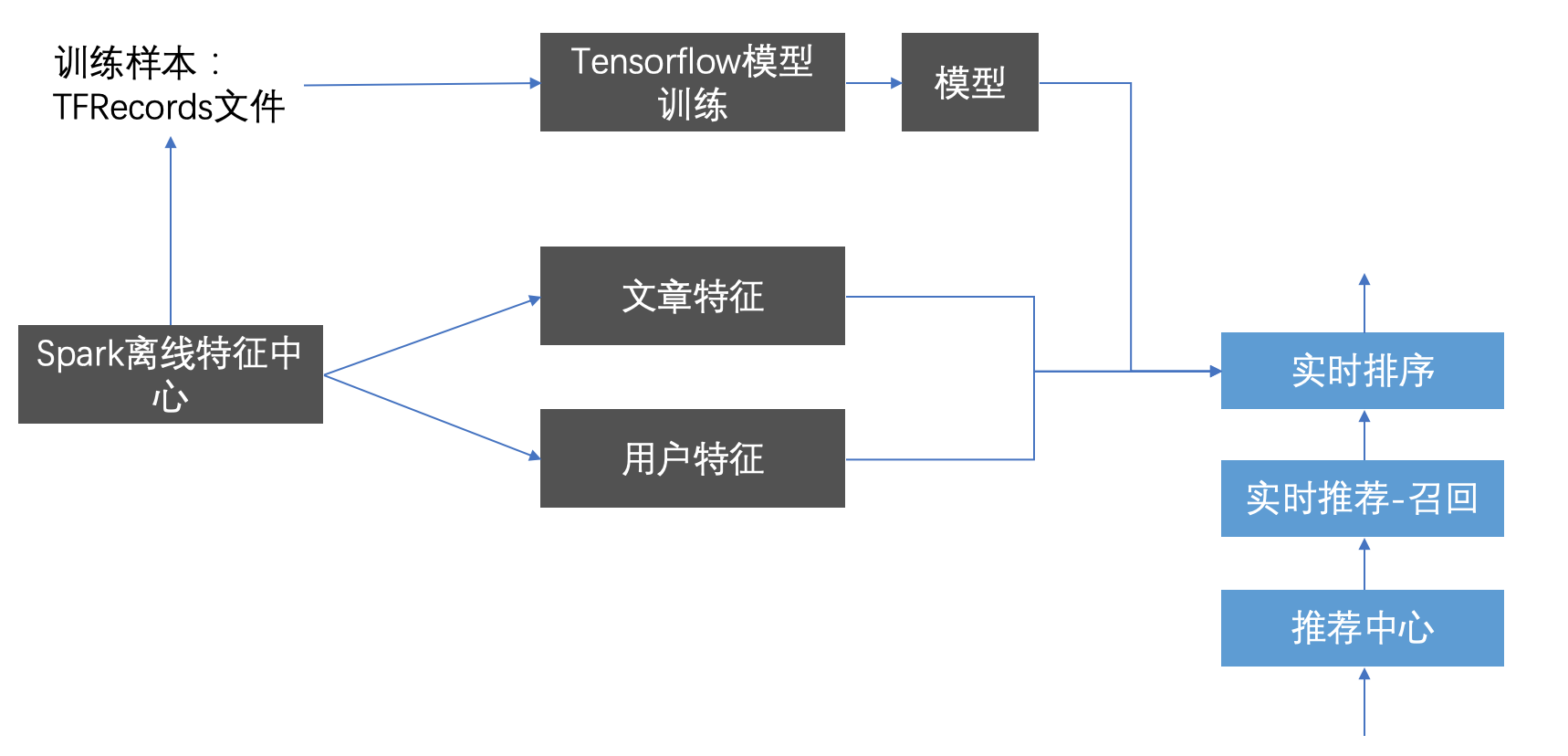

3.8 离线ctr特征中心更新

学习目标

- 目标

- 了解特征服务中心的作用

- 应用

- 无

3.8.1 特征服务中心

特征服务中心可以作为离线计算用户与文章的高级特征,充当着重要的角色。可以为程序提供快速的特征处理与特征结果,而且不仅仅提供给离线使用。还可以作为实时的特征供其他场景读取进行

原则是:用户,文章能用到的特征都进行处理进行存储,便于实时推荐进行读取

- 存储形式

- 存储到数据库HBASE中

- 构造好样本,存储到TFRecords文件给TensorFlow模型训练

首先确定创建特征结果HBASE表:

create 'ctr_feature_user', 'channel'

4 column=channel:13, timestamp=1555647172980, value=[]

4 column=channel:14, timestamp=1555647172980, value=[]

4 column=channel:15, timestamp=1555647172980, value=[]

4 column=channel:16, timestamp=1555647172980, value=[]

4 column=channel:18, timestamp=1555647172980, value=[0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073, 0.2156294170196073]

4 column=channel:19, timestamp=1555647172980, value=[]

4 column=channel:20, timestamp=1555647172980, value=[]

4 column=channel:2, timestamp=1555647172980, value=[]

4 column=channel:21, timestamp=1555647172980, value=[]

create 'ctr_feature_article', 'article'

COLUMN CELL

article:13401 timestamp=1555635749357, value=[18.0,0.08196639249252607,0.11217275332895373,0.1353835167902181,0.16086650318453152,0.16356418791892943,0.16740082750337945,0.18091837445730974,0.1907214431716628,0.2........................-0.04634634410271921,-0.06451843378804649,-0.021564142420785692,0.10212902152136256]

创建HIVE外部表,

create external table ctr_feature_user_hbase(

user_id STRING comment "user_id",

user_channel map comment "user_channel")

COMMENT "ctr table"

STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,channel:")

TBLPROPERTIES ("hbase.table.name" = "ctr_feature_user");

create external table ctr_feature_article_hbase(

article_id STRING comment "article_id",

article_feature map comment "article")

COMMENT "ctr table"

STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,article:")

TBLPROPERTIES ("hbase.table.name" = "ctr_feature_article");

3.8.2 用户特征中心更新

- 目的:计算用户特征更新到HBASE

- 步骤:

- 获取特征进行用户画像权重过滤

- 特征批量存储

获取特征进行用户画像权重过滤

# 构造样本

ctr.spark.sql("use profile")

user_profile_hbase = ctr.spark.sql(

"select user_id, information.birthday, information.gender, article_partial, env from user_profile_hbase")

# 特征工程处理

# 抛弃获取值少的特征

user_profile_hbase = user_profile_hbase.drop('env', 'birthday', 'gender')

def get_user_id(row):

return int(row.user_id.split(":")[1]), row.article_partial

user_profile_hbase_temp = user_profile_hbase.rdd.map(get_user_id)

from pyspark.sql.types import *

_schema = StructType([

StructField("user_id", LongType()),

StructField("weights", MapType(StringType(), DoubleType()))

])

user_profile_hbase_schema = ctr.spark.createDataFrame(user_profile_hbase_temp, schema=_schema)

def frature_preprocess(row):

from pyspark.ml.linalg import Vectors

channel_weights = []

for i in range(1, 26):

try:

_res = sorted([row.weights[key] for key

in row.weights.keys() if key.split(':')[0] == str(i)])[:10]

channel_weights.append(_res)

except:

channel_weights.append([0.0] * 10)

return row.user_id, channel_weights

res = user_profile_hbase_schema.rdd.map(frature_preprocess).collect()

特征批量存储,保存用户每个频道的特征

import happybase

# 批量插入Hbase数据库中

pool = happybase.ConnectionPool(size=10, host='hadoop-master', port=9090)

with pool.connection() as conn:

ctr_feature = conn.table('ctr_feature_user')

with ctr_feature.batch(transaction=True) as b:

for i in range(len(res)):

for j in range(25):

b.put("{}".format(res[i][0]).encode(),{"channel:{}".format(j+1).encode(): str(res[i][1][j]).encode()})

conn.close()

3.8.2 文章特征中心更新

文章特征有哪些?

- 关键词权重

- 文章的频道

- 文章向量结果

存储这些特征以便于后面实时排序时候快速使用特征

- 步骤:

- 1、读取相关文章画像

- 2、进行文章相关特征处理和提取

- 3、合并文章所有特征作为模型训练或者预测的初始特征

- 4、文章特征存储到HBASE

读取相关文章画像

ctr.spark.sql("use article")

article_profile = ctr.spark.sql("select * from article_profile")

进行文章相关特征处理和提取

def article_profile_to_feature(row):

try:

weights = sorted(row.keywords.values())[:10]

except Exception as e:

weights = [0.0] * 10

return row.article_id, row.channel_id, weights

article_profile = article_profile.rdd.map(article_profile_to_feature).toDF(['article_id', 'channel_id', 'weights'])

article_profile.show()

article_vector = ctr.spark.sql("select * from article_vector")

article_feature = article_profile.join(article_vector, on=['article_id'], how='inner')

def feature_to_vector(row):

from pyspark.ml.linalg import Vectors

return row.article_id, row.channel_id, Vectors.dense(row.weights), Vectors.dense(row.articlevector)

article_feature = article_feature.rdd.map(feature_to_vector).toDF(['article_id', 'channel_id', 'weights', 'articlevector'])

指定所有文章特征进行合并

# 保存特征数据

cols2 = ['article_id', 'channel_id', 'weights', 'articlevector']

# 做特征的指定指定合并

article_feature_two = VectorAssembler().setInputCols(cols2[1:4]).setOutputCol("features").transform(article_feature)

结果:

+----------+----------+--------------------+--------------------+--------------------+

|article_id|channel_id| weights| articlevector| features|

+----------+----------+--------------------+--------------------+--------------------+

| 26| 17|[0.19827163395829...|[0.02069368539384...|[17.0,0.198271633...|

| 29| 17|[0.26031398249056...|[-0.1446092289546...|[17.0,0.260313982...|

| 474| 17|[0.49818598558926...|[0.17293323921293...|[17.0,0.498185985...|

| 1677| 17|[0.19827339246090...|[-0.1303829028565...|[17.0,0.198273392...|

| 1697| 6|[0.25105539265038...|[0.05229978313861...|[6.0,0.2510553926...|

| 1806| 17|[0.18449119772340...|[0.02166337053188...|[17.0,0.184491197...|

| 1950| 17|[0.33331407122173...|[-0.3318378543653...|[17.0,0.333314071...|

| 2040| 17|[0.38583431341698...|[-0.0164312324191...|[17.0,0.385834313...|

| 2250| 6|[0.46477621366740...|[-0.0597617824653...|[6.0,0.4647762136...|

| 2453| 13|[0.50514620188273...|[-0.1038588426578...|[13.0,0.505146201...|

| 2509| 13|[0.15138306650944...|[0.04533940468085...|[13.0,0.151383066...|

| 2529| 17|[0.11634963900866...|[0.02575729180313...|[17.0,0.116349639...|

| 2927| 6|[0.28513034617795...|[0.09066218648052...|[6.0,0.2851303461...|

| 3091| 6|[0.23478830492918...|[0.08091488655859...|[6.0,0.2347883049...|

| 3506| 17|[0.22844780420769...|[0.08157531127196...|[17.0,0.228447804...|

| 3764| 15|[0.27265314149033...|[-0.1795835048850...|[15.0,0.272653141...|

| 4590| 19|[0.40296288036812...|[0.07013928253496...|[19.0,0.402962880...|

| 4823| 19|[0.21729897161021...|[0.04938335582130...|[19.0,0.217298971...|

| 4894| 19|[0.11699953656531...|[0.04255864598683...|[19.0,0.116999536...|

| 5385| 15|[0.34743921088686...|[0.10922433026109...|[15.0,0.347439210...|

+----------+----------+--------------------+--------------------+--------------------+

only showing top 20 rows

保存到特征数据库中

# 保存到特征数据库中

def save_article_feature_to_hbase(partition):

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master')

with pool.connection() as conn:

table = conn.table('ctr_feature_article')

for row in partition:

table.put('{}'.format(row.article_id).encode(),

{'article:{}'.format(row.article_id).encode(): str(row.features).encode()})

article_feature_two.foreachPartition(save_article_feature_to_hbase)

3.8.3 离线特征中心定时更新

添加update.py更新程序

def update_ctr_feature():

"""

定时更新用户、文章特征

:return:

"""

fp = FeaturePlatform()

fp.update_user_ctr_feature_to_hbase()

fp.update_article_ctr_feature_to_hbase()

添加apscheduler定时运行

# 添加定时更新用户文章特征结果的程序,每个4小时更新一次

scheduler.add_job(update_ctr_feature, trigger='interval', hours=4)

完整代码:

import os

import sys

# 如果当前代码文件运行测试需要加入修改路径,否则后面的导包出现问题

BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__)))

sys.path.insert(0, os.path.join(BASE_DIR))

from offline import SparkSessionBase

# from offline.utils import textrank, segmentation

import happybase

import pyspark.sql.functions as F

from datetime import datetime

from datetime import timedelta

import time

import gc

class FeaturePlatform(SparkSessionBase):

"""特征更新平台

"""

SPARK_APP_NAME = "featureCenter"

ENABLE_HIVE_SUPPORT = True

def __init__(self):

# _create_spark_session

# _create_spark_hbase用户spark sql 操作hive对hbase的外部表

self.spark = self._create_spark_hbase()

def update_user_ctr_feature_to_hbase(self):

"""

:return:

"""

clr.spark.sql("use profile")

user_profile_hbase = self.spark.sql(

"select user_id, information.birthday, information.gender, article_partial, env from user_profile_hbase")

# 特征工程处理

# 抛弃获取值少的特征

user_profile_hbase = user_profile_hbase.drop('env', 'birthday', 'gender')

def get_user_id(row):

return int(row.user_id.split(":")[1]), row.article_partial

user_profile_hbase_temp = user_profile_hbase.rdd.map(get_user_id)

from pyspark.sql.types import *

_schema = StructType([

StructField("user_id", LongType()),

StructField("weights", MapType(StringType(), DoubleType()))

])

user_profile_hbase_schema = self.spark.createDataFrame(user_profile_hbase_temp, schema=_schema)

def frature_preprocess(row):

from pyspark.ml.linalg import Vectors

channel_weights = []

for i in range(1, 26):

try:

_res = sorted([row.weights[key] for key

in row.weights.keys() if key.split(':')[0] == str(i)])[:10]

channel_weights.append(_res)

except:

channel_weights.append([])

return row.user_id, channel_weights

res = user_profile_hbase_schema.rdd.map(frature_preprocess).collect()

# 批量插入Hbase数据库中

pool = happybase.ConnectionPool(size=10, host='hadoop-master', port=9090)

with pool.connection() as conn:

ctr_feature = conn.table('ctr_feature_user')

with ctr_feature.batch(transaction=True) as b:

for i in range(len(res)):

for j in range(25):

b.put("{}".format(res[i][0]).encode(),

{"channel:{}".format(j + 1).encode(): str(res[i][1][j]).encode()})

conn.close()

def update_article_ctr_feature_to_hbase(self):

"""

:return:

"""

# 文章特征中心

self.spark.sql("use article")

article_profile = self.spark.sql("select * from article_profile")

def article_profile_to_feature(row):

try:

weights = sorted(row.keywords.values())[:10]

except Exception as e:

weights = [0.0] * 10

return row.article_id, row.channel_id, weights

article_profile = article_profile.rdd.map(article_profile_to_feature).toDF(

['article_id', 'channel_id', 'weights'])

article_vector = self.spark.sql("select * from article_vector")

article_feature = article_profile.join(article_vector, on=['article_id'], how='inner')

def feature_to_vector(row):

from pyspark.ml.linalg import Vectors

return row.article_id, row.channel_id, Vectors.dense(row.weights), Vectors.dense(row.articlevector)

article_feature = article_feature.rdd.map(feature_to_vector).toDF(

['article_id', 'channel_id', 'weights', 'articlevector'])

# 保存特征数据

cols2 = ['article_id', 'channel_id', 'weights', 'articlevector']

# 做特征的指定指定合并

article_feature_two = VectorAssembler().setInputCols(cols2[1:4]).setOutputCol("features").transform(

article_feature)

# 保存到特征数据库中

def save_article_feature_to_hbase(partition):

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master')

with pool.connection() as conn:

table = conn.table('ctr_feature_article')

for row in partition:

table.put('{}'.format(row.article_id).encode(),

{'article:{}'.format(row.article_id).encode(): str(row.features).encode()})

article_feature_two.foreachPartition(save_article_feature_to_hbase)

to_hbase(self):

"""

:return:

"""

# 文章特征中心

self.spark.sql("use article")

article_profile = self.spark.sql("select * from article_profile")

def article_profile_to_feature(row):

try:

weights = sorted(row.keywords.values())[:10]

except Exception as e:

weights = [0.0] * 10

return row.article_id, row.channel_id, weights

article_profile = article_profile.rdd.map(article_profile_to_feature).toDF(

['article_id', 'channel_id', 'weights'])

article_vector = self.spark.sql("select * from article_vector")

article_feature = article_profile.join(article_vector, on=['article_id'], how='inner')

def feature_to_vector(row):

from pyspark.ml.linalg import Vectors

return row.article_id, row.channel_id, Vectors.dense(row.weights), Vectors.dense(row.articlevector)

article_feature = article_feature.rdd.map(feature_to_vector).toDF(

['article_id', 'channel_id', 'weights', 'articlevector'])

# 保存特征数据

cols2 = ['article_id', 'channel_id', 'weights', 'articlevector']

# 做特征的指定指定合并

article_feature_two = VectorAssembler().setInputCols(cols2[1:4]).setOutputCol("features").transform(

article_feature)

# 保存到特征数据库中

def save_article_feature_to_hbase(partition):

import happybase

pool = happybase.ConnectionPool(size=10, host='hadoop-master')

with pool.connection() as conn:

table = conn.table('ctr_feature_article')

for row in partition:

table.put('{}'.format(row.article_id).encode(),

{'article:{}'.format(row.article_id).encode(): str(row.features).encode()})

article_feature_two.foreachPartition(save_article_feature_to_hbase)

1054

1054

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?