导读:这篇是1999 年Richard Sutton 在强化学习领域中的经典论文,论文证明了策略梯度定理和在用函数近似 Q 值时策略梯度定理依然成立,本论文奠定了后续以深度强化学习策略梯度方法的基石。理解熟悉本论文对 Policy Gradient,Actor Critic 方法有很好的指导意义。

导读:这篇是1999 年Richard Sutton 在强化学习领域中的经典论文,论文证明了策略梯度定理和在用函数近似 Q 值时策略梯度定理依然成立,本论文奠定了后续以深度强化学习策略梯度方法的基石。理解熟悉本论文对 Policy Gradient,Actor Critic 方法有很好的指导意义。

论文分成四部分。第一部分指出策略梯度在两种期望回报定义下都成立(定理一)。第二部分提出,如果 被函数 近似时且满足兼容(compatible)条件,以 替换策略梯度中的 公式也成立(定理二)。第三部分举Gibbs分布的策略为例,如何应用 近似函数来实现策略梯度算法。第四部分证明了近似函数的策略梯度迭代法一定能收敛到局部最优解。附录部分证明了两种定义下的策略梯度定理。

1. 策略梯度定理

对于Agent和环境而言,可以分成episode和non-episode,后者的时间步骤可以趋近于无穷大,但一般都可以适用两种期望回报定义。一种是单步平均reward ,另一种是指定唯一开始状态并对trajectory求 -discounted 之和,称为开始状态定义。两种定义都考虑到了reward的sum会趋近于无穷大,并通过不同的方式降低了此问题的概率。

A. 平均reward定义

目标函数 定义成单步的平均reward,这种情况下等价于稳定状态分布下期望值。

稳定状态分布定义成无限次数后状态的分布。

此时, 定义为无限步的reward sum 减去累积的单步平均 reward ,这里减去 是为了一定程度防止 没有上界。

B. 开始状态定义

在开始状态定义方式中,某指定状态 作为起始状态, 的定义为 trajectory 的期望回报,注意由于时间步骤 t 趋近于无穷大,必须要乘以discount 系数 保证期望不会趋近无穷大。

也直接定义成 trajectory 的期望回报。

依然为无限次数后状态的稳定分布。

依然为无限次数后状态的稳定分布。

策略梯度定理

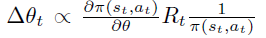

论文指出上述两种定义都满足策略梯度定理,即目标 对于参数 的偏导不依赖于 对于 偏导,仅取决

关于策略梯度定理的一些综述,可以参考

深度强化学习之:Policy Gradient Theorem 综述。

关于策略梯度定理的一些综述,可以参考

深度强化学习之:Policy Gradient Theorem 综述。

论文中还提到策略梯度定理公式和经典的William REINFORCE算法之间的联系。REINFORCE算法即策略梯度的蒙特卡洛实现。

联系如下:

首先,根据策略梯度定理,如果状态 s 是通过 采样得到,则下式是 的无偏估计。注意,这里action的summation和 是无关的。

在William REINFORCE算法中,采用

作为

的近似,但是

取决于 on-policy

的动作分布,因此必须除掉

项,去除引入

后导致oversample动作空间。

在William REINFORCE算法中,采用

作为

的近似,但是

取决于 on-policy

的动作分布,因此必须除掉

项,去除引入

后导致oversample动作空间。

2. 函数近似的策略梯度

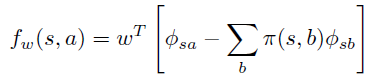

论文第二部分,进一步引入 的近似函数 : 。

如果我们有 的无偏估计,例如 ,很自然,可以让 通过最小化 和 之间的差距来计算。

当拟合过程收敛到局部最优时,策略梯度定理中右边项对于 求导为0,可得(3)式。

至此,引出策略梯度定理的延续,即定理2:当 满足(3)式同时满足(4)式(称为compatible条件时),可以用 替换原策略梯度中的

3. 一个应用示例

假设一个策略用features的线性组合后的 Gibbs分布来生成,即:

注意, 和 都是 维的。当 满足compatible 条件,由公式(4)可得

注意, 也是 维。 可以很自然的参数化为

即

和 策略

一样是features的线性关系。当然

还满足对于所有状态,在

动作分布下均值为0。

即

和 策略

一样是features的线性关系。当然

还满足对于所有状态,在

动作分布下均值为0。

上式和advantage 函数

定义一致,因此可以认为

的意义是

的近似。

上式和advantage 函数

定义一致,因此可以认为

的意义是

的近似。

具体定义如下

4. 函数近似的策略梯度收敛性证明

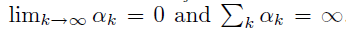

这一部分证明了在满足一定条件后, 可以收敛到局部最优点。

条件为

Compatible 条件,公式(4)

任意两个 偏导是有限的,即

3. 步长数列满足如下条件

3. 步长数列满足如下条件

4. 环境的 reward 是有限的

4. 环境的 reward 是有限的

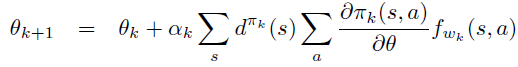

此时,当 和 按如下方式迭代一定能收敛到局部最优。

收敛到局部最优,即

5. 策略梯度定理的两种情况下的证明

下面简单分解策略梯度的证明步骤。

A. 平均reward 定义下的证明

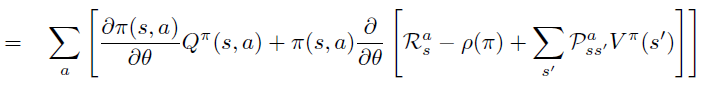

根据定义,将

导数放入求和号中,并分别对乘积中的每项求导。

根据定义,将

导数放入求和号中,并分别对乘积中的每项求导。

将

的定义代入第二项

对

求偏导中,引入环境reward 随机变量

,环境dynamics

和

将

的定义代入第二项

对

求偏导中,引入环境reward 随机变量

,环境dynamics

和

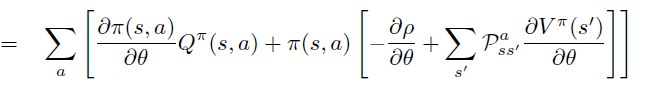

偏导进一步移入,

,

不依赖于

。

偏导进一步移入,

,

不依赖于

。

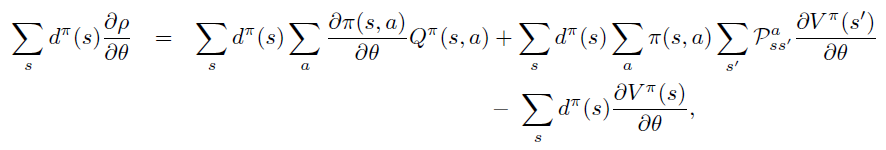

对于

偏导整理到等式左边

对于

偏导整理到等式左边

两边同时乘以

两边同时乘以

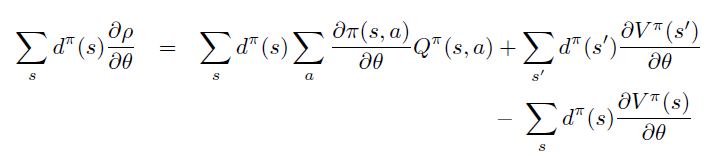

由于

是状态在

下的平稳分布,

项表示 agent 主观

和环境客观

对于状态分布的影响,因此可以直接去除。

由于

是状态在

下的平稳分布,

项表示 agent 主观

和环境客观

对于状态分布的影响,因此可以直接去除。

整理证得。

整理证得。

B. Start-state 定义下的证明

根据定义,将

导数放入求和号中,并分别对乘积中的每项求导。

根据定义,将

导数放入求和号中,并分别对乘积中的每项求导。

将

的定义代入第二项

对

求偏导中,引入环境reward 随机变量

,环境dynamics

将

的定义代入第二项

对

求偏导中,引入环境reward 随机变量

,环境dynamics

偏导进一步移入,

,

不依赖于

。注意,此式表示从状态

出发一步之后的能到达的所有

,将次式反复unroll

成

之后得到

偏导进一步移入,

,

不依赖于

。注意,此式表示从状态

出发一步之后的能到达的所有

,将次式反复unroll

成

之后得到

表示 k 步后 状态 s 能到达的所有状态 x

表示 k 步后 状态 s 能到达的所有状态 x

根据定义,

根据定义,

将

替换成unroll 成

的表达式

将

替换成unroll 成

的表达式

即

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

往期精彩回顾

适合初学者入门人工智能的路线及资料下载机器学习及深度学习笔记等资料打印机器学习在线手册深度学习笔记专辑《统计学习方法》的代码复现专辑

AI基础下载机器学习的数学基础专辑

获取本站知识星球优惠券,复制链接直接打开:

https://t.zsxq.com/qFiUFMV

本站qq群704220115。

加入微信群请扫码:

这篇1999年的经典论文深入探讨了强化学习中的策略梯度定理,证明了在平均reward和开始状态定义下策略梯度定理的成立,并介绍了函数近似在策略梯度中的应用。论文展示了如何使用线性组合的Gibbs分布策略,并证明了在特定条件下,近似策略梯度算法能够收敛到局部最优解。

这篇1999年的经典论文深入探讨了强化学习中的策略梯度定理,证明了在平均reward和开始状态定义下策略梯度定理的成立,并介绍了函数近似在策略梯度中的应用。论文展示了如何使用线性组合的Gibbs分布策略,并证明了在特定条件下,近似策略梯度算法能够收敛到局部最优解。

823

823

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?