😎 作者介绍:我是程序员行者孙,一个热爱分享技术的制能工人。计算机本硕,人工制能研究生。公众号:AI Sun,视频号:AI-行者Sun

🎈 本文专栏:本文收录于《音视频》系列专栏,相信一份耕耘一份收获,我会分享音视频相关学习内容,不说废话,祝大家都offer拿到手软

🤓 欢迎大家关注其他专栏,我将分享Web前后端开发、人工智能、机器学习、深度学习从0到1系列文章。

🖥随时欢迎您跟我沟通,一起交流,一起成长、进步!

音视频同步的关键:深入解析PTS和DTS

在多媒体播放和处理领域,音视频同步是保证用户体验的关键因素。而在这个过程中,PTS(Presentation Time Stamp)和DTS(Decoding Time Stamp)起着至关重要的作用。本文将深入解析这两个概念,并探讨它们在音视频同步中的作用和联系。

视频的播放过程可以简单理解为一帧一帧的画面按照时间顺序呈现出来的过程,就像在一个本子的每一页画上画,然后快速翻动的感觉。

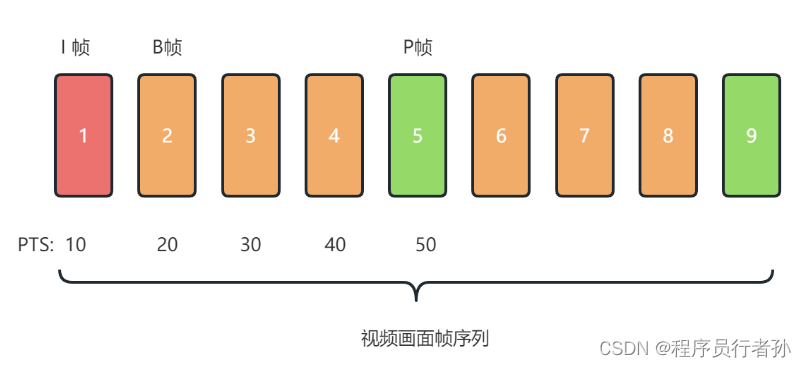

但是在实际应用中,并不是每一帧都是完整的画面,因为如果每一帧画面都是完整的图片,那么一个视频的体积就会很大,这样对于网络传输或者视频数据存储来说成本太高,所以通常会对视频流中的一部分画面进行压缩(编码)处理。由于压缩处理的方式不同,视频中的画面帧就分为了不同的类别,其中包括:I 帧、P 帧、B 帧。

具体IPB帧的介绍看这里:深入解析视频编码中的IPB帧

什么是PTS和DTS?

PTS(显示时间戳)

PTS是音视频帧应该被显示或播放的时间戳。它确保了在播放过程中,无论是视频帧还是音频帧,都能在正确的时间点呈现给用户,保持音视频的同步性。例如,在视频播放中,PTS会指示每个帧在何时显示,以维持连贯的视觉体验。

DTS(解码时间戳)

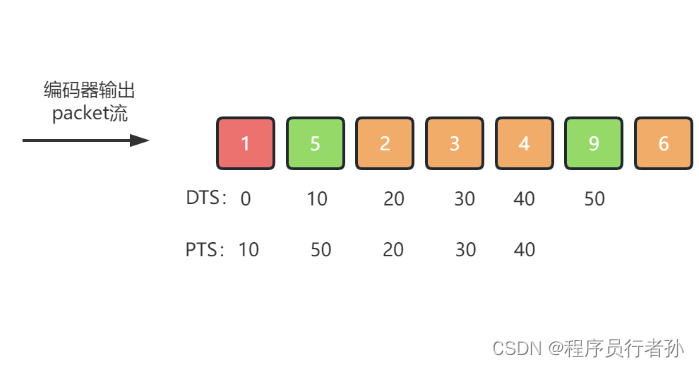

DTS是音视频帧应该被解码的时间戳。由于一些编码格式可能会对帧进行重新排序,解码顺序可能与显示顺序不一致。DTS确保解码器能够按照正确的顺序解码帧,特别是在处理需要重新排序的编码格式时,DTS显得尤为重要。

DTS和PTS的区别

概念上的区别

- DTS:标识帧被解码的时间。

- PTS:标识帧被显示或播放的时间。

功能上的区别

- DTS:主要用于解码过程,确保帧按照正确的顺序进行解码。

- PTS:主要用于播放过程,确保帧在正确的时间点被显示或播放。

应用场景的区别

- DTS:更多应用于解码器内部,用于管理帧的解码顺序。

- PTS:更多应用于播放器,用于管理帧的显示和音频的播放时间。

DTS和PTS的联系

尽管DTS和PTS在功能和应用场景上有所区别,但它们共同服务于音视频同步这一目标。解码器使用DTS来决定帧的解码顺序,而播放器使用PTS来决定帧的显示顺序。这种同步工作机制确保了帧在正确的时间点被解码和播放,实现了音视频同步。

音视频同步的实例

以H.264编码格式为例,由于该编码格式支持B帧(双向预测帧),帧的解码顺序可能与播放顺序不一致。例如,假设有以下帧序列:

显示顺序:I B B P

解码顺序:I P B B

在这种情况下,解码器会按照DTS顺序解码帧,但播放器会按照PTS顺序显示帧。这样,即使在解码过程中帧的顺序被打乱,最终在播放时仍然能够保证音视频的同步性。

示例代码

音视频同步是一个复杂的过程,通常涉及到对音频和视频流的解码、时间戳处理以及适当的同步机制。在C++中实现这一功能,我们通常会使用像FFmpeg这样的库来处理媒体数据。以下是一个简化的示例,展示如何使用FFmpeg解码音频和视频流,并尝试进行基本的同步。

请注意,这个示例假设你已经安装了FFmpeg,并配置了相应的开发环境。此外,这个示例不包括实际的音频和视频播放代码,而是专注于解码和时间戳的处理。

#include <iostream>

#include <vector>

#include <algorithm>

#include <chrono>

#include <thread>

extern "C" {

#include <libavcodec/avcodec.h>

#include <libavformat/avformat.h>

#include <libavutil/time.h>

}

// 用于存储解码后的帧

struct Frame {

AVFrame* av_frame;

int64_t pts; // 表示帧的显示/播放时间戳

};

// 模拟解码队列

std::vector<Frame> video_frames;

std::vector<Frame> audio_frames;

// 模拟播放队列

std::vector<Frame> play_queue;

// 同步播放函数

void play_frames(std::vector<Frame>& queue) {

// 这里只是一个示例,实际播放逻辑会更复杂

for (auto& frame : queue) {

// 根据帧的pts进行适当的延时以实现同步

int64_t delay = frame.pts - av_gettime();

if (delay < 0) delay = 0; // 防止负延时

std::this_thread::sleep_for(std::chrono::milliseconds(delay));

// 模拟播放帧

std::cout << "Playing frame with PTS: " << frame.pts << std::endl;

av_frame_unref(frame.av_frame);

}

queue.clear();

}

// 主函数

int main() {

// 初始化FFmpeg库

av_register_all();

avcodec_register_all();

// 打开视频文件

AVFormatContext* format_ctx = nullptr;

if (avformat_open_input(&format_ctx, "input.mp4", nullptr, nullptr) < 0) {

std::cerr << "Cannot open input file" << std::endl;

return -1;

}

// 检索流信息

if (avformat_find_stream_info(format_ctx, nullptr) < 0) {

std::cerr << "Cannot find stream information" << std::endl;

return -1;

}

// 找到音频和视频流的索引

int video_stream_idx = -1, audio_stream_idx = -1;

for (unsigned i = 0; i < format_ctx->nb_streams; i++) {

if (format_ctx->streams[i]->codecpar->codec_type == AVMEDIA_TYPE_VIDEO) {

video_stream_idx = i;

} else if (format_ctx->streams[i]->codecpar->codec_type == AVMEDIA_TYPE_AUDIO) {

audio_stream_idx = i;

}

}

if (video_stream_idx == -1 || audio_stream_idx == -1) {

std::cerr << "No audio or video streams found" << std::endl;

return -1;

}

AVCodecContext* video_codec_ctx = avcodec_alloc_context3(nullptr);

AVCodecContext* audio_codec_ctx = avcodec_alloc_context3(nullptr);

// 打开音频和视频编解码器

// ...

// 模拟解码过程

AVPacket packet;

while (av_read_frame(format_ctx, &packet) == 0) {

if (packet.stream_index == video_stream_idx || packet.stream_index == audio_stream_idx) {

// 分配帧

Frame frame{av_frame_alloc(), packet.pts};

// 解码帧

// ...

// 根据类型将帧添加到相应的队列

if (packet.stream_index == video_stream_idx) {

video_frames.push_back(frame);

} else {

audio_frames.push_back(frame);

}

// 同步逻辑(简化示例)

// 这里需要更复杂的逻辑来处理实际的同步

if (!play_queue.empty() && video_frames.back().pts < play_queue.front().pts) {

play_frames(play_queue);

}

av_packet_unref(&packet);

}

}

// 清理资源

avformat_close_input(&format_ctx);

// ...

return 0;

}

这个代码提供了一个基本的框架,展示了如何使用FFmpeg库来打开视频文件、检索流信息、找到音频和视频流,以及模拟解码过程。示例没有实现真正的解码和播放逻辑,而是展示了如何组织代码结构以及如何考虑同步问题。

结论

PTS和DTS是音视频同步中不可或缺的两大时间戳。它们确保了在多媒体播放和处理过程中,无论是视频帧还是音频帧,都能在正确的时间点被解码和播放。理解和正确应用PTS和DTS,对于开发高质量的多媒体播放和处理软件至关重要。通过深入理解这些概念,我们可以为用户提供更加流畅和同步的多媒体体验。

祝大家学习顺利~

如有任何错误,恳请批评指正~~

以上是我通过各种方式学习的经验和方法,欢迎大家评论区留言讨论呀,如果文章对你们产生了帮助,也欢迎点赞收藏,我会继续努力分享更多干货~

🎈关注我的公众号AI Sun可以获取Chatgpt最新发展报告以及腾讯字节等众多大厂面经。

😎也欢迎大家和我交流,相互学习,提升技术,风里雨里,我在等你~

1779

1779

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?