机器之心报道

机器之心编辑部

大模型API,正式进入Flash时代。

最近一段时间,国内外的大模型行业卷的是「快速版」。

5 月谷歌 I/O 大会上,新发布的 Gemini 1.5 大模型序列中出现了 Flash 版,主打轻量化和响应速度。到 7 月,OpenAI 又在 GPT-4o 的基础上推出了 Mini 版,号称比当前最为先进的小模型能力更强,价格更低。

如果你现在访问 ChatGPT,会发现原来的默认模型 GPT-3.5 已经消失,新的默认选项就是 GPT-4o mini。自 2022 年底一直沿用的 GPT-3.5 终于被取代了,这不禁让人们感叹 AI 技术进步速度之快。

这一波技术迭代的背后,是直面应用的底层逻辑。新一代大语言模型继续保持多模态、长上下文等方面的性能优势,又因为速度和效率的大幅提升获得了更多开发者的青睐。

在实际应用场景中,新模型适用于处理高频次、相对简单的任务,禁得起人们的反复调用。现在想要开发一个使用生成式 AI 技术的产品,不再是一件难事了。

最近,国内大模型平台市场份额领先的智谱,也正式宣布了新模型,并提出了一系列提升 AI 开发效率的工具。

大模型开发便捷化

智谱此前已经上线了大模型的一键微调工具,这次更是决定将 GLM-4-Flash 免费。

智谱的最新版大模型 GLM-4-Flash 在 6 月份刚刚上线,在开放时 API 价格就已低至每 100 万 token 0.1 元,吸引了大量开发者使用。不论是国内还是国外,很多人都在社交网络上 po 出了自己的使用心得。

这款大模型 API 的能力如何?我们自己也上手试了试。

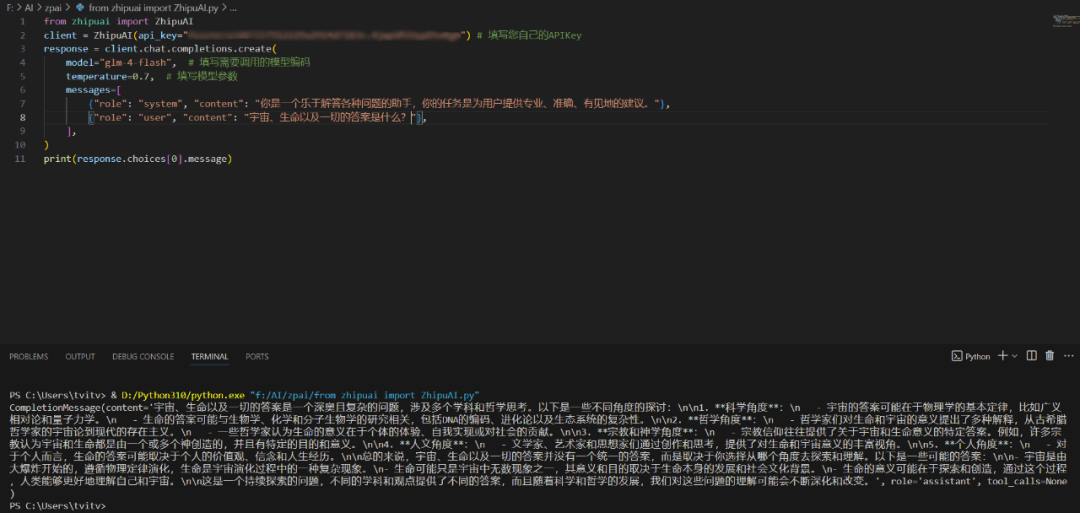

首先,要想调用大模型能力,有最简单的方法:通过 Python 脚本进行体验。智谱的官网上提供了一些示例,只需将其中的 api key 替换成自己的并修改其中的具体内容,就能很方便地使用这个大模型,比如可以在 VS Code 中使用它。

当然,你也可以将其集成到任何支持 API 接入的应用之中。比如在这里,我们可以将其引入到笔记软件 Obsidian 中。选择 BMO Chatbot 插件,下载启用之后,我们进入其设置选项,找到 API Connections 下的 OpenAI。这里之所以选择 OpenAI,是因为 GLM-4-Flash 的 API 协议基本与 OpenAI 一致。

之后在 OpenAI-Based URL 中填入智谱的模型链接:https://open.bigmodel.cn/api/paas/v4/,并在 OpenAI API Key 填入我们需要使用的 key。为了使用 GLM-4-Flash 模型,你还需要修改该插件的 data.json 文件,将 glm-4-flash 加入到 openAIBaseModels 中。

这样你就可以将 GLM-4-Flash 引入到你的笔记工作流程之中,以下展示了部署好的示例,我们让 GLM-4-Flash 分析了一篇有关视觉语言模型的文章并让其建议了一些标题。

当然,你也可以直接使用 GLM-4-Flash 生成文本笔记:

看起来效果都很不错。

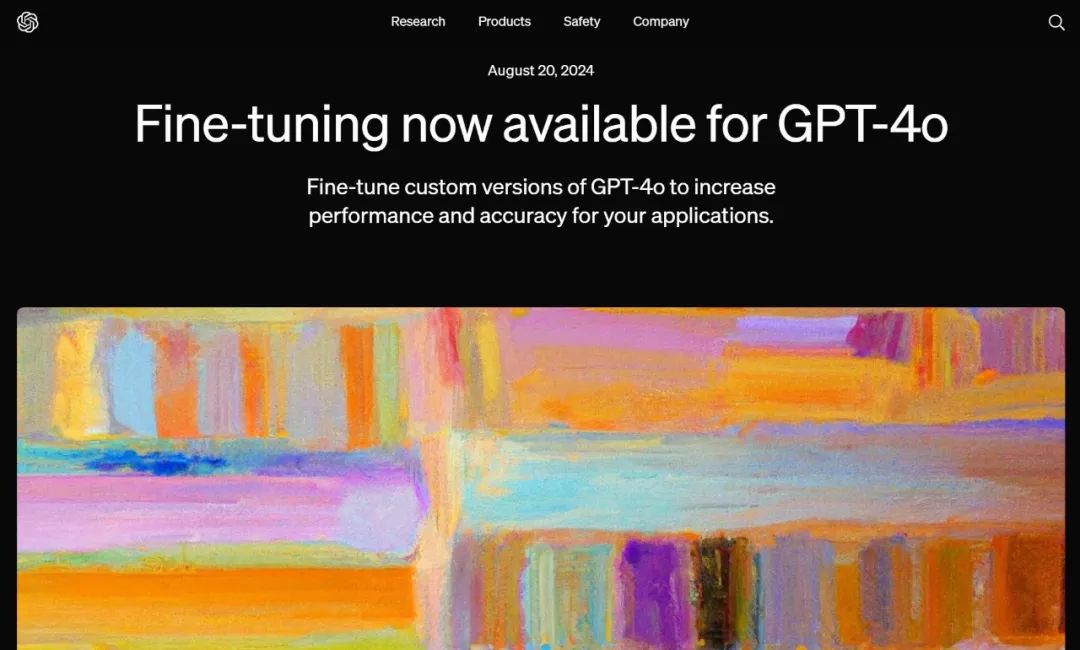

另一方面,说到大模型微调,上周二 OpenAI 正式上线了大模型的微调功能,引发了 AI 领域的关注。

OpenAI 的初衷,是帮助开发者能够低成本地构建个性化的应用。这次的智谱推出的大模型微调功能,也可以让我们通过微调工具,加入自身独有的场景数据,对平台提供的基础模型进行微调,快速使其定制化。这样做既符合了业务场景,也不需要进行复杂的调整或重新训练。

如果你认为基础模型无法满足复杂任务的需求时,使用微调可以获得更好的效果。微调可以让大模型表现出特定的风格,或是提高输出的可靠性,让大模型可以完成更加复杂的任务。

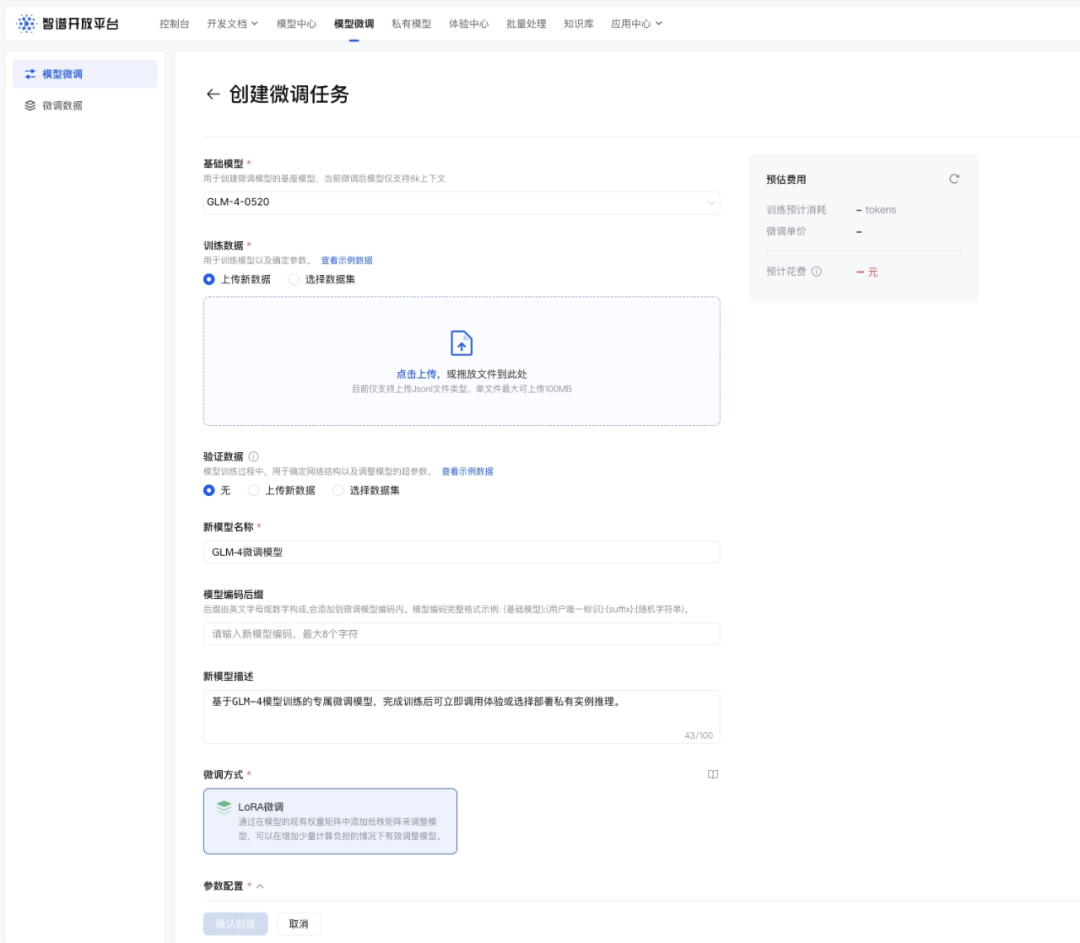

智谱目前已开放了 GLM-4-Flash、GLM-4-9B 等模型的 LoRA 微调和全参数微调能力。在微调的过程中,你需要准备并上传训练数据训练大模型,尝试部署并评估结果,最后完成的模型也可以快速部署。

我们可以看到,如今各家大模型公司提供的产品,越来越贴近实际需求了。这些充分考虑开发者,能够用起来的工具,对于 AI 的大规模应用来说意义重大。

Flash 大模型意味着什么?

智谱提供的一系列新能力,背后作为支撑的基础都是 GLM-4-Flash 大模型。

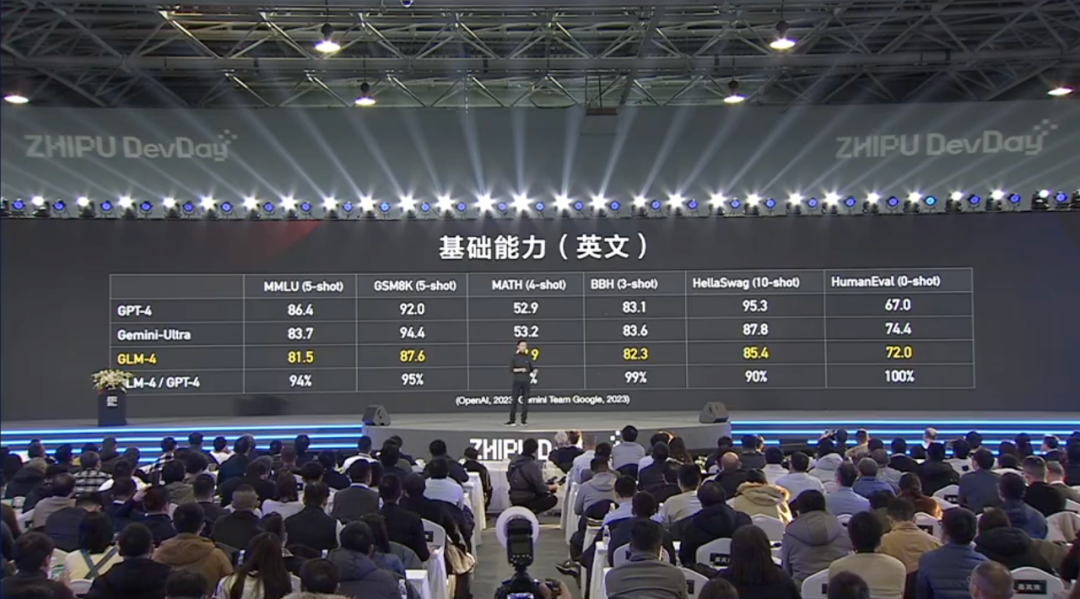

GLM-4 大模型是智谱在今年 1 月推出的新一代基座大模型,它在十余项指标上逼近或达到了大模型标杆 GPT-4 的水准。与此同时,GLM-4 支持了更长的上下文、更强的多模态、更快的推理速度,以及更多并发请求,大大降低了推理成本。

在此基础上发展出的 GLM-4-Flash,则带来了一系列技术优势:

数据预训练:引入大语言模型进入数据筛选流程,使用 10T 高质量多语言数据进行了训练。

预训练技术:采用 FP8 技术进行高效预训练,显著提高了训练效率和计算量。

模型能力:GLM-4-FLASH 模型具备强大的推理性能,支持 128K 长上下文推理和多语言处理。

生成速度:输出速度高达 72.14 token/s,约等于每秒 115 个字符。

GLM-4-Flash 模型实测

GLM-4-Flash 模型已经在大量测试中展现了能力。

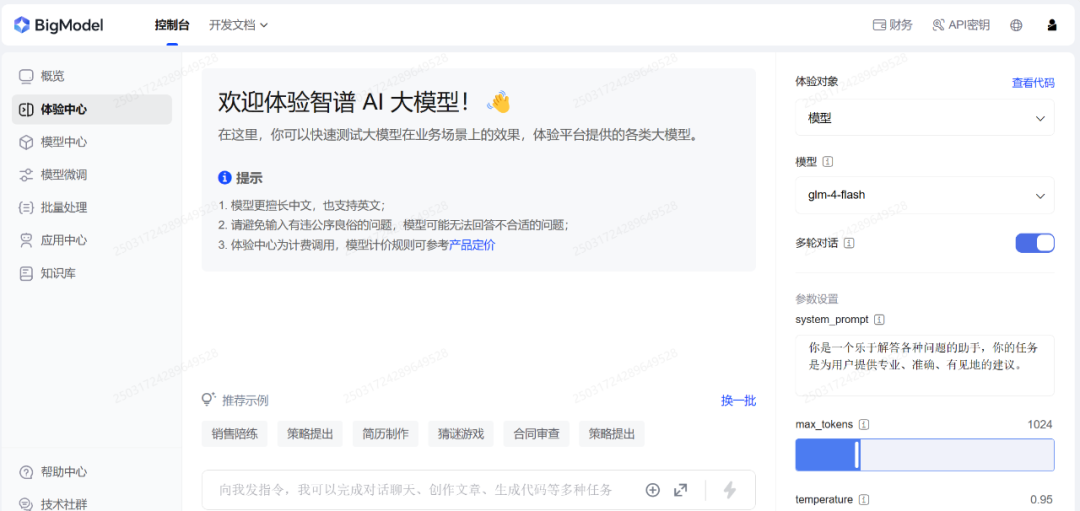

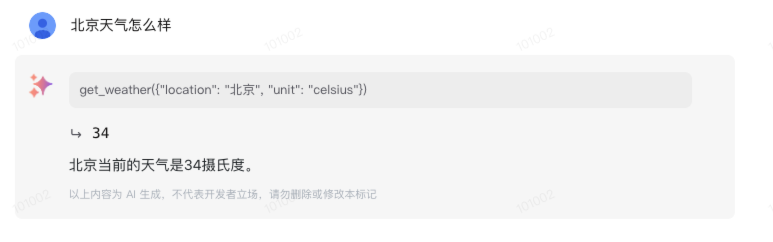

从模型界面来看,GLM-4-Flash 支持多轮对话、自定义系统指令构建(比如设定模型身份、任务目标)以及网页搜索、知识库搜索和函数调用等工具调用功能。

此外,用户也可以自由调整 GLM-4-Flash 对话窗口的最大 tokens 数量(输入上下文长度)、模型温度(控制生成的随机性和创造性)、top_p(控制回答风格,保证输出结果正确性的同时增加多样性)。

体验地址:https://open.bigmodel.cn/

逻辑推理能力,从简单到复杂,包含一般逻辑推理和数学推理。

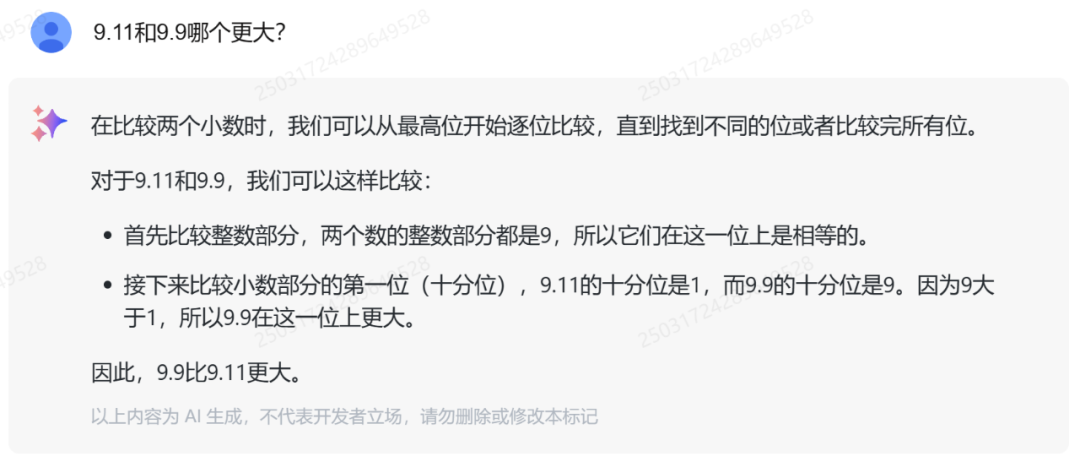

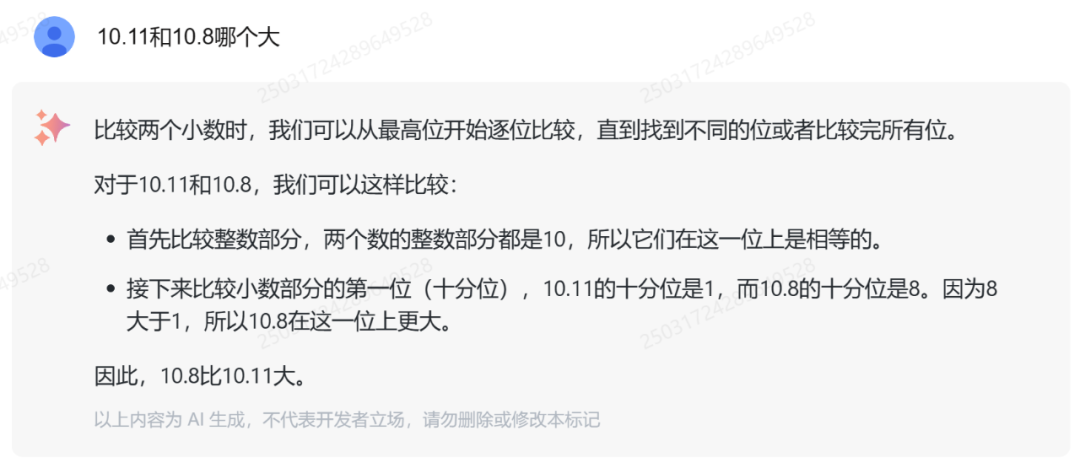

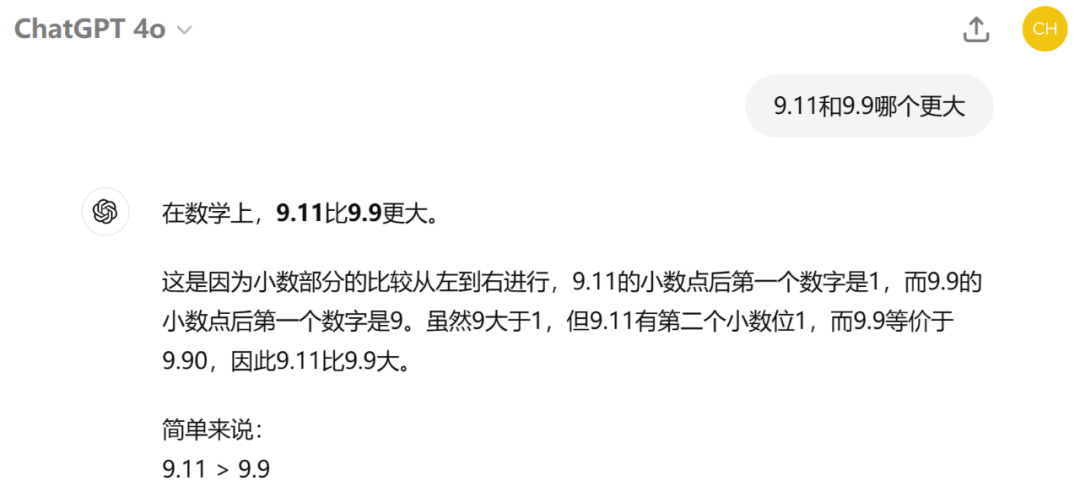

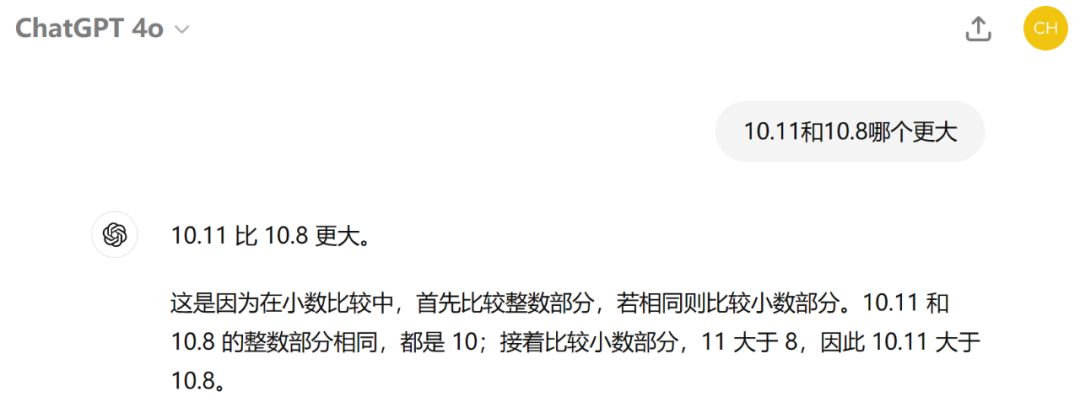

测试 1:先来一道前段时间让很多大模型翻车的「9.11 和 9.9 哪个更大」问题,很容易就答对了。

类似的数字比较同样答对了。从解题思路来看,GLM-4-Flash 掌握了正确的小数位比较方法。

而目前版本的 GPT-4o 全都翻车了。

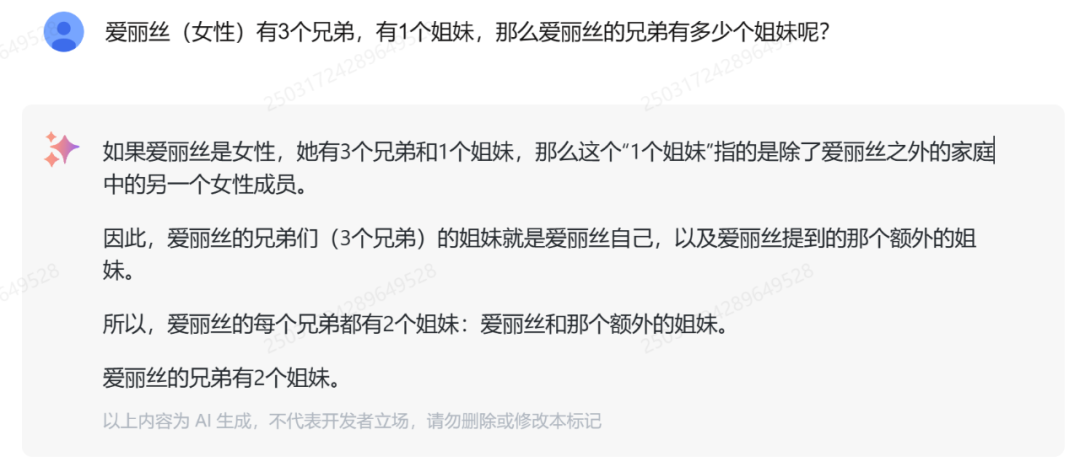

测试 2:此前研究机构 LAION 在一项研究中发现,GPT-3.5/4、Llama、Gemini、Claude 和 Mistral 等大模型回答「爱丽丝(女性)有 N 个兄弟,有 M 个姐妹,那么爱丽丝的兄弟有多少个姐妹呢?」问题时,正确率非常低。

我们让 GLM-4-Flash 试了试,回答正确。

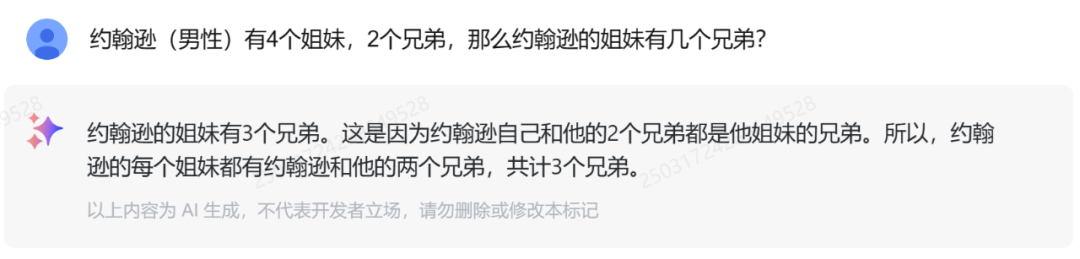

改变了主角性别和亲属关系之后,GLM-4-Flash 同样可以理解,再次回答对了。

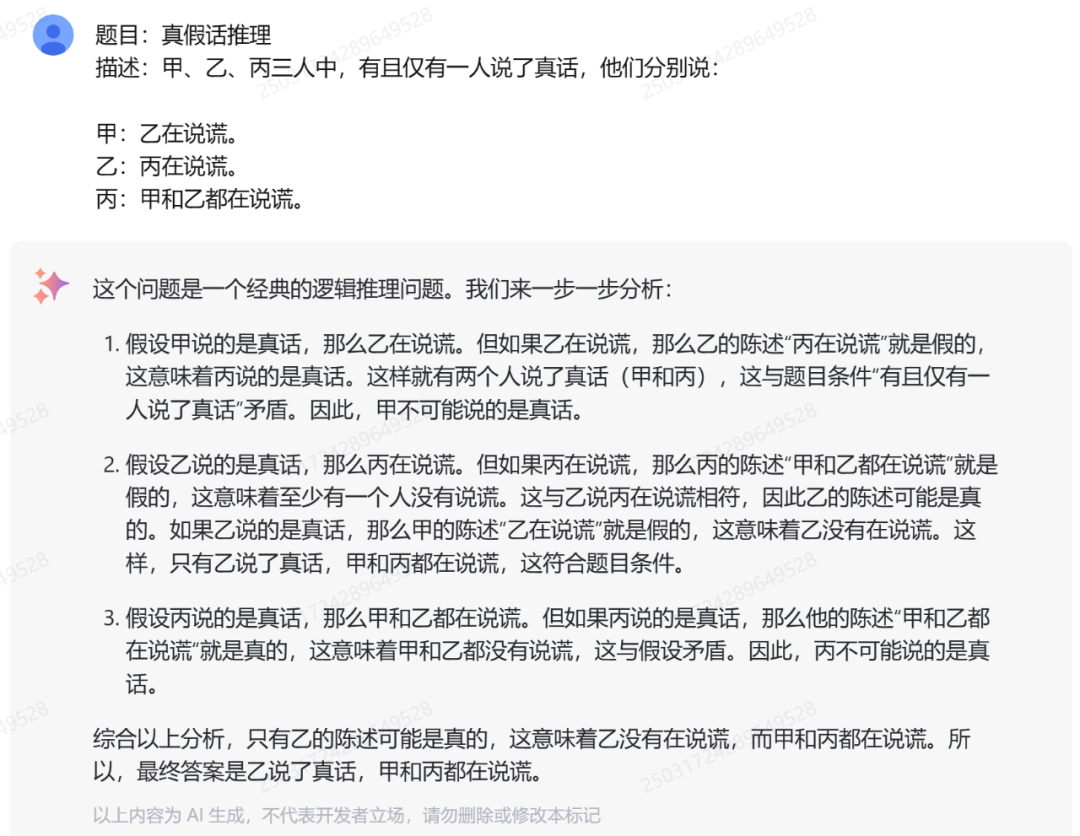

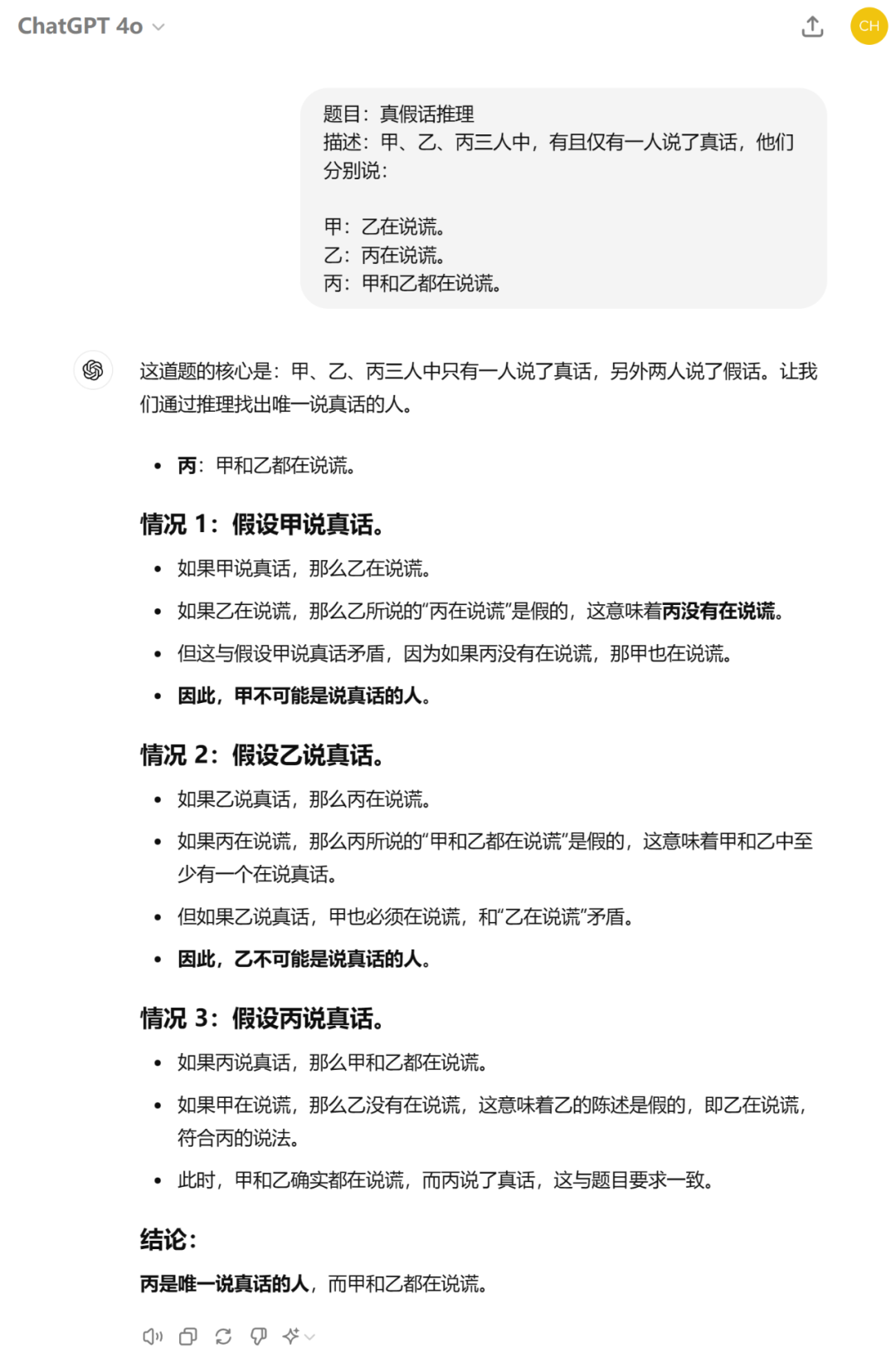

测试 3:对于多人真假话判断问题,GLM-4-Flash 能够理清各种假设情况,并最终给出了正确答案。

作为对比,GPT-4o 回答错误。

函数调用能力,允许 GLM-4-Flash 调用外部函数或服务。

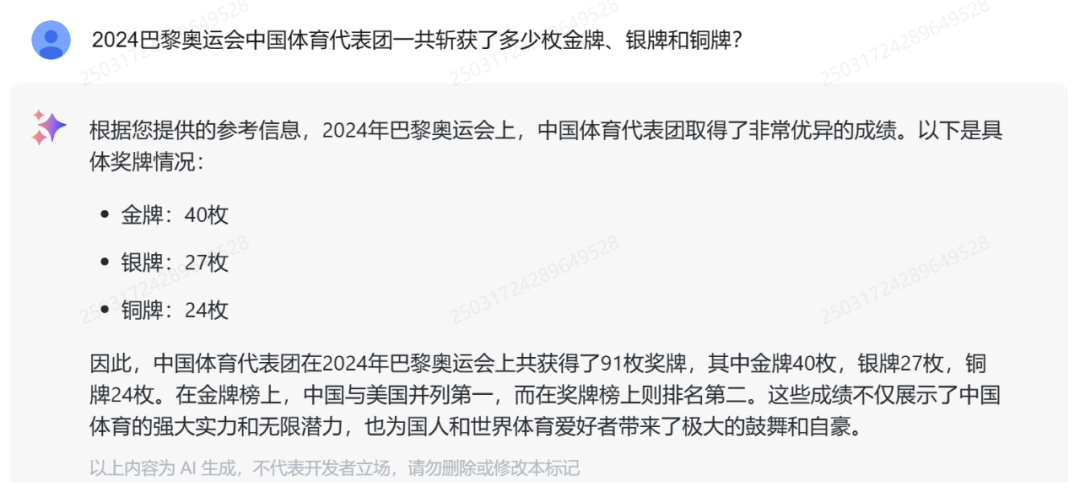

网页检索能力,实时获取互联网最新信息。

比如 2024 巴黎奥运会中国体育代表团斩获金银铜牌的总数量,结果无误。

还有代码生成、视频脚本制作、角色扮演、文章扩写等一系列能力,据说能力都不错。

通用化 AI 的应用,已经跑起来了

如今,GLM-4-Flash 已经上线两个月,人们都在用这款大模型做什么?很多人展示了自己的应用方向,或许能给我们带来一些启发。据介绍:

有生物学博士正在利用 GLM-4-Flash 模型处理复杂分子数据,大大提高了科研工作中数据处理的效率。通过 AI+Science,生物学和大模型的结合,我们可以探索基因序列与人类健康之间的深层联系;

有一群年轻科研人员正在使用 Flash 模型生成高质量数据材料。这些数据可以用于自身研究,也可以用于给其他领域的大模型进行训练;

有独立开发者发现 Flash 模型可用于高效翻译,开发出来的中英文翻译 APP 不仅提供翻译能力,还有互动学习模块。通过基于智谱大模型的 APP,小朋友可以在轻松愉快的环境下学习英语。这款 APP 已经帮助了大量学习者;

还有广告公司发现了 Flash 模型在内容创作上的巨大潜力。他们构建了应用对文章进行润色,帮助编辑和文案人员在创作过程中提升效率。AI 大模型可以联网获取最新信息,并提供创意灵感,保证了文案的质量和一致性。

看来,在速度更快,性能足够强大的 GLM-4-Flash 版本上,一些简单垂直,需要快速响应的应用已经得到了充分的验证。

不过对于通用的大模型来说,还有很多功能有待人们的发掘。

8 月 27 日,智谱 BigModel 开放平台正式宣布:GLM-4-Flash 全部免费,同时开启限时免费微调活动。

GLM-4-Flash 是智谱首次开放免费 API 的大模型,支持长度达 128K 的上下文。在用户调用量上,智谱做到了原有调用用户并发不变,新用户有两个并发,还可以申请进一步提高。

而在 GLM-4-Flash 微调赠送额度上,如果立即申请,你可以获得 500 万 token (3 个月)的训练资源包,限额 2000 位,先到先得。智谱还将开放 GLM-4-Flash 模型的更多能力,致力于构建更好的部署平台。

这一系列行动,展示了国内大模型公司在应用层面的独特优势。在大模型技术对标国际先进水平的同时,国内 AI 的先头部队已经打磨好「内功」,通过系统优化大幅提升了推理效率。

现在,免费开放的大模型已经可以惠及广大开发者,让人不花一分钱就可以上线基于大模型的智能应用。

不论如何,是时候体验大模型的开发了,羊毛薅起来!

点击阅读原文,立即开始使用。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

1241

1241

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?