Gemini是一款由Google DeepMind(谷歌母公司Alphabet下设立的人工智能实验室)于2023年12月6日发布的人工智能模型,可同时识别文本、图像、音频、视频和代码五种类型信息,还可以理解并生成主流编程语言(如Python、Java、C++)的高质量代码,并拥有全面的安全性评估。首个版本为Gemini 1.0,包括三个不同体量的模型:用于处理“高度复杂任务”的Gemini Ultra、用于处理多个任务的Gemini Nano和用于处理“终端上设备的特定任务”的Gemini Pro。

谷歌AI模型的研发进程从2012年就已开始;2022年8月推出高级语言学习模型PaLM;2023年5月Google I/O大会上Alphabet首席执行官桑达尔·皮查伊发布了PaLM2与Bard,同时宣布Gemini即将问世;12月6日在一段官方公布的视频中,谷歌正式推出Gemini。

谷歌计划逐步将Gemini整合到其搜索、广告、Chrome等其他服务中。从2023年12月13日开始,开发者和企业客户可以通过Google的AI Studio和Google Cloud Vertex AI中的Gemini API访问Gemini Pro。

2023年12月7日,科技界指出Gemini与ChatGPT测试方法存疑,且分数存在夸大嫌疑,同时发布会演示视频也存在虚假剪辑问题。随后,对于视频“造假”一说,Gemini联合创始人奥里奥尔·维尼亚尔斯予以否认。

2024年2月9日,谷歌宣布Gemini Ultra可免费使用,16日发布Gemini 1.5,21日发布开源模型Gemma。Gemma采用了与Gemini相同的技术和基础架构,基于英伟达GPU和谷歌云TPU等硬件平台进行优化,有20亿、70亿两种参数规模。

谷歌AI发展历程

从搜索引擎到成为AI领域领导者,谷歌不仅重新定义了公司的发展轨迹,也对全球科技格局产生了深远影响。以下是其AI技术发展历程中的重大节点:

2001年:机器学习帮助搜索用户纠正拼写

2001年,谷歌开始使用简单版本的机器学习技术,来为网络搜索提供拼写建议。即使在用户输入不完整的情况下搜索,谷歌仍可以为用户提供所需的内容。

2006年:谷歌翻译

2006年,谷歌推出了翻译功能。从阿拉伯语到英语和英语到阿拉伯语的互译开始,截至2023年,可支持全球共计133种语言。这项技术可以实现实时文本、图像甚至对话翻译,打破全球语言障碍的同时扩大了信息获取的范围。

2015年:TensorFlow框架

2015年,Google Brian团队推出全新开源机器学习框架TensorFlow,使AI变得更易于访问、可扩展且高效。这一框架加快了全球人工智能研发的进程。TensorFlow是现如今的主流机器学习框架之一,已被用于开发广泛的人工智能应用程序,如图像识别、自然语言处理和机器翻译等。

2016年:AlphaGo获胜

作为Google DeepMind挑战赛的一部分,2016年,超过2亿人在线观看了AlphaGo成为第一个在围棋比赛中击败人类世界冠军的围棋人机大战。AlphaGo战胜了世界上最好的围棋棋手之一李世石,这一里程碑式的胜利证明了深度学习有潜力解决曾经被认为对计算机来说不可能解决的复杂问题,并表明人工智能系统可以学习掌握需要战略思维和创造力的复杂游戏。

同年,谷歌TPU(张量处理单元)实现了更快、更高效的AI部署,TPU是谷歌专门为机器学习发明并针对TensorFlow进行优化的定制设计硅芯片。它可以更快地训练和运行人工智能模型,非常适合大规模人工智能应用。TPU v5e版本于2023年8月发布,是迄今为止最具成本效益、多功能且可扩展的Cloud TPU。

2017年:Transformer模型

2017年,Google Research推出了Transformer模型。谷歌官方论文“Attention Is All You Need”介绍了Transformer——一种有助于语言理解的新神经网络架构。在Transformer出现之前,机器不太擅长理解长句子的含义,也无法看到相距较远单词之间的关联。Transformer极大地改善了这一点,并成为当今语言理解和生成式人工智能系统的基石。Transformer彻底改变了机器执行翻译、文本摘要、问题回答甚至图像生成和机器人技术的含义。

2019年:BERT帮助搜索理解查询意图

2019年,谷歌对Transformers的研究促成了 Transformers 的双向编码器表示法(Bidirectional Encoder Representations from Transformers)(简称 BERT)的推出,它帮助搜索能更好地理解用户的查询意图。谷歌的BERT算法不是以单独理解单词为目标,而是帮助Google理解上下文中的单词。这大大提高了整个搜索的质量,使人们更容易自然地提出问题,而不是将关键词串联在一起。

2020年:AlphaFold医学应用

2020年,DeepMind凭借其系统AlphaFold在人工智能领域实现了飞跃,该系统被认为是“蛋白质折叠问题”的解决方案。蛋白质是生命的基石,它的折叠方式决定了其功能,错误折叠的蛋白质可能会导致疾病的产生。50年来,科学家们一直试图预测蛋白质如何折叠,以帮助理解和治疗疾病。2022年,AlphaFold做到了这一点:谷歌通过AlphaFold蛋白质结构数据库,与科学界免费共享了2亿个AlphaFold蛋白质结构,几乎涵盖地球上所有进行过基因组测序的生物。截至2022年,已有100多万名研究人员利用该数据库开展了各种研究,如加速新型疟疾疫苗的研发、推动癌症药物的发现和塑料分解酶的开发等。

2023年:Gemini问世

2023年1月,为应对ChatGPT的挑战,已隐退的谷歌联合创始人拉里·佩奇(Larry Page)和谢尔盖·布林(Sergey Brin)回归,并将优化谷歌自身人工智能能力的问题作为优先事项。2月,谷歌首席执行官桑达尔·皮查伊要求谷歌旗下用户超10亿的产品尽快接入生成式AI,由此催生了数十个生成式AI集成计划。

2023年3月,谷歌推出Bard,在全球大部分地区提供40多种语言版本。Bard将与用户每天使用的Google服务(如Gmail、文档、云端硬盘、航班、地图和YouTube)相结合,为用户完成旅行计划、信息复核等任务,提供更多帮助,如文本总结、书写文档或电子邮件。

2023年5月,谷歌推出PaLM 2,它优化了多语言、推理及编码能力,比前代产品功能更强大、速度更快、效率更高,且已经为超过25种Google产品和功能提供支持,包括Bard、Gmail和Workspace中的生成式AI功能,以及SGE(谷歌将生成式AI深度集成到Google搜索中的实验)。谷歌还使用PaLM 2推进从医疗保健到网络安全等各方面的研究。

2023年9月,Gemini开启小范围内测;12月6日,谷歌正式发布Gemini,成为AI领域一项重大突破。

2024年:Gemini推出

2024年2月8日,谷歌Gemini体验与谷歌助理业务副总裁暨总经理Sissie Hsiao在谷歌官网发表博客指出,聊天机器人Bard将会直接称为Gemini,网页版支持40种语言,并将在Android和iOS的Google应用程序上推出新的Gemini应用程序。此外,谷歌还推出了Gemini Advanced,透过Ultra 1.0模型,Gemini Advanced能够处理更复杂的任务与指令,像是程序编写、逻辑推理、遵循细微与精确的指示,以及进行创意协作。

2024年2月16日,谷歌升级了Gemini系列模型,并发布用于早期测试的Gemini 1.5版本。Gemini 1.5建立在谷歌基础模型开发和基础设施之上,采用包括通过全新稀疏专家混合 (MoE) 架构,第一个版本Gemini 1.5 Pro配备了128000个token 上下文窗口,可推理100,000行代码,提供有用的解决方案、修改和注释,使Gemini 1.5的训练和服务更加高效。

主要功能

五种模型

2023年12月6日,谷歌针对Gemini 1.0优化了三个不同体量的模型,分别应用于不同的场景;2024年2月16日,发布大模型Gemini 1.5;21日,放出基于Gemini的开源模型Gemma。

| 模型版本 | 模型规模 | 模型描述 |

|---|---|---|

| Gemini 1.0 | Gemini Ultra | 虽然目前还没有被广泛使用,但谷歌将Gemini Ultra描述为其最强大的模型。可在各种高度复杂的任务(包括推理和多模态任务)中提供最先进的性能。由于采用了Gemini架构,它可以在TPU加速器上高效地提供大规模服务。该版本将于2024年在Bard中推出,并通过云API提供服务(前提是经过“广泛的信任和安全检查”)。该模型被定位于击败ChatGPT 4.0。 |

| Gemini Pro | 在成本和延迟方面性能优化的模型,可在广泛的任务范围内提供较优性能。该模型表现出强大的推理性能和广泛的多模态能力。Gemini Pro在谷歌的数据中心运行,旨在支持公司AI聊天机器人Bard的最新版本,它能够快速响应并理解复杂的查询。该模型定位于击败ChatGPT 3.5。 | |

| Gemini Nano | 用于在数码设备上运行的最高效模型,目前应用于谷歌的智能手机系统,特别是Google Pixel 8(谷歌智能手机),旨在执行需要高效AI处理但不需要连接到外部服务器的本地任务,比如在聊天应用中建议回复或总结文本,分别应用于Pixel 8录音机应用中的自动摘要功能,以及Gboard键盘的智能回复部分。谷歌训练了两个Nano版本,参数分别为18亿(Nano-1)和32.5亿(Nano-2),分别针对低内存和高内存设备。它是通过从更大的Gemini模型中提取精髓进行训练。该模型经过4位量化(量化是指将连续的模拟信号转换为离散的数字信号的过程;4位量化即数字信号的每个采样点数值表示为4位二进制数,其可以表示16个不同的数值)以进行部署,并提供最佳性能。 | |

| Gemini 1.5 | Gemini 1.5 Pro | Gemini 1.5 建立在谷歌基础模型开发和基础设施之上,采用包括通过全新稀疏专家混合 (MoE) 架构,第一个版本Gemini 1.5 Pro 配备了128000个token 上下文窗口,可推理100,000 行代码,提供有用的解决方案、修改和注释使 Gemini 1.5 的训练和服务更加高效。 Gemini 1.5 Pro性能水平与谷歌迄今为止最大的模型 1.0 Ultra 类似,并引入了长上下文理解方面的突破性实验特征,性能、文本长度均超越了GPT-4 Turbo。 2024年2月16日起,少数开发人员和企业客户可以通过 AI Studio 和 Vertex AI 的私人预览版在最多 100 万个 token 的上下文窗口中进行尝试 1.5 Pro 预览版。 |

| Gemma | Gemma | Gemma在全球范围内开放使用,用户可以在Kaggle、Hugging Face等平台上进行下载和试用,它可以直接在笔记本电脑或台式机上运行。 Gemma采用了与Gemini相同的技术和基础架构,基于英伟达GPU和谷歌云TPU等硬件平台进行优化,有20亿、70亿两种参数规模,每个规模又分预训练和指令微调两个版本。Gemma 2B和7B模型分别在2T和6T的tokens上进行训练,数据主要来自网络文档、数学和代码的英语数据。不同于Gemini,这些模型不是多模态的,也没有针对多语言任务进行训练。 Gemma在设计时将其AI原则放在首位,通过大量微调和人类反馈强化学习(RLHF)使指令微调模型与负责任的行为对齐,还通过手工红队测试、自动对抗性测试等对模型进行评估。 |

原生多模态

模型优化思路,从多模态到原生多模态

传统的多模态模型通常通过分别训练处理各类信息类型的组件,然后将它们组合在一起的方式来构建。虽然这些模型在某些任务上表现不错,比如描述图像,但在处理更复杂的概念和推理时,效果并不理想。为了提升多模态模型的性能,谷歌采用了一种不同的策略,将Gemini设计成一个原生多模态模型。这意味着Gemini从一开始就在各种信息类型上进行了预训练,然后通过额外的多模态数据微调,使其更好地理解和推理各种输入。

三种能力

三种显著优化的能力如下:

1、复杂的推理能力

Gemini 1.0的多模态推理能力有助于理解复杂的书面和视觉信息,它能在大规模的数据提取中,识别微小的差异点。通过阅读、过滤和理解信息,从成千上万的文档中提取独到的信息和见解,有利于未来在从科学到金融等众多领域以数字化的速度实现新的突破。

以下图中描述的教育场景为例:一位老师画了一个滑雪者下坡的物理问题,使用Gemini多模态推理能力,模型能够理解学生混乱的手写答案,正确理解题目的表述,将问题和解决方案转换为数学排版,识别学生在解决问题时出错的具体推理步骤,然后给出一个经过深思熟虑的正确解决方案。这为教育领域提供了更多可能性。

图片和示例于谷歌官网Gemini的60页性能测试报

Gemini的多模态推理能力,可以生成重新排列子图的matplotlib代码,如下图所示,多模态提示显示在左上角的灰色区域;Gemini Ultra的响应,包括生成的代码,显示在右列的蓝色区域;左下方的图显示了生成代码的渲染版本。成功解决这个任务展示了该模型结合了多种能力:(1)识别图中所描绘的函数;(2)通过逆向图形推断生成子图的代码;(3)按照指示将子图放置在期望的位置;(4)抽象推理(推断指数图必须保持在原来的位置,因为正弦图必须为三维图腾出位置)。

谷歌官网示例

2、理解文本、图像、音频等内容的能力

经过训练,Gemini 1.0可以同时识别和理解文本、图像、音频及更多内容,因此它能更好地理解细微信息,回答与复杂主题相关的问题,且尤其擅长解释数学和物理等复杂学科的推理。

本图片来自于谷歌官网Gemini的60页性能测试报告

如上图所示,Gemini支持以交错的方式输入文本、图像、音频和视频序列(在输入序列中用不同颜色的标记表示),它能够输出交错的图像和文本响应,并且能处理夹杂着各种音频和视觉输入的文本输入,例如自然图像、图表、屏幕截图、PDF和视频,并能够生成文本和图像输出。与其他多模态模型重要的一个区别是,这些模型从一开始就是多模态的,且可以使用离散图像标记原生输出图像。

3、高级编码能力

谷歌的第一版Gemini可以理解、解释和生成主流的编程语言(如Python、Java、C++和Go)的高质量代码,能够跨语言工作并推理复杂的信息。在此基础上,Gemini Ultra在多个编码基准测试中表现优异,包括行业标准的HumanEval和谷歌内部的Natural2Code数据集。

此外,Gemini可用作更高级编码系统的引擎,包括先前推出的AlphaCode。通过Gemini的专门版本,谷歌创建了更先进的代码生成系统AlphaCode 2,该系统擅长解决超出编码范围、涉及复杂数学和理论计算机科学的竞争性编程问题。经过与原始AlphaCode在相同平台上进行评估,AlphaCode 2展现出巨大进步,可解决的问题数量几乎是原来的两倍。

AlohaCode2 system

下图为编程竞赛平台Codeforces上AlphaCode 2(一种人工智能编程模型)的性能预估排名。可以看到,大部分人类参赛者的得分分布在较低的百分位数区域,而AlphaCode 2的得分,则位于85%以上的百分位区域,这意味着它的性能超过了85%的人类参赛者。谷歌鼓励内部员工使用AI工具提高代码生成能力。

性能测试

谷歌自身对Gemini模型进行了测试,并评估了三种模型在各类任务中的性能。从自然图像、音频和视频理解到数学推理,Gemini Ultra在大型语言模型 (LLM) 研发中广泛使用的32个学术基准中的30个基准,性能都超过了当前最先进的结果。

如下图所示,Gemini Ultra的得分率高达90.0%,是第一个在MMLU(大规模多任务语言理解)上超过人类专家的模型,该模型综合使用数学、物理、历史、法律、医学和伦理学等57个学科来测试世界知识和解决问题的能力。Gemini在文本和编码等一系列基准测试中超越了ChatGPT。

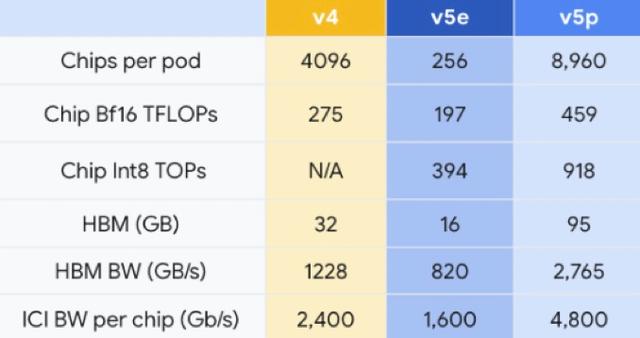

芯片TPU

与新模型一起亮相的,还有新版本的TPU芯片TPU v5p,TPU芯片又称张量处理器,旨在减少训练大语言模型相关的时间投入。TPU是谷歌为神经网络设计的专用芯片,经过优化可加快机器学习模型的训练和推断速度,谷歌于2016年起开始推出第一代TPU。

谷歌TPU芯片参数比较

与TPU v4相比,TPU v5p的浮点运算性能提升了两倍,高带宽内存方面提升了3倍。使用谷歌的600 GB/s芯片间互连,可以将8960个v5p加速器耦合在一个Pod(通常指一个包含多个芯片的集群或模块)中,从而更快或更高精度地训练模型。作为参考,该值比TPU v5e大35倍,是TPU v4的两倍多。

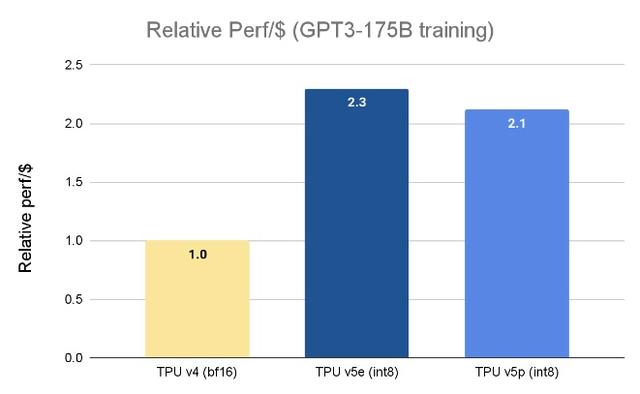

TPU v5p是截至2023年最强大的、能够提供超高性能、支持95GB的高带宽内存、同时以2.76 TB/s的速度传输数据的芯片。这意味着TPU v5p可以比TPU v4更快地训练大型语言模型,如训练GPT-3(1750亿参数)这样的大语言模型速度比TPU v4快2.8倍。

不过,这种更高的性能和可扩展性也是有代价的——每个TPU v5p加速器的运行费用为每小时4.2美元,而TPU v4加速器的运行费用为每小时3.22美元,TPU v5e加速器则为每小时1.2美元。

谷歌TPU芯片训练大模型的参数比较

谷歌DeepMind首席科学家杰夫·迪恩(Jeff Dean)指出,相较使用TPU v4芯片,使用TPU v5p芯片的大语言模型(LLM)训练工作的负载速度提高了两倍,且TPU v5p芯片对机器学习框架(JAX、PyTorch、TensorFlow)和编排工具的强大支持使得能够更高效地扩展。通过第二代SparseCores,嵌入密集型工作负载的性能有了显著提高。TPU对于在Gemini等尖端模型上进行大规模的研究和工程工作至关重要。

实际应用

从发布会当天开始,Pixel 8 Pro手机的两项功能将由Gemini Nano提供支持,分别是录影机应用中的自动摘要功能以及Gboard键盘的智能回复部分。Gemini Pro已与谷歌聊天机器人Bard相结合,可实现高级推理、规划、理解能力。预计在2024年年初,谷歌将推出Bard Advanced,使用Gemini Ultra模型。

Gemini AI是一个强大的工具,有潜力用于各种应用,如:

-

聊天机器人:创建更现实、更有吸引力的聊天机器人。

-

虚拟助理:创建虚拟助理,帮助用户完成安排约会、预订和查找信息等任务。

-

内容生成:生成创意内容,例如文章、博客文章和脚本。

-

数据分析:分析大型数据集并识别模式和趋势。

-

医疗诊断:帮助医生诊断疾病。

核心成员

2023年4月20日,Google和Alphabet首席执行官桑达尔·皮查伊 (Sundar Pichai) 以及DeepMind首席执行官戴密斯·哈萨比斯 (Demis Hassabis) 宣布:DeepMind和Google Research的Brain团队将联手成为一个单一的、专注的部门,称为Google DeepMind,核心成员如下:

| 职位 | 姓名 | 简介 |

|---|---|---|

| 首席执行官 | Demis Hassabis | 领导通用人工智能系统的开发。 |

| 首席科学家 | Jeff Dean | 向首席执行官戴密斯·哈萨比斯 (Demis Hassabis) 汇报,是Google最早的员工之一,他因帮助创建了一些基础技术而受到赞誉,这些技术推动了Google在2000年初的崛起。同时他也是Google Brain团队的联合创始人。2015年,参与了Google机器学习框架TensorFlow的开发。2018年开始,他一直担任Google AI的负责人。在Alphabet的人工智能团队进行重组后,于2023年被任命为Alphabet的首席科学家。 |

| 研究副总裁 | 科雷·卡武克乔格鲁 Koray Kavukcuoglu | 在加入DeepMind之前,是NEC美国实验室机器学习部门的研究人员。攻读博士学位期间,在纽约大学Yann LeCun的小组(计算和生物学习实验室)工作,致力于特征提取器和目标识别多阶段架构的无监督学习。 |

| 副总裁 | 祖宾·加赫拉马尼 Zoubin Ghahraman | 2020年,加入Google Brain,担任高级研究总监。2003年至2012年期间,担任卡内基梅隆大学计算机科学学院副研究教授。2003年至2012年期间,担任卡内基梅隆大学计算机科学学院副研究教授。自2009年起,成为剑桥圣约翰学院的院士,是一位英国-伊朗研究员。 |

科学委员会

成立以监督Google DeepMind的研究进展和方向,该委员会将由研究副总裁科雷·卡武克乔格鲁(Koray Kavukcuoglu)领导。

主要竞争对手

| 产品名称 | 产品定位 | 产品官网 | 公司名称 | 模型名称 | 参数规模 | 发布时间 |

|---|---|---|---|---|---|---|

| 国外竞争对手 | ||||||

| AI语言模型, 多用途文本生成工具, 知识检索整合平台, 交互式学习及教育工具。能力: 自然语言理解与生成, 多样化文本应用, 广泛的知识库, 支持多语言, 定制化和可拓展性。 | https://chat.openai.com | OpenAI | GPT3.5/GPT-4,Transformer | 1750亿 | 2022-11-30 | |

| Stability AI | 图像生成工具, 开源和社区向导。 能力:文本到图片的转换, 高级算法应用, 用户友好界面,社区驱动创新。 | https://stability.ai | Stability AI | Stable Diffusion XL SDXL | — | 2022-08-22 |

| Anthropic | 可理解和透明的AI,AI研究及创新。能力: 高级语言模型, 模型可解释性, 透明,人工智能伦理安全。 | https://www.anthropic.com | Anthropic | The Anthropic Claude modes | 1750亿 | 2022-3 |

| AI21Labs | 企业级AI解决方案, ai文本生成与编辑工具,创新的自然语言处理技术。能力: 高级语言模型, 多样化使用场景, 用户友好界面。 | https://www.ai21.com | AI 21 Labs | Jurassic | 1780亿 | 2020-10-27 |

| Cohere | 多用途AI平台, 易于集成的API, 企业级解决方案. 能力: 用户友好接口, 多语言自持, 文本分析生成, 高级语言模型。 | https://cohere.com/ | Cohere | large language models (LLMs) | 520亿 | 2022-12 |

| 国内主要竞争对手 | ||||||

| 具有自然语言处理、智能写作、多模态交互和跨平台应用。能力:理解人类语言,进行智能推理和分析,生成高质量的文字输出,并支持多种模态的交互方式和跨平台应用。 | https://yiyan.baidu.com | 百度 | ERNIE Bot | 2600亿 | 2023-02-07 | |

| 通义千问 | 成为一个通用的人工智能助手,旨在为用户提供全面的语言理解和生成能力。能力:它可以提供定义、解释和建议,将文本从一种语言翻译成另一种语言,总结文本,生成文本,写故事,分析情绪,提供建议,开发算法,编写代码以及任何其他基于语言的任务。 | https://tongyi.aliyun.com | 阿里巴巴 | QianWen | 720亿 | 2023-04-07 |

| 混元 | 为用户提供高效、便捷、多样化的智能服务。能力:语言理解和生成能力、图像和视频处理能力以及多模态交互能力,可以应用于自然语言处理、计算机视觉、语音识别等多个领域。 | https://hunyuan.tencent.com | 腾讯 | 浑元大模型 | 1750亿 | 2023-09-07 |

| 360智脑 | 提供生成与创作、阅读理解、多轮对话等多种能力的数字人制作和分享平台。能力:它提供了上传和管理数字人的方便功能;大语言模型,具备跨模态生成能力,拥有文字、图像、语音、视频处理四大能力,可应用于文生图、图生图、文生视频等场景 | https://chat.360.com/chat | 360 | 360智脑4.0版 | 千亿参数规模 | 2023-12-12 |

| 商量 | 商量AI是一款基于人工智能技术的智能助手,旨在为用户提供高效、便捷、个性化的服务。能力:自然语言处理能力,理解人类语言并进行语义分析和理解,同时具有智能推理能力,可以根据用户输入和历史行为进行智能推荐。 | https://chat.sensetime.com/wb/login | 商汤 | 1800亿 | 1800亿 | 2023-4-10 |

| 讯飞星火 | 是科大讯飞研发的以中文为核心的新一代认知智能大模型。能力:内容生成能力,语言理解能力,知识问答能力,推理能力,多题型步骤级数学能力,代码理解与生成能力。 | https://xinghuo.xfyun.cn | 科大讯飞 | 千亿参数 | 1000亿 | 2023-05月06 |

| 言犀 | 言犀的产品定位是“最懂产业的人工智能应用平台”。能力:自然语言处理,语音生成和识别,情感智能,大规模数据处理能力,跨平台应用。 | https://yanxi.jd.com | 京东 | 千亿参数 | 千亿参数规模 | 2023-07-13 |

| APUS大模型 | APUS大模型的产品定位是致力于为中国打造AI大模型。能力:对文本、图像、音频、视频的深入理解和生成能力,针对具体应用场景的垂直领域精炼模型,在产业端的落地应用,针对开发者的开放API接口和精炼模型。 | https://www.apusai.com | APUS | — | 千亿参数规模 | 2023-4-18 |

Gemini聊天机器人

产品原理

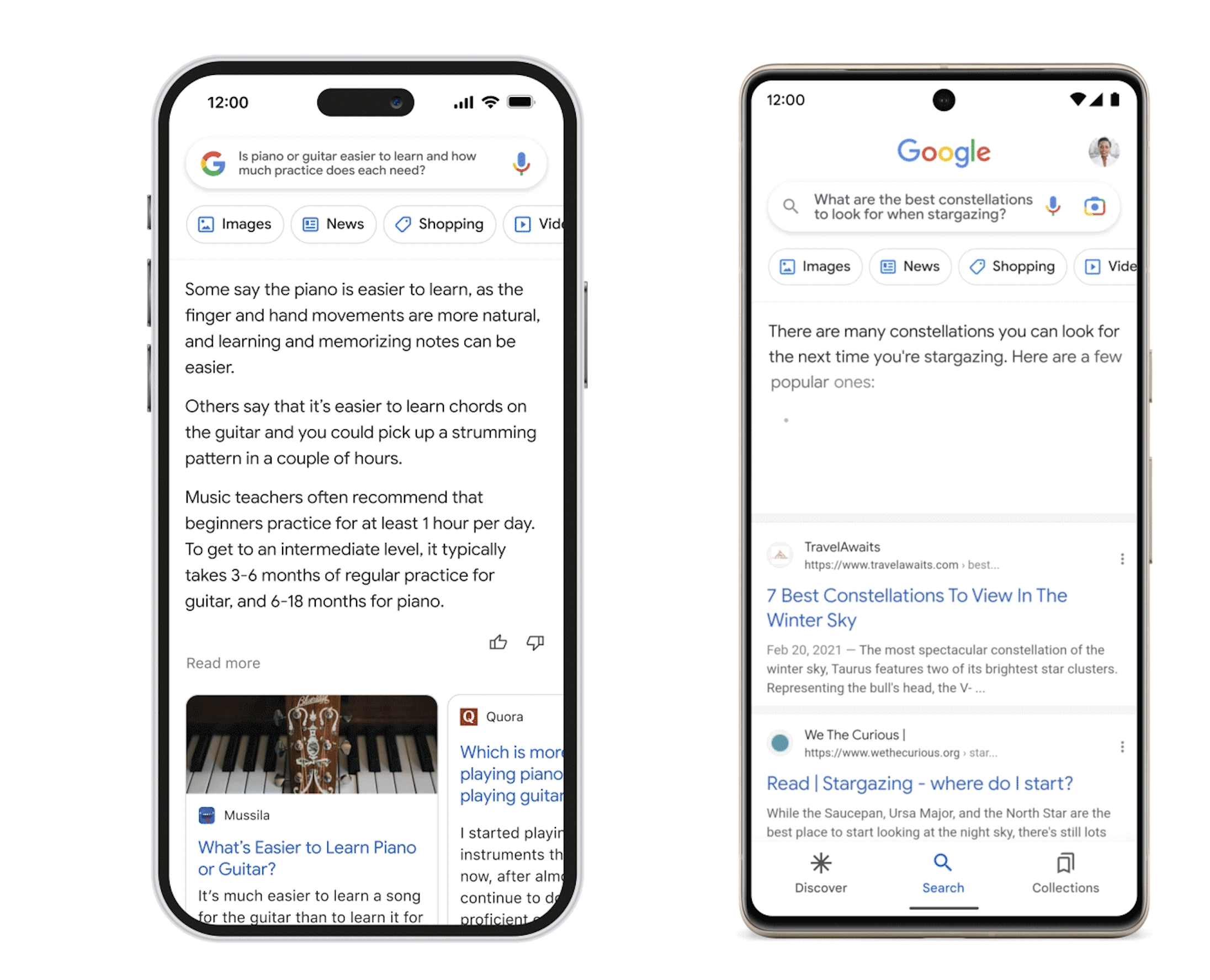

Google Bard是由Google AI开发的大型语言模型(LLM)聊天机器人,它在大量文本和代码数据集上进行训练,可以生成文本、翻译语言、编写不同类型的创意内容,并以多种信息方式回答问题。 Bard的开发是为了应对OpenAI公司推出的ChatGPT聊天机器人。2023年3月,首次以有限规模推出,随后,在2023年5月,扩展到更多国家。2024年2月8日,谷歌Gemini体验与谷歌助理业务副总裁暨总经理Sissie Hsiao在谷歌官网发表博客指出,聊天机器人Bard将会直接称为Gemini,网页版支持40种语言,并将在Android和iOS的Google应用程序上推出新的Gemini应用程序。

Bard电脑交互界面如下图所示:

Bard手机界面交互示意图

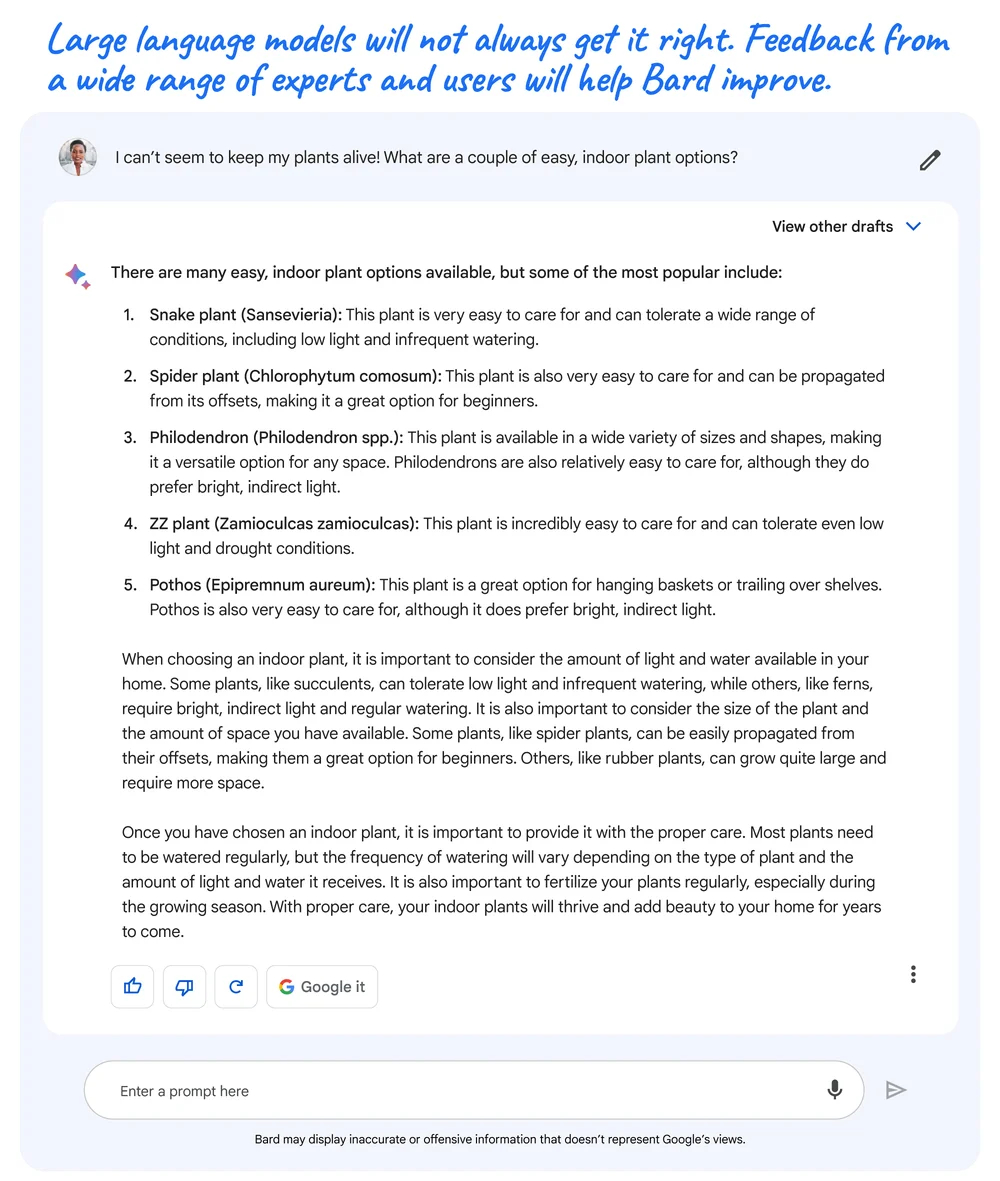

Bard由研究型大型语言模型(LLM)提供支持,可以将LLM视为一个预测引擎,当得到一个提示时,它会从下一个可能出现的单词中一次选择一个单词来生成响应;它每次会选择差异化的单词,产生创意性的回答,因此具有一定的灵活性,使用LLM的人越多,LLM在预测的预测能力越强。

虽然LLM是一项前沿技术,但也有缺点,例如,由于LLMs从广泛的信息中学习,而这些信息反映了现实世界中的偏见和刻板印象,因此这些偏见和刻板印象有时会出现在输出结果中;另外,在展示信息时,也可能提供不准确、误导性或虚假的信息,例如,当它被要求分享几种简易室内植物时,Bard给出了一些方案,但也弄错了植物的学名。

如图所示,在这个回应中,Bard犯了个错误, ZZ植物的学名实际上是Zamioculcas zamiifolia,而不是 Zamioculcas zamioculcas。

目前Google Bard已经有插件可用。可在多种应用程序下直接使用Bard。如:Spotify(音乐)、沃尔玛(零售)、Adobe Firefly(图像创作)、Google Docs(文档编辑)、Google Maps(出行导航)。

语言模型

LLM是谷歌大型语言模型家族,它包含多个不同语言。Bard最初建立在LaMDA系列的基础上,后来过渡到了基于PaLM 2的模型上。Bard的语言模型迭代:

-

LaMDA建立在谷歌2017年发明并开源的神经网络架构Transformer上,是对话应用程序语言模型,为Bard的创建提供了基础。

-

最初版本的Bard使用的是LaMDA的轻量级模型版本,因为它所需的计算能力较低,可以扩展到更多用户。

-

2023年起,Brad由大型语言模型PaLM 2提供支持,该模型在2023年谷歌I/O大会上发布。

-

PaLM 2是PaLM的更高级版本,已于2022年4月发布。

-

2013年,Brad接入Gemini Pro。Gemini Pro是最先落地的一个模型,应用于Bard里。Gemini Pro在Google的数据中心运行,具有快速响应时间和理解复杂查询的能力,将提升聊天机器人在推理、规划和理解方面的能力。2024年初,谷歌将推出Bard Advanced采用Gemini Ultra,预计将是自Bard发布以来的最重大更新。

有趣的是,据谷歌称,ChatGPT的语言模型GPT-3也是基于Transformer构建的。谷歌决定使用自己的LLM,即LaMDA和PaLM 2,这是谷歌的一个大胆决定,因为主流的一些AI聊天机器人,包括ChatGPT和必应聊天、都是用的GPT语言模型。

未来规划

Google对Bard的未来有多项计划,包括:

1)让Bard变得更加贴近生活、更加全球化。 以更多语言提供给世界各地更多的人。

2)提高Bard的能力。Google正在继续培训和提高Bard生成文本、翻译语言、编写不同类型的创意内容以及以信息丰富的方式回答问题的能力。

3)使Bard与其他Google产品和服务更加集成。努力让用户更轻松地从其他Google产品(例如Gmail、Docs和Drive)中访问和使用Bard。

4)为Bard开发新功能和工具。Google正在探索让Bard对用户更加有用和多功能的方法,例如开发代码生成、创意写作和研究协助的新功能。

Google的目标是使Bard成为一款强大且多功能的AI工具,可供各行各业的人们使用,以提高工作效率、创造力和见识。Google为Bard的未来应用方向具体示例如下:

1)Bard扩展

Google正在开发Bard扩展,这是可以与Bard集成以添加新特性和功能的第三方应用程序。例如,Bard扩展可用于生成视频的实时字幕或创建个性化的营销活动。

2)开发者能力

Google通过提供API和文档,让开发人员更轻松地使用Bard构建应用程序。这将使开发人员能够创建新的、创新的方式来使用Bard,例如聊天机器人、虚拟助手和教育工具。

3)为研究员提供便利

Google正在努力开发数据分析和可视化的新功能,让Bard对研究人员更加便利。这将使研究人员能够使用Bard从数据中获得新的视角,并更有效地传达观点。

竞争格局

产业格局

巨头主导,垂类分化

互联网巨头具备先发优势,芯片层、模型层、应用层布局完备。互联网巨头在AI领域投入已久,百度2014年即成立人工智能实验室,阿里、腾讯、字节跳动也于2016年成立人工智能实验室,此后各家在芯片层、模型层及应用层持续探索,不断完善布局,在研发、模型、数据、应用等方面已积累显著的先发优势。

算法模型:追随海外技术进展,研发突破是竞争关键。从技术路线来看,国内大模 型主要追随海外进展。基于谷歌在人工智能领域更高的影响力以及BERT开源代码,前期中国企业在大模型领域的探索更多参考BERT路线。随着ChatGPT在人机对话领域的超预期表现验证了高质量数据+反馈激励(大模型预训练+小数据微调)的有效性,国内大模型技术路线也逐渐向GPT方向收敛。尽管模型架构设计的不同对特定任务上的表现有一定影响,但国内大模型厂商在技术上基本同源,从而导致了现阶段较为相似的模型能力,下一阶段对于GPT方向的研发突破将是竞争关键。

算力:互联网厂商在算力资源上具备优势。随着模型参数和复杂度的提升,大模型对算力的需求也在加速增长。当前国内已发布的大模型中,参数规模达到千亿及以上的厂商仅为10个左右,一定程度上体现出各厂商之间算力能力的差异。

数据:优质开源中文数据集稀缺,自有数据及处理能力构成模型训练壁垒。得益于开源共创的互联网生态,海外已有大量优质、结构化的开源数据库,文本来源既包含严 谨的学术写作、百科知识,也包含文学作品、新闻媒体、社交网站、流行内容等,更加丰富的语料数据能够提高模型在不同情景下的对话能力。而受制于搭建数据集较高的成本以及尚未成熟的开源生态,国内开源数据集在数据规模和语料质量上相比海外仍有较大差距,数据来源较为单一,且更新频率较低,从而导致模型的训练效果受限。因此, 大模型厂商的自有数据和处理能力构成模型训练效果差异化的核心。

资源投入:互联网厂商重研发投入,资金及人才实力领先。大模型的训练需要较高且可持续的研发投入,头部互联网企业兼具高资本密度和高人才密度优势。

场景:业务丰富多元,互联网厂商天然具备落地实践场景。考虑到数据隐私和安全合规,初期通用大模型在行业落地时可能会面临一定的信任问题,从而导致较高的获客成本。而头部互联网平台基于自身在电商、搜索、游戏、金融等领域丰富的业务积累,天然具备落地实践场景。在提高产品效率的同时,也有望率先形成示范效应,从而有助于外部客户和应用的拓展。

格局推演:互联网巨头有望保持领先地位,中小厂商或将面临路径选择。

综合上述分析,结合行业竞争要素,并参考海外当前竞争格局,国内大模型赛道有望形成与海外相似的产业趋势,兼具技术、资金、人才和场景优势的头部互联网企业有望 成为大模型领域的重要玩家,而中小厂商或将面临路径选择。一方面,中小厂商可以利用自身在垂类场景和数据层面积累的优势,成为聚焦垂类的核心特色玩家;另一方面, 基于训练和用户调用带来的算力需求的激增,考虑到资源优势和经济性,中小厂商或将 寻求云厂商的支持和合作。

巨头布局

短看技术突破, 长看生态壁垒

阿里巴巴:2014年即成立了数据科学与技术研究院,2016年成立人工智能实验室,2017年成立达摩院,后续成立AI芯片自研团队作为算力支持,并陆续发布了中文社区最大规模预训练语言模型PLUG和多模态大模型M6。除自研投入外,阿里也在AI核心产业环节积极进行对外投资,在芯片领域投资寒武纪、深鉴科技等,机器视觉和深度学习领域投资商汤科技、旷视科技等,应用领域投资小鹏、小i机器人等。

百度:2011年在硅谷开设办公室,并在2017年提出“All in AI”的公司战略。从AI技术体系来看,百度是国内少数在AI领域全栈自研布局的公司之一,在芯片层、框架层、模型层和应用层均有自研投入。芯片层,百度已有两代自研昆仑芯实现量产,预计第三代昆仑芯将于2024年初实现规模上市;框架层,百度飞桨经过6年开发并逐渐成熟后,成为中国首个开源开放、 功能完备的端到端深度学习平台,截至2022年11月,百度飞桨已有535万开发者,服务了20万家企事业单位,创建了67万个模型;模型层,百度最早于2019年推出文心大模型并不断迭代,并于2021年发布百亿级大模型文心ERNIE 3.0和千亿级大模型文心ERNIE 3.0 Titan;应用层,百度推出生成式AI对话产品文心一言以及面向企业客户的文心千帆大模型平台,通过实践场景验证大模型能力。百度全栈自研布局的优势在于各层之间的反馈有望进一步驱动技术能力的优化,提升迭代效率。2023年以来,随着ChatGPT引发新一轮AI产业热潮,百度亦加速在AIGC及多模态大模型领域的布局, 先后投资text-to-video生成技术与社区的初创企业Morph Studio、人工智能公司西湖心辰及多模态大模型公司生数科技。

腾讯:重视AI发展,内生+外延双轮并驱。腾讯2016年成立AI Lab,并在2017年提出 “make AI everywhere”的战略愿景,2018年建立以人工智能与前沿科技为基础的两大实验室矩阵。对外投资方面,截至2022年底,腾讯共投资53家国内AI公司,多次投资AI算力芯片公司燧原科技、企业级认知智能服务平台明略科技等,并在2023年投资深言科技、MiniMax、光年之外等大模型企业。

字节跳动:2016年成立人工智能实验室,将其定位为公司内部的研究所和技术服务商,为平台输出的大规模内容提供AI技术支持。这段时间,AI研究成果主要与业务相结合,研发重点集中在机器翻译、智能语音、视频图像和多模态等领域,而大模型相关积累相对薄弱。2023年成立大模型团队,搜索、智创两部门牵头。语言大模型团队由搜索部门牵头,图片大模型团队则由产品研发与工程架构部下属的智能创作团队牵头。

模型争议

测试方法

Gemini与ChatGPT测试方法存疑,且分数存在夸大嫌疑

谷歌称Gemini的MMLU的得分率高于GPT-4时,显示GPT-4的得分率是86.4%,但根据谷歌发布的60页技术报告,Gemini Ultra的MMLU测试结果下有 “CoT@32” 的小字注释,表示其使用了思维链提示技巧,尝试了32次并从中选择最好结果。而作为对比的GPT-4却是无提示词技巧给5个示例,在这个标准下,Gemini Ultra的测试结果其实是83.7%,低于GPT-4的86.4%。

同样使用CoT@32的方法,即使成绩仍低于Gemini Ultra,GPT-4的得分率也达到了87.29%。

虚假剪辑

Gemini的演示视频存在剪辑效果

在推出Gemini后,谷歌发布了一个时长六分钟的演示视频,展现了测试员和Gemini的一些有趣互动,其中包括让Gemini识别图片并用多种语言描述、让Gemini利用一张地图设计智力问答、和Gemini玩杯子游戏和推理小游戏等等。在整个过程中,Gemini的反应速度都非常快,还会生成音频和图片来辅助回答,并用上一些口语化乃至幽默化的表达。

但很快,网友发现此视频不是实时录制,而是经过了剪辑。视频演示中向Gemini展示静态图像时,同时有声音读出向Gemini发出的人工提示词。这与谷歌似乎暗示的完全不同:当Gemini实时观察周围的世界并做出反应时,一个人可以与Gemini进行流畅的对话。

谷歌在一篇博客文章中解释了多模态交互过程,基本上也间接承认了只有使用静态图片和多段提示词拼凑,才能达成演示视频中的效果。

官网截图

如上图,在文章中,谷歌承认,不同于视频中对于猜拳手势的快速反应,只有在向Gemini同时展示这三个手势并提示其这是游戏时,Gemini才会得出猜拳游戏的结论。

沃顿商学院教授伊桑·莫利克(Ethan Mollick)也在X平台上进行了演示,如果是使用静态图片和多段提示词,完全可以通过ChatGPT Plus来复制Gemini的表现,如下图所示。

在质疑发酵后,谷歌DeepMind产品副总裁伊莱·柯林斯(Eli Collins)对外媒回应称,视频中的画鸭子演示(画一个鸭子的简笔画,Gemini可以对每一步骤做出正确的解释)确实是研究级别的功能,还未出现在谷歌的实际产品中。

谷歌DeepMind研究和深度学习负责人副总裁奥里奥尔·维尼亚尔斯(Oriol Vinyals)也在X(原推特)平台上发布长文,解释了团队是如何制作该视频的:“视频中的所有用户提示和输出都是真实的,只是为了简洁而进行了缩短。” 维尼亚尔斯还表示:“该视频展示了使用Gemini构建的多模态用户体验是什么样子。我们这样做是为了激励开发人员。”

在谷歌宣布推出“双子星”AI大模型后,不少网民通过问答系统向AI下达指令,但他们发现,这个系统在生成图像时,刻意避免展示白人的形象。此外,该系统还因为执行“多元化”价值观闹出了不少笑话。

如上图所示,一名外国网民在社交媒体发文表示,当自己要求“双子星”生成一张“白人家庭”的图片时,系统表示自己“无法生成针对特定族群的图片”,理由是“此类内容可能存在歧视、刻板印象”。而当该网民要求生成一张“黑人家庭”的图片时,“双子星”则正常按照要求输出了图片。

更荒诞的是,有网民称自己让“双子星”生成“1943年德军士兵”的图片时,系统居然向其展示了由黑人、亚裔和白人女性身穿纳粹德军制服的照片,而这显然和历史事实不符。

随着越来越多网民在网上抱怨类似的问题后,“双子星”系统负责人杰克·克拉夫奇克对美国福克斯新闻等媒体承认,“双子星”之所以出现这些问题,是因为谷歌一直力图让该系统“呈现多元化社会”,而对于网友列举的各种问题,克拉夫奇克表示谷歌团队“正在加紧更正这些情况”。

产品事件

2024年2月24日据美联社报道,对于用户反馈谷歌公司推出的人工智能(AI)模型Gemini在生成人物图像时出现疑似“反白人”的问题,谷歌高级副总裁普拉巴卡尔·拉加万23日进行了道歉。谷歌称,将暂时停止Gemini运行生成人物图像的功能。

2154

2154

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?