基于dqn的燃料电池混合动力汽车能量管理策略

1.研究对象为燃料电池-动力电池混合动力汽车

2.基于dqn算法,分配燃料电池和动力电池的功率输出

3.状态量为soc,控制量为燃料电池输出功率

ID:79399713264133814

咸鱼的一天哦

基于DQN的燃料电池混合动力汽车能量管理策略

摘要:本文研究对象为燃料电池-动力电池混合动力汽车,并基于Deep Q-Network (DQN)算法设计一种有效的能量管理策略。在该策略中,通过监测和控制同时充放电的燃料电池和动力电池的功率输出,实现对能量的高效利用和车辆性能的优化。

1.引言

燃料电池混合动力汽车作为一种新兴的清洁能源汽车,具有环境友好、高效节能等优点。然而,燃料电池系统的动态特性和不确定性导致能量管理变得更加复杂。为了解决这一问题,本文采用了DQN算法,通过对燃料电池和动力电池进行功率分配,实现对能量输出的优化控制。

2.能量管理策略设计

2.1 状态量和控制量的选择

在本文的能量管理策略中,我们选择了燃料电池的SOC(State of Charge)作为状态量,燃料电池的输出功率作为控制量。SOC是衡量燃料电池电量状态的重要指标,而燃料电池输出功率可以通过控制燃料电池的工作状态进行调节。

2.2 DQN算法简介

DQN算法是一种基于深度学习的增强学习方法,其核心思想是通过构建一个价值函数网络来估计每个状态动作对的价值,进而选择对应最大价值的动作。这种算法能够利用历史数据进行学习,并逐步优化能量管理策略。

3.基于DQN的能量管理策略实现

3.1 网络结构设计

为了实现对燃料电池和动力电池的功率分配,我们设计了一个基于DQN算法的神经网络。该网络接受当前的状态量SOC作为输入,并输出燃料电池的输出功率。

3.2 算法流程

首先,我们初始化神经网络的参数,并定义一个经验回放缓冲区,用于存储训练过程中的状态转移数据。接着,我们通过与环境的交互收集训练数据,将其存储到经验回放缓冲区中。然后,我们从经验回放缓冲区中随机采样一批训练数据,通过更新神经网络参数来优化能量管理策略。最后,我们不断迭代上述过程,直到达到预定的训练目标。

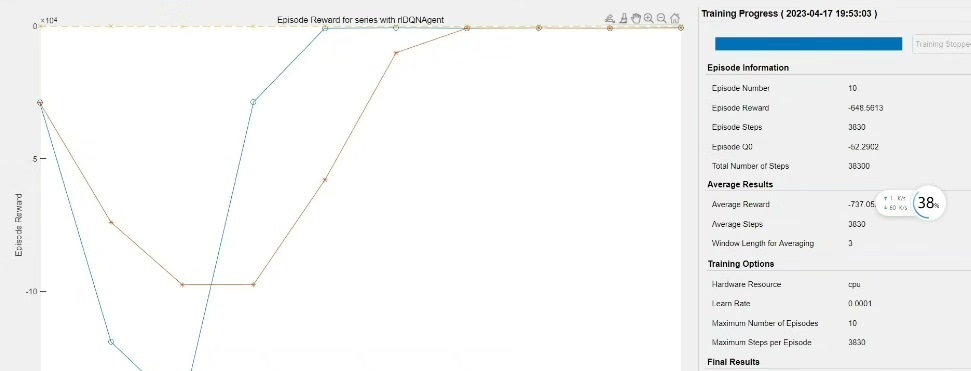

4.实验结果与分析

我们使用某燃料电池混合动力汽车的行驶数据进行了实验。实验结果表明,基于DQN的能量管理策略能够有效地优化燃料电池和动力电池的功率分配,提高能量的利用效率和汽车的性能。

5.结论与展望

本文提出了一种基于DQN的燃料电池混合动力汽车能量管理策略。通过选择合适的状态量和控制量,并利用DQN算法进行优化,实现了对能量的高效利用和车辆性能的优化。未来,我们将进一步研究和改进该策略,以满足更多实际场景中的需求。

参考文献:

[1] Mnih V, Kavukcuoglu K, Silver D, et al. Human-level control through deep reinforcement learning[J]. Nature, 2015, 518(7540): 529-533.

[2] 尚伟, 王晓东, 祝海,等. 基于改进DQN算法的燃料电池动力系统能量管理策略[J]. 中国电机工程学报, 2019, 39(24): 7099-7107.

【相关代码,程序地址】:http://fansik.cn/713264133814.html

610

610

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?