背景

语义分割领域现有的一些捕获更加丰富的上下文信息的方法都是关注于使用不同的空间策略,比如,Pyramid Pooling Module,Atrous Spatial Pyramid Pooling,还有Global Average Pooling。

这些方法的问题是在于利用这些空间内的像素位置的激活值的时候,没有区分像素来自那个类别,无论像素来自哪个类别,周围不同类别的激活对象对上下文的贡献都是相同的,这可能会使像素难以确定它属于哪个类别。

本文提出class center的概念用来描述图像上每个类别的一个全局性的表征,每个标签类的class center都聚合了属于该类别像素位置的所有特征。该方法与上面所提到的方法的不同之处在于,上面的方法关注利用的是空间上下文信息,而该方法利用的是类别上下文信息。

要利用每个类别的上下文信息,就要直到所有像素位置属于哪个类别,这在训练时是没有问题的,因为有Ground Truth,但是在测试的时候即实际应用时,没有Ground Truth,要如何来获得每个像素位置的类别信息呢???没有条件,就需要创造条件,很自然而然地想到可以先进行一次粗分割得到一个粗略的预测图,在利用该预测图来计算近似的class center,后面再利用class center实现精细的分割。

方法

1.Class Center

CCB:Class Center Block

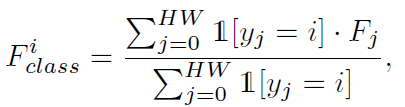

类别i的Class Center:属于类别i的所有像素的平均特征(特征图上的平均响应值)

理论:在label上计算

类别i的class center=(label上类别i在每个通道上对应位置预测值累加和)/(label上类别i的像素个数)

实际:在粗分割图和特征图

上计算,先将

的维度reshape成

,使用1*1卷积减少F的通道数然后reshape得到

Class Center的两个好处:

- 每个类别的class center都表达了该类别的全局信息,在训练时可以帮助模型学习到每个类别之间的鉴别力的特征

- class center可以帮助检查一个像素与每个类别的class center之间的一致性,通过引入class center,模型可以纠正一些之前被错分的case

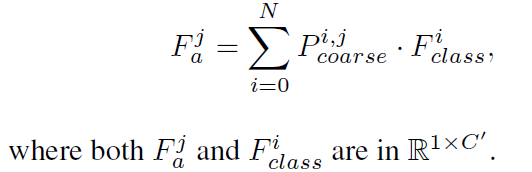

2.Attentional Class Feature

CAB:Class Attention Block

直接使用粗分割图作为attention map,再利用class center来计算得到attention class feature:

然后后面再跟着一个1*1的卷积,细化计算得到的特征

3.Attentional Class Feature Network

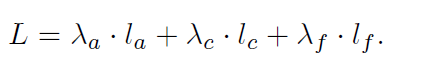

Loss Function:三项辅助监督损失,粗分割损失

,精细分割损失

968

968

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?