以前导师要求写的文献综述,对我随后的研究工作有了积极的影响,个人感觉越是尽早将看到的、读到的进行总结(写综述),越能进入状态

另外,我写的东西我不负责哦~

参考文献那里有些格式不准确,我也懒得改了,切记勿照抄

第一章 前言

1.1 背景

伴随着互联网与移动终端的飞速发展,图片作为信息的主要载体之一早已融入到人们生活的方方面面。数据量的激增,使人们不得不面临这样一个问题:如何快速有效地从庞大的图片集中筛选出自己想要的内容。目前,对于解决图像检索问题,绝大多数检索系统[1][2]采用的是基于图像内容检索(CBIR, Content-Based Image Retrieval)的方法,即通过查询每张图片事先标注好的“关键字”来进行“关键字”的检索,当然这里的“关键字”并不是文字,而是图像的颜色、纹理、形状、空间位置关系等特征。

但CBIR并不能完全满足用户的需求。例如,用户所想要检索的图片并没有数字格式,即图像存于大脑,无法使用CBIR以图搜图,用户也无法通过语言来描述该图,或描述过程过于复杂,或描述方式不够准确。鉴于上述场景,行之有效的方法就是让用户将脑海里的图片,以草图的形式绘制下来,然后通过草图来检索图片:提取图片库的特征,与检索请求中草图的特征进行相关度计算,系统返回相关度排序后值最大的前k张图片,记作top-k,该top-k序列的图片子集即是检索结果,这就是基于草图的图像检索(SBIR, Sketch-Based Image Retrieval)的核心思路[3][4][8][14]。

1.2 研究方向

SBIR已研究了25余年[9],检索步骤逐渐归拢为一个定式:将图片转化为草图,以草图搜草图。本文将近10年的研究方向总结为以下三点:

- 图像转草图

- 图像草图化后的特征提取

- 检索方式

图像转草图,目前多是使用边缘滤波器,Canny滤波器、Sobel滤波器、Laplace滤波器[5][6][8][21]。对于边缘提取算法,本文发现近十年来均未讨论其算法改进问题,因此认为数学层面或已无创新之处。不过E. Mathias、Zhang Y、Cheng M M等研究团队均讨论到,对于人类而言,使用简单笔画“复述”一副图片,优先绘制的是图中最吸引眼球的“精彩点”——显著区域的图像轮廓[8][14][15]。因此,若能提取出显著区域再与草图进行匹配,将大大提高匹配准确率,此内容较为特殊,将放在第二章特征提取方法的其他方法里进行说明。

对于SBIR中的特征提取,除开深度神经网络(本文立足于传统意义上的图像匹配,而深度学习计算量巨大,对于百万数据集别的图片集,使用传统特征提取方法更佳合理),常见的提取方法可以分为以下三类:全局特征描述符(Global descriptor),从整张图片中提取足以描述整张图片内容的全局特征;局部特征描述符(Local descriptor),由图像的单位区域得到图像的局部特征;其他,从三维图形检索借鉴而来的基于物体轮廓的特征提取技术,可归为局部特征。而检索方法,则归为两类。本文接下来将会分为两个部分,分别对上述特征提取方法与检索方法进行详细介绍,并使用具有代表性的论文来分析使用该特征提取方法、检索方法的优缺点。

1.3 研究前景

研究者将检索分为两个层次:粗粒度(coarse-grained)检索与细粒度(fine-grained)检索[18]。对于SBIR而言,粗粒度检索或称为类别级别(category-level)检索,是传统的草图检索(SG-SBIR)形式;细粒度草图检索(FG-SBIR, fine-grained SBIR),是一个新兴的概念[16][17][18],针对草图的细节进行图像匹配,Yu Q [17]抛弃了传统特征提取方法转而使用卷积神经网络,从效果上看比Li K [18]更好。

例如,用户检索鞋,SG-SBIR能为用户返回一系列鞋的图片,这比用户输入文字“鞋”而不是画出鞋的外观的检索方式更加复杂,而FG-SBIR[17][18]却能根据用户草图的细节返回与这些细节对应的鞋,如下图1所示。

图 1 FG-SBIR下的鞋物检索

本文认为细粒度检索这一概念是很有研究前景的,或是使用SG-SBIR与其它技术结合,克服FG-SBIR中使用神经网络带来的计算耗时巨大的缺点,达到FG-SBIR中细粒度检索的能力。

第二章 特征提取方法

2.1 全局特征描述符

对于全局特征描述符,出发点在于对图片整体内容的描述,相比局部特征描述符更加“宏观”,不需要考虑图像局部的内容,因此拥有计算量较局部特征描述符更少、特征存储空间更小的优点。它能够胜任图像的匹配、分类工作,但却无法适用于图像出现局部仿射变换的情况,即当图像经过透视扭曲后,全局特征描述符无法将其与原图归为一类。现有的全局特征描述符主要有下列几种:GIST, HoG及衍生算法。

2.1.1 GIST

GIST这个概念最初源自Friedman A[10]对用于激活记忆的场景的抽象描述;后被Oliva A等人[11]借用,作为文中提出的一种新型的特征描述符:空间包络(Spatial Envelope)的理论基础[11];随后GIST正式被定义为全局特征描述符,其视觉描述子从以前的5个增长到8个,用于描述场景特征。

作为GIST特征的前身,空间包络使用5个视觉描述子来描述图像的视觉特征。它使用离散傅里叶变换(DFT, the discrete Fourier transform)与加窗傅里叶变换(WFT, the windowed Fourier transform)将图像从空间域转换到频谱域,见图2所示,不同的场景拥有不同的频谱图,可以发现,视觉描述子近似的图片,其频谱图的形状类似。

图 2 GIST特征提取示意图

凭借这一规律,作者随后提出了判别谱模(DST, Discriminant spectral templates)与加窗判别谱模(WDST, windowed Discriminant spectral templates)这两个特征量,以此度量上述5个视觉描述子。分类时使用了PCA(Principal Component Analysis)降低特征维度,分类算法使用的是K-NN。

Torralba A等人[12]对其进行改良,将分类算法从K-NN改为隐含马尔科夫模型(HMM, hidden Markov model),Siagian C [13]则是将图片分块,如下图3所示,提取单位区域的GIST特征,进而增加特征信息,经过实验表明,较原始GIST,分块提取的准确率更高。

图 3 改良的GIST特征示意图

2.1.2 HOG与DPM

HOG作为图像人体检测算法的特征描述子表现优异,本质是统计图像的梯度方向,突出图像中的纹理与边缘信息,它的前身是EHD[5][21],对于SBIR近年来并没有使用传统的HOG算法,而是使用HOG的改进算法或是衍生算法。

Tu B等人[20]则是使用HOG改进算法GF-HOG(Gradient Field HOG),结合草图的笔画颜色信息来进行图像检索,GF-HOG统计的不是图像所有的像素点的HOG,而是统计图像中作为边的像素点的HOG,如下式:

( 2-1 )

( 2-1 )

M代表图像中坐标为(x,y)的像素点,若像素点在已提取的边上,则M(x,y)=1,随后寻找M附近的空间的梯度方向,得到M的GF-HOG特征值。

由于HOG对目标的形变十分敏感,即若图像中的物体产生了形变,HOG无法判断目标形变前后是否是同类物体,而实际上目标形变前后是同一物体,因此人们提出了DPM算法以解决这个问题。

DPM算法对目标的形变具有很强的鲁棒性,是一种基于部件的检测方法。 Li Y[16]将其算法应用于SBIR,不过不同于过去方法[17][18]强调草图所描述的物体的细节,而是强调草图描述物体的朝向、观测视角。Li Y [16]将DPM特征扩充至两层结构,第一层为传统DPM特征,称之为根过滤器(root filter),第二层为含DPM的每个星状图的图信息,称之为部分过滤器(part filter),而在特征匹配时,不仅匹配DPM的相似度,还会匹配星状图的相似图。Li K[18]中使用了Strongly-Supervised DPM(SS-DPM),因为普通DPM在提取特征后需要使用latent-SVM训练模型,而latent-SVM的初始值采用自启发算法,分类可能不准确,而SS-DPM的监督特性能提高latent-SVM分类的准确度。

2.1.3 小结

正如前文所述,全局特征描述符是对图像整体“场景”的描述,虽能提高特征提取速度,降低特征存储空间,但大前提是忽略了图像细节。对于图像识别领域,放弃了对细节的把控,失去了对图像内部物体的匹配,计算机并不知道目标图像内部有什么,这是没有意义的。因而近几年研究人员对于全局特征描述符的研究表现冷淡,除了一些应用外,均是从算法层面入手将其转换为局部特征,因此第二节将会说明上述传统特征提取的改进算法。

2.2 局部特征描述符

局部特征描述符拥有仿射不变性,与全局特征描述符恰恰相反,它是从单张图片某一特定区域提取特征。局部特征提取是近年来研究SBIR系统最为推崇的方法,可以说是SBIR的研究热点。目前比较热门、特征提取效果较好的方法主要有下列几种:ShapeContext、SHOG、TENSOR描述子、EI边缘统计。

2.2.1 ShapeContext与SparkFeature

ShapeContext具有在图像形状发生倾斜、位移、大小等平面变换时有较好匹配的特点[21][22],是一种经典的形状识别特征,与SIFT拥有同等地位[21]。传统的ShapeContext针对封闭的轮廓提取特征,它抽取封闭轮廓上的等距样本点与其余样本点的相对向量作为该点的上下文信息,该描述子在非刚性物体的匹配中具有很好的鲁棒性。

对于SBIR而言,草图若没有封闭——室外场景多使用线条勾勒,不会产生封闭形状——ShapeContext描述子效果较差,Eitz M等人[6]优化其算法使之适应SBIR:图4所示。其步骤为,在提取出图像的边缘(黑色线条表示)后,随机选取边缘上的点作为特征点(橘色圆圈),记作特征点集

U

U

U,设置阈值

γ

γ

γ,若特征点

i

i

i(红色点)与附近的点相距

d

<

γ

d<γ

d<γ,则纳入

i

i

i的相临点集,后统计

i

i

i的相临点集的极坐标直方图,作为

i

i

i的ShapeContext特征,遍历

U

U

U,得到所有特征点对应的特征值。

图 4 ShapeContext特征的示意图

Eitz M等人[6]接着提出了ShapeContext的改进算法SparkFeatures,如下图5所示。其步骤为,在提取出图像的边缘(黑色线条表示)后,对图像进行随机采样,对每个采样点(绿色圆圈)进行如下操作:从该点出发,随机方向发散,若能够到达图像边缘,则记录其距离与向量信息,发散数为定值,统计所有发散到达边缘点的极坐标直方图。

图 5 SparkFeatures特征的示意图

2.2.2 SHOG

Eitz M[6]提出的改进的HOG特征描述子,不同于HOG的全局特性,SHOG是局部特征描述子,见图6,在提取出图像的边缘(黑色线条表示)后,对图像进行随机采样,对每个采样点(绿色圆圈)进行如下操作:以该点为中心,设置网格,统计每个网格中包含边缘的那个网格的HOG特征,后得到所有采样点的HOG特征集合,称之为SHOG特征。

图 6 SHOG特征的示意图

Eitz M等人[6]的实验表明,SHOG较ShapeContext与SparkFeatures、EHD、ARP、TENSOR效果更好,不过文中并没有给出PR曲线,所以其结果存疑。

2.2.3 TENSOR

TENSOR是Eitz M[5]提出的局部特征描述符,对于每个单位区域(Cell)记作

C

i

j

C_{ij}

Cij,不同于HOG将梯度信息离散化至直方图,TENSOR使用一个向量

T

I

J

T_{IJ}

TIJ来代表该单位区域

C

i

j

C_{ij}

Cij的梯度信息,设存在一单位向量

x

x

x,通过式2-2

( 2-2 )

( 2-2 )

代表该单位区域 C i j C_{ij} Cij的主要梯度方向,其中 g u v g_{uv} guv是 C i j C_{ij} Cij中的梯度向量,经过式( 2-3 )与式( 2-4 )变换,使 G i j G_{ij} Gij拥有全部 C i j C_{ij} Cij的梯度信息,

( 2-3 )

( 2-3 )

( 2-4 )

( 2-4 )

其中

λ

λ

λ是拉格朗日乘子,经过frobenius范数变换得到最终的TENSOR特征,记为

T

I

J

T_{IJ}

TIJ。

( 2-5 )

( 2-5 )

对于TENSOR特征相似度的计算,则是使用frobenius范数的差异,后将所有TENSOR特征进行累加求和,得到两个特征集合的距离,通过距离来衡量其相似度。

Eitz M等人[21]将TENSOR与HOG在ARP、EHD的检索结果为基准下进行对比,同样地(与他们的工作[5]对比),使用15万Flickr图片集,为检测系统的鲁棒性,将图片缩放、旋转,发现在网格(grid, 每个grid下有多个cell,grid作为多个cell的向量集合,该集合作为描述符的一个特征) 不同大小下,TENSOR的效果更好。不过Eitz M等人的工作[21]较[5]的不同之处在于,使用参数的变化范围更广,且手绘草图的采集方式有两个,一是临摹,二是凭借记忆绘制。

论文[5] [21]均提到,对于大量图片集而言,当时并没有一个标准来度量检索结果的好坏,Eitz M等人[5] [21]使用的是,赋予图片分值,当检索系统返回对应图片后,就为该检索方法加相应分数。为更客观,在后续工作中建立了一个标准数据集[6][8]。

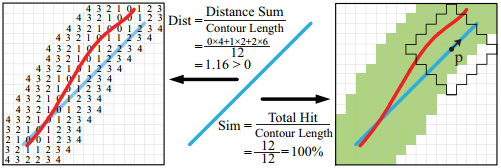

2.2.4 EI

Y. Cao等人[4]提出了一种新的边缘特征匹配算法EI(Edgel Index Algorithm),由于特征空间数据量极大(可达55GB,正常服务器无法处理),因此使用高效检索架构(Structure-consistent Sketch Matching, SSM)对相似度计算(即草图匹配)进行了优化,并提出了经过简化的边缘匹配方式IOCM(Indexable Oriented Chamfer Matching)。如下图7所示,左侧为原始OCM(Oriented Chamfer Matching) [23],右侧为作者提出的IOCM(Indexable Oriented Chamfer Matching)。

图 7 OCM与IOCM算法示意图

当待测边(query contour,红线)在目标边(object contour,蓝线)由IOCM生成的范围(绿色区域)内,则带侧边与目标边匹配,记作Hitmap,如下式定义:

( 2-6 )

( 2-6 )

计算各个方向(文中将其离散化为6个)上的Hitmap作为EI算法的特征量。

对于草图匹配,本文设计了SSM,分为三步,其中D代表Database,Q代表Query:第一步,D->Q,统计Hitmap为D中的图片打分,该步检索记作EI-1;第二步,Q->D,使用第一步的分数选出Top-N的图片与草图计算相似度,降低了待匹配图像的数量,该步检索记作EI-2;第三步,Q,D,使用下式( 2-7 )将EI-1与EI-2的相似度结果融合到一起,作为最终相似度,该步检索记作EI-S。

( 2-7 )

( 2-7 )

对于图像链接到草图方面,[4]使用的是Berkeley detector寻找图片的边缘信息。

2.2.5 小结

Eitz M[21]中说到,TENSOR比HOG的效果更好,而后续研究说明,SHOG较ShapeContext以及衍生算法SparkFeature更适合SBIR[6],同时期的Y. Cao [4]则表示,他们提出的方法EI较TENSOR更好,而这些实验[4][6][21]中的方法并没有使用统一的数据集在同等的条件下进行比较,因此结论的准确性不得而知,不过Eitz M 等人[6]除了提出的SHOG外,他们另一个贡献是耗费大量人力物力建立的对SBIR的检索结果较客观的评价指标。

上述文章均为未使用SIFT,这是因为SIFT的匹配更加精确,它具有诸多不变性,而手绘草图具有很强的随意性(free sketch),精确的搜索将会导致检索数据集的缺失,草图检索需要“模糊”的匹配。

2.3 其他方法

由于Cheng M M研究团队[15][24]的系列研究,使得从图像抽取显著区域的效果变得很好,能够模拟人类看到图像后,以此为基准绘制草图的这一过程中人类所绘制的目标物体,即显著区域,如下图8所示,若希望参照左图绘制草图,那么人类会寻找左图的显著区域:乌鸦,将乌鸦这一内容作为草图绘制,因此可以预见草图的样子大致会与右图一致。

图 8 显著区域示意图

上述内容为草图检索提供了两种新的思路:一是借鉴三维图形检索中的轮廓匹配方法,由草图轮廓搜图像轮廓;二是经过显著区域的过滤后,再对显著区域中的图像使用提取图像边缘的传统草图检索方法[14]。

对于第一种思路,即轮廓检索,目前较新的方法有GALIF[7]、HOAD[25];而对于第二种方法,有ARP、AROP[14]。

2.3.1 GALIF

Eitz M等人[7]提出了基于局部线条的Gabor特征描述符GALIF(Gabor Local Line-based Feature)。GALIF对一个特征点进行8个方向的滤波特征提取,它能够很好地提取图像的局部线条特征。

图 9 GALIF特征示意图

如上图9所示,对于图像 I I I,使用不同方向的Gabor滤波 g i g_i gi后产生滤波图 R i R_i Ri,接着将 R i R_i Ri分解为 n ∗ n n*n n∗n的区域,计算各个区域中所有点的灰度平均值作为一个特征量,最后会得到 i ∗ n ∗ n i*n*n i∗n∗n个特征值组成的特征向量,并使其归一化,这就是GALIF特征的提取方法。

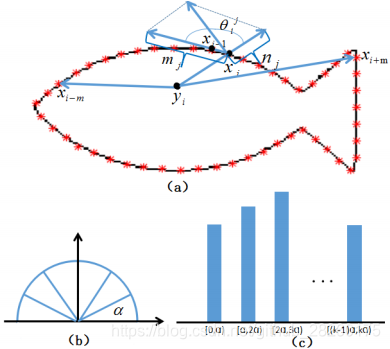

2.3.2 HOAD

Wang F等人[25]提出了HOAD(Histogram of Orientation Angular Distribution)作为三维图形检索的特征,如下图10所示,

图 10 HOAD特征示意图

对于上图轮廓,首先将该轮廓转化为封闭图形,后在该轮廓上均匀采样,计算采样点集的重心,后计算重心到每个采样点的方向,并将该方向离散化后使用直方图进行统计,最终得到HOAD特征。

2.3.3 ARP与AROP

ARP特征仅仅是粗略地统计了图像轮廓的像素个数,并没有考虑到图像轮廓含有的梯度方向信息,而HOG作为统计图像梯度信息的特征已在图像识别领域得到了广泛的应用,因此Zhang Y等人[14]将ARP特征进行了改进,提出了一种新的特征,记作AROP(Angle, Radius and Orientation Partition),该特征的提取方法见下图11,

图 11 ARP特征示意图

将图像(a)按(b)所示分割为多个区域,每个区域拥有自己的角度、半径信息,统计每个区域的梯度方向信息,类似HOG方法,将每个区域的梯度方向信息离散化,最终得到AROP特征。

第三章 检索算法

现有的方法多是在提取草图与图像的特征后,计算两者的距离,作为草图与图像的相似度,然后对相似度进行排序,返回相似度排序序列中的Top-N作为检索结果。

对于图片集十分巨大导致检索速度变慢的问题,研究人员多是对这个N进行修改,因为在实际情况中,人们在使用手绘检索时,关心的是检索的准确度,而不是检索返回图片的数量,因此在检索的时候,只需要匹配某一类别的“关键图”即可,这也是前文提到的类别级别(category-level)检索的思路。Y. Cao[4]中使用的草图搜图片、图片搜草图这两步预处理也是在修改N的大小。

而Eitz M等人[5][6][7]使用了一种类似文本推荐系统BoW(Bag of Words)的方法BoF(Bag of Features)作为检索算法。实际上BoF算法在[5][6][7]之前就有研究者提出,它的主要思想是,对图像库中的所有图像提取特征,后使用K-means进行聚类产生“词汇”,使用tf-idf方法统计每幅图像中的“词汇”的权重,后用草图的“词汇”表乘以权重得到该草图的“分数”,根据“分数”高低返回图像集合。

Wang F等人[25][26]则是提出,使用推荐系统来提高检索系统的准确性:就系统而言,若含有相当量的历史用户,他们已经完成了检索,即系统中存有他们的历史草图,当新用户进行检索的时候,推荐系统通过相似度比对该用户与历史用户的手绘风格,若该用户检索历史用户已经检索过的内容,系统则将该历史用户推荐给新用户,检索系统返回这项历史内容,以此来提高检索准确性。

第四章 总结

本文叙述了近十年关于基于草图的图像检索的方法,如前文所述,草图检索可以分为两大部分:特征提取与图像检索。对于特征提取,本文论述了全局特征描述符与局部特征描述符,全局特征描述符是对图像整体“场景”的描述,虽能提高特征提取速度,降低特征存储空间,但大前提是忽略了图像细节;局部特征描述符,虽能达到对图像细节把控的目的,但单张图片含有特征数目过多,致使特征存储空间过大,并不适合大数据环境下的图像集。进而在检索步中进行降维处理,通过降维处理减少特征存储空间的消耗,这就是BoW技术的应用。BoW技术能显著地加快特征匹配速度,对于大数据环境而言,BoW技术能够解决数据爆炸的问题。

正如前文所讨论的,结合局部特征描述符与BoW技术,能够提高草图检索的准确性。因此,对于草图检索而言,本文认为对,若想在草图检索效果上有所提高,除了发现新的特征描述符外,改进BoW技术也是另一个可行的研究点。

参考文献

[1] X. Yang, X. Qian, and Y. Xue, “Scalable mobile image retrieval by exploring contextual saliency,” IEEE Trans. Image Process., vol. 24, no. 6, pp. 1709–1721, Jun. 2015.

[2] Guo J M, Prasetyo H. Content-based image retrieval using features extracted from halftoning-based block truncation coding.[J]. IEEE Transactions on Image Processing, 2015, 24(3):1010-24.

[3] A. Chalechale, G. Naghdy, and A. Mertins, “Edge image description using angular radial partitioning,” Proc. IEE, vol. 151, no. 2, pp. 93–101, Apr. 2004.

[4] Y. Cao, C. Wang, L. Zhang, and L. Zhang, “Edgel index for largescale sketch-based image search,” IEEE Comput. Soc. Conf. Comput. Vis. Pattern Recog., Jun. 2011, pp. 761–768.

[5] Eitz M, Hildebrand K, Boubekeur T, et al. A descriptor for large scale image retrieval based on sketched feature lines[C]// Eurographics Symposium on Sketch-Based Interfaces and Modeling. ACM, 2009:29-36.

[6] Eitz M, Hildebrand K, Boubekeur T, et al. Sketch-Based Image Retrieval: Benchmark and Bag-of-Features Descriptors[J]. IEEE Transactions on Visualization & Computer Graphics, 2011, 17(11):1624-1636.

[7] Eitz M, Richter R, Boubekeur T,et al. Sketch-Based Shape Retrieval[J]. ACM Transactions on Graphics (Proceedings SIGGRAPH), 2012, 31(4):31-1—31-10

[8] E. Mathias, H. James, and A. Marc, “How do humans sketch objects?” ACM Trans. Graph., vol. 31, no. 4, pp. 44-1–44-10, 2012.

[9] Kato T, Kurita T, Otsu N, et al. A sketch retrieval method for full color image database-query by visual example[C]// Iapr International Conference on Pattern Recognition, 1992. Vol.i. Conference A: Computer Vision and Applications, Proceedings. IEEE Xplore, 1992:530-533.

[10] Friedman A. Framing pictures: the role of knowledge in automatized encoding and memory for gist[J]. J Exp Psychol Gen, 1979, 108(3):316-355.

[11] Oliva A, Torralba A. Modeling the Shape of the Scene: A Holistic Representation of the Spatial Envelope[M]. Kluwer Academic Publishers, 2001.

[12] Torralba A, Murphy K P, Freeman W T, et al. Context-based vision system for place and object recognition[C]// IEEE International Conference on Computer Vision, 2003. Proceedings. IEEE, 2003:273-280 vol.1.

[13] Siagian C, Itti L. Rapid Biologically-Inspired Scene Classification Using Features Shared with Visual Attention[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2007, 29(2):300.

[14] Zhang Y, Qian X, Tan X, et al. Sketch-Based Image Retrieval by Salient Contour Reinforcement[J]. IEEE Transactions on Multimedia, 2016, 18(8):1604-1615.

[15] Cheng M M, Zhang G X, Mitra N J, et al. Global contrast based salient region detection[C]// IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2011:409-416.

[16] Li Y, Hospedales T M, Song Y Z, et al. Fine-grained sketch-based image retrieval by matching deformable part models[J]. 2014. in Proc. BMVC, 2014, pp. 1–12.

[17] Yu Q, Liu F, Song Y Z, et al. Sketch Me That Shoe[C]// Computer Vision and Pattern Recognition. IEEE, 2016:799-807.

[18] Li K, Pang K, Song Y Z, et al. Synergistic Instance-Level Subspace Alignment for Fine-Grained Sketch-Based Image Retrieval[J]. IEEE Transactions on Image Processing, 2017, PP(99):1-1.

[19] Ren X, Ramanan D. Histograms of Sparse Codes for Object Detection[C]// IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2013:3246-3253.

[20] Tu B, Collomosse J. Scalable Sketch-Based Image Retrieval Using Color Gradient Features[C]// IEEE International Conference on Computer Vision Workshop. IEEE Computer Society, 2015:1012-1019.

[21] Eitz M, Hildebrand K, Boubekeur T, et al. An evaluation of descriptors for large-scale image retrieval from sketched feature lines[J]. Computers & Graphics, 2010, 34(5):482-498.

[22] Belongie S, Malik J, Puzicha J. Shape Matching and Object Recognition Using Shape Contexts[C]// IEEE International Conference on Computer Science and Information Technology. IEEE, 2010:509-522.

[23] B. Stenger, A. Thayananthan, P. Torr, and R. Cipolla. Modelbased hand tracking using a hierarchical bayesian filter. PAMI, 2006

[24] Cheng M M, Warrell J, Lin W Y, et al. Efficient Salient Region Detection with Soft Image Abstraction[C]// IEEE International Conference on Computer Vision. IEEE, 2013:1529-1536.

[25] Wang F, Lin S, Luo X, et al. A Data-Driven Approach for Sketch-Based 3D Shape Retrieval via Similar Drawing‐Style Recommendation[C]// Computer Graphics Forum. 2017.

[26] Wang F, Lin S, Wu H, et al. Data-driven method for sketch-based 3D shape retrieval based on user similar draw-style recommendation[C]// SIGGRAPH Asia. ACM, 2016:34.

3216

3216

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?