Llama 3 的推出标志着 Meta 基于 Llama 2 架构推出了四个新的开放型大语言模型。这些模型分为两种规模:8B 和 70B 参数,每种规模都提供预训练基础版和指令调优版。所有版本均可在各种消费级硬件上运行,并具有 8000 Token 的上下文长度。

GpuMall智算云 | 省钱、好用、弹性。租GPU就上GpuMall,面向AI开发者的GPU云平台

Meta-Llama-3-8b: 8B 基础模型

Meta-Llama-3-8b-instruct: 8B 基础模型的指令调优版

Meta-Llama-3-70b: 70B 基础模型

Meta-Llama-3-70b-instruct: 70B 基础模型的指令调优版

GpuMall智算云 | 省钱、好用、弹性。租GPU就上GpuMall,面向AI开发者的GPU云平台

与 Llama 2 相比,Llama 3 最大的变化是采用了新的 Tokenizer,将词汇表大小扩展至 128,256(前版本为 32,000 Token)。这一更大的词汇库能够更高效地编码文本(无论输入还是输出),并有可能提升模型的多语种处理能力。不过,这也导致嵌入层的输入和输出矩阵尺寸增大,这是小型模型参数增加(从 Llama 2 的 7B 增至 Llama 3 的 8B)的主要原因之一。此外,8B 版本的模型现在采用了分组查询注意力(GQA),这是一种效率更高的表达方式,有助于处理更长的上下文。#autodl#恒源云#矩池云#算力云#autodl 官网#AutoDL#AutoDL算力云#autodi#GpuMall#GPU云#GpuMall智算云#GpuMall#AI#大数据#算力租赁#大模型#深度学习#人工智能#算力变现

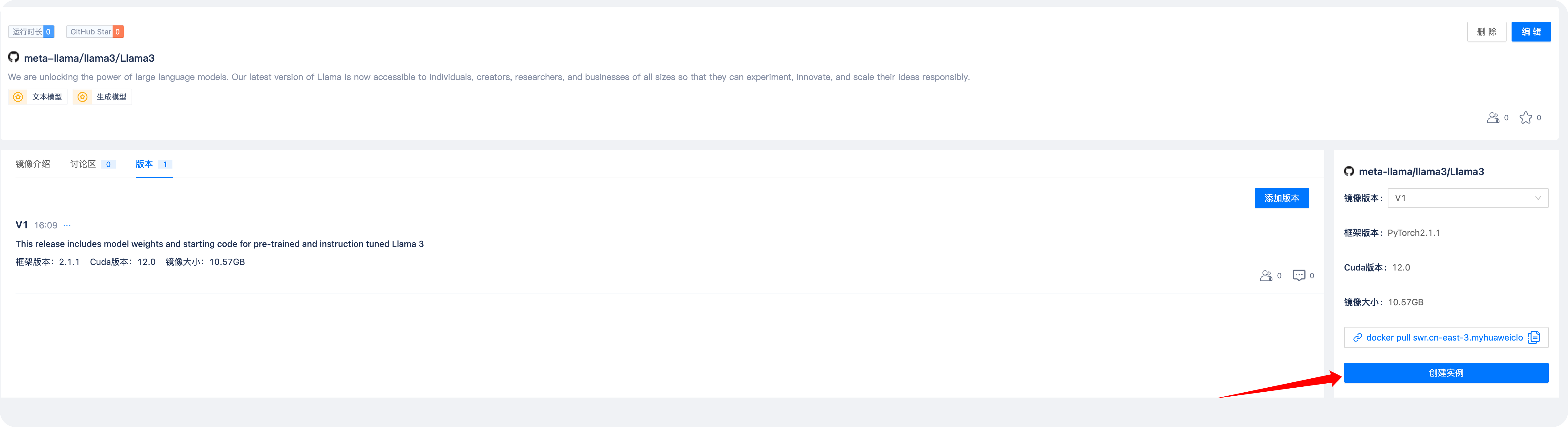

使用Llama3镜像创建实例

点击创建实例

选择高可用云

然后选择GPU去创建实例,8B和8B-instruct 需要选择大于16G显存的GPU资源,如果需要使用 70B则需要更高显存显卡。

进入实例复制模型到数据盘

cp -rf /gm-models/Llama3/Meta-Llama-3-8B-Instruct /gm-data/

1

运行测试

cd /root/llama3/

torchrun --nproc_per_node 1 example_chat_completion.py \

--ckpt_dir /gm-data/Meta-Llama-3-8B-Instruct/ \

--tokenizer_path /gm-data/Meta-Llama-3-8B-Instruct/tokenizer.model \

--max_seq_len 512 --max_batch_size 6

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?