高德地图官方导航部分Demo使用android sdk 24编译,执行会崩溃。经过和高德工程师的交涉得知,地图中使用了科大讯飞的语音模块,崩溃的就是语音部分。探究一下科大讯飞语音识别,在此记录一下成长点滴!

这里使用的是科大讯飞

科大讯飞API提供的功能

语音合成

将一段文字转换为成语音,可根据需要合成出不同音色、语速和语调的声音,让机器像人一样开口说话。

语音听写

将一段语音转换成文本,把语音中包含文字信息提取出来,并可以优先识别用户手机特有的联系人和个性化数据。

语法识别

判断用户所说的内容是否与预定义的语法相符合, 主要用于识别用户是否下达某项指令,使用语法识别前,需要先定义语法。

语义理解

在语音听写基础上,分析理解用户的说话意图,返回结构化的指令信息。开发者可在语义开放平台定义专属的问答格式。

语音评测

通过智能语音技术自动对发音水平进行评价,给出用户综合得分和发音信息。

声纹密码

据语音波形反映说话人生理和行为特征的语音参数,自动识别说话人身份,声纹识别所提供的安全性可与其他生物识别技术(指纹、掌形和虹膜)相媲美。

人脸识别

基于人的脸部特征信息进行身份识别的一种生物识别技术,可以自动在图像中检测和跟踪人脸,进而对检测到的人脸进行检测和验证。系统同时支持人脸关键点检出、视频流人脸检测等功能,识别率高达 99%。

由于时间和能力限制,这里仅仅对语音听写&&语音合成中的云服务部分进行简单探究。

环境搭建

到讯飞官网,申请一个开发者账号,创建一个应用,下载相应的sdk,添加相关的jar和so文件。

1.在Application中完成讯飞模块的初始化

@Override

public void onCreate() {

super.onCreate();

// 将“12345678”替换成您申请的 APPID

// 请勿在“ =” 与 appid 之间添加任务空字符或者转义符

SpeechUtility.createUtility(context, SpeechConstant.APPID +"=12345678");

SpeechUtility.createUtility(this, SpeechConstant.APPID +"=12345678");

}2.添加相应的权限

<!--连接网络权限,用于执行云端语音能力 -->

<uses-permission android:name="android.permission.INTERNET" />

<!--获取手机录音机使用权限,听写、识别、语义理解需要用到此权限 -->

<uses-permission android:name="android.permission.RECORD_AUDIO" />

<!--读取网络信息状态 -->

<uses-permission android:name="android.permission.ACCESS_NETWORK_STATE" />

<!--获取当前wifi状态 -->

<uses-permission android:name="android.permission.ACCESS_WIFI_STATE" />

<!--允许程序改变网络连接状态 -->

<uses-permission android:name="android.permission.CHANGE_NETWORK_STATE" />

<!--读取手机信息权限 -->

<uses-permission android:name="android.permission.READ_PHONE_STATE" />

<!--读取联系人权限,上传联系人需要用到此权限 -->

<uses-permission android:name="android.permission.READ_CONTACTS" />

<!--外存储写权限, 构建语法需要用到此权限 -->

<uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE" />

<!--外存储读权限,构建语法需要用到此权限 -->

<uses-permission android:name="android.permission.READ_EXTERNAL_STORAGE" />

<!--配置权限,用来记录应用配置信息 -->

<uses-permission android:name="android.permission.WRITE_SETTINGS" />

<!--摄相头权限, 拍照需要用到 -->

<uses-permission android:name="android.permission.CAMERA" />

语音合成

就是将文本读出来

使用的布局文件如下:

<?xml version="1.0" encoding="utf-8"?>

<!--activity_text2speech.xml-->

<LinearLayout xmlns:android="http://schemas.android.com/apk/res/android"

android:layout_width="match_parent"

android:layout_height="match_parent"

android:focusable="true"

android:focusableInTouchMode="true"

android:gravity="center_horizontal"

android:orientation="vertical"

android:paddingLeft="10dp"

android:paddingRight="10dp">

<TextView

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_centerInParent="true"

android:text="讯飞合成示例"

android:textSize="30sp" />

<EditText

android:id="@+id/tts_text"

android:layout_width="match_parent"

android:layout_height="0dp"

android:layout_weight="1"

android:gravity="top|left"

android:text="科大讯飞作为中国最大的智能语音技术提供商,在智能语音技术领域有着长期的研究积累,并在中文语音合成、语音识别、

口语评测等多项技术上拥有国际领先的成果。科大讯飞是我国唯一以语音技术为产业化方向的“国家863计划成果产业化基地”…"

android:textSize="20sp" />

<Button

android:id="@+id/tts_play"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:text="开始合成"

android:textSize="20sp" />

</LinearLayout>

java代码如下:

package com.iflytek.voicedemo;

import android.Manifest;

import android.annotation.SuppressLint;

import android.app.Activity;

import android.os.Bundle;

import android.os.Environment;

import android.support.v4.app.ActivityCompat;

import android.view.View;

import android.view.View.OnClickListener;

import android.view.Window;

import android.widget.EditText;

import android.widget.Toast;

import com.iflytek.cloud.ErrorCode;

import com.iflytek.cloud.SpeechConstant;

import com.iflytek.cloud.SpeechError;

import com.iflytek.cloud.SpeechSynthesizer;

import com.iflytek.cloud.SynthesizerListener;

public class Text2SpeechActivity extends Activity implements OnClickListener {

// 语音合成对象

private SpeechSynthesizer mTts;

private Toast mToast;

@SuppressLint("ShowToast")

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

requestWindowFeature(Window.FEATURE_NO_TITLE);

setContentView(R.layout.activity_text2speech);

findViewById(R.id.tts_play).setOnClickListener(this);

// 初始化合成对象

mTts = SpeechSynthesizer.createSynthesizer(this, null);

mToast = Toast.makeText(this, "", Toast.LENGTH_SHORT);

applyPermission();

}

//获取权限,将语音保存到sd卡

private void applyPermission() {

ActivityCompat.requestPermissions(this, new String[]{

Manifest.permission.READ_EXTERNAL_STORAGE

}, 12);

}

@Override

public void onClick(View view) {

switch (view.getId()) {

// 开始合成

// 收到onCompleted 回调时,合成结束、生成合成音频

// 合成的音频格式:只支持pcm格式

case R.id.tts_play: {

String text = ((EditText) findViewById(R.id.tts_text)).getText().toString();

// 设置参数

setParam();

int code = mTts.startSpeaking(text, mTtsListener);

// /**

// * 只保存音频不进行播放接口,调用此接口请注释startSpeaking接口

// * text:要合成的文本,uri:需要保存的音频全路径,listener:回调接口

// */

// String path = Environment.getExternalStorageDirectory()+"/tts.pcm";

// int code = mTts.synthesizeToUri(text, path, mTtsListener);

if (code != ErrorCode.SUCCESS) {

showTip("语音合成失败,错误码: " + code);

}

}

break;

}

}

/**

* 合成回调监听。

*/

private SynthesizerListener mTtsListener = new SynthesizerListener() {

@Override

public void onSpeakBegin() {

showTip("开始播放");

}

@Override

public void onSpeakPaused() {

showTip("暂停播放");

}

@Override

public void onSpeakResumed() {

showTip("继续播放");

}

@Override

public void onBufferProgress(int percent, int beginPos, int endPos,

String info) {

// 合成进度

}

@Override

public void onSpeakProgress(int percent, int beginPos, int endPos) {

// 播放进度

}

@Override

public void onCompleted(SpeechError error) {

if (error == null) {

showTip("播放完成");

} else if (error != null) {

showTip(error.getPlainDescription(true));

}

}

@Override

public void onEvent(int eventType, int arg1, int arg2, Bundle obj) {

// 以下代码用于获取与云端的会话id,当业务出错时将会话id提供给技术支持人员,可用于查询会话日志,定位出错原因

// 若使用本地能力,会话id为null

// if (SpeechEvent.EVENT_SESSION_ID == eventType) {

// String sid = obj.getString(SpeechEvent.KEY_EVENT_SESSION_ID);

// Log.d(TAG, "session id =" + sid);

// }

}

};

private void showTip(final String str) {

mToast.setText(str);

mToast.show();

}

/**

* 参数设置

*

* @return

*/

private void setParam() {

// 清空参数

mTts.setParameter(SpeechConstant.PARAMS, null);

// 根据合成引擎设置相应参数

mTts.setParameter(SpeechConstant.ENGINE_TYPE, SpeechConstant.TYPE_CLOUD);

// 设置在线合成发音人

mTts.setParameter(SpeechConstant.VOICE_NAME, "xiaoyan");

//设置合成语速

mTts.setParameter(SpeechConstant.SPEED,

"50");

//设置合成音调

mTts.setParameter(SpeechConstant.PITCH, "50");

//设置合成音量

mTts.setParameter(SpeechConstant.VOLUME,

"50");

//设置播放器音频流类型

mTts.setParameter(SpeechConstant.STREAM_TYPE,

"3");

// 设置播放合成音频打断音乐播放,默认为true

mTts.setParameter(SpeechConstant.KEY_REQUEST_FOCUS, "true");

// 设置音频保存路径,保存音频格式支持pcm、wav,设置路径为sd卡请注意WRITE_EXTERNAL_STORAGE权限

// 注:AUDIO_FORMAT参数语记需要更新版本才能生效

mTts.setParameter(SpeechConstant.AUDIO_FORMAT, "wav");

mTts.setParameter(SpeechConstant.TTS_AUDIO_PATH, Environment.getExternalStorageDirectory() + "/msc/tts.wav");

}

@Override

protected void onDestroy() {

super.onDestroy();

mTts.stopSpeaking();

// 退出时释放连接

mTts.destroy();

}

}

使用官方封装的UI,进行语音听写

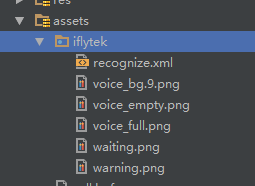

为了便于开发者调用,讯飞封装了一套用于语音输入的UI。在使用之前需要将官方Demo中的assets目录下的iflytek放到你的项目的assets目录下。其内容如下:

展示界面的布局文件

<?xml version="1.0" encoding="utf-8"?>

<!--activity_speech2text_ui.xml-->

<LinearLayout xmlns:android="http://schemas.android.com/apk/res/android"

android:layout_width="match_parent"

android:layout_height="match_parent"

android:focusable="true"

android:focusableInTouchMode="true"

android:gravity="center_horizontal"

android:orientation="vertical"

android:paddingLeft="10dp"

android:paddingRight="10dp">

<TextView

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_centerInParent="true"

android:text="讯飞听写示例"

android:textSize="30sp" />

<EditText

android:id="@+id/iat_text"

android:layout_width="match_parent"

android:layout_height="0dp"

android:layout_weight="1"

android:gravity="top|left"

android:paddingBottom="20dp"

android:textSize="20sp" />

<Button

android:id="@+id/iat_recognize"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:text="开始"

android:textSize="20sp" />

</LinearLayout>java代码:

package com.iflytek.voicedemo;

import android.Manifest;

import android.annotation.SuppressLint;

import android.app.Activity;

import android.os.Bundle;

import android.support.v4.app.ActivityCompat;

import android.view.View;

import android.view.View.OnClickListener;

import android.view.Window;

import android.widget.EditText;

import android.widget.Toast;

import com.iflytek.cloud.RecognizerResult;

import com.iflytek.cloud.SpeechError;

import com.iflytek.cloud.ui.RecognizerDialog;

import com.iflytek.cloud.ui.RecognizerDialogListener;

import com.iflytek.speech.util.JsonParser;

import org.json.JSONException;

import org.json.JSONObject;

import java.util.HashMap;

import java.util.LinkedHashMap;

public class Speech2TextUIActivity extends Activity implements OnClickListener {

private static String TAG = Speech2TextUIActivity.class.getSimpleName();

// 语音听写UI

private RecognizerDialog mIatDialog;

// 用HashMap存储听写结果

private HashMap<String, String> mIatResults = new LinkedHashMap<String, String>();

private EditText mResultText;

private Toast mToast;

@SuppressLint("ShowToast")

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

requestWindowFeature(Window.FEATURE_NO_TITLE);

setContentView(R.layout.activity_speech2text_ui);

findViewById(R.id.iat_recognize).setOnClickListener(this);

// 初始化听写Dialog,如果只使用有UI听写功能,无需创建SpeechRecognizer

// 使用UI听写功能,放置布局文件和图片资源

//使用云服务InitListener参数写成null

mIatDialog = new RecognizerDialog(this, null);

mToast = Toast.makeText(this, "", Toast.LENGTH_SHORT);

mResultText = ((EditText) findViewById(R.id.iat_text));

applyPermission();

}

private void applyPermission() {

ActivityCompat.requestPermissions(this, new String[]{Manifest.permission.RECORD_AUDIO}, 12);

}

@Override

public void onClick(View view) {

switch (view.getId()) {

// 开始听写

// 如何判断一次听写结束:OnResult isLast=true 或者 onError

case R.id.iat_recognize:

mResultText.setText(null);// 清空显示内容

mIatResults.clear();

// 显示听写对话框

mIatDialog.setListener(mRecognizerDialogListener);

mIatDialog.show();

showTip("请开始说话…");

break;

default:

break;

}

}

private void printResult(RecognizerResult results) {

String text = JsonParser.parseIatResult(results.getResultString());

String sn = null;

// 读取json结果中的sn字段

try {

JSONObject resultJson = new JSONObject(results.getResultString());

sn = resultJson.optString("sn");

} catch (JSONException e) {

e.printStackTrace();

}

mIatResults.put(sn, text);

StringBuffer resultBuffer = new StringBuffer();

for (String key : mIatResults.keySet()) {

resultBuffer.append(mIatResults.get(key));

}

mResultText.setText(resultBuffer.toString());

mResultText.setSelection(mResultText.length());

}

/**

* 听写UI监听器

*/

private RecognizerDialogListener mRecognizerDialogListener = new RecognizerDialogListener() {

public void onResult(RecognizerResult results, boolean isLast) {

printResult(results);

}

/**

* 识别回调错误.

*/

public void onError(SpeechError error) {

showTip(error.getPlainDescription(true));

}

};

private void showTip(final String str) {

mToast.setText(str);

mToast.show();

}

}解释服务器返回数据,用到的工具类

package com.iflytek.speech.util;

import org.json.JSONArray;

import org.json.JSONObject;

import org.json.JSONTokener;

import android.util.Log;

/**

* Json结果解析类

*/

public class JsonParser {

public static String parseIatResult(String json) {

StringBuffer ret = new StringBuffer();

try {

JSONObject joResult = new JSONObject(json);

JSONArray words = joResult.getJSONArray("ws");

for (int i = 0; i < words.length(); i++) {

// 转写结果词,默认使用第一个结果

JSONArray items = words.getJSONObject(i).getJSONArray("cw");

JSONObject obj = items.getJSONObject(0);

ret.append(obj.getString("w"));

// 如果需要多候选结果,解析数组其他字段

// for(int j = 0; j < items.length(); j++)

// {

// JSONObject obj = items.getJSONObject(j);

// ret.append(obj.getString("w"));

// }

}

} catch (Exception e) {

e.printStackTrace();

}

return ret.toString();

}

public static String parseGrammarResult(String json) {

StringBuffer ret = new StringBuffer();

try {

JSONTokener tokener = new JSONTokener(json);

JSONObject joResult = new JSONObject(tokener);

JSONArray words = joResult.getJSONArray("ws");

for (int i = 0; i < words.length(); i++) {

JSONArray items = words.getJSONObject(i).getJSONArray("cw");

for(int j = 0; j < items.length(); j++)

{

JSONObject obj = items.getJSONObject(j);

if(obj.getString("w").contains("nomatch"))

{

ret.append("没有匹配结果.");

return ret.toString();

}

ret.append("【结果】" + obj.getString("w"));

ret.append("【置信度】" + obj.getInt("sc"));

ret.append("\n");

}

}

} catch (Exception e) {

e.printStackTrace();

ret.append("没有匹配结果.");

}

return ret.toString();

}

public static String parseLocalGrammarResult(String json) {

StringBuffer ret = new StringBuffer();

try {

JSONTokener tokener = new JSONTokener(json);

JSONObject joResult = new JSONObject(tokener);

JSONArray words = joResult.getJSONArray("ws");

for (int i = 0; i < words.length(); i++) {

JSONArray items = words.getJSONObject(i).getJSONArray("cw");

for(int j = 0; j < items.length(); j++)

{

JSONObject obj = items.getJSONObject(j);

if(obj.getString("w").contains("nomatch"))

{

ret.append("没有匹配结果.");

return ret.toString();

}

ret.append("【结果】" + obj.getString("w"));

ret.append("\n");

}

}

ret.append("【置信度】" + joResult.optInt("sc"));

} catch (Exception e) {

e.printStackTrace();

ret.append("没有匹配结果.");

}

return ret.toString();

}

}

官方定制的UI还是挺漂亮的!

不使用官方UI控件进行语音听写

使用到的布局文件如下:

<?xml version="1.0" encoding="utf-8"?>

<!--activity_speech2text.xml-->

<LinearLayout xmlns:android="http://schemas.android.com/apk/res/android"

android:layout_width="match_parent"

android:layout_height="match_parent"

android:focusable="true"

android:focusableInTouchMode="true"

android:gravity="center_horizontal"

android:orientation="vertical"

android:paddingLeft="10dp"

android:paddingRight="10dp">

<TextView

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_centerInParent="true"

android:text="讯飞听写示例"

android:textSize="30sp" />

<EditText

android:id="@+id/iat_text"

android:layout_width="match_parent"

android:layout_height="0dp"

android:layout_weight="1"

android:gravity="top|left"

android:paddingBottom="20dp"

android:textSize="20sp" />

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:layout_marginBottom="2dp"

android:layout_marginTop="10dp"

android:gravity="center_horizontal"

android:orientation="horizontal">

<Button

android:id="@+id/iat_recognize"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="1"

android:text="开始"

android:textSize="20sp" />

<Button

android:id="@+id/iat_stop"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="1"

android:text="停止"

android:textSize="20sp" />

<Button

android:id="@+id/iat_cancel"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="1"

android:text="取消"

android:textSize="20sp" />

</LinearLayout>

</LinearLayout>java代码:

package com.iflytek.voicedemo;

import android.Manifest;

import android.annotation.SuppressLint;

import android.app.Activity;

import android.os.Bundle;

import android.support.v4.app.ActivityCompat;

import android.util.Log;

import android.view.View;

import android.view.View.OnClickListener;

import android.view.Window;

import android.widget.EditText;

import android.widget.Toast;

import com.iflytek.cloud.ErrorCode;

import com.iflytek.cloud.RecognizerListener;

import com.iflytek.cloud.RecognizerResult;

import com.iflytek.cloud.SpeechConstant;

import com.iflytek.cloud.SpeechError;

import com.iflytek.cloud.SpeechRecognizer;

import com.iflytek.speech.util.JsonParser;

import org.json.JSONException;

import org.json.JSONObject;

import java.util.HashMap;

import java.util.LinkedHashMap;

public class Speech2TextActivity extends Activity implements OnClickListener {

private static String TAG = Speech2TextActivity.class.getSimpleName();

// 语音听写对象

private SpeechRecognizer mIat;

// 用HashMap存储听写结果

private HashMap<String, String> mIatResults = new LinkedHashMap<String, String>();

private EditText mResultText;

private Toast mToast;

@SuppressLint("ShowToast")

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

requestWindowFeature(Window.FEATURE_NO_TITLE);

setContentView(R.layout.activity_speech2text);

findViewById(R.id.iat_recognize).setOnClickListener(Speech2TextActivity.this);

findViewById(R.id.iat_stop).setOnClickListener(Speech2TextActivity.this);

findViewById(R.id.iat_cancel).setOnClickListener(Speech2TextActivity.this);

mIat = SpeechRecognizer.createRecognizer(this, null);

mToast = Toast.makeText(this, "", Toast.LENGTH_SHORT);

mResultText = ((EditText) findViewById(R.id.iat_text));

applyPermission();

}

private void applyPermission() {

ActivityCompat.requestPermissions(this, new String[]{Manifest.permission.RECORD_AUDIO}, 12);

}

int ret = 0; // 函数调用返回值

@Override

public void onClick(View view) {

switch (view.getId()) {

// 开始听写

// 如何判断一次听写结束:OnResult isLast=true 或者 onError

case R.id.iat_recognize:

mResultText.setText(null);// 清空显示内容

mIatResults.clear();

// 设置参数

setParam();

ret = mIat.startListening(mRecognizerListener);

if (ret != ErrorCode.SUCCESS) {

showTip("听写失败,错误码:" + ret);

}

break;

case R.id.iat_stop:

mIat.stopListening();

showTip("停止听写");

break;

case R.id.iat_cancel:

mIat.cancel();

showTip("取消听写");

break;

default:

break;

}

}

/**

* 听写监听器。

*/

private RecognizerListener mRecognizerListener = new RecognizerListener() {

@Override

public void onBeginOfSpeech() {

// 此回调表示:sdk内部录音机已经准备好了,用户可以开始语音输入

showTip("开始说话");

}

@Override

public void onError(SpeechError error) {

// Tips:

// 错误码:10118(您没有说话),可能是录音机权限被禁,需要提示用户打开应用的录音权限。

// 如果使用本地功能(语记)需要提示用户开启语记的录音权限。

showTip(error.getPlainDescription(true));

}

@Override

public void onEndOfSpeech() {

// 此回调表示:检测到了语音的尾端点,已经进入识别过程,不再接受语音输入

showTip("结束说话");

}

@Override

public void onResult(RecognizerResult results, boolean isLast) {

Log.d(TAG, results.getResultString());

printResult(results);

}

@Override

public void onVolumeChanged(int volume, byte[] data) {

showTip("当前正在说话,音量大小:" + volume);

Log.d(TAG, "返回音频数据:" + data.length);

}

@Override

public void onEvent(int eventType, int arg1, int arg2, Bundle obj) {

// 以下代码用于获取与云端的会话id,当业务出错时将会话id提供给技术支持人员,可用于查询会话日志,定位出错原因

// 若使用本地能力,会话id为null

// if (SpeechEvent.EVENT_SESSION_ID == eventType) {

// String sid = obj.getString(SpeechEvent.KEY_EVENT_SESSION_ID);

// Log.d(TAG, "session id =" + sid);

// }

}

};

private void printResult(RecognizerResult results) {

String text = JsonParser.parseIatResult(results.getResultString());

String sn = null;

// 读取json结果中的sn字段

try {

JSONObject resultJson = new JSONObject(results.getResultString());

sn = resultJson.optString("sn");

} catch (JSONException e) {

e.printStackTrace();

}

mIatResults.put(sn, text);

StringBuffer resultBuffer = new StringBuffer();

for (String key : mIatResults.keySet()) {

resultBuffer.append(mIatResults.get(key));

}

mResultText.setText(resultBuffer.toString());

mResultText.setSelection(mResultText.length());

}

private void showTip(final String str) {

mToast.setText(str);

mToast.show();

}

/**

* 参数设置

*/

public void setParam() {

// 清空参数

mIat.setParameter(SpeechConstant.PARAMS, null);

// 设置听写引擎

mIat.setParameter(SpeechConstant.ENGINE_TYPE, SpeechConstant.TYPE_CLOUD);

// 设置返回结果格式

mIat.setParameter(SpeechConstant.RESULT_TYPE, "json");

// 设置语言

mIat.setParameter(SpeechConstant.LANGUAGE, "zh_cn");

// 设置语言区域

mIat.setParameter(SpeechConstant.ACCENT, "mandarin");

// 设置语音前端点:静音超时时间,即用户多长时间不说话则当做超时处理

mIat.setParameter(SpeechConstant.VAD_BOS, "4000");

// 设置语音后端点:后端点静音检测时间,即用户停止说话多长时间内即认为不再输入, 自动停止录音

mIat.setParameter(SpeechConstant.VAD_EOS, "1000");

// 设置标点符号,设置为"0"返回结果无标点,设置为"1"返回结果有标点

mIat.setParameter(SpeechConstant.ASR_PTT, "1");

}

@Override

protected void onDestroy() {

super.onDestroy();

// 退出时释放连接

mIat.cancel();

mIat.destroy();

}

}

1311

1311

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?