关注并星标

从此不迷路

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

计算机视觉研究院专栏

作者:Edison_G

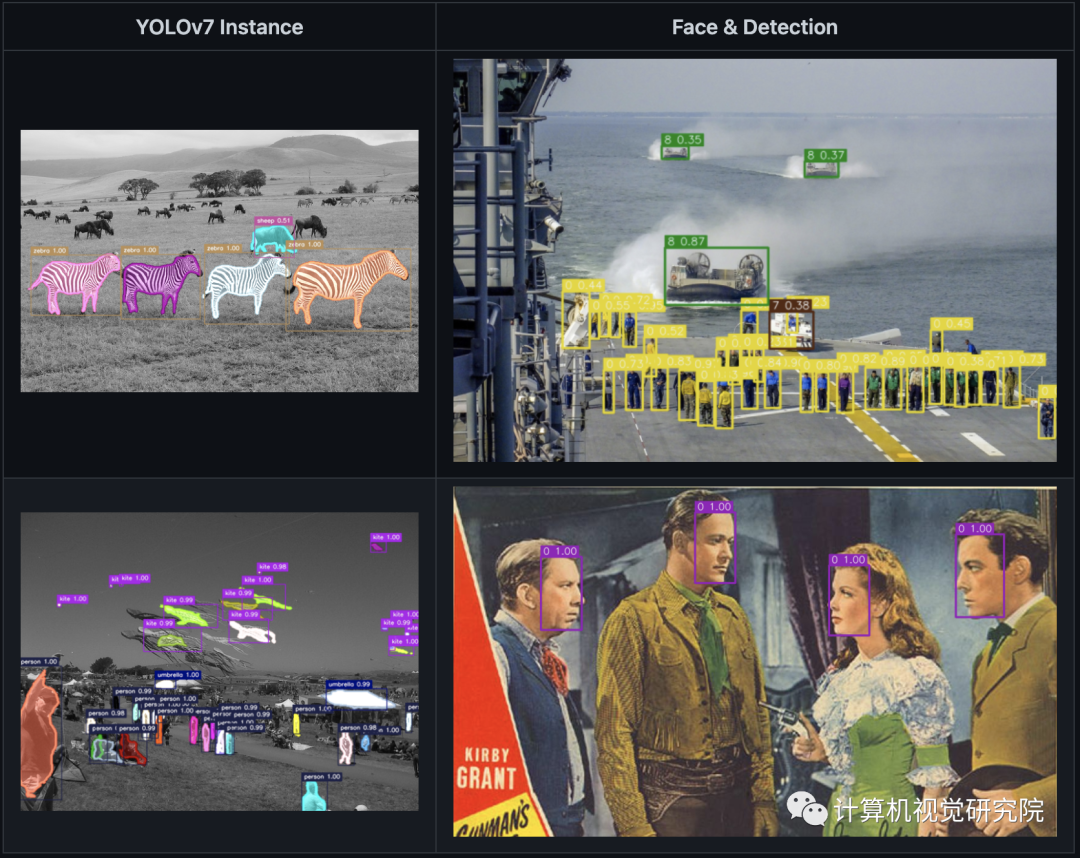

请注意,这里的7,不是下一代YOLO,而是一个幸运数字,姑且可以看作是一个代号。它的目的是让YOLO全面开花,不仅仅只是做目标检测。也不是简单的加一个semantic head做分割,而是做一个体系的目标检测积木模块,即插即用,使之能够更简单的做复杂的上层任务,比如多个分类head,实例分割,甚至是加上姿态检测等等。

转自《知乎——金天》

链接:https://zhuanlan.zhihu.com/p/464007111

介绍

目前支持的东西就这么一些,现列举一些大家可能感兴趣的:

支持GridMask,Mosiac的数据增强,而且可以可视化;

支持YOLOX(很强),而且部署方式比原版更方便,可训练,官方不是唯一可选;

支持YOLOv7+实例分割,是SingleStage的方式,目前用的是OrienMaskHead,未来可能增加更多方式;

支持DETR,AnchorDETR等transformer,这是独一无二的,在一个框架里面同时被支持;

YOLOv4 contained with CSP-Darknet53;

YOLOv7 arch with resnets backbone;

YOLOv7 arch with resnet-vd backbone (likely as PP-YOLO), deformable conv, Mish etc;

GridMask augmentation from PP-YOLO included;

YOLOv7 arch Swin-Transformer support (higher accuracy but lower speed);

YOLOv7 arch Efficientnet + BiFPN;

YOLOv5 style positive samples selection, new coordinates coding style;

RandomColorDistortion, RandomExpand, RandomCrop, RandomFlip;

CIoU loss (DIoU, GIoU) and label smoothing (from YOLOv5 & YOLOv4);

YOLOF also included;

YOLOv7 Res2net + FPN supported;

Pyramid Vision Transformer v2 (PVTv2) supported;

WBF (Weighted Box Fusion), this works better than NMS, link;

YOLOX like head design and anchor design, also training support;

YOLOX s,m,l backbone and PAFPN added, we have a new combination of YOLOX backbone and pafpn;

YOLOv7 with Res2Net-v1d backbone, we found res2net-v1d have a better accuracy then darknet53;

Added PPYOLOv2 PAN neck with SPP and dropblock;

YOLOX arch added, now you can train YOLOX model (anchor free yolo) as well;

DETR: transformer based detection model and onnx export supported, as well as TensorRT acceleration;

AnchorDETR: Faster converge version of detr, now supported!

最后强调一下,这个版本里面的transformer是支持转到ONNX的,并且这个ONNX是可以被TensorRT推理的。据我所知,这在全网没有任何一个开源的仓库做得到。

社区支持

为什么要开源这个框架,原因主要是两个:

我希望利用社区的力量把它做的更完善,增加更多的功能,这一年我们越来越相信社区的力量,众人拾材火焰高,不同的人研究优化不同的方向,就可以把这个框架被更多人用起来,用它训练的模型和部署起来的模型就可以跑在更多的地方,这才是价值所在;

我没有卡继续维护这些模型,希望有卡的朋友们一起来训模型,把社区做起来。

一个好的框架离不开发起人的积极参与和技术支持,我会一如既往的回答大家的问题,希望能给开源尽一些绵薄之力。

非常欢迎有时间,有计算资源,懂行的朋友来贡献代码或者模型,尤其是做目标检测方向的朋友们,这确实是发自内心一个非常良心的建议,把这些好的算法都汇聚到一起来吧。让社区的力量把它发展的更加壮大。

Github:https://github.com/jinfagang/yolov7

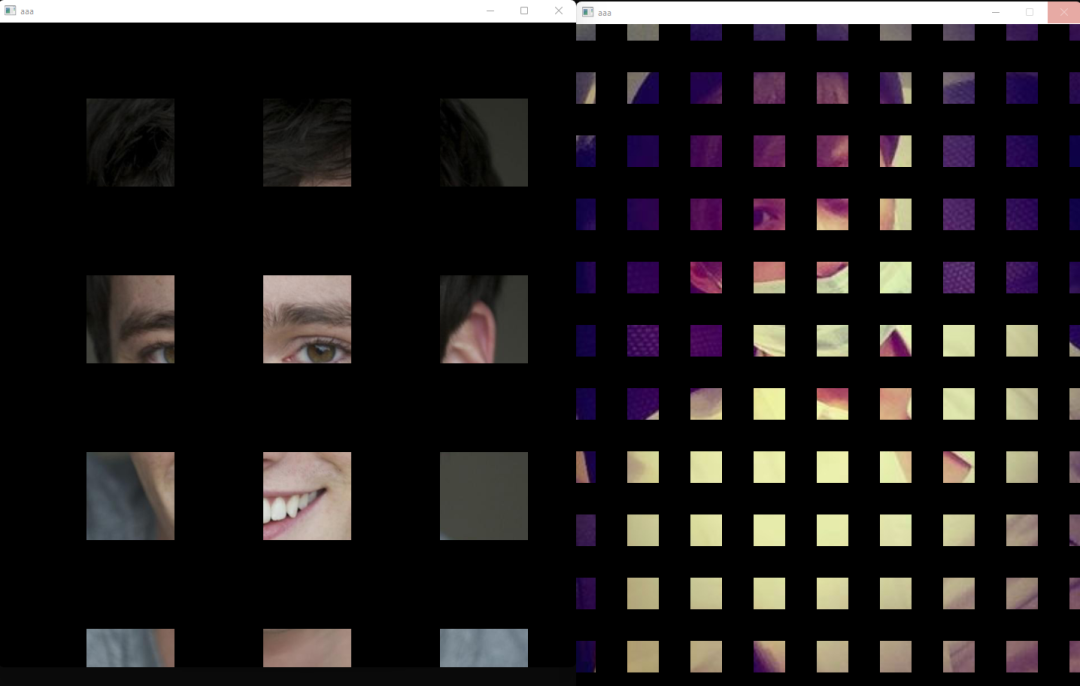

GridMask

Mosaic

© THE END

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

计算机视觉研究院主要涉及深度学习领域,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。研究院接下来会不断分享最新的论文算法新框架,我们这次改革不同点就是,我们要着重”研究“。之后我们会针对相应领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

扫码关注

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

往期推荐

🔗

2806

2806

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?