大家读完觉得有帮助记得关注和点赞!!!

摘要

车联网与6G网络的融合正在推动下一代智能交通系统的发展。然而,车联网网络面临着持续的挑战,包括车辆通信频谱效率低、难以实现动态和自适应的资源优化,以及在高度动态环境下需要保持长期稳定性。本文研究了支持集成感知与通信的车联网网络中数字孪生辅助的任务卸载与资源分配问题。目标是在确保队列随时间稳定的同时,最小化长期平均系统成本(定义为延迟和能耗的加权组合)。为了解决这个问题,我们采用支持ISAC的设计并引入了两种传输模式(即原始数据传输和指令传输)。InstrT模式支持指令级传输,从而减少数据量并提高频谱效率。然后,我们采用李雅普诺夫优化将长期随机问题分解为每个时隙的确定性问题,确保长期队列稳定性。在此基础上,我们提出了一种李雅普诺夫驱动的数字孪生增强多智能体近端策略优化算法,该算法在集中训练分散执行的架构中,利用DT实现全局状态感知和智能决策。大量的仿真验证表明,与现有基准相比,Ly-DTMPPO实现了更优越的性能。

I 引言

I-A 背景研究

随着5G的商业部署和6G的持续研究,车联网已成为智能交通和自动驾驶的基石技术。然而,车联网面临着对低延迟、高可靠性通信、精确环境感知和智能计算的迫切需求[1]。许多车联网应用是计算密集型和延迟敏感型的(例如,自动驾驶、高清视频分析和协同车辆感知),其中来自车载摄像头、激光雷达和毫米波雷达的多传感器数据需要实时处理[2]。支撑这些应用的深度神经网络通常规模庞大;例如,ResNet-152进行单次图像分类大约需要226亿次操作,处理高清视频序列可能超过30万亿次操作[3]。仅依赖车载计算处理此类工作负载会导致难以接受的推理延迟,从而损害安全性和用户体验。

为了缓解这一瓶颈,车载边缘计算被提出作为一种有效的任务卸载范式[4, 5]。与集中式云计算不同,VEC将计算和存储推向网络边缘。因此,任务可以通过车辆到基础设施链路在路侧单元之间,以及通过车辆到车辆链路在附近车辆之间进行划分和联合执行。这种边缘近端架构显著降低了端到端延迟并缓解了回程拥塞,使得计算密集型和延迟敏感型车联网应用能够及时执行[6]。

此外,有限的频谱资源已成为车联网的主要瓶颈,车联网必须为实时服务提供超可靠通信和高吞吐量数据交换。例如,现代自动驾驶汽车依赖大量车载传感器,可产生超过8 Gbps的数据[7]。集成感知与通信已被认为是6G解决此限制的关键使能技术,因为它可以在同一频谱内同时执行通信和环境感知[8]。与传统的"感知-通信分离"范式不同,ISAC使节点能够同时执行通信和感知,这不仅提高了频谱效率,还扩展了有效通信带宽,从而提高了数据传输速率[9]。

然而,由于缺乏预测能力,ISAC辅助的车联网仍然存在反应式决策的问题。虽然ISAC可以感知当前的通信和环境条件,但它无法预见未来的移动性和工作负载变化。因此,在高移动性条件下,任务卸载和资源调度仍然容易出现效率低下的情况。数字孪生作为信息物理融合的关键工具,通过提供全局可见性和预测性智能来解决这一差距[10]。通过构建车辆、RSU和网络资源的高保真虚拟副本,DT能够实现物理状态的实时同步,并支持任务动态的预测建模。例如,DT可以预测车辆轨迹和任务负载分布,从而促进卸载和资源分配的主动优化[11]。因此,将DT与ISAC相结合,为下一代智能交通系统提供了更全面的网络优化框架。

I-B 动机与主要挑战

尽管将DT和ISAC技术集成到车联网中具有巨大潜力,但几个基本挑战仍未解决。

-

首先,有效利用ISAC来增强车联网通信是一个关键挑战。感知与通信之间的紧密耦合在吞吐量和感知精度之间产生了重要的权衡,使得资源分配高度依赖于状态且更难以稳定[12]。这些问题在密集、高移动性场景中进一步加剧,其中对高速率传输和精确感知的同时需求显著增加了调度不确定性[13]。为了解决这个问题,我们利用ISAC的双重功能来支持两种传输模式:原始数据传输和指令传输,其中RSU使用自身的感知来重建传感数据。这种机制在确保任务执行精度的同时,有效降低了传输开销和延迟。

-

其次,在确保长期稳定性的同时最小化延迟和能耗是一个基本挑战。在许多实际部署中,车辆和RSU都受到有限能量预算的限制[14, 15]。在高度动态的移动性和时变任务到达情况下,过度的短期能耗很容易导致队列积压并降低服务可靠性。在没有预见未来系统动态的情况下,跨时隙做出一致的资源分配决策变得极其困难,尤其是在同时追求低延迟和高能效时[16]。为了应对这一挑战,我们采用李雅普诺夫优化框架,将长期随机控制问题分解为易于处理的每时隙决策,在保证队列长期稳定性的同时,动态平衡延迟减少和能耗。这种设计确保车辆和RSU能够在高度动态的车联网环境中持续运行,而不会牺牲响应能力。

-

第三,在高度动态的车联网环境中实现高效和自适应的任务卸载仍然是一个主要挑战。车辆任务具有异构性和延迟敏感性,而高移动性导致频繁的拓扑变化和波动的工作负载[10, 17]。传统优化方法(例如,凸优化和启发式算法)在此类环境中难以进行实时决策。深度强化学习通过环境交互机制提供了适应性,但仅依赖局部观察的智能体在部分可观测性下可能会产生不稳定或短视的行为。为了应对这一挑战,我们在集中训练分散执行范式下将DT集成到DRL框架中,在训练期间提供同步的全局状态。这提高了策略对系统动态的感知能力,并在快速变化的场景中增强了决策的鲁棒性(如第七节所验证)。

I-C 贡献总结

在本文中,受上述挑战的驱动,我们研究了支持ISAC的车联网中DT辅助的任务卸载与资源分配。我们的目标是在高度动态的车辆环境中确保队列稳定性的同时,最小化长期系统成本(定义为平均延迟和能耗的加权和)。这项工作的主要贡献总结如下:

-

框架:我们在支持ISAC的车联网中制定了一个长期联合任务卸载与资源分配问题,其中车辆和RSU采用双重传输模式(即DataT和InstrT),后者减少了数据量并提高了频谱效率。我们将该问题建模为一个混合整数非线性规划公式,已知其为NP难问题。在高车辆移动性和时变任务到达的情况下求解该问题尤其具有挑战性。

-

解决方案:为了应对这一挑战,我们首先采用李雅普诺夫优化技术将原始的长期耦合目标转化为一系列易于处理的每时隙子问题,确保队列稳定性和可持续的能耗。基于此转换,我们在CTDE范式下提出了一种李雅普诺夫驱动的DT增强多智能体近端策略优化算法。该算法将DT增强的全局可见性集成到同策略强化学习中,并将李雅普诺夫稳定性意识嵌入到奖励设计中,与基线相比,实现了更快的收敛速度、更高的稳定性和更好的适应性。

-

验证:我们进行了大量的仿真来验证所提出的框架。结果表明,与李雅普诺夫驱动的多智能体基线相比,Ly-DTMPPO实现了更快的收敛、更好的稳定性以及延迟和能耗的更大降低,从而获得了最低的整体系统成本。此外,与不含DT的对应方案进行比较,证实了所提出的DT模块显著增强了决策稳定性,并提高了动态车辆环境中计算卸载和资源调度的有效性。

I-D 论文组织

本文的其余部分组织如下。第二节回顾了关于车联网中DT辅助ISAC和李雅普诺夫优化方法的相关工作。第三节介绍了系统模型,包括DT辅助的车辆场景和支持ISAC的通信、计算和队列模型。第四节制定了具有延迟和能量约束的联合优化问题。第五节介绍了基于李雅普诺夫的问题分解方法。第六节在多智能体强化学习框架下开发了提出的Ly-DTMPPO算法。第七节通过仿真和比较分析评估系统性能。最后,第八节总结了论文并讨论了未来的研究方向。

II 相关工作

此后,我们回顾了最相关的研究,并指出了推动当前工作的研究空白。

II-A 支持ISAC的车联网

作为6G的基础技术,ISAC能够在共享频谱上同时进行通信和感知。[18]的作者开发了一个支持ISAC的V2X MEC框架,通过联合卸载和资源分配来减少长期服务延迟。[19]提出了一种利用MEC和云服务器的三层ISCC架构,以改善感知任务的延迟和能量性能。此外,[20]设计了一种基于数据融合的ISAC方法来优化长期延迟-能量权衡,[21]提出了一种ISAC驱动的关联策略,以在自组织网络中扩大感知范围并减少通信延迟。

尽管取得了这些进展,现有研究主要集中在物理层信号处理或短期权衡优化上。ISAC与更高层决策(如跨层资源分配、任务调度和长期系统稳定性)之间的相互作用仍未得到充分解决。

II-B 车联网中DT辅助的ISAC

DT已成为车联网的一项关键技术,提供了网络状态的全局可见性和预测建模。[11]的作者提出了一种DT驱动的边端调度方案,通过准确的资源估计提高了异构任务的完成率。[22]的工作研究了维护DT模型和执行任务之间的权衡,强调了DT在平衡稀缺计算资源方面的作用。[23]提出了一种利用DT实现实时车辆交互的协同驾驶架构。此外,Li等人[24]研究了DT辅助的集成感知-通信-计算,其中DT预测有助于卸载决策,以平衡感知精度和计算效率。

然而,大多数现有的DT辅助车联网研究主要关注架构设计或预测性调度,而只有少数明确解决了支持ISAC环境中感知、通信和计算资源之间的紧密耦合[25]。在高移动性下,将DT和ISAC集成以实现稳定的长期资源分配仍然在很大程度上未被探索。

II-C 支持ISAC的车联网资源分配

高效的资源分配对于支持ISAC的车联网至关重要,其中频谱、计算和功率资源必须协调以支持多样化和延迟关键的任务。[26]的作者优化了基于SDMA的调度,以最大化支持ISAC的车联网中的吞吐量。Chen等人[27]引入了具有通过A2GNN管理的TSFC资源解耦的ISCC范式。[18]的工作联合优化了卸载和资源分配以减少长期延迟,[20]利用李雅普诺夫优化来平衡协同感知中的队列延迟和能量。

虽然有效,但这些研究主要强调瞬时或仿真驱动的优化,并且通常简化了感知-通信耦合,使得长期队列和能量稳定性的探索不足。这一空白促使我们研究针对DT使能的ISAC辅助车联网的稳定性感知、跨层资源分配。

II-D 基于李雅普诺夫优化的车联网方法

李雅普诺夫优化广泛应用于车联网中,以保证队列稳定性,同时优化长期指标。[28]的作者将其应用于ISAC网络,进行联合带宽和功率分配,以减少延迟并提高感知。在MEC背景下,[13]采用了一种基于李雅普诺夫的多智能体方法进行任务和资源协调,而[16]将李雅普诺夫优化与基于GCN的RL相结合来管理相互依赖的子任务。此外,[29]提出了LySAC,将李雅普诺夫与软演员-评论家相结合,以联合优化延迟和能量。

然而,这些研究通常依赖于简化的假设或仅解决孤立的通信-计算权衡。感知、通信和计算之间的耦合,以及对预测性全局可见性的需求,在很大程度上仍未得到探索。这促使我们使用李雅普诺夫优化对DT辅助的支持ISAC的车联网系统进行更深入的研究,以实现长期稳定性。

III 系统模型

在本节中,我们提出了DT辅助的支持ISAC的车联网系统模型。我们首先描述了DT辅助的车联网架构和支持ISAC的通信与计算场景,然后对任务卸载、资源分配和队列动态进行建模。它们共同为后续开发的基于李雅普诺夫的优化和学习框架奠定了基础。

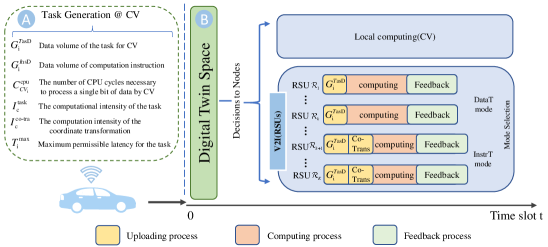

图1: DT辅助的ISAC车联网场景。A部分说明了物理层,其中支持ISAC的车辆和RSU在感知、通信和计算方面进行协作。其中,ISAC通信在车辆和RSU之间进行。B部分呈现了DT层,它通过同步的数字副本镜像物理环境,支持预测性控制和主动资源优化。

III-A DT辅助的车联网场景

如图1所示,我们介绍了一个集成通信、感知和计算的车联网场景,由部署在双向直线城市道路路段上的几个RSU组成,这些RSU以固定的间隔(取决于RSU的范围)部署。这些RSU配备了ISAC能力并与MEC服务器集成[29],提供超过移动车辆的计算能力,以及传感器(例如高清摄像头、激光雷达和毫米波雷达)[30]以实时感知环境信息。相邻的RSU通过光纤互连,能够创建DT空间,以实现通信、感知和计算状态的全局态势感知,从而促进准确和明智的决策。在我们的论文中,为了同时优化时域和频域资源分配,采用正交频分多址技术来实现CV和RSU之间的并发通信。因此,在后续分析中可以忽略信号重叠引起的干扰[3, 13]。此外,我们对上传和反馈过程采用时分双工模式。

我们采用离散时隙计算模型,其中总持续时间被划分为T个相等的时隙,每个时隙的持续时间表示为τ。时隙集合表示为𝒯={1,…,T}。RSU集合可以描述为ℝ={ℛ1,…,ℛK} (k∈{1,…,K})。一些车辆携带一个计算密集型和延迟密集型的任务,该任务以环境数据作为输入。这些车辆被视为客户车辆,可以描述为ℂ={𝒞1,…,𝒞I} (i∈{1,…,I})。车辆和RSU DT的详细信息如下:

-

CV孪生体:CV数字孪生包括任务数据量G_i^TasD和计算指令数据量G_i^InsD、计算能力C_^(CV_i cpu)、车辆DT ID D^(T-Number_CVs)、坐标L_i^cv、车辆速度v_i^cv以及最大容忍延迟T_i^max,其中𝒞_i∈ℂ。

-

RSU孪生体:RSU数字孪生包括RSU DT ID D^(T-Number_RSU)、坐标L_k^rsu、覆盖区域(即半径)R^(Range_k rsu)、计算资源F_k^(rsu, max),其中ℛ_k∈ℝ。

与传统的车联网模型(车辆只能访问本地信息)不同,我们框架中的DT空间提供了系统的虚拟化全局视图。具体来说,DT实时同步车辆和RSU的物理状态,并维护虚拟队列,这些队列镜像了RSU中的任务积压和资源利用率。由DT维护的这些队列在实践中无法被车辆直接观察,但通过DT空间对智能决策智能体变得可用。这使得能够对移动性和任务动态进行预测建模,允许强化学习算法利用全局上下文信息进行更准确的任务卸载和资源分配。

因此,DT不仅记录静态参数(例如,位置和计算能力),还充当动态估计器和预测器,这弥补了局部可观察状态和全局最优调度策略之间的差距。在我们的实际实现中,DT进一步为CTDE框架中的行动者网络提供了全局视角,使智能体能够做出更明智和协调的决策。这种DT辅助设计的有效性在我们的实验中得到了验证,详见第七-C节。为便于参考,表I总结了系统模型中使用的关键符号。

表I:关键符号列表

| 符号 | 描述 |

|---|---|

| b(t) | 带宽分配决策 |

| ℂ | 车辆集合 |

| C_^(CV_i cpu) | 车辆𝒞_i的本地计算能力 |

| ∁(t) | 系统级成本函数 |

| d_(i,k)^(veh→rsu)(t) | CV 𝒞_i 与 RSU ℛ_k 之间的欧几里得距离 |

| D_i^loc(t) | CV 𝒞_i 中的本地处理延迟 |

| D_(i,k)^rsu(t) | RSU ℛ_k 中的边缘处理延迟 |

| D_i^(queue,n)(t) | 排队延迟 |

| E_i^loc(t) | CV 𝒞_i 中本地执行任务的能耗 |

| E_(i,k)^(DataT-up)(t) | DataT模式下任务上传期间的能耗 |

| E_(i,k)^(co-tra)(t) | RSU执行坐标变换的能耗 |

| E_i^task(t) | 所有节点消耗的总能量 |

| F_^(RSU_k cpu)(t) | 在时隙t时,RSU分配给其卸载任务的计算资源 |

| G_i^TasD | 任务的数据量 |

| G_i^InsD | 计算指令的数据量 |

| I_c^task | 处理一位数据所需的CPU周期数 |

| ℓ(t) | 任务分配决策 |

| Q_i^loc(t) | 时隙t时车辆𝒞_i的任务队列长度 |

| Q_k^rsu(t) | 时隙t时RSU ℛ_k的任务队列长度 |

| ℝ | RSU集合 |

| R_(i,k)^(veh→rsu)(t) | 从CV 𝒞_i 到 RSU ℛ_k 的V2I传输速率 |

| 𝒯 | 时隙索引集合 |

| T_i^max | 任务完成的最大容忍延迟 |

| T_i^task(t) | 并行执行的所有任务的总延迟 |

| V_i(t) | 时隙t时的虚拟能量队列 |

| Ψ_i^CV | 时隙t时车辆𝒞_i的任务 |

| Θ | 通信增益 |

| η_i^rsu(t) | 模式选择器 |

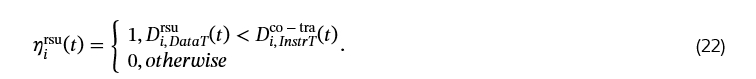

III-B 支持ISAC的车联网计算场景

在第三-A节中,随着持续更新,这个孪生体实时更新以反映物理对象的状态[25]。因此,本文中的RSU孪生体和车辆孪生体可以被视为ISAC节点。配备传感器的RSU和车辆都具有获取环境信息的能力。因此,邻近CV的相邻RSU的孪生体可能收集到类似的环境传感数据。在这种情况下,CV和RSU可以共同提供通信和感知功能,这进一步使得ISAC辅助的车联网系统能够支持多样化的计算场景。这种冗余使得协作机制成为可能,即CV不必为每个任务都上传原始数据。

具体来说,我们为CV向RSU孪生体卸载任务引入了两种可用的传输模式:

-

DataT模式:CV直接将完整的原始传感数据G_i^TasD(t)(例如,高清视频和激光雷达点云)上传到RSU。卸载时间取决于传输速率和原始任务数据的大小。RSU完成计算后,输出结果被发送回CV,其中反馈延迟取决于结果数据的大小和传输速率。

-

InstrT模式:CV不上传海量原始数据,而是仅上传数据量显著减小的计算指令G_i^InsD(t)。由于RSU本身从其自身的传感器收集类似的环境数据,它在接收到指令后可以使用其本地感知数据重建任务输入[25]。然而,由于CV和RSU之间的视角不同,原始环境数据需要通过坐标变换进行对齐。这个过程可以通过使用计算指令中包含的CV坐标信息进行矩阵运算来实现,如[25, 31]所建议。此预处理的相应计算强度记为I_c^(co-task)。一旦对齐,RSU使用自身的感知数据执行任务,并将结果返回给CV。

通过利用ISAC的双重能力,与DataT相比,InstrT模式可以显著减少传输开销和延迟,同时仍能确保准确的任务执行。这种ISAC辅助的协作机制允许任务在RSU孪生体之间并行执行,从而提高了动态车辆环境中的资源利用率和服务效率。在本文中,我们关注CV生成任务,而RSU作为任务执行的主要服务节点的场景。在DataT和InstrT模式之间的选择成为任务卸载策略的关键部分,并将与资源分配一起在所提出的李雅普诺夫驱动框架中进行联合优化。

III-C 感知增强的通信模型

在本文中,我们考虑V2I通信模型。此外,类似于[29],我们考虑通信和感知功能之间的协同效益(即感知增强的通信模型)。让增强因子Θ = R^(sen-enhance) / R^(normal) 表示感知增强下的通信速率与正常通信速率之比。

V2I通信:设R_(i,k)^(veh→rsu)(t)为时隙t时从CV 𝒞_i到RSU ℛ_k的数据传输速率:

其中 b_(i,k)^(veh→rsu)(t) * ℬ 表示CV 𝒞_i 和 RSU ℛ_k 之间的通信带宽,b_(i,k)^(veh→rsu)(t) ∈ [0,1] 是时隙t时从CV 𝒞_i 到 RSU ℛ_k 的带宽分配比率,P_i 是CV 𝒞_i 的发射功率,σ_0² 是加性高斯白噪声。此外,h_(i,k)^(veh→rsu)(t) ∼ 𝒞𝒩(0,1) 是时隙t时CV 𝒞_i 和 RSU ℛ_k 之间的小尺度衰落分量。另外,g_(i,k)^(veh→rsu)(t) 是CV 𝒞_i 和 RSU ℛ_k 之间大尺度衰落分量的路径损耗,计算为 -38.4 - 21.0 * log₁₀(dis_(i,k)^(veh→rsu)(t)) [32],其中 dis_(i,k)^(veh→rsu)(t) 表示时隙t时CV 𝒞_i 和 RSU ℛ_k 之间的时变距离。

此外,由于车辆的高移动性,我们对车辆和RSU之间的实时3D欧几里得距离进行建模,以捕捉V2I距离的时空变化。时隙t时CV 𝒞_i 和 RSU ℛ_k 之间的欧几里得距离由下式给出:

其中 x_i(t) = x_i + v_i^cv * t 是CV的纵向位置。y_i^cv 表示由其所在车道决定的横向位置。RSU ℛ_k 的坐标描述为 L_k^rsu(即一个元组 (x_k^rsu, l_k, H_k)),其中 x_k^rsu, l_k, 和 H_k 分别表示RSU的纵向位置、RSU相对于道路中心线的横向偏移量以及RSU的高度。类似于[25],我们可以忽略CV 𝒞_i 和 RSU ℛ_k 之间的相对移动距离。因此,CV 𝒞_i 和 RSU ℛ_k 之间的欧几里得距离可以通过以下公式更新:

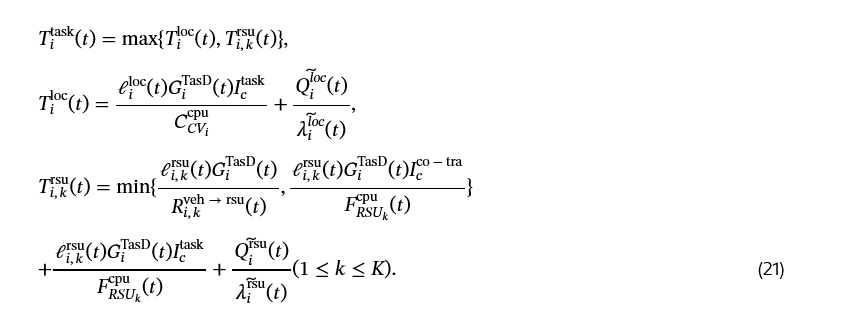

III-D 计算模型

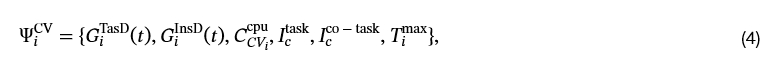

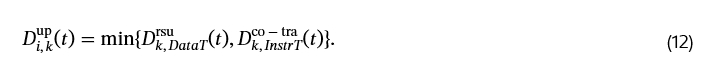

图2: 总任务完成延迟。此处,"Co-Trans"代表坐标变换。A部分说明了CV处的任务生成,其中定义了数据量和计算属性。B部分显示了决定本地和RSU节点之间任务卸载比率以实现低延迟协同计算的DT空间。

如图2所示,在每个时隙t开始时,CV生成一个任务,即:

其中 G_i^TasD(t) 表示时隙t时CV 𝒞_i 的任务数据量。G_i^InsD(t) 表示计算指令的数据量。C_^(CV_i cpu)(单位:周期/秒)表示CV 𝒞_i 每秒可以执行的CPU周期数。I_c^task(单位:周期/位)表示任务的计算强度(即处理单位比特任务数据所需的CPU周期数)。I_c^(co-task)(单位:周期/位)是坐标变换的计算强度。T_i^max 表示任务完成的最大容忍延迟。

根据第三-B节,与任务的数据量相比,任务描述和相应的决策非常小。因此,这两种传输时间可以忽略不计[25]。如图2所示,CV生成的任务将在本地和RSU上并行计算。

-

本地处理:在时隙t,当子任务在本地执行时,本地处理延迟就是本地计算时间。本地处理延迟 D_i^loc(t) 和本地执行任务的能耗 E_i^loc(t) 由下式给出:

其中 ℓ_i^loc(t) 表示分配给本地的任务比率。κ_cv 是车辆计算的能耗参数,它是一个依赖于硬件的常数。

-

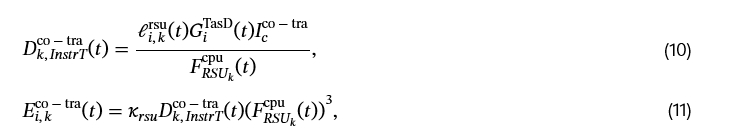

RSU处的边缘处理:当任务在RSU执行时,CV需要考虑是选择DataT模式还是InstrT模式。此外,任务的数据量或计算指令将被传输到RSU。在RSU完成计算任务后,计算结果将返回给CV。根据[25, 33, 34],输出结果的大小远小于输入数据,因此我们忽略反馈延迟。因此,RSU的任务处理延迟将进一步包括上传时间和处理时间,形式化如下。

-

上传时间:如果CV选择了DataT模式,则上传时间可通过以下公式计算:

其中 ℓ_(i,k)^rsu(t) 是时隙t时从CV 𝒞_i 分配给 RSU ℛ_k 的任务比率。那么,E_(i,k)^(DataT-up) 是DataT模式下任务上传期间的能耗,由下式给出:

InstrT模式的上传时间计算如下:

其中 G_(i,k)^InsD(t) 表示时隙t时分配给RSU ℛ_k 的计算指令大小。InstrT模型的上传时间主要取决于坐标变换时间,E_(i,k)^(co-tra)(t) 表示RSU执行坐标变换的能耗。它们由下式给出:

其中 κ_rsu 是RSU计算的能耗参数。I_c^(co-tra)(单位:周期/位)是坐标变换的计算强度。F_^(RSU_k cpu)(t)(单位:周期/秒)表示时隙t时RSU ℛ_k 分配给卸载任务的计算资源。DT空间将选择DataT模式和InstrT模型之间上传时间较小的那个。因此,上传时间可以定义为:

-

计算时间:上传后,卸载到RSU ℛ_k 的任务将在RSU ℛ_k 上并行处理。RSU处理延迟 D_(i,k)^compt(t) 和RSU执行卸载任务的能耗 E_(i,k)^(compt,rsu)(t) 描述如下:

总结来说,在RSU ℛ_k 上边缘处理的总延迟由下式给出:

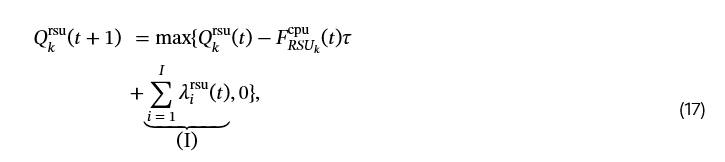

III-E 队列模型

在我们的系统中,为了准确捕捉异构节点间的计算负载动态,我们为CV和RSU建立了独立的任务队列。每种类型节点的队列演化由基于任务到达和时隙持续时间τ内可用计算资源的离散时间动态控制。

-

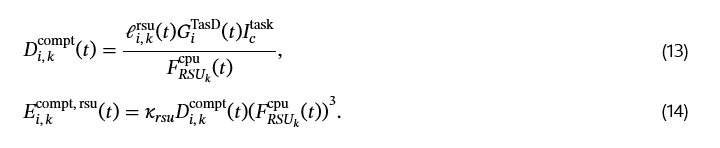

本地队列

对于每个CV 𝒞_i,本地任务队列是私有维护的,并且只考虑在本地处理的那部分任务。队列更新如下:

其中 Q_i^loc(t) 是时隙t时CV 𝒞_i 本地任务队列中的计算积压。项 (I) 表示在时隙持续时间τ内本地可执行的计算量,项 (II) 表示分配给本地的新到达任务的计算量,其中 λ_i^loc(t) = ℓ_i^loc(t) * G_i^TasD(t) * I_c^task。 -

RSU队列

相比之下,RSU作为共享的边缘计算节点,可能同时接收来自多个CV 𝒞_i 的卸载任务段。由RSU ℛ_k 维护的计算队列必须聚合来自不同CV的所有到达任务:

其中 Q_k^rsu(t) 表示时隙t时RSU ℛ_k 任务队列中积压的计算量,项 (I) 表示时隙t时所有将其任务卸载到RSU ℛ_k 的CV 𝒞_i 新到达的计算量。这里 ∑(i=1)^I λ_i^rsu(t) = ℓ(i,k)^rsu(t) * G_i^TasD(t) * [ η_i^rsu(t) * I_c^(co-tra) + I_c^task ],其中,η_i^rsu(t) ∈ {0,1} 是一个模式选择器。根据(12),如果InstrT模式具有更低的总上传时间,则 η_i^rsu(t) 将等于1,否则 η_i^rsu(t) = 0。

在对CV和RSU的任务队列演化进行建模之后,我们继续估计分配给每个节点的任务所遇到的相应排队延迟。为了捕捉执行前的平均等待时间,我们应用了利特尔定律,这是排队论中一个广泛采用的原则,它指出稳定系统中的预期延迟与队列中的平均任务数除以平均到达率成正比[35]。

具体来说,我们将节点 n ∈ {loc, rsu} 处由CV 𝒞_i 发起的任务的排队延迟定义为时间平均队列长度与时间平均到达计算负载之比。

设 Q_i^n(t) 和 λ_i^n(t) 分别表示时隙t时的队列长度和任务到达负载,排队延迟表示为:

其中 Q̃_i^n(t) = (1/m) * ∑(l=t-m+1)^t Q_i^n(l) 和 λ̃_i^n(t) = (1/m) * ∑(l=t-m+1)^t λ_i^n(l) 分别是大小为m的滑动时间窗口上计算的时间平均队列长度和到达率。

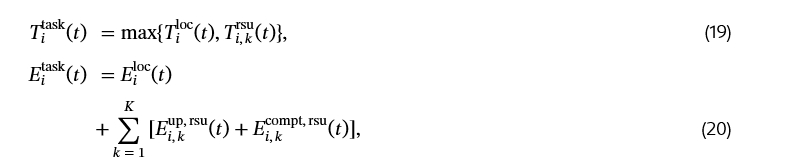

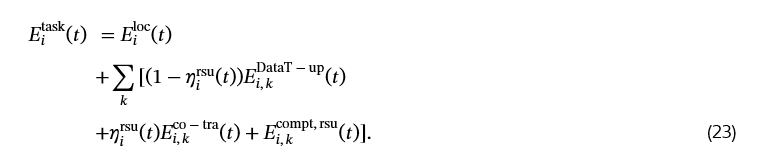

因此,T_i^task(t)(即本地部分延迟和RSU部分延迟的最大值)被视为并行执行的所有任务的总延迟。E_i^task(t) 表示执行由𝒞_i 在时隙t发起的任务所涉及的所有节点(包括CV和RSU)消耗的总能量。它们定义如下:

其中 T_i^loc(t) = D_i^loc(t) + D_i^(queue,loc)(t) 是本地部分总延迟。T_(i,k)^rsu(t) = D_(i,k)^rsu(t) + D_i^(queue,rsu)(t), ℛ_k ∈ ℝ 表示RSU部分总延迟。

结合(5)、(15)和(18),总延迟更新为:

上传任务的能耗取决于所选的传输模式。为确保一致性,我们细化了第三-E节中提到的模式选择器 η_i^n'(t),并结合(12),定义如下:

因此,总能耗更新为:

IV 问题表述

为了实现实用且可解释的系统目标,我们根据总成本来表述优化问题,该总成本共同考虑了任务延迟和支持每个任务所产生的系统范围能耗。具体来说,对于每个客户车辆𝒞_i,我们将其与服务相关的成本定义为:

其中 α ∈ [0,1] 是一个可配置的权重,用于灵活平衡延迟和能耗。

基于此,系统级成本定义为所有CV的总和,如下所示:

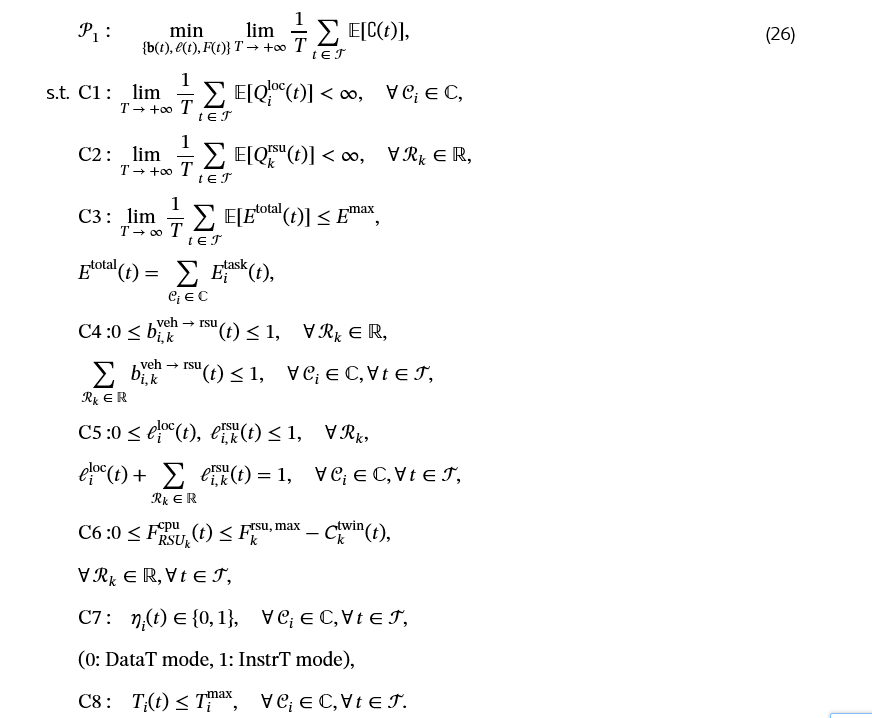

系统范围的目标是最小化所有CV的累积成本,可以表述为:

其中优化变量是:(i) b(t) = {b_(i,k)(t)}(𝒞_i ∈ ℂ, ℛ_k ∈ ℝ) 是时隙t时CV 𝒞_i 和 RSU ℛ_k 之间的带宽分配比率;(ii) ℓ(t) = {ℓ_i^loc(t), ℓ(i,k)^rsu(t)}(𝒞_i ∈ ℂ, ℛ_k ∈ ℝ) 是任务分配比率,指示𝒞_i 的任务如何在本地处理和RSU节点之间分配;(iii) F(t) = {F^(RSU_k cpu)(t)}_(ℛ_k ∈ ℝ) 是时隙t时用于子任务的RSU计算资源分配。

在(𝒫1)中,约束C1和C2分别确保CV和RSU处任务队列的长期稳定性。约束C3要求长期平均总系统能耗在预定义的系统范围能量预算E_max内。其中,E_i^task(t) 表示由CV 𝒞_i 发起的任务在整个系统中引起的能耗,E_total(t) 表示时隙t中由所有CV发起的任务引起的总系统能耗。约束C4[29]确保带宽分配比率限制在有效范围内,并且任何给定时隙每个CV 𝒞_i 的总分配带宽不超过归一化的单位带宽。约束C5保证所有可用计算节点上的任务分配比例之和为一,并且每个单独的比率被限制在区间[0,1]内。约束C6限制了RSU分配的计算资源,以确保分配的资源不超过为构建DT空间保留一部分C_k^twin(t)后的剩余可用容量。约束C7表示二元模式选择器η_i(t) ∈ {0,1},其中0表示CV 𝒞_i 的DataT模式,1表示InstrT模式。约束C8确保CV感知到的任务执行延迟不超过其最大容忍延迟T_i^max。

备注1.

联合优化问题(𝒫1)涉及队列稳定性C1和C2的长期约束,这些约束固有地将不同时隙的任务卸载和资源分配决策耦合在一起。这种时间耦合源于任务队列随时间的动态演化,使得决策空间具有顺序依赖性。此外,连续变量(例如,约束C4和C5中的任务和带宽分配比率)和离散决策变量(例如,约束C7中的计算模式选择器)共存导致了一个MINLP结构。此类问题通常是NP难的,并且难以实时有效求解,特别是在动态车辆移动性和对未来状态了解有限的情况下。

V 基于李雅普诺夫的动态长期问题解耦

为了应对上述挑战,我们采用李雅普诺夫优化方法将原始的长期问题重新表述为一系列易于处理的每时隙决策。这使得能够在不需要未来系统动态完整知识的情况下进行实时决策,同时仍然提供长期稳定性和可行性的保证。

在李雅普诺夫优化中,物理任务队列(C1和C2)被直接纳入李雅普诺夫函数和漂移表达式以确保长期队列稳定性。相比之下,对于系统级时间平均约束(例如与显式队列结构无关的能耗C3),必须引入虚拟队列将这些平均约束转化为队列稳定性条件。为了处理长期系统范围的能量约束C3,我们引入了一个虚拟能量队列V_i(t),它跟踪实际能量使用与允许平均值之间的累积偏差。尽管时隙索引集定义为𝒯={1,…,T},为方便李雅普诺夫分析,我们采用t=0作为初始时隙,并设置虚拟队列状态V_i(0)=0。

虚拟队列根据以下方式演化:

V_i(t+1) = max{ V_i(t) - E_max + E_total(t), 0 }, (27)

其中,稳定V_i(t)保证了长期平均能耗约束得到满足。

为了检查V_i(t)的长期行为,我们首先为了可处理性放松max算子,并分析不等式:

V_i(t+1) - V_i(t) ≥ E_total(t) - E_max. (28)

将(28)的两边从t=0求和到T-1,我们得到:

V_i(T) - V_i(0) ≥ ∑_(t=0)^(T-1) (E_total(t) - E_max). (29)

两边除以T并重新排列得到:

(1/T) * ∑_(t=0)^(T-1) E_total(t) ≤ E_max + (V_i(T) - V_i(0)) / T. (30)

取期望并注意V_i(0)=0,我们推导出:

(1/T) * ∑_(t=0)^(T-1) 𝔼[E_total(t)] ≤ E_max + 𝔼[V_i(T)] / T. (31)

因此,如果虚拟队列V_i(t)是均值速率稳定的,即:

lim_(T→∞) 𝔼[V_i(T)] / T = 0. (32)

那么,原始能耗约束C4得到满足[29]:

lim_(T→∞) (1/T) * ∑_(t=0)^(T-1) 𝔼[E_total(t)] ≤ E_max. (33)

因此,稳定虚拟队列V_i(t)确保了长期平均能耗约束C3的满足。

我们定义𝐙(t)为时隙t时积压状态的紧凑表示,它包括CV和RSU的任务队列,以及虚拟队列V_i(t):

𝐙(t) = { {Q_i^loc(t)}(𝒞_i ∈ ℂ), {Q_k^rsu(t)}(ℛ_k ∈ ℝ), V_i(t) }. (34)

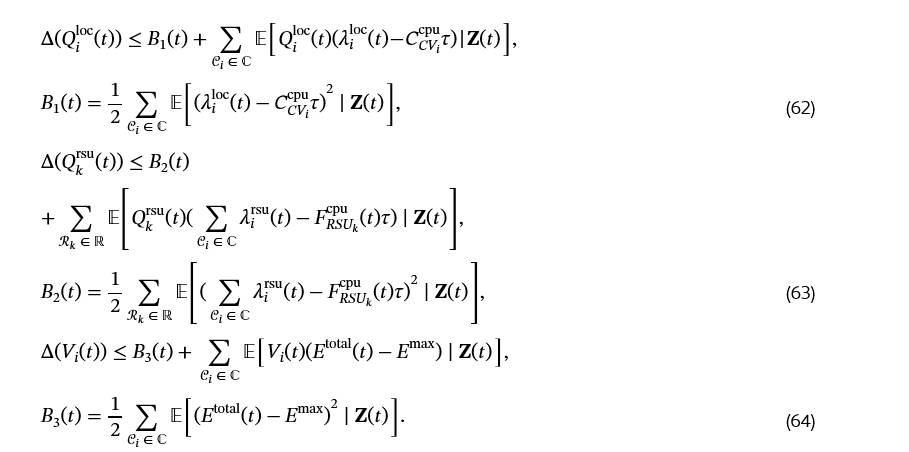

我们定义李雅普诺夫函数作为队列积压的标量二次度量:

L(𝐙(t)) = (1/2) * [ ∑(i∈ℂ) (Q_i^loc(t))² + ∑(k∈ℝ) (Q_k^rsu(t))² + ∑_(i∈ℂ) V_i(t)² ]. (35)

李雅普诺夫漂移,表征连续时隙间队列状态的变化,通过将(V)中的李雅普诺夫函数应用于两个连续时隙推导得出:

Δ(𝐙(t)) = 𝔼[ L(𝐙(t+1)) - L(𝐙(t)) ∣ 𝐙(t) ]. (36)

利用李雅普诺夫漂移加惩罚框架,我们制定了一个漂移-惩罚函数,该函数共同包含了李雅普诺夫漂移和问题(𝒫1)的目标函数,旨在最小化以下每个时隙的漂移加惩罚表达式的上界:

Λ(𝐙(t)) = Δ(𝐙(t)) + V ⋅ 𝔼[ ∁(t) ∣ 𝐙(t) ], (37)

其中 V > 0 是权重参数,用于平衡最小化控制成本和确保队列稳定性之间的权衡。

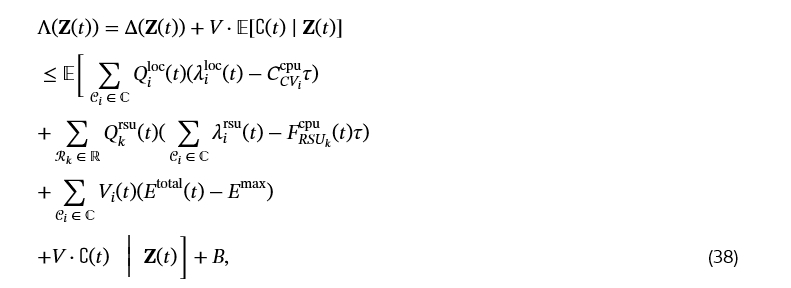

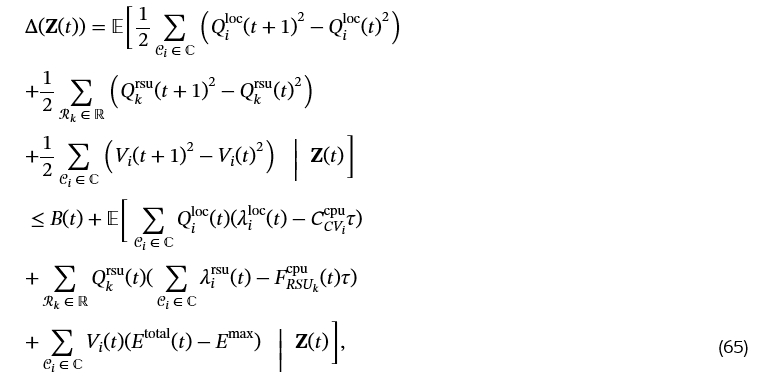

在下文中,我们获得了(37)上Λ(𝐙(t))的一个上界。

引理1:对于任何满足约束C1∼C8的可行集合{b(t), ℓ(t), F(t)}(t∈𝒯),李雅普诺夫漂移加惩罚表达式Λ(𝐙(t))可以上界如下:

其中 B 是队列变动的二阶矩的常数上界,由每时隙决策 {b(t), ℓ(t), F(t)}_(t∈𝒯) 决定。

详细证明附于在线附录A。

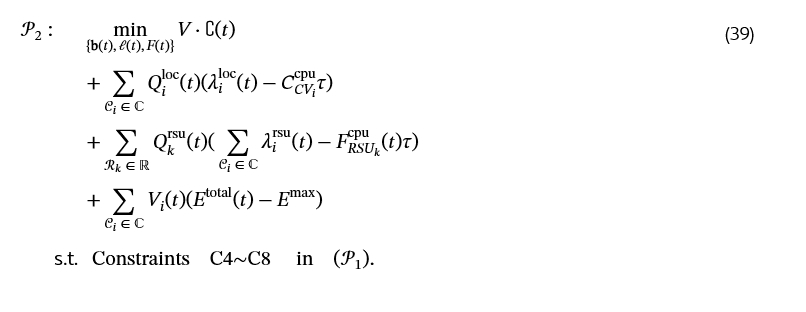

基于引理1中的上界,可以通过求解每个时隙的确定性优化问题来最小化漂移加惩罚表达式Λ(𝐙(t))。

由于常数项B不影响决策过程,可以安全地将其从目标函数中省略。因此,我们将问题(𝒫1)重新表述为每时隙问题(𝒫2),该问题可以在当前观察下在线求解,确保长期约束满足和队列稳定性。

VI 基于李雅普诺夫的资源分配DRL

在本节中,我们将每时隙问题转化为马尔可夫决策过程。然后,我们开发了CTDE行动者-评论家解决方案,详细介绍了其基于MAPPO的架构和训练过程,随后进行了计算复杂度分析,量化了轨迹收集和行动者-评论家更新的成本。

VI-A 马尔可夫决策过程

为了在动态车辆环境和不确定网络条件下以在线方式解决推导出的每时隙优化问题(𝒫2),我们进一步将其表述为MDP。这种MDP表述使得能够应用DRL通过与环境的交互来学习最优的卸载和资源分配策略。虽然最近的研究将扩散模型纳入深度确定性策略梯度框架以提高高维连续空间中的探索效率[36],但我们的方法不同之处在于将李雅普诺夫漂移加惩罚理论嵌入到奖励设计中,明确保证了动态车辆环境中的队列稳定性和长期能效。具体来说,MDP由以下组件定义:状态空间、动作空间和奖励函数。

-

状态空间:在我们的系统中,每个CV 𝒞_i 被建模为一个独立的智能体。在每个时隙t,我们采用DT增强的状态描述,包含车辆和RSU动态,以及我们基于李雅普诺夫的模型中引入的额外排队状态。局部状态 s_i(t) 由下式给出:

其中,CV 𝒞_i 的DT可以定义为 ℧i^info_CV = { G_i^TasD(t), G_i^InsD(t), C^(CV_i cpu), L_i^cv(t), v_i^cv, T_i^max }。RSU ℛ_k 的DT可以定义为 ℧_i^info_RSU = { L_k^rsu, F_k^(rsu,max) }。然后,所有智能体的联合状态定义如下:

S(t) = { s_1(t), …, s_i(t), …, s_I(t) }. (41) -

动作空间:对应于CV 𝒞_i 的智能体i负责做出任务卸载和带宽分配决策。具体来说,在时隙t开始时生成任务后,DT空间提供实时环境和资源信息以辅助决策过程。基于此,智能体确定:(i) 任务在本地处理和卸载到RSU节点之间的划分比率;以及 (ii) 每个卸载链路的带宽分配比率。因此,智能体i在时隙t的动作空间定义为:

a_i(t) = { b(t), ℓ(t), F(t) }, (42)

其中 b(t) 满足约束C4,ℓ(t) 满足约束C5。需要注意的是,传输模式选择变量 η_i(t) 不是由智能体直接决定的。相反,它由DT空间自动确定。η_i(t) 满足约束C7。

然后,所有智能体的联合动作定义如下:

a(t) = { a_1(t), …, a_i(t), …, a_I(t) }. (43) -

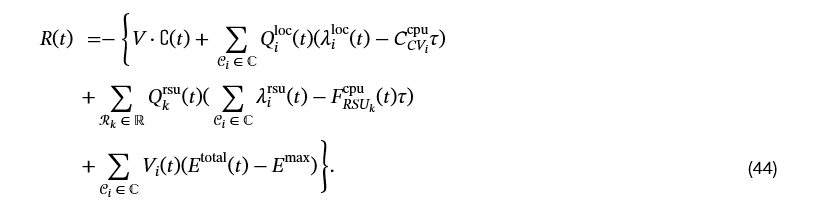

奖励函数:在状态 s_i(t) 下执行动作 a_i(t) 后,智能体i观察到环境转换到新状态 s_i(t+1),并收到反映决策质量的奖励。在我们的系统中,奖励函数源自通过李雅普诺夫优化获得的漂移加惩罚公式。具体来说,它被设计为问题(𝒫2)中转换后的每时隙目标函数的负值,该函数共同捕获队列稳定性、任务完成延迟和能耗[29]。这种设计确保最大化预期累积奖励等价于在保持队列稳定性的同时最小化长期系统成本。

因此,奖励函数定义为:

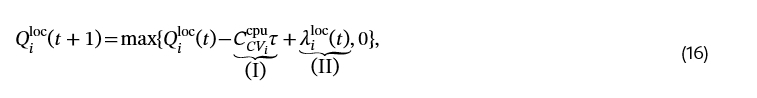

VI-B DT增强的DRL算法

为了解决(𝒫2)中李雅普诺夫优化的每时隙决策问题,该问题被建模为一个具有共享资源约束的协作多智能体强化学习问题。尽管所有智能体旨在协作地最小化系统范围的李雅普诺夫漂移加惩罚目标,但智能体在有限的RSU计算和带宽资源方面存在隐式竞争。因此,这种情况构成了一种软耦合的协作MARL问题,其中智能体在策略优化方面是协作的,但由于受限和共享的资源分配而相互依赖。

-

采用MAPPO的动机[16, 37]:尽管李雅普诺夫优化有效地将长期耦合的优化问题分解为易于处理的每时隙子问题,但由于高维决策空间和快速变化的车辆环境,实时求解由此产生的混合整数非线性规划问题仍然具有挑战性。传统的优化和启发式方法通常不足以捕捉在移动性、任务异构性和严格延迟约束下联合资源分配和任务卸载的复杂动态。为了克服这些挑战,我们采用MAPPO框架,该框架自然地契合了车联网协作但又资源竞争的特性。在CTDE范式内,MAPPO利用集中式评论家在训练期间利用全局信息,同时允许分散式行动者在实时中独立执行策略。此外,通过将李雅普诺夫漂移加惩罚公式嵌入到奖励函数中,该算法明确地将队列稳定性、延迟和能量权衡纳入学习过程。这种集成不仅确保了对动态网络条件的适应性,还保证了长期系统稳定性。

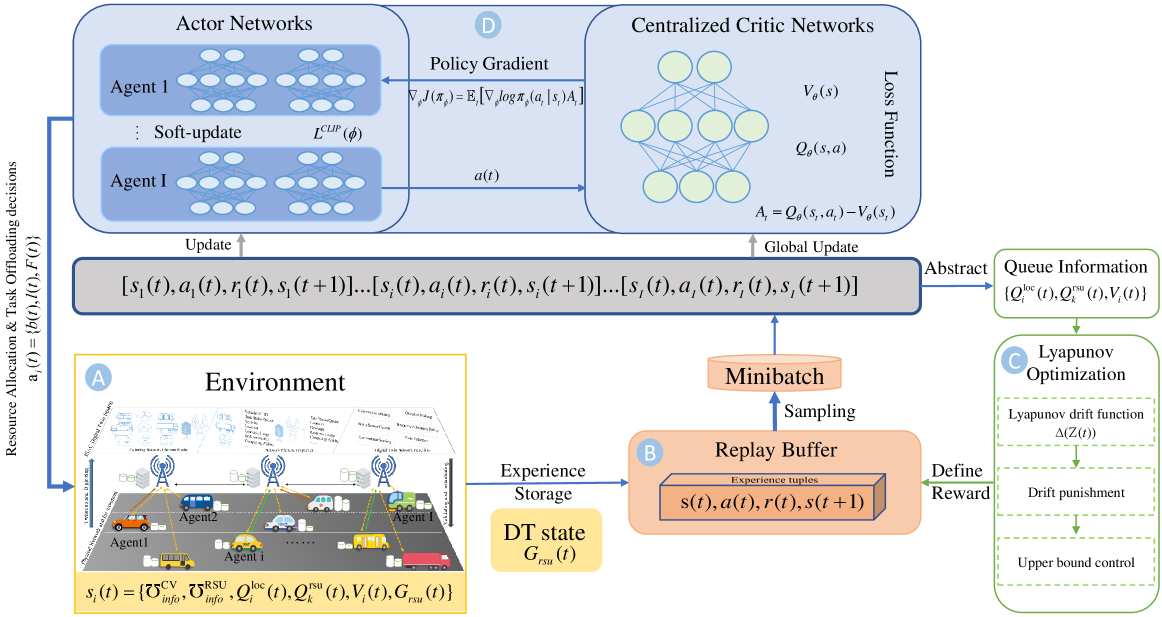

图3: 提出的Ly-DTMPPO算法框架。A部分描述了智能体与系统交互的DT辅助车辆环境。B部分存储和采样经验用于策略更新。C部分采用李雅普诺夫优化来稳定队列动态并平衡延迟-能量权衡。D部分采用具有集中式评论家和分散式行动者的CTDE结构进行协作策略学习。

-

Ly-DTMPPO的网络架构:如图3所示,提出的Ly-DTMPPO框架在CTDE范式下采用了行动者-评论家架构。每个智能体都配备了一个用于分散决策的行动者网络,而在训练期间使用一个集中式评论家网络来指导策略改进。

-

行动者网络:对于每个智能体 i ∈ ℐ,行动者网络接收其局部观察 s_i(t),其中包括DT增强的车辆状态(例如,任务大小、CPU能力、位置和速度)、队列相关信息以及RSU级队列聚合 G_rsu(t) = [ ∑(k=1)^K Q_k^rsu(t), (1/K) * ∑(k=1)^K Q_k^rsu(t), max_k Q_k^rsu(t) ]。当DT信息不可用时,此组件被替换为相同维度的零向量,以保持状态表示的一致性。行动者由两个具有ReLU激活函数的全连接隐藏层组成,随后是一个参数化高斯策略的输出层。具体来说,行动者输出动作分布的均值和方差,从中采样出卸载和资源分配决策 a_i(t)。为了稳定策略优化,使用了PPO目标,其中裁剪的替代损失 L^CLIP(ϕ) 确保保守的策略更新。在执行期间,每个智能体仅基于其局部状态以分布式方式选择其动作。

-

评论家网络:评论家网络是集中式的,并在训练期间共享。它将全局状态 s(t) 作为输入,该状态聚合了所有智能体的观察结果和系统级队列信息,以及RSU队列聚合 G_rsu(t)。它输出状态值估计 V_θ(s(t))。评论家由两个具有ReLU激活函数的全连接隐藏层和一个线性输出层组成。通过最小化预测回报和经验回报之间的均方误差,评论家提供了稳定的价值函数近似。然后,优势函数推导为:

A_t = Q_θ(s_t, a_t) - V_θ(s_t), (45)

用于通过策略梯度指导行动者更新。

-

提出的Ly-DTMPPO算法描述:我们在算法1中具体介绍了为每个CV 𝒞_i 提出的Ly-DTMPPO。整体训练和执行过程总结如下。

-

轨迹收集:在每个决策时隙t,每个智能体 i ∈ ℐ 观察其局部状态 s_i(t),并根据其随机策略 π_ϕ(a_i | s_i) 生成一个动作 a_i(t)。联合动作 a(t) = {a_1(t), …, a_I(t)} 在环境中执行,然后环境返回下一个状态 s(t+1) 和奖励向量 r(t) = {r_1(t), …, r_I(t)}。奖励由李雅普诺夫漂移加惩罚公式定义,以同时捕获延迟、能量和队列稳定性约束。经验元组 (s(t), a(t), r(t), s(t+1)) 被存储到回放缓冲区中。

-

优势估计:对于每个智能体,评论家网络近似价值函数 V_θ(s_t)。为了计算时间差分误差并稳定训练,我们采用广义优势估计。步骤t的优势计算如下:

A_t = δ_t + (γ λ) δ_(t+1) + ⋯ + (γ λ)^(T-t+1) δ_(T-1), (46)

其中 δ_t = r_t + γ V_θ(s_(t+1)) - V_θ(s_t),γ 和 λ 分别表示折扣因子和迹衰减因子。 -

行动者更新:使用PPO裁剪替代目标优化行动者参数 ϕ,以防止过大的策略更新:

L^CLIP(ϕ) = 𝔼_t[ min( r_t(ϕ) A_t, clip(r_t(ϕ), 1-ϵ, 1+ϵ) A_t ) ], (47)

其中 r_t(ϕ) = π_ϕ(a_t | s_t) / π_(ϕ_old)(a_t | s_t) 是新旧策略之间的概率比,ϵ 是裁剪参数。然后,行动者目标的梯度计算为:

∇_ϕ J(π_ϕ) ≈ 𝔼_t[ ∇_ϕ log π_ϕ(a_t | s_t) A_t ]. (48) -

评论家更新:通过最小化预测价值与经验回报之间的均方误差来更新评论家网络参数 θ:

L^V(θ) = 𝔼_t[ (V_θ(s_t) - R_t)² ], (49)

其中 R_t = A_t + V_θ(s_t) 表示时间t的估计回报。因此,评论家为优势计算提供了稳定的基线。 -

训练循环:使用从回放缓冲区采样的轨迹小批量,对行动者和评论家进行多个周期的更新。为防止梯度爆炸,应用了梯度裁剪。还在行动者损失中添加了熵奖励,以鼓励在动作空间中进行充分的探索。

-

执行阶段:在集中训练之后,每个车辆根据其自身的局部观察 s_i(t) 独立执行学习到的策略。这种分散执行确保了真实车联网中的可扩展性,而李雅普诺夫形状的奖励保证了长期的队列稳定性和能量-延迟权衡。

-

复杂度分析:提出的Ly-DTMPPO算法的计算复杂度主要来自四个部分:轨迹收集、优势估计、行动者-评论家更新和集中训练[22, 38]。

在轨迹收集阶段,每个ℐ个智能体每个时隙执行其策略网络一次,导致复杂度为𝒪(ℐ × d_π),其中d_π表示行动者参数的数量。优势估计在T个决策步骤上引入了𝒪(ℐ × T)的复杂度。对于行动者-评论家更新,使用批量大小B_s和E个周期的小批量训练产生总复杂度为𝒪(E × B_s × (d_π + d_V)),其中d_V是评论家参数的数量。在CTDE范式下,集中训练期间的通信开销为每次同步𝒪(I × d_π),而分散执行仅产生每个智能体𝒪(d_π)的推理成本。总体而言,Ly-DTMPPO的每次迭代复杂度可以表示为:

𝒪( ℐ × (T + d_π) + E × B_s × (d_π + d_V) ), (50)

该复杂度随智能体数量和决策步骤线性增长。受益于分散执行和并行推理,Ly-DTMPPO在大规模车联网中实现了可扩展和实时的适用性。

算法1 在DT使能的V2X网络中,为智能体i提出的Ly-DTMPPO算法

0: 状态空间 s_i(t) 定义于(40);行动者 π_(φ_i);评论家 V_θ;缓冲区 𝒟

0: 训练后的行动者 π_(φ_i) 和评论家 V_θ

1: for 每个回合 do

2: 初始化环境 ℰ,获取初始状态 s_i(0),清空缓冲区 𝒟

3: for t=1,2,…,T do

4: 观察当前状态 s_i(t) 如(40)所定义;

5: 每个智能体 i 根据 π_(φ_i)(a_i | s_i(t)) 选择动作 a_i(t);

6: 在 ℰ 中执行联合动作 a(t) = {a_1(t), …, a_I(t)};

7: 观察下一个状态 s_i(t+1) 和由(VI-A)定义的奖励 r_i(t);

8: 将 (s_i(t), a_i(t), r_i(t), s_i(t+1)) 存储到 𝒟;

9: 更新 s_i(t) ← s_i(t+1);

10: end for

11: for epoch=1,2,…,E do

12: 从 𝒟 中采样一个小批量;

13: 使用GAE通过(46)计算优势;

14: 通过(47)计算行动者裁剪替代损失;

15: 通过(48)用策略梯度更新行动者网络;

16: 通过(49)计算评论家损失;

17: 用梯度 ∇_θ L^V 更新评论家网络;

18: end for

19: end for

VII 性能评估

在本节中,我们首先描述了仿真参数设置,然后通过将我们提出的Ly-DTMPPO算法与几个代表性基准方案进行比较来全面评估其性能,最后讨论评估结果。

VII-A 参数设置

我们采用pytorch 1.11和Python 3.8的环境,硬件为NVIDIA GeForce RTX 4070 SUPER 12GB,第13代Intel(R) Core(TM) i5-13600KF 3.50 GHz,以及32 GB RAM。详细设置如下:

-

仿真场景:我们考虑一个东西走向的四车道道路,每条车道宽3.75米(L0)[22],长700米。三个RSU部署在中心道路北侧,距离中心线9.375米(l_k),间距150米,高度10米(H_k)[25],覆盖半径200米。系统带宽ℬ设置为20 MHz [22],噪声功率σ_0²为10⁻¹³ W [25],系统以时隙方式运行,持续时间1秒(τ)。

-

CV和RSU参数:车辆速度v_i^cv服从[12, 16] m/s的均匀分布。每辆车的计算能力C_^(CV_i cpu)均匀分布在[2, 3] GHz [38],而每个RSU配备固定的20 GHz计算能力(F_k^(rsu,max))。任务数据量G_i^TasD均匀分布在[1, 3] Mb [38],任务的计算强度I_c^task在[1500, 2000] 周期/位的范围内初始化。

-

训练参数:对于提出的Ly-DTMPPO算法,学习率设置为8×10⁻⁵,折扣因子γ=0.99,GAE参数λ=0.95,裁剪比率ϵ=0.2,更新周期数为10。每个回合包含30个时隙,最大回合数为1800。采用Adam优化器进行参数更新以确保稳定收敛。

其余参数的值总结在表II中。

表II:仿真参数

| 参数 | 值 |

|---|---|

| 最大回合数: | 1800 |

| 每回合步数: | 30 |

| 车辆数量: N | [2,6] |

| 车道宽度 (m): L0 | 3.75 |

| RSU高度 (m): Hk | 10 |

| RSU覆盖半径 (m): R^(Range_k rsu) | 200 |

| 相邻RSU之间的距离 (m): | 150 |

| RSU到道路中心的距离 (m): lk | 9.75 |

| 带宽 (MHz): ℬ | 20 |

| 时隙持续时间 (s): τ | 1 [39] |

| 加性高斯白噪声 (W): σ0² | 10⁻¹³ [25] |

| 发射功率 (W): Pi | 1 |

| 车辆速度 (m/s): v_i^cv | [12,16] |

| CV计算能力 (GHz): C_^(CV_i cpu) | [2,3] [29] |

| RSU计算资源 (GHz): F_k^(rsu,max) | 20 |

| 任务数据量 (Mb): G_i^TasD | [1,3] |

| 任务的计算强度 (周期/位): I_c^task | [1500,2000] [25] |

| 坐标变换的计算强度 (周期/位): I_c^(co-tra) | [100,500] [25] |

| 车辆能量系数: κ_cv | 10⁻²⁶ [35] |

| RSU能量系数: κ_rsu | 10⁻²⁸ [40] |

| 通信增益因子: Θ | 1.5 [29] |

| 李雅普诺夫控制参数: V | 5 |

| 批量大小: B | 512 |

| 折扣因子: γ | 0.99 |

| GAE参数: λ | 0.95 |

| 裁剪比率: ϵ | 0.2 |

VII-B 基线

为了证明所提出的Ly-DTMPPO算法的有效性,我们将其与几个代表性的MARL基线进行比较。为公平起见,所有算法都在相同的仿真环境下实现,并采用第七-A节中描述的车联网场景的相同参数设置。主要区别在于任务卸载和资源分配的决策模块。

-

Ly-MADDPG [13, 41]:该基线采用多智能体深度确定性策略梯度作为主干,结合基于李雅普诺夫的队列稳定性公式进行资源分配和任务卸载。

-

Ly-MATD3:该基线将所提出方案的PPO核心替换为多智能体双延迟深度确定性策略梯度[42]。李雅普诺夫优化框架保持相同,以确保在队列稳定性方面进行公平比较。

-

Ly-MASAC:该基线采用多智能体软演员-评论家算法,这是一种利用熵正则化改进探索的离策略算法。它将[29]中的LySAC框架扩展到多智能体设置,其中结合了李雅普诺夫优化机制以保证队列稳定性。

-

Ly-MAPPO [16]:该基线在相同的李雅普诺夫优化框架下应用MAPPO算法,但移除了DT增强的全局可见性和预测建模。与我们提出的Ly-DTMPPO的比较突显了在高移动性车辆环境中集成DT对提高决策效率的独特贡献。

VII-C 仿真结果

在本节中,我们首先在默认参数设置下评估所提出的Ly-DTMPPO算法的整体系统性能。随后,我们与基准方案进行比较分析,以突出我们方法的有效性。最后,我们研究了关键系统参数对Ly-DTMPPO和基线算法性能的影响,以提供对其在动态车辆环境中适应性和鲁棒性的更深入见解。

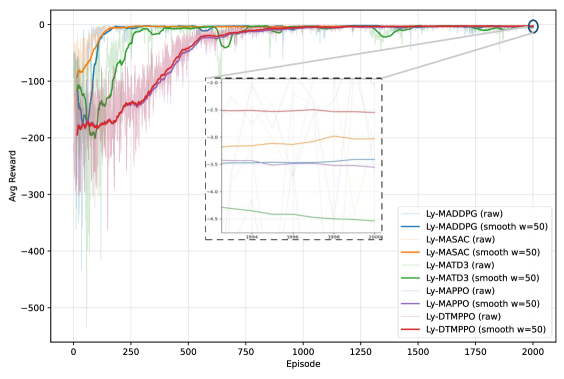

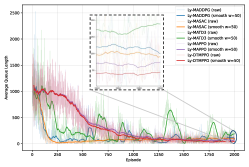

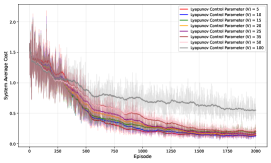

图4: 不同算法下的平均奖励。

-

收敛性能:图4描绘了所有方案的收敛行为。所有方法最终都收敛,该实验在5个CV和3个RSU下进行。相比之下,Ly-DTMPPO(红色曲线)获得了最高的稳态奖励并保持了相对平滑的收敛。使用最后50个回合的平均奖励作为稳态度量,Ly-DTMPPO相对于Ly-MADDPG、Ly-MATD3、Ly-MASAC和Ly-MAPPO分别实现了25.3%、43.9%、15.9%和28.3%的相对增益。此外,Ly-DTMPPO的变异系数为0.411,明显小于Ly-MAPPO(0.672)和Ly-MADDPG(0.530),与MASAC(0.366)和MATD3(0.333)相当,从而证明了相对于大多数基线的优越稳定性。在收敛速度方面,Ly-DTMPPO在1711个回合时达到其稳态奖励的95%,比离策略方案(例如,Ly-MADDPG在185,Ly-MASAC在278)慢。然而,显著更高的奖励突显了同策略PPO主干结合DT使能的全局可见性和基于李雅普诺夫的队列稳定在实现高度动态车联网中最优性和鲁棒性方面的优势。详细的数值结果进一步总结在表III中。

表III:不同方案的收敛稳定性和速度

| 算法 | 稳态奖励¹ | CV² | 收敛回合数 (95%)³ |

|---|---|---|---|

| Ly-MADDPG | -3.412 | 0.530 | 185 |

| Ly-MASAC | -3.031 | 0.366 | 278 |

| Ly-MATD3 | -4.541 | 0.333 | 579 |

| Ly-MAPPO | -3.555 | 0.672 | 1398 |

| Ly-DTMPPO | -2.549 | 0.411 | 1711 |

-

¹ 稳态奖励是最后50个回合的平均值。

-

² CV表示变异系数。

-

³ "收敛回合数"表示首次达到稳态奖励95%的回合。

(a)

(b)

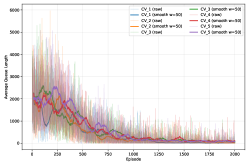

图5: 不同CV和算法的任务队列长度比较:(a) 不同CV的任务队列长度;(b) 不同算法的任务队列长度。

-

队列稳定性性能:图5a评估了通过将李雅普诺夫优化集成到决策循环中所实现的队列稳定性。我们考虑一个具有5个CV、3个RSU和李雅普诺夫控制参数V=5的设置。在图7(a)中,每辆车(CV1–CV5)的任务队列轨迹从初始瞬态迅速衰减到一个小的稳定窗口,并在此后有界,证明李雅普诺夫漂移项即使在异构到达情况下也能有效抑制积压增长。为使趋势清晰可见,曲线以原始形式和最后50个回合的移动平均平滑显示;两种视图一致地表明所有智能体快速收敛和低残余振荡,这意味着在车辆侧实现了稳定的任务接纳/卸载和鲁棒的队列调节。

图5b比较了算法间的平均系统队列长度(每回合所有CV的平均值)。与其他算法相比,我们的Ly-DTMPPO曲线表现出 (i) 更陡峭的下降阶段(更快的积压清除)和 (ii) 更低的稳态平台和减少的波动。这种行为与设计目标一致:漂移加惩罚机制强制执行队列稳定性,而DT增强的全局可见性改善了工作负载和信道动态的预测,实现了更具队列感知的资源分配。总体而言,时间演化队列的收敛证明了所提出的方案导致了稳定的任务分配过程和有界队列,从而在考虑的DT使能的ISAC辅助车联网场景中保证了稳定的系统运行。

(a)

(b)

(c)

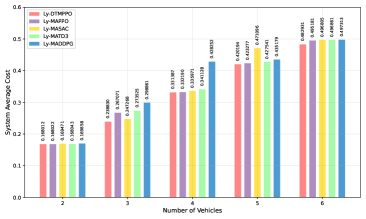

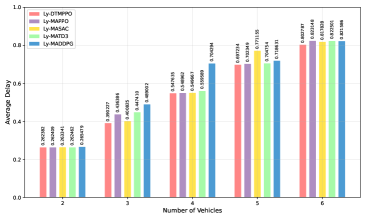

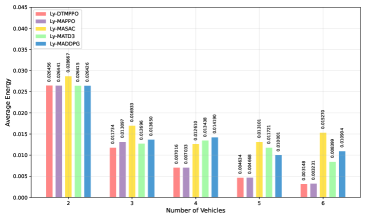

图6: 不同算法下系统性能随CV数量的变化:(a) 不同算法下系统平均成本随CV数量的变化;(b) 不同算法下平均延迟随CV数量的变化;(c) 不同算法下平均能耗随CV数量的变化。

-

CV数量的影响:图6a显示了CV数量对系统平均成本的影响。这个比较是在可配置权重α设置为0.6的条件下进行的,表明系统更重视系统延迟而非能耗。我们可以观察到,对于所有比较的算法,系统平均成本随着CV数量的增加而持续增加,这是由于更多CV带来了更高的计算和通信负载。然而,在所有流量负载(2–6个CV)下,提出的Ly-DTMPPO始终实现最低的成本。以两个代表性负载为例,在3个CV时,Ly-DTMPPO的成本相对于Ly-MAPPO、Ly-MASAC、Ly-MATD3、Ly-MADDPG分别降低了10.57%、3.41%、2.68%和20.09%。在4个CV时,降低幅度分别为0.24%、1.36%、2.86%和22.62%。在所有负载(2–6个CV)上平均,Ly-DTMPPO比Ly-MAPPO、Ly-MASAC、Ly-MATD3和Ly-MADDPG分别降低了2.81%、3.85%、4.02%和10.03%的成本。这表明,结合李雅普诺夫引导的优化和DT决策有效地平衡了延迟和能量开销,从而带来了优越的整体性能。

图6b呈现了不同CV数量下的平均延迟性能。正如预期的那样,由于更重的流量负载和对有限通信和计算资源的竞争,延迟随着车辆数量的增加而持续增加。在所有方案中,Ly-DTMPPO在所有场景下都保持了最低的平均延迟。例如,在3个CV时,Ly-DTMPPO的延迟相对于Ly-MAPPO、Ly-MADDPG、Ly-MASAC和Ly-MATD3分别降低了10.6%、20.2%、2.6%和12.8%。平均而言(2-6个CV),Ly-DTMPPO相对于这些基线实现了大约2.8%、9.8%、3.0%和3.7%的延迟降低。这些结果表明,PPO的同策略探索与DT增强的全局可见性和李雅普诺夫稳定的结合产生了更高效的资源分配,从而缓解了队列积累并降低了整体任务处理延迟。

图6c呈现了不同CV数量下的平均系统能耗。可以观察到,Ly-DTMPPO和Ly-MAPPO表现出从2→6个CV的单调递减,表明本地计算和RSU卸载之间的协调性逐渐改善。相比之下,Ly-MASAC在达到4个CV之前下降,但在5–6个CV时反弹;Ly-MATD3在4个CV时增加然后下降;Ly-MADDPG波动显著。这些非单调行为揭示了离策略基线在高移动性下可能导致不平衡的RSU利用和冗余卸载,从而导致振荡的能耗。

例如,在6个CV时,Ly-DTMPPO的能耗相对于Ly-MAPPO、Ly-MASAC、Ly-MATD3和Ly-MADDPG分别降低了2.6%、79.4%、62.5%和71.1%。总体而言,Ly-DTMPPO在整个负载范围(2-6个CV)内相比Ly-MAPPO实现了大约2-3%的平均能耗改善,而相对于其他方案的平均改善大约分别为46%、36%和37%。这表明,在李雅普诺夫优化和DT全局可见性的共同作用下,Ly-DTMPPO能够有效避免无效的本地计算和RSU过载,从而在保证服务质量的同时显著降低总系统能耗。

(a)

(b)

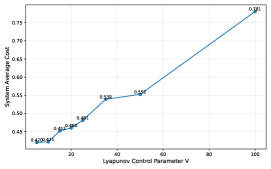

图7: 不同李雅普诺夫控制参数下的系统性能比较:(a) 系统平均成本随回合数在不同李雅普诺夫控制参数V下的变化;(b) 系统平均成本随李雅普诺夫控制参数V的变化。

-

李雅普诺夫控制参数V的影响:图7a和图7b说明了李雅普诺夫控制参数V对系统平均成本的影响。如图7a所示,所有V的设置最终都导致收敛。然而,稳态水平差异显著。对于小的V(例如,V=5或10),系统实现了相对较低的平均成本(约0.42),因为漂移-惩罚权衡强调队列稳定性,从而抑制了过度的任务积压。随着V的增加,平均成本逐渐上升(例如,在V=50时达到0.552,在V=100时达到0.781),这是由于任务队列中更大的平均积压累积,这放大了总成本中的延迟分量。

这一趋势表明,过大的V优先考虑即时能量最小化但忽略了延迟控制,而过小的V可能导致以能量效率为代价的激进队列清空。因此,选择适中的V实现了最平衡的权衡,确保最小的系统平均成本,同时保持李雅普诺夫稳定性。这些结果突显了在动态车辆环境中适当调整李雅普诺夫控制参数以充分利用漂移-惩罚框架的重要性。

VIII 结论

在本文中,我们研究了支持ISAC的车联网中DT辅助的任务卸载与资源分配。通过利用李雅普诺夫优化,我们将长期随机控制问题转化为每时隙问题,在平衡延迟和能耗的同时保证队列稳定性。为了进一步利用DT的全局可见性,我们提出了Ly-DTMPPO算法,该算法将基于李雅普诺夫的稳定性建模嵌入到CTDE多智能体强化学习框架中。这种设计使每个车辆能够使用DT空间提供的全局上下文信息做出自适应且稳定的决策。仿真结果验证了与现有的李雅普诺夫驱动和多智能体基线相比,Ly-DTMPPO实现了更快的收敛、更低的延迟和更高的能效,从而获得了最低的整体系统成本。这些发现表明,将李雅普诺夫优化与DT增强的策略学习相结合,为支持ISAC的车联网中的智能资源管理提供了一个鲁棒且可扩展的框架。未来的工作将把所提出的框架扩展到异构车辆边缘网络,并探索基于GenAI的鲁棒优化技术[43],以增强在动态车辆和频谱条件下的系统适应性。

引理1的证明

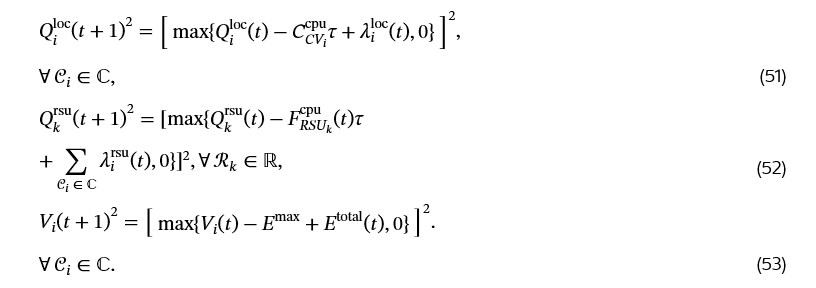

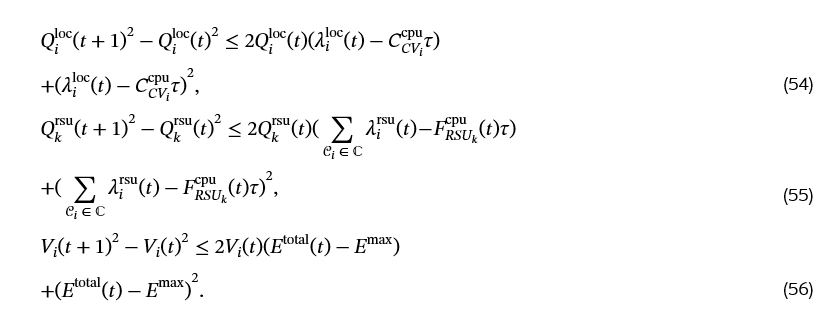

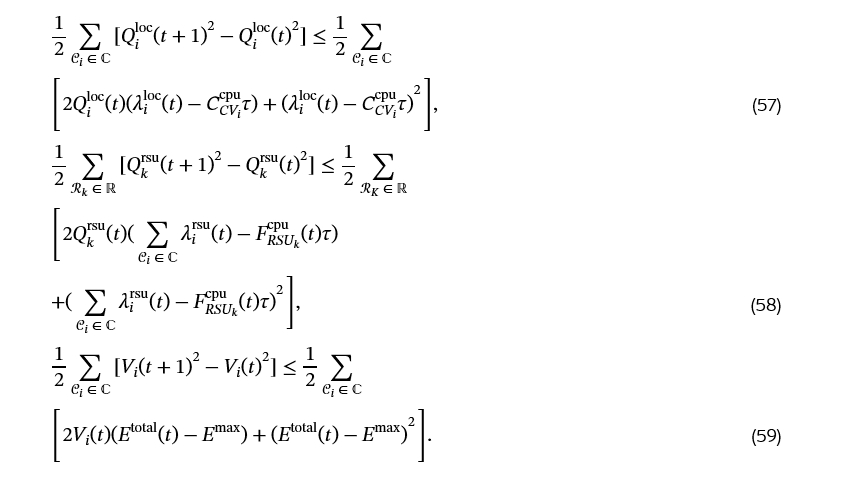

首先,对(16)、(• ‣ III-E)和(27)的两边进行平方,我们有:

然后,我们考虑不等式 [max{x,0}]² ≤ x²,(51)、(52)和(53)可以分别转换为以下方程:

接下来,将(54)对所有CV求和。类似地,对(55)和(56)进行相同的操作。它们成立:

我们定义:

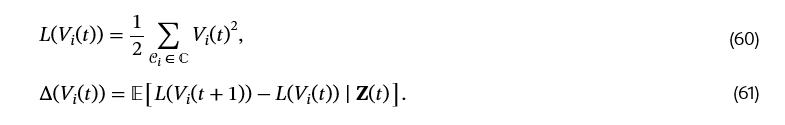

然后,对(57)、(58)和(59)的两边取条件期望,我们有:

对(62)、(63)和(64)中的四个不等式求和:

其中 B(t) = B_1(t) + B_2(t) + B_3(t).

最后,通过将与队列状态无关的上界元素分组为一个常数项B,并通过确定卸载决策ℓ(t)、带宽分配b(t)、计算资源分配F(t)和能量消耗项E_total(t),所有的B_1(t)、B_2(t)、B_3(t)在每个时隙都成为确定性常数。因此,整体上界B(t)简化为一个常数B,这完成了引理1的证明。

540

540

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?