前言:scrapy是个非常不错的处理高并发的爬虫框架,其底层是异步框架 twisted,优势明显。

现在来看一个问题:当存在多个爬虫的时候如何指定对应的管道呢?

这里定义了两个爬虫:film、meiju

1.首先想到settings设置文件。

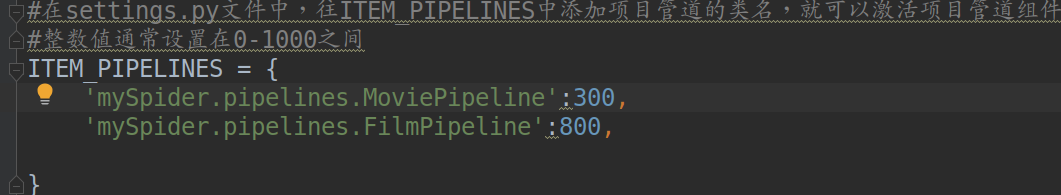

settings里针对item_pipelines的设置如下:

内置设置参考:ITEM_PIPELINES

默认: {}

包含要使用的项目管道及其顺序的字典。顺序值是任意的,但通常将它们定义在0-1000范围内。较低订单处理较高订单前。

例:

对应管道文件:

但是我遇到一个问题,当我单独运行film或者meiju时总会指定到settings里的第一个配置管道,也就是

本文探讨了在Scrapy中处理多个爬虫时如何为每个爬虫指定不同的Item Pipeline。方法包括:1) 通过settings设置文件,但会受全局属性影响;2) 在Pipeline中判断爬虫来源,实现逻辑差异化;3) 直接在爬虫内部设置Pipeline,适用于Scrapy 1.1及以上版本。

本文探讨了在Scrapy中处理多个爬虫时如何为每个爬虫指定不同的Item Pipeline。方法包括:1) 通过settings设置文件,但会受全局属性影响;2) 在Pipeline中判断爬虫来源,实现逻辑差异化;3) 直接在爬虫内部设置Pipeline,适用于Scrapy 1.1及以上版本。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1677

1677

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?