安装、配置、启动Spark集群

在 master 节点操作

(1)切换到 /opt 目录下

cd /opt/

(2)在官网下载spark的安装包,并上传至服务器上

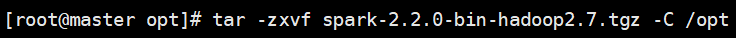

(3)解压 spark 文件到当前目录(/opt)下面,使用相对路径或者绝对路径均可,下面的命令使用绝对路径

tar -zxvf spark-2.2.0-bin-hadoop2.7.tgz -C /opt

(4)给Spark文件重命名为spark-2.2.0

mv spark-2.2.0-bin-hadoop2.7 spark-2.2.0

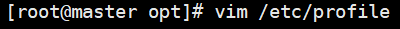

(5)配置环境变量,编辑 /etc/profile 文件,在文件最后添加 spark 路径

vim /etc/profile

export SPARK_HOME=/opt/spark-2.2.0

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

Spark集群安装与启动教程,

Spark集群安装与启动教程,

该文详细介绍了如何在master节点上安装、配置Spark2.2.0,并通过Yarn模式运行计算程序,然后将配置复制到slave节点,最终启动整个Spark集群的过程。

该文详细介绍了如何在master节点上安装、配置Spark2.2.0,并通过Yarn模式运行计算程序,然后将配置复制到slave节点,最终启动整个Spark集群的过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

490

490

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?