首先crossentropy的定义为

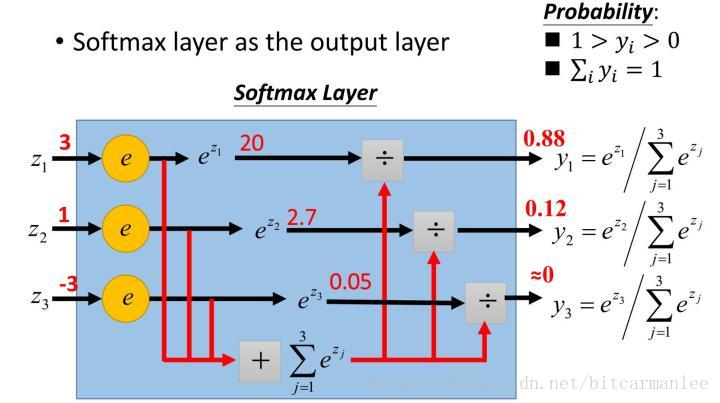

softmax的直观定义(摘于李宏毅教授主页http://speech.ee.ntu.edu.tw/~tlkagk/courses.html)

softmax它将多个神经元的输出,映射到(0,1)区间内,可以看成概率来理解,从而来进行多分类!以手写数字图像识别为例。softmax输出的是一个十维的vector,比如待识别的数字是2,则我们希望的是在索引为2处的值最大,此时y可能是

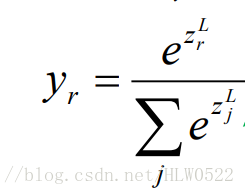

在Backpropagation中我们需要求

![[ Z^L_{1},Z^L_{2}... Z^L_{10} ]](https://img-blog.csdnimg.cn/20181228160440839)

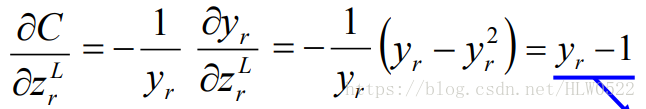

1)当i=r时( 注:此时yr的分子分母都含有

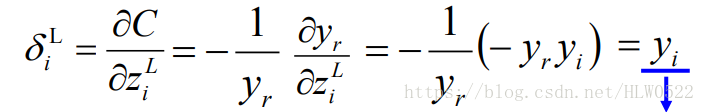

2)i≠r时 ( 注:此时yr的只有分母都含有

1581

1581

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?