本文重点

导数作为微积分学的核心概念之一,不仅在数学领域内占有举足轻重的地位,更在实际问题中发挥着不可替代的作用。我们要想学习反现象传播算法,我们前提是先要学习导数的概念。本节课程我们将看一下导数是什么?

导数

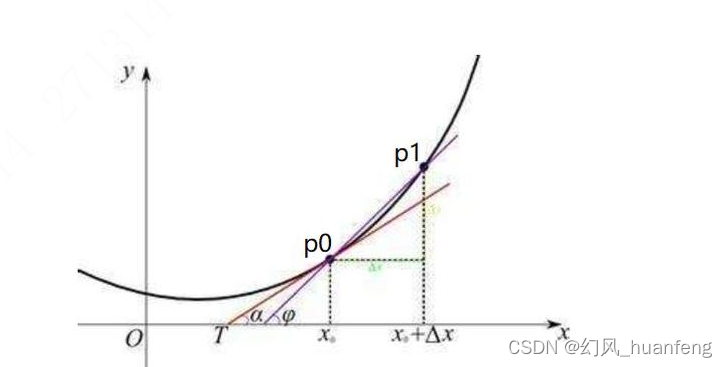

导数,顾名思义,是函数在某一点或某一段区间内变化率的极限。从几何角度来看,它描述了函数图像在某一点的切线斜率;从物理角度来看,它反映了物体运动的速度或加速度等物理量。具体来说,设函数y=f(x)在点x₀的附近有定义,当自变量x在x₀处有增量Δx(x₀+Δx也在该函数的定义域内)时,相应地函数取得增量Δy=f(x₀+Δx)-f(x₀);如果Δy与Δx之比当Δx→0时极限存在,则称函数y=f(x)在点x₀处可导,并称这个极限为函数在点x₀处的导数,记作f'(x₀)或df(x₀)/dx,简称导数。

这里有一条曲线,其中x是自变量

当x=x0的时候f(x0)=p0

假定稍微增大一点点x0,假如只增大▲x,这个▲x非常小,那么f(x+▲x)=p1

所以(p1-p0)/(▲x)=斜率

也就是三角形的高度/宽度,也就是斜率,我们可以说在x=x0的地方的斜率,这就是斜率的直观体现。

导数的性质

导数具有一系列重要的性质ÿ

订阅专栏 解锁全文

订阅专栏 解锁全文

586

586

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?