机器学习中分类和预估算法的评估:

- 准确率

- 速度

- 强壮性

- 可规模性

- 可解释性

——————————————————————————————

1.什么是决策树/判定树(decision tree)?

每个内部节点代表在一个属性上的测试

每个分支代表一个属性输出

每个树叶结点代表类或者类分布

树的最顶层是根节点

2.机器学习中分类算法的一个重要算法

3.构造决策树的基本算法

3.1熵概念:

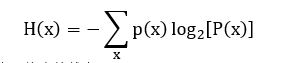

信息和抽象,如何度量?

一条信息的信息量的大小和他的不确定性有直接关系,要搞清一件非常非常不确定的事情,或者一无所知的事情,需要大量的信息==》信息量的度量就等于不确定性的多少。

比特(bit)来衡量信息的多少,

变量的不确定性越大,熵也就越大。

3.1决策树归纳算法(ID3)

选择属性判断节点:

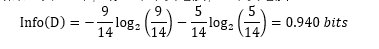

信息获取量:Gain(A)=Info_(D)-Info_A(D)

通过A来作为节点分类获取了多少信息

如:结果:共14个,有5个不买电脑,9个买电脑

3.1其他算法:

C4.5

CART

区别:属性选择的度量方法不同

3.2如何处理连续变量的属性?

将其离散化

4.树剪枝叶(避免overfitting)

4.1先剪枝

4.2后剪枝

5.决策树优点:直观,便于理解,小规模数据有效

缺点:处理连续变量不好,类别较多时,错误增加的比较快,可规模性一般

—————————————————————————————————

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?