centos6.6 搭建hadoop-2.6.0

1 在VMware下建三个虚拟机,分别表示一个master,两个slave。

可以用hostname 查看主机的名称。 并用host XX 改主机的名字(XX表示主机的名字)

也可以 vim /etc/sysconfig/network

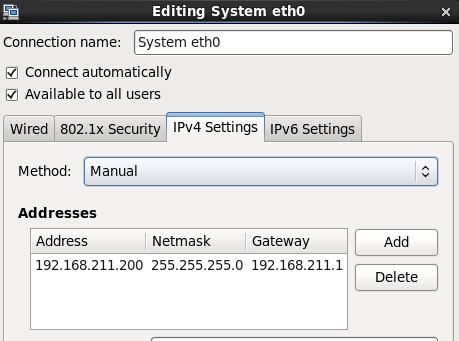

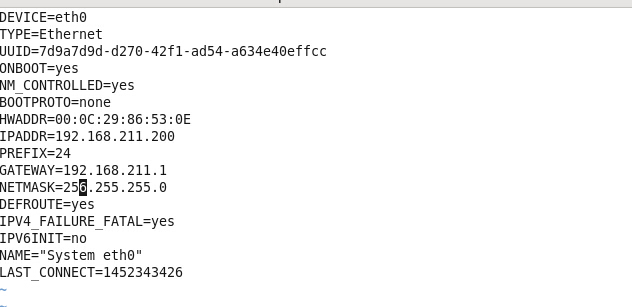

2 配置三个虚拟机的iP,每个主机都要配置。

可以用 vim /etc/sysconfig/network-scripts/ifcfg-eth0

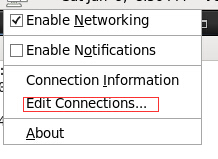

也可以点击右上方网络图标,进行手动进行配置。

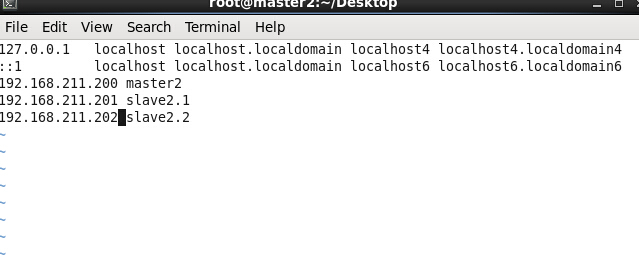

3 建立三台虚拟机的映射关系,每台都要进行设置。

vim /etc/hosts

4 关闭系统防火墙。

chkconfig iptables off

每台都要做,注意防火墙关闭后要重启。

可用 chkconfig iptables –list 查看系统防火墙是否关闭,全为off。

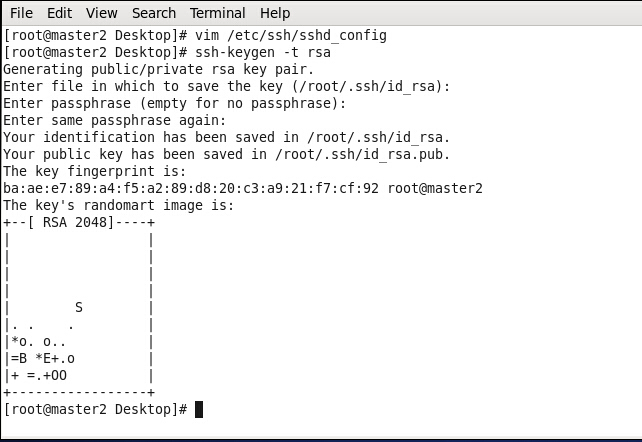

5配置SSH密码登陆

5.1 Hadoop 需要通过ssh登陆到各个节点,每个机器都生成公钥,再合并到authorized_keys文件中。

删除/etc/ssh/sshd_config中的两行注释,每台都要删除。

RSAAuthentication yes

PubkeyAuthentication yes

5.2 输入 ssh-keygen -t rsa .一直ENTER生产key,直到生产图案。

5.3 合并公钥到authorized_keys文件。进入/root/.ssh目录。每台机器都要做。

cat id_rsa.pub>>authorized_keys

5.4 进入master机器 /root/.ssh目录

执行下面命令

ssh root@slave2.1 cat /root/.ssh/id_rsa.pub>>authorized_keys

ssh root@slave2.2 cat /root/.ssh/id_rsa.pub>>authorized_keys

5.5 将master2节点的authorized_keys 和known_hosts复制到slave节点。

scp -r /root/.ssh/authorized-keys root@slave2.1:/roor/.ssh

scp -r /root/.ssh/konwn_hosts root@slave2.1:/root/.ssh

scp -r /root/.ssh/authorized-keys root@slave2.2:/roor/.ssh

scp -r /root/.ssh/konwn_hosts root@slave2.2:/root/.ssh

5.6 复制完成验证是否成功。

ssh slave2.1

ssh slave2.2

查看是否能进入slave节点。

但是如果遇到提示:

# Agent admitted failure to sign using the key

需要登录密码才能进去,这样就失去了免登录的意义了。

执行命令:

# ssh-add /root/.ssh/id_rsa

会有如下提示信息:

Identity added: /root/.ssh/id_rsa (/root/.ssh/id_rsa)

这时候执行命令:

# ssh slave1

就可以直接登陆到slave1节点了。如果想返回到主机节点上Ctrl + D 退出登录。

6 安装JAVA JDK

6.1 卸载自带的JDK

可以通过命令 rpm -qa|grep java 查看系统自带的jdk信息。比如:

java-1.7.0-openjdk-1.7.0.65-2.5.1.2.el6_5.i686

卸掉系统的jdk:

rpm -e –nodeps java-1.7.0-openjdk-1.7.0.65-2.5.1.2.el6_5.i686

然后输入指令java 如果显示

bash:java:command not found 则表示删除Java 成功。

6.2 安装jdk

在usr目录下新建java文件夹。将jdk安装包放在/usr/java/。

tar -zxvf jdk-8u51-linux-i586.gz 解压到当前文件夹。

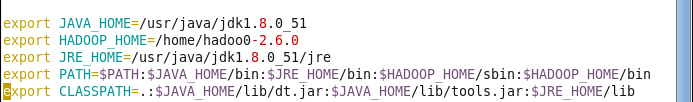

6.3 配置JAVA环境变量

vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_51

export JRE_HOME=/usr/java/jdk1.8.0_51/jre

export PATH=

PATH:

JAVA_HOME/bin:

JREHOME/bin:exportCLASSPATH=.:

JAVA_HOME/lib/dt.jar:

JAVAHOME/lib/tools.jar:

JRE_HOME/lib

修改完环境变量后更新下配置文件

#source /etc/profile

7 配置Hadoop变量及文件

7.1 配置HADOOP_HOME变量

vim /etc/profile

更新配置文件

source /etc/profile

7.2 配置Hadoop文件

打开hadoop-env.sh 和yarn-env.sh

加入 export JAVA_HOME=/usr/java/jdk_1.8.0_51

配置slaves文件 ,删除localhost,加入节点的名字,每台机器都要做。

vim slaves

添加:

slave201

slave202

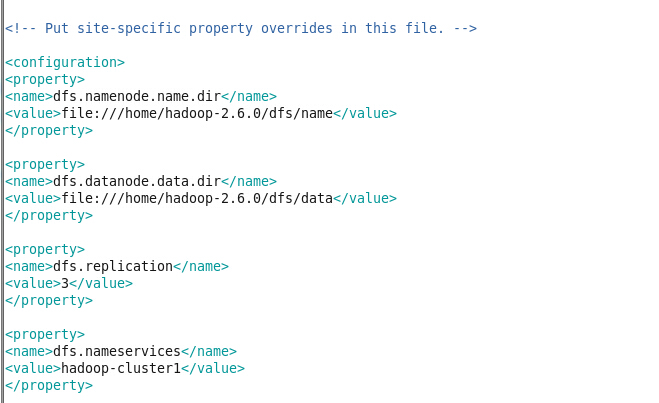

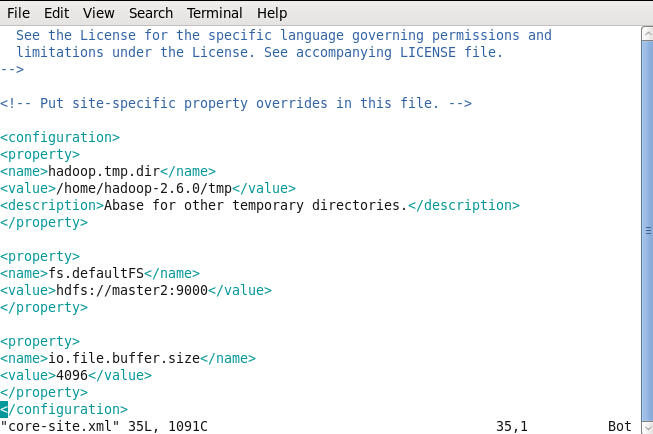

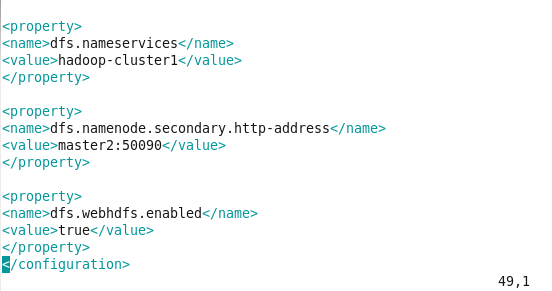

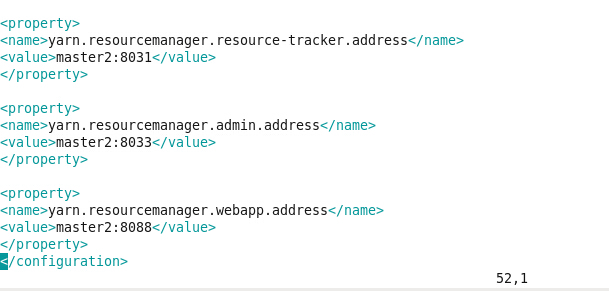

7.3分别配置core-site.xml hdfs-site.xml yarn-site.xml mapred-site.xml(如果没有就新建文件)

core-site.xml

hdfs-site.xml

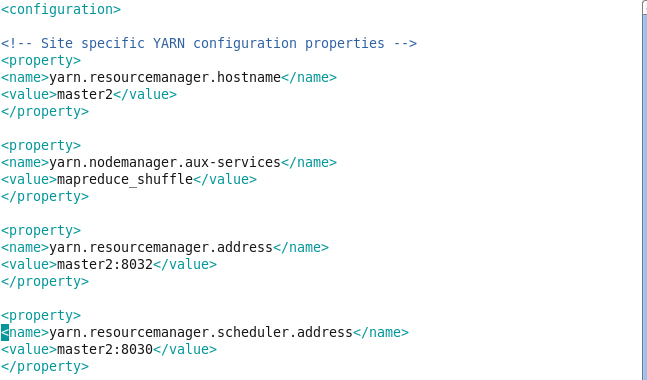

yarn-site.xml

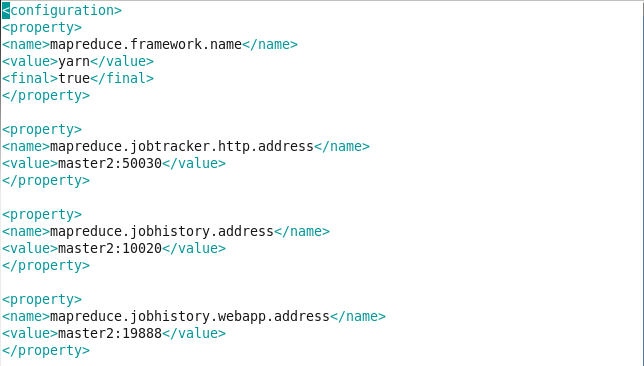

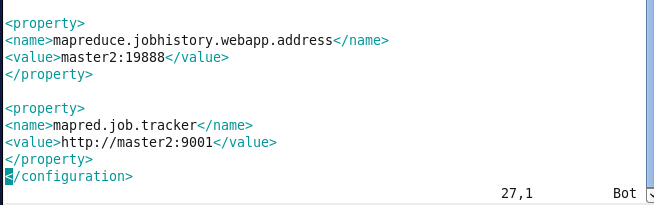

mapred-site.xml

7.4 配置结束后,把Hadoop文件和JDK文件复制到slave节点上,注意文件目录要一样,不然要修改配置文件。

scp -r /usr/java/jdk1.8.0_51 root@slave201:/usr/java/

scp -r /usr/java/jdk1.8.0_51 root@slave202:/usr/java/

scp -r /home/hadoop-2.6.0 root@slave201:/home/

scp -r /home/hadoop-2.6.0 root@slave202:/home/

还要修改slave的环境变,和master节点一样。

vim /etc/profile

注意修改后要

source /etc/profile

8 启动hadoop

8.1 启动前要格式化namenode

cd /home/hadoop-2.6.0

bin/hdfs namenode -format

8.2 格式化完成后

sbin/start-all.sh

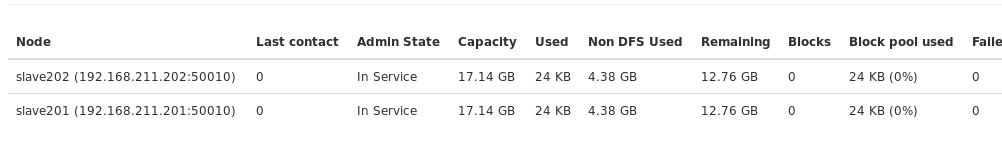

这时可以通过jps命令来查看是否成功。或者通过浏览器

,在浏览器中输入loacalhost:50070。

这样就显示成功了。

由于是新手安装过程中碰到很多困难,看过许多人的文章,

在这里特别要感谢刘师兄,在他的文章及指导下才配置成功的。下面是他博客链接:

http://blog.sina.com.cn/s/blog_945b0eac0102vspy.html

文章中可能会有问题,恳请批评指正。

3261

3261

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?