CTranslate2是一个高性能的机器翻译引擎,由OpenNMT团队开发,提供轻量级、可移植且快速的框架,使开发者和研究人员能够轻松地部署和优化大规模的翻译模型。以下是关于CTranslate2的详细介绍:

- 核心特性:

- 高性能:无论是在CPU还是GPU上,CTranslate2都提供了卓越的速度表现。

- 易于集成:简单的API设计使得将CTranslate2集成到现有工作流程中变得容易。

- 跨平台:支持Windows、Linux和macOS等操作系统。

- 可扩展:提供自定义编译选项,允许根据需要调整性能和大小的平衡。

- 技术分析:

- 模型推理优化:CTranslate2采用了高度优化的模型推理实现,支持多种硬件平台,包括CPU和GPU,并利用了底层的并行计算库如Intel MKL或cuDNN来最大化性能。

- 动态图执行模式:允许在运行时调整输入序列的长度,降低了对内存的需求。

- 模型兼容性:支持ONNX模型导入,可以方便地迁移来自不同深度学习框架(如TensorFlow、PyTorch等)的预训练模型。

- 序列编码器-解码器架构:基于标准的Transformer模型结构,这是目前NMT领域的主流范式,可以定制不同的编码器和解码器层以适应特定任务。

- 多线程与并行处理:通过多线程和设备间通信的优化,CTranslate2能在多核处理器上高效运行,甚至可以跨多个GPU进行数据并行。

- 应用场景:

- 在线翻译服务:实时为用户提供高质量的文本翻译。

- 文档处理:批量转换文档中的多语种内容。

- 智能客服:自动理解并回复多语言的用户咨询。

- 本地化工具:在游戏中或软件中实现实时的多语言切换。

- 加速原理:

- 使用卷积神经网络(CNN)加速模型的编码器层,提高运行效率。

- 自适应编码器解码器选择(ADES)技术,根据输入序列的长度自动选择适当的编码器和解码器层数。

- 自动混合精度(AMP)技术,在不降低精度的情况下,以较低的计算和存储成本提高模型的性能。

- 高度优化的多线程和向量化实现,充分利用现代硬件的并行处理能力。

- 额外功能:

- 支持权重量化、层融合、批量重新排序等性能优化技术,以加速和减少Transformer模型在CPU和GPU上的内存使用。

- 支持降低精度的权重,包括16位浮点(FP16)、16位脑浮点(BF16)、16位整数(INT16)和8位整数(INT8)。

综上所述,CTranslate2是一个功能强大、易于使用且性能卓越的神经机器翻译解决方案,适用于研究、生产以及各种自然语言处理任务。

import ctranslate2

import sentencepiece as spm

import os

def tokenize(sp, queries):

if isinstance(queries, list):

return sp.encode(queries, out_type=str)

else:

return [sp.encode(queries, out_type=str)]

def detokenize(sp, queries, lang):

translation = sp.decode(queries)

prefix_len = len(lang) + 1

translation = [''.join(query)[prefix_len:] for query in translation]

return translation

os.environ["KMP_DUPLICATE_LIB_OK"]="TRUE"

sp = spm.SentencePieceProcessor()

sp.load("m2m100_418m\sentencepiece.model")

# 假设'zh'对应的文本表示是'<2zh>'(这只是一个例子,实际情况可能不同)

zh_token_text = '<2zh>'

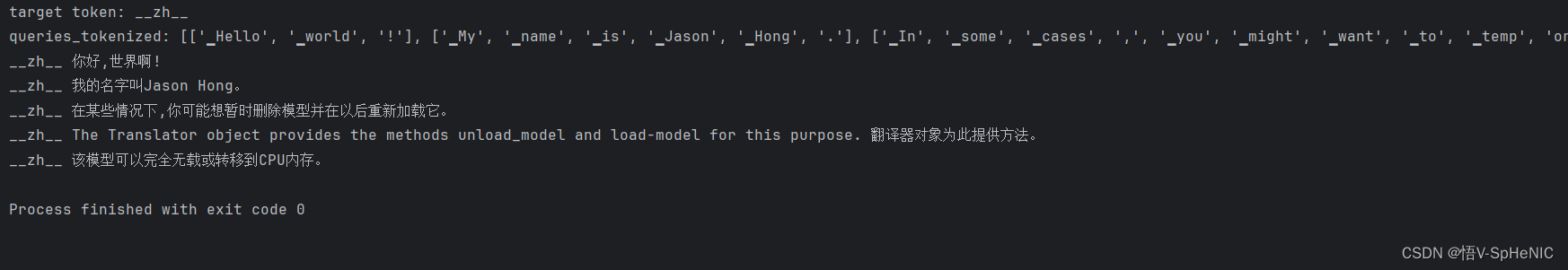

zh_token_id = "__zh__"

print(f"target token: {zh_token_id} " )

# source = sp.encode("Hello world!", out_type=str)

queries= ["Hello world! ",

"My name is Jason Hong.",

"In some cases, you might want to temporarily unload the model and load it back later. ",

"The Translator object provides the methods unload_model and load_model for this purpose. ",

"The model can be either fully unloaded or moved to the CPU memory. "]

translator = ctranslate2.Translator("m2m100_418m")

queries_tokenized = tokenize(sp,queries)

print(f"queries_tokenized: {queries_tokenized} ")

results = translator.translate_batch(

source=queries_tokenized,

target_prefix=[[zh_token_id]] * len(queries),

beam_size=5,

max_batch_size=1024,

return_alternatives=False,

disable_unk=True,

replace_unknowns=True,

repetition_penalty=3)

# 对翻译结果进行去分词(detokenize)

translations = [sp.decode(ids.hypotheses[0]) for ids in results]

# 打印翻译结果

for translation in translations:

print(translation)

输出结果:不知道第四条,怎么还有原文 ,求大神指点

692

692

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?