前言

通过通过yarn.provided.lib.dirs配置选项指定位置,将flink的依赖上传到hdfs文件管理系统

1. 实践

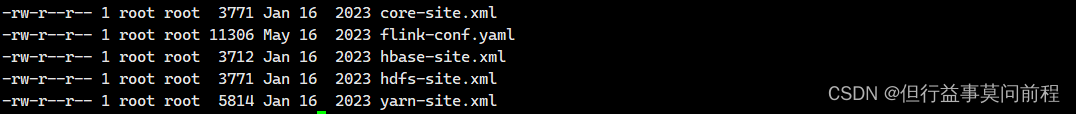

(1)生产集群为cdh集群,从cm上下载配置文件,设置环境

export HADOOP_CONF_DIR=/home/conf/auth

export HADOOP_CLASSPATH=`hadoop classpath`

(2)上传flink的lib和plugins、自己的jar包到hdfs上

hdfs dfs -put lib/ /flink-dist

hdfs dfs -

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?