学习完吴恩达的机器学习视频,看过机器学习实战及学习了网上的一些博客之后,在这里对我学习到的逻辑回归知识做一个学习总结。

1.线性回归和sigmoid函数

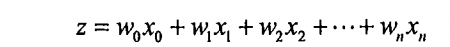

逻辑回归是一种分类算法,它可以解决二分类问题,它的实质是线性回归+逻辑函数,传统的线性回归是为了找到能更好地拟合真正的函数曲线的最佳参数,线性回归如下:

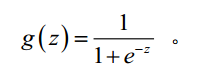

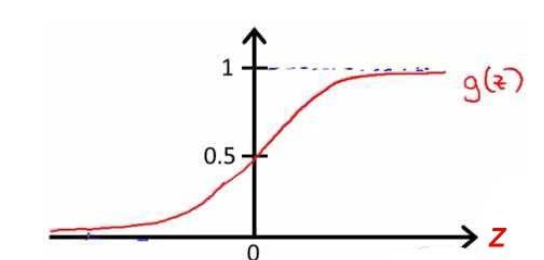

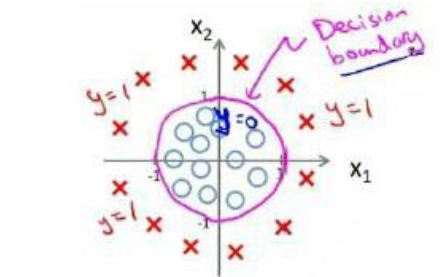

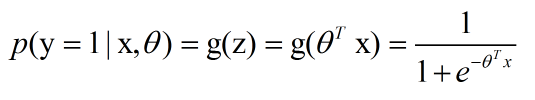

如果用线性回归做分类的话,由于最终的结果可能会远大于或远小于分类结果1和0,所以我们加入sigmoid逻辑函数,这个逻辑函数把把输出值固定在0-1之间,sigmoid的公式和图像如下:

而且这个最终的g(z)的输出结果也很有趣,它可以表示函数点在

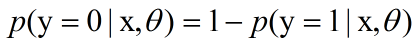

也即

2.极大似然估计

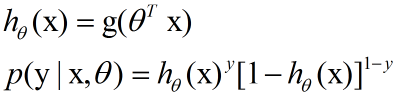

现在我们有一个逻辑回归分类器,它输出的是分类结果为1的概率,当大于等于0.5时,我们认为其分类结果为1,当小于0.5时,我们认为其分类结果是0。有了训练集,为了构建逻辑回归模型,我们使用最大似然估计。对于单个样本,其后验概率为:

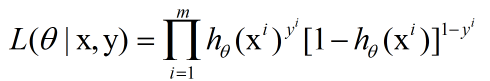

则m个样本的极大似然函数是:

log似然是:

3.梯度上升法

我们现在的目标是使上面的log似然最大,也即是使属于0类的被判定到0类的概率和属于1类被判定到1类的概率的乘积最大。

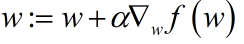

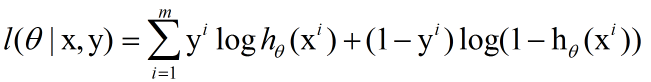

我们经常听到梯度下降法,梯度上升法是为了求函数的最大值,而梯度下降法是为了求函数的最小值。梯度算子总是指向函数值增长最快的方向,梯度上升法沿梯度方向一小步一小步地移动,这样函数值才会增大,这一小步即移动量被称为步长,记作α,梯度上升法和梯度下降法的迭代公式是:

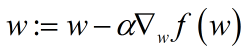

其目的是为了求使函数值最大或最小的参数w,可以注意到它求导也是对w求导的,w是函数值f(w)的自变量,当然我们这里的w指的是θ,下面我们使用梯度上升法求出其具体的迭代公式:

该公式将一直被迭代执行,直至达到某个停止条件为止,比如迭代到某个指定值或算法达到某个可以允许的误差范围。

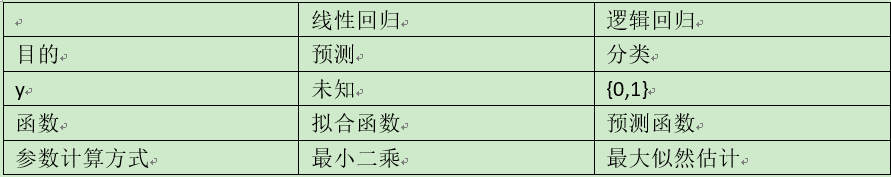

4.线性回归与逻辑回归区别

多类别分类问题参考:

http://52opencourse.com/125/coursera%E5%85%AC%E5%BC%80%E8%AF%BE%E7%AC%94%E8%AE%B0-%E6%96%AF%E5%9D%A6%E7%A6%8F%E5%A4%A7%E5%AD%A6%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E7%AC%AC%E5%85%AD%E8%AF%BE-%E9%80%BB%E8%BE%91%E5%9B%9E%E5%BD%92-logistic-regression

SVM多分类问题:

http://www.cnblogs.com/CheeseZH/p/5265959.html

参考:

吴恩达机器学习视频

机器学习实战

http://www.cnblogs.com/sparkwen/p/3441197.html?utm_source=tuicool&utm_medium=referral

http://blog.csdn.net/weixin_30014549/article/details/52850870

http://blog.csdn.net/yunhaitianguang/article/details/43877591

http://blog.csdn.net/pakko/article/details/37878837

936

936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?