很多时候,本地修改代码以后,pycharm并不能及时地与远程服务器上进行同步。

今天偶尔发现了同步的方法,记录下来:

方法一、

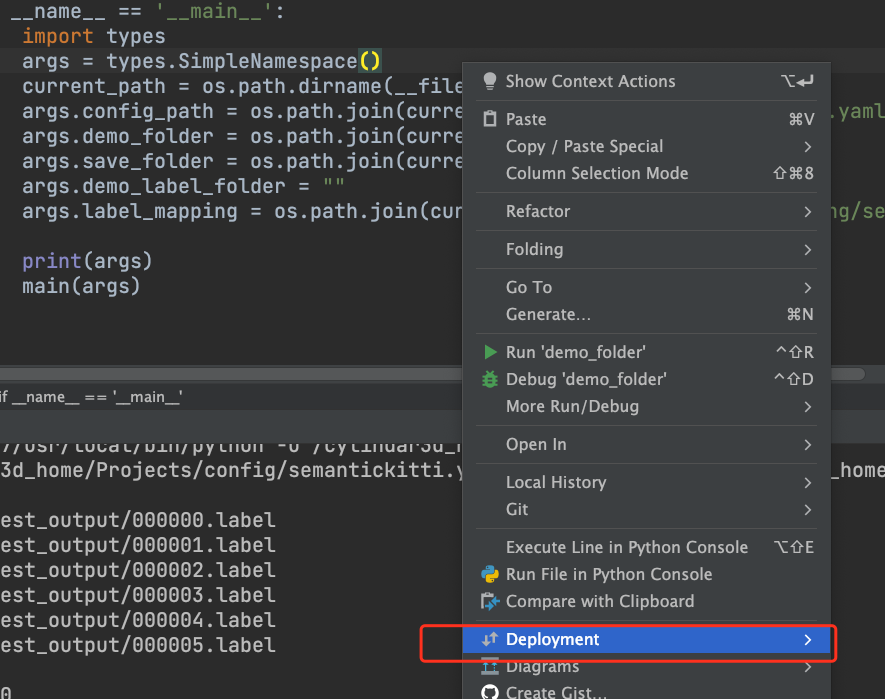

1、在要同步的文件/文件夹上右击,

补充:

如果是正在修改的代码,可以在代码内部直接右击;也能够出现Deployment按钮。

2、选择Deployment

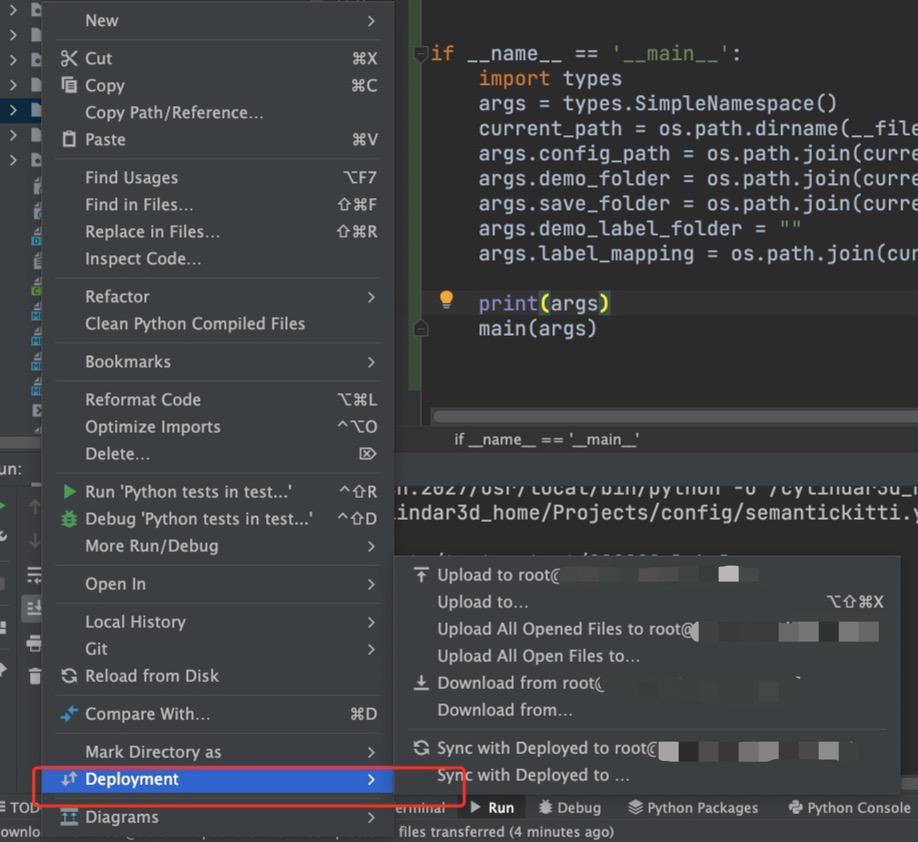

3、选择Upload to root@......这个

这样就可以了。

同样的还有:Download from root@.....

注意:

要同步哪个文件,就在这个文件上进行右击。不要在最外层的文件夹上执行Upload、Download,会非常耗时间。

方法二、

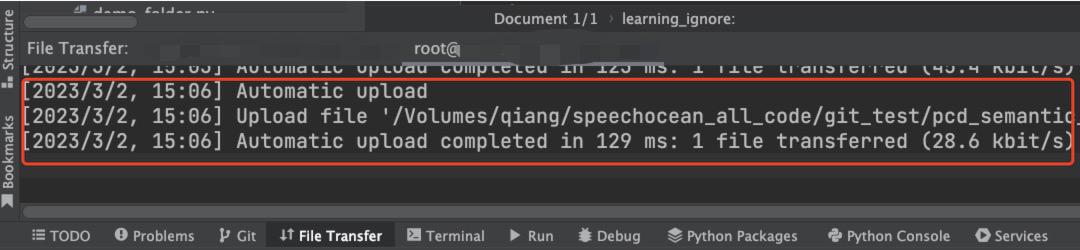

修改完某一个代码后,直接按ctrl + s进行保存,也会自动Upload。

可以在下面的窗口中看到Upload的提示:

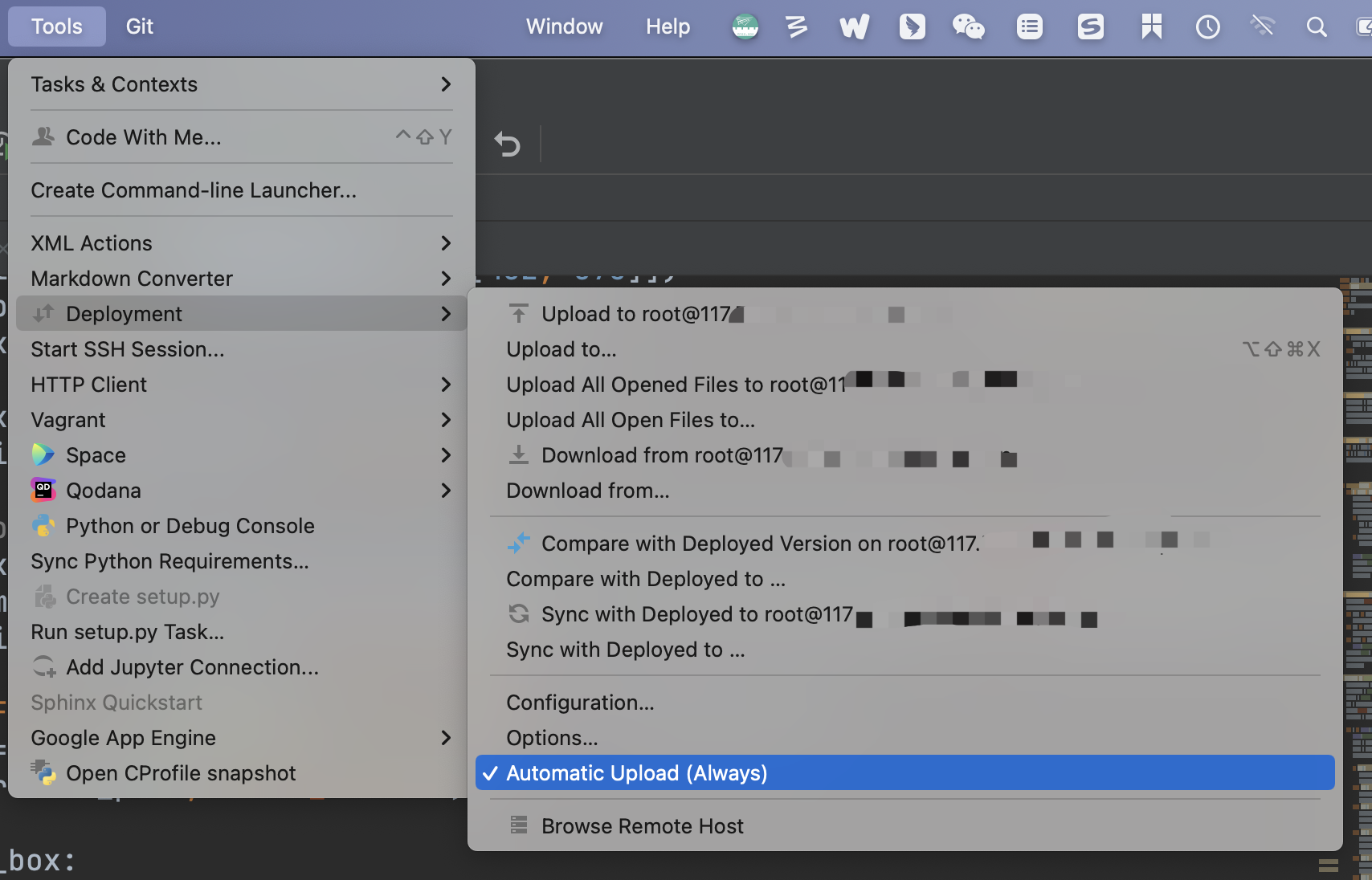

注意:后来我才发现要想 ctrl + s自动上传代码到远程,需要打开下图中的 “Automatic Upload”

不打开这个,是不行的。

从别人那里学来了两个有用的配置:

来自:【全过程】Pycharm 远程服务器调试 配置 project Interpreter_pycharm远程调试_爱科研的徐博士的博客-CSDN博客

我们可以进行一个简单的配置, Tool---Deployment--Options,重新配置如下划线两处。第一处代表,可以允许在服务器上建立空文件路径,第二处代表,当在本地执行保存(ctrl + s)操作的时候,会把保存后的修改同步到服务器上。 点击OK完成修改配置。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?