HDFS分布式文件系统

一、HDFS的简介

二、HDFS的架构和原理

默认一个Block大小为128MB,通常备份三份

默认一个Block大小为128MB,通常备份三份

三、HDFS的Shell操作

【常用的命令】:

-help

hdfs dfs -help [cmd]

显示命令的帮助信息

-mkdir

hdfs dfs -mkdir [-p] <paths>

创建文件夹,-p用于时是否递归创建

-put

hdfs dfs -put <localsrc> ... <dst>

上传本地文件到HDFS

-get

hdfs dfs -get [ignorecrc] [-crc] <src> <localdst>

从HDFS下载文件到本地

-cat

hdfs dfs -cat URI[URI...]

查看文件内容

-rm

hdfs dfs -rm URI[URI...]

删除指定的文件,只删除非空目录和文件。

-r递归删除,可以删除有文件的文件夹。

-mv

hdfs dfs -mv URI[URI...] <dest>

将文件从源路径移动到目标路径,这个命令允许有多个源路径,此时目标路径必须是一个目录

注意:不允许在不同的文件系统间移动文件

-cp

hdfs dfs -cp URI[URI...] <dest>

将文件从源路径复制到目标路径,这个命令允许有多个源路径,此时目标路径必须是一个目录

四、案例

1. 创建相关的目录

2. 创建脚本文件

五、HDFS的Java API操作

1. windows 下载安装配置JDK

1) 下载JDK1.8 64位安装包

2) 安装

双击下载的安装包,开始安装

提示安装完成

提示安装完成

安装在本地的目录

3) 配置环境变量

JAVA_HOME环境变量配置

完成创建

修改PATH变量

修改PATH变量

4) 测试java是否安装成功

按下win+r,打开运行窗口

在命令行窗口中,输入:

在命令行窗口中,输入:

java -version

2. 下载并安装配置maven

1) 下载maven

百度搜索apache maven之后就让官网

选择对应的版本压缩包进行下载

选择对应的版本压缩包进行下载

2) 解压到某个盘下

3) 配置环境变量

配置系统变量

添加path变量

4) 测试maven是配置成功

命令行输入 mvn –version 出现以下提示则说明peizi5成功

3. 下载并安装idea

下载社区版就可以

下载后点击启动完成安装

4. 编写一个maven项目,测试jdk、maven和idea

1) 启动idea,新建一个maven项目

建立完成后,主界面如下所示:

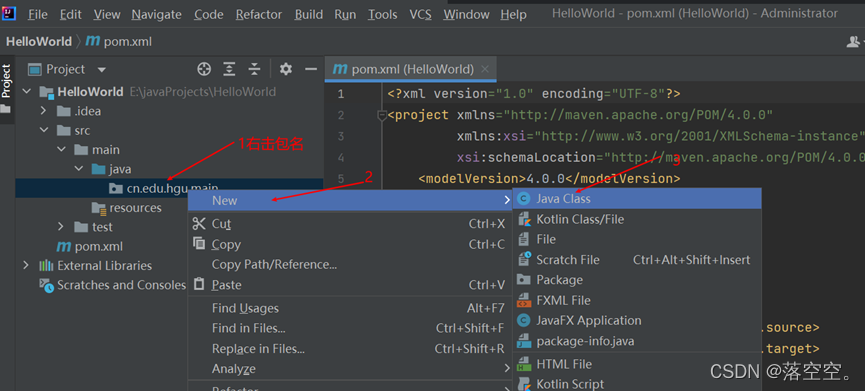

2) 新建一个包

3) 新建一个类

4) 输入代码

5) 运行,查看结果

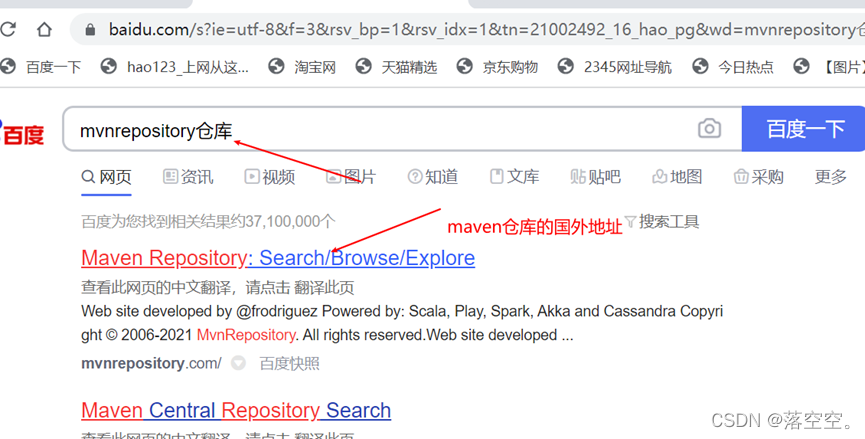

6) 配置国内maven镜像库

复制粘贴到项目的pom文件中,保存后点击pom刷新按钮后自动下载

但因默认仓库在国外,下载比较慢,需要修改maven仓库为国内的镜像

搜索阿里的仓库镜像

查看其配置指南

修改maven仓库的存放位置,默认在c盘下,容易造成c盘空间满,一般放在其他盘下

修改maven国内镜像地址

5. 修改idea使用国内maven镜像仓库搭建项目环境

后面由于版本问题,我idea版本一律用的是2018.3.6,不影响

6. 案例——使用Java API操作HDFS

1) 新建一个maven项目

2) 修改项目的maven仓库使用国内镜像

3) 修改pom.xml文件,添加pom依赖

只添加一个依赖即可

出现这些就表示成功

4) 初始化客户端对象

5) 启动hadoop和yarn集群

6) 运行,查看结果

说明项目搭建成功

7) 在hadoop集群上创建一个文件夹

8) 删除文件夹

9) 上传文件

10) 下载文件

如果下载后代码提示如下错误:

则需要下载hadoop文件hadoop-3.1.2放到指定位置,并且添加环境变量,之后便会无报错运行

本文详细介绍了HDFS分布式文件系统的概念、架构及原理,重点讲解了HDFS的Shell命令,包括创建目录、上传下载文件、查看内容、删除和移动等操作。此外,还通过JavaAPI展示了如何在Windows环境下配置JDK、Maven和IDEA,以及如何使用JavaAPI进行HDFS文件操作,包括创建文件夹、删除文件夹、上传和下载文件等步骤,最后解决了在运行中遇到的环境配置问题。

本文详细介绍了HDFS分布式文件系统的概念、架构及原理,重点讲解了HDFS的Shell命令,包括创建目录、上传下载文件、查看内容、删除和移动等操作。此外,还通过JavaAPI展示了如何在Windows环境下配置JDK、Maven和IDEA,以及如何使用JavaAPI进行HDFS文件操作,包括创建文件夹、删除文件夹、上传和下载文件等步骤,最后解决了在运行中遇到的环境配置问题。

1104

1104

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?