最近我必须执行一项从一个需要登录的网站上爬取一些网页的操作。它没有我想象中那么简单,因此我决定为它写一个辅助教程。

在本教程中,我们将从我们的bitbucket账户中爬取一个项目列表。

教程中的代码可以从我的 Github 中找到。

我们将会按照以下步骤进行:

-

提取登录需要的详细信息

-

执行站点登录

-

爬取所需要的数据

在本教程中,我使用了以下包(可以在 requirements.txt 中找到):

requests

lxml

步骤一:研究该网站

打开登录页面

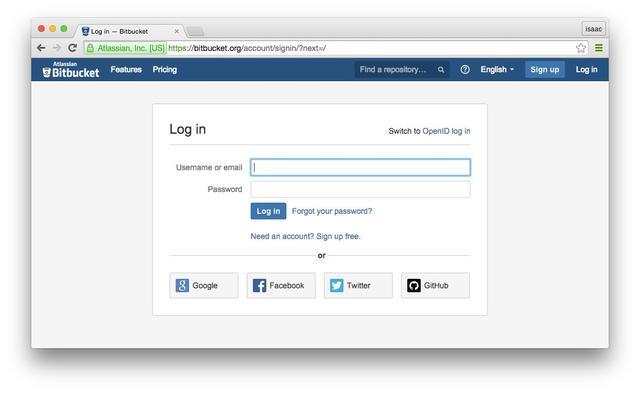

进入以下页面 “bitbucket.org/account/signin”。你会看到如下图所示的页面(执行注销,以防你已经登录)

仔细研究那些我们需要提取的详细信息,以供登录之用

在这一部分,我们会创建一个字典来保存执行登录的详细信息:

- 右击 “Username or email” 字段,选择“查看元素”。我们将使用 “name” 属性为 “username” 的输入框的值。“username”将会是 key 值,我们的用户名/电子邮箱就是对应的 value 值(在其他的网站上这些 key 值可能是 “email”,“ user_name”,“ login”,等等)。最后,如果你的时间不是很紧张,并且又想快速的提高,最重要的是不怕吃苦&#x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2821

2821

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?