(10)使用Pytorch实现ResNet

ResNet要解决的问题

深度学习网络的深度对最后的分类和识别的效果有着很大的影响,所以正常想法就是能把网络设计的越深越好,但是事实上却不是这样,常规的网络的堆叠(plain network)在网络很深的时候,效果却越来越差了。

其中的原因之一即是网络越深,梯度消失的现象就越来越明显,网络的训练效果也不会很好。 但是现在浅层的网络(shallower network)又无法明显提升网络的识别效果了,所以现在要解决的问题就是怎样在加深网络的情况下又解决梯度消失的问题。

ResNet的解决方案

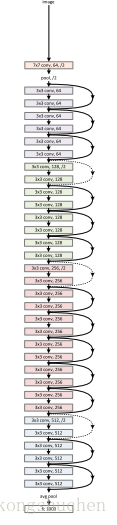

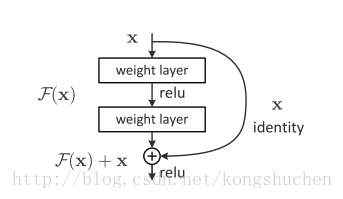

ResNet引入了残差网络结构(residual network),通过残差网络,可以把网络层弄的很深,据说现在达到了1000多层,最终的网络分类的效果也是非常好,残差网络的基本结构如下图所示

ResNet通过在输出个输入之间引入一个shortcut connection,而不是简单的堆叠网络,这样可以解决网络由于很深出现梯度消失的问题,从而可可以把网络做的很深,ResNet其中一个网络结构如下图所示

下面用Pytorch来实现ResNet:

# -*- coding:utf-8 -*-

import torch

import torch.nn as nn

import torchvision.datasets as dsets

import torchvision.transforms as transforms

from torch.autograd import Variable

# Image Preprocessing

transform = transforms.Compose([

transforms.Scale(40),

transforms.RandomHorizontalFlip(),

transforms.RandomCrop(32),

transforms.ToTensor()])

# CIFAR-10 Dataset

train_dataset = dsets.CIFAR10(root='./data/',

train=True,

transform=transform,

download=True)

test_dataset = dsets.CIFAR10(root='./data/',

train=False,

transform=transforms.ToTensor())

# Data Loader (Input Pipeline)

train_loader = torch.uti

本文介绍了ResNet为何能解决深度学习中梯度消失问题,其通过引入残差网络结构,允许网络达到上千层仍能有效训练。并展示了使用Pytorch实现ResNet的示例及运行结果。

本文介绍了ResNet为何能解决深度学习中梯度消失问题,其通过引入残差网络结构,允许网络达到上千层仍能有效训练。并展示了使用Pytorch实现ResNet的示例及运行结果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?