揭秘万亿参数大型语言模型的 AI 推理部署

AI 正在改变每个行业,解决人类面临的重大科学挑战,例如精准药物发现和自动驾驶汽车的开发,以及为了解决商业问题,自动创建电子商务产品描述和从法律合同中提取见解。

如今,每家企业都在探索大型语言模型 (LLM) 创造竞争优势的潜力。NVIDIA Cloud 合作伙伴正在介入,支持企业的 AI 之旅。例如,NexGen Cloud 为其客户提供了通过其按需云平台 Hyperstack 运行概念验证 (PoC) 的机会,然后再承诺签订大规模超级云合同。您可以立即测试运行最新一代的 NVIDIA GPU,从而快速采用其他服务层,例如 NVIDIA AI 平台。

在成功实施试点计划后,许多企业现在正在将这些计划投入生产,以增加利润。这提出了一个重要的问题:企业如何在提供出色的用户体验的同时保持强劲的投资回报?

LLM 生成映射到自然语言并发送回用户的令牌。增加 LLM 部署的令牌吞吐量可让您为更多用户提供服务,从而最大化投资回报率。然而,高吞吐量部署可能会导致较低的用户交互性,即可读文字出现在用户面前的速度,从而导致用户体验不佳。

随着 LLM 的发展,在吞吐量和用户交互性之间取得适当的平衡变得越来越具有挑战性,就像大海捞针一样。

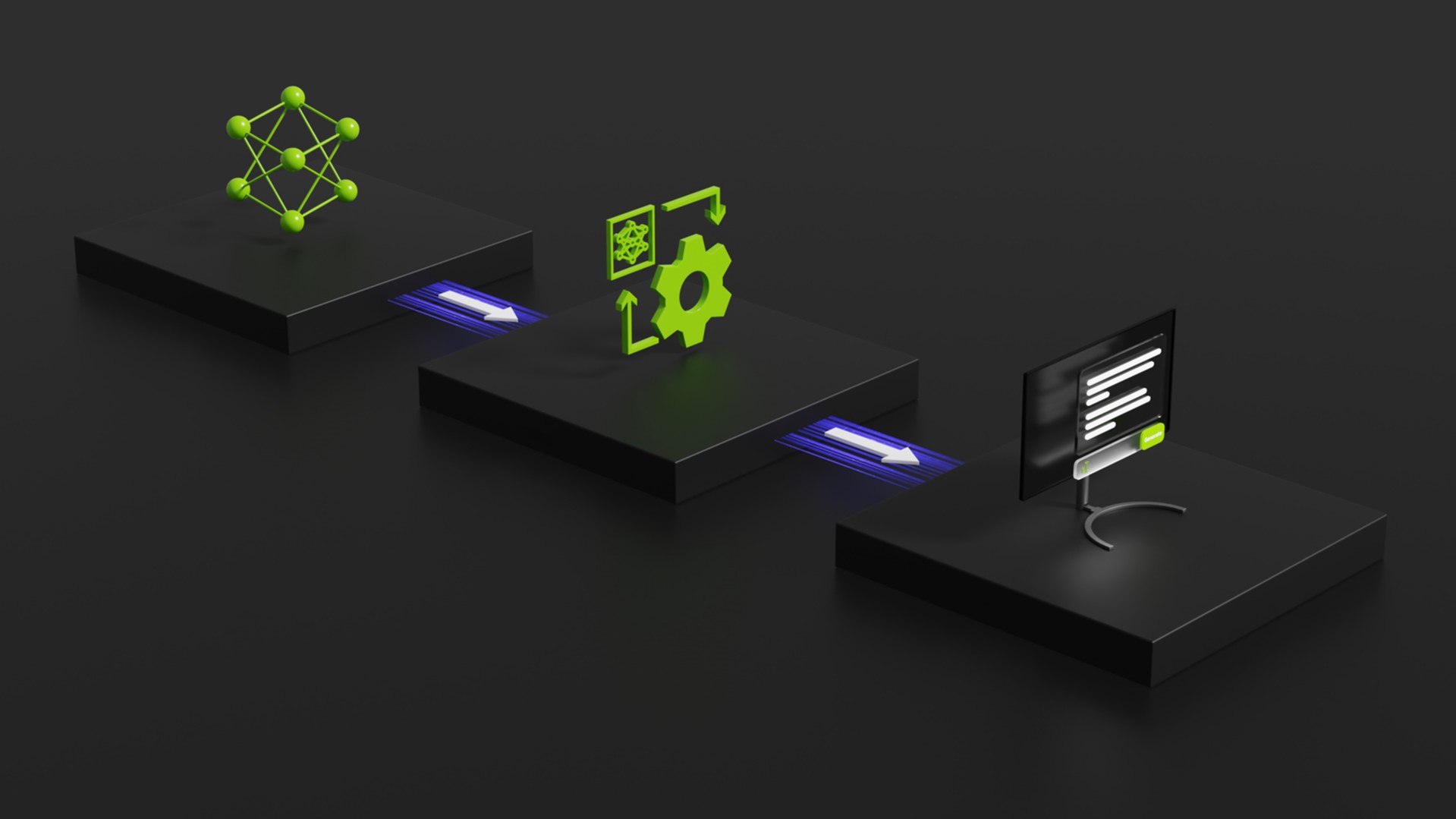

在本文中,我们讨论了不同的部署注意事项,例如批处理、并行化和分块。我们分析了这些不同的部署如何影响混合专家 (MoE) 模型的推理。例如,GPT MoE 1.8T 参数模型具有独立执行计算的子网络,然后组合结果以产生最终输出。我们还重点介绍了 NVIDIA Blackwell 和 NVIDIA AI 推理软件(包括 NVIDIA NIM)的独特功能,与上一代 GPU 相比,这些功能提高了性能。

在生产中部署 LLM 的平衡行为

在生产中部署 LLM 的企业旨在通过集成类似虚拟助手的功能来创造新的收入来源或增强其产品的吸引力。但是,他们还必须优先考虑投资回报率并确保引人注目的用户体验。

最大化投资回报率需要在不产生额外基础设施成本的情况下满足更多用户请求。要实现这一点,需要批量处理不同的用户请求并同时处理它们。此设置可最大限度地提高 GPU 资源利用率(每秒每 GPU 的令牌数),使组织能够将其 AI 投资分摊到尽可能多的用户身上。

另一方面,用户体验取决于用户等待 LLM 回复的时间。这以每个用户每秒的令牌数来衡量。

为了最大限度地提高用户交互性,将较小批次的用户请求输入到 GPU,从而最大限度地增加分配给每个请求的 GPU 资源量。批次越小,可以分配给每个请求的 GPU 资源就越多。这种方法可以实现计算操作的并行化,从而加快输出 token 的生成速度,但可能会导致 GPU 资源利用不足。

显然,这两个目标需要权衡。最大化 GPU 吞

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?