CUDA Dynamic Parallelism深度解析

1. 引言

在现代高性能计算领域,GPU已经成为处理并行计算任务的主力军。NVIDIA的CUDA(Compute Unified Device Architecture)作为一种通用并行计算平台和编程模型,使开发者能够利用GPU的强大计算能力来解决各种复杂问题。而CUDA Dynamic Parallelism(动态并行)作为CUDA编程模型的一个重要扩展,为开发者提供了更灵活、更强大的并行编程能力。

本文将深入探讨CUDA Dynamic Parallelism的概念、工作原理、编程接口以及实际应用场景,并通过丰富的代码示例和图表来帮助读者全面理解这一技术。

2. 什么是CUDA Dynamic Parallelism

2.1 基本概念

CUDA Dynamic Parallelism是CUDA编程模型的一个扩展,它允许CUDA内核直接在GPU上创建和同步新的工作(即启动新的内核)。在传统的CUDA编程模型中,只有CPU(主机)能够启动GPU内核,而Dynamic Parallelism使得GPU线程也能够启动新的内核,从而实现更灵活的并行计算模式。

Dynamic Parallelism的核心优势在于,它使得并行计算可以在程序的任何需要的地方动态创建,而不需要CPU的干预。这种能力为处理递归算法、自适应网格细化、不规则数据结构等复杂问题提供了更直接、更高效的解决方案。

2.2 Dynamic Parallelism的优势

使用Dynamic Parallelism有以下几个主要优势:

-

减少主机-设备数据传输:由于内核可以直接在GPU上启动新的内核,无需将控制权返回给CPU,因此减少了主机和设备之间的数据传输和同步开销。

-

运行时决策:线程可以在运行时根据数据特性动态决定启动配置,使得计算资源的分配更加灵活和高效。

-

支持递归和不规则算法:传统的单级并行模型难以表达递归、不规则循环结构等复杂算法,而Dynamic Parallelism使这些算法可以更自然地实现。

-

利用GPU硬件调度器:Dynamic Parallelism能够充分利用GPU的硬件调度器和负载均衡器,根据数据驱动的决策或工作负载动态适应和调整计算资源。

2.3 支持的设备

需要注意的是,Dynamic Parallelism只在计算能力3.5及以上的NVIDIA GPU设备上受支持。在使用这一特性前,请确保您的硬件满足要求。

3. 执行环境和内存模型

3.1 父子网格关系

在Dynamic Parallelism中,启动新网格的线程所属的网格被称为"父网格",而被启动的新网格则被称为"子网格"。父子网格之间存在明确的嵌套关系:

- 父网格中的线程可以启动子网格

- 子网格完成前,父网格不会被视为完成

- 运行时保证父子网格之间的隐式同步

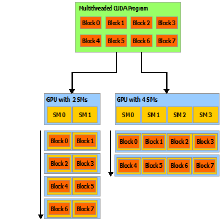

下图展示了父子网格的嵌套启动关系:

3.2 内存一致性和可见性

在Dynamic Parallelism中,内存模型遵循以下规则:

- 所有网格中的线程共享同一个全局内存空间

- 子网格可以访问父网格分配的内存

- 父网格可以访问子网格分配的内存

- 内存操作的顺序和可见性遵循CUDA内存一致性模型

这种统一的内存模型使得父子网格之间可以方便地共享数据,而不需要额外的数据传输操作。

4. 编程接口

4.1 内核启动语法

在Dynamic Parallelism中,设备端内核启动使用与主机端相同的语法:

kernel_name<<< Dg, Db, Ns, S >>>(kernel arguments);

其中:

Dg:指定网格的维度和大小(类型为dim3)Db:指定线程块的维度和大小(类型为dim3)Ns:指定每个线程块动态分配的共享内存大小(类型为size_t)S:指定与此调用关联的流(类型为cudaStream_t)

4.2 同步机制

设备端内核启动与主机端一样是异步的,这意味着启动命令会立即返回,而启动线程会继续执行。为了等待子网格完成,可以使用以下同步机制:

-

隐式同步:当父网格中的所有线程完成执行时,运行时会自动等待所有子网格完成。

-

显式同步:使用

cudaDeviceSynchronize()函数可以显式等待所有未完成的设备工作完成。 -

流同步:使用

cudaStreamSynchronize()函数可以等待特定流中的所有操作完成。 -

事件同步:使用CUDA事件可以更细粒度地控制同步点。

4.3 错误处理

在设备代码中,可以使用cudaGetLastError()函数检查内核启动是否成功。如果启动失败,应该采取适当的错误处理措施,例如提前返回或设置错误标志。

5. 代码示例

下面通过几个具体的代码示例来展示CUDA Dynamic Parallelism的使用方法和应用场景。

5.1 Hello World示例

首先,让我们看一个简单的Hello World示例,展示基本的父子内核交互:

#include <stdio.h>

// 定义子内核函数

__global__ void childKernel()

{

// 子内核简单地打印"Hello"

printf("Hello ");

}

// 定义尾部内核函数

__global__ void tailKernel()

{

// 尾部内核打印"World!\n"

printf("World!\n");

}

// 定义父内核函数

__global__ void parentKernel()

{

// 启动子内核

// <<< >>> 是CUDA的核函数启动语法,指定网格和块的维度

// 这里启动了一个包含1个线程块,每个块1个线程的网格

childKernel<<<1,1>>>();

// 检查子内核启动是否成功

if (cudaSuccess != cudaGetLastError()) {

return;

}

// 启动尾部内核到cudaStreamTailLaunch流

// cudaStreamTailLaunch是一个特殊的流,会隐式地等待子内核完成

// 这里使用了0作为共享内存大小参数

tailKernel<<<1,1,0,cudaStreamTailLaunch>>>();

}

int main(int argc, char *argv[])

{

// 从主机端启动父内核

parentKernel<<<1,1>>>();

// 检查父内核启动是否成功

if (cudaSuccess != cudaGetLastError()) {

return 1;

}

// 等待设备上所有操作完成

// cudaDeviceSynchronize()会阻塞主机线程直到设备上所有操作完成

if (cudaSuccess != cudaDeviceSynchronize()) {

return 2;

}

return 0;

}

在这个示例中,parentKernel启动了childKernel和tailKernel。注意tailKernel使用了cudaStreamTailLaunch流,这确保它会在childKernel完成后才执行。

5.2 四叉树递归示例

下面是一个更复杂的示例,展示如何使用Dynamic Parallelism实现四叉树递归算法:

#include <stdio.h>

// 递归求解四叉树的示例

// 这个示例展示了如何使用Dynamic Parallelism来递归地划分问题

// 定义一个简单的2D区域结构

struct Region {

float x, y; // 区域左下角坐标

float width; // 区域宽度

};

// 判断区域是否需要进一步细分的函数

__device__ bool needsSubdivision(const Region& region) {

// 这里简化为当区域宽度大于某个阈值时需要细分

// 实际应用中,可能基于更复杂的条件判断

return region.width > 0.1f;

}

// 处理区域的函数

__device__ void processRegion(const Region& region) {

// 在实际应用中,这里可能会进行一些计算

// 这里简化为打印区域信息

printf("处理区域: (%.2f, %.2f) 宽度: %.2f\n", region.x, region.y, region.width);

}

// 递归处理区域的内核函数

__global__ void processQuadTreeKernel(Region region) {

// 检查是否需要进一步细分

if (needsSubdivision(region)) {

// 计算新的宽度(四等分)

float newWidth = region.width / 2.0f;

// 创建四个子区域

Region subRegions[4];

subRegions[0] = {region.x, region.y, newWidth}; // 左下

subRegions[1] = {region.x + newWidth, region.y, newWidth}; // 右下

subRegions[2] = {region.x, region.y + newWidth, newWidth}; // 左上

subRegions[3] = {region.x + newWidth, region.y + newWidth, newWidth}; // 右上

// 为每个子区域启动一个新的内核

for (int i = 0; i < 4; i++) {

// 递归调用自身,为每个子区域启动一个线程

processQuadTreeKernel<<<1, 1>>>(subRegions[i]);

}

// 等待所有子内核完成

cudaDeviceSynchronize();

} else {

// 区域足够小,直接处理

processRegion(region);

}

}

// 主机端代码

int main() {

// 定义初始区域(整个问题空间)

Region initialRegion = {0.0f, 0.0f, 1.0f}; // 从(0,0)开始的1x1区域

// 启动初始内核

processQuadTreeKernel<<<1, 1>>>(initialRegion);

// 等待所有GPU操作完成

cudaDeviceSynchronize();

// 检查错误

cudaError_t error = cudaGetLastError();

if (error != cudaSuccess) {

printf("CUDA错误: %s\n", cudaGetErrorString(error));

return -1;

}

return 0;

}

这个示例展示了如何使用Dynamic Parallelism实现四叉树递归算法。当区域需要细分时,内核会为每个子区域启动新的内核,形成递归结构。下图展示了这一过程:

5.3 自适应网格细化示例

下面是一个自适应网格细化的示例,展示如何根据数据特性动态调整计算精度:

#include <stdio.h>

// 自适应网格细化示例

// 这个示例展示了如何使用Dynamic Parallelism实现自适应网格细化

// 定义一个简单的函数,用于判断某个区域是否需要更高的计算精度

__device__ bool needsRefinement(float x, float y, float size) {

// 这里使用一个简单的条件:如果点(x,y)接近某个特定区域,则需要更高精度

// 例如,接近点(0.5, 0.5)的区域需要更高精度

float dx = x + size/2 - 0.5f;

float dy = y + size/2 - 0.5f;

float distance = sqrtf(dx*dx + dy*dy);

// 距离中心点越近,且区域尺寸较大时需要细化

return (distance < 0.3f && size > 0.05f);

}

// 计算网格点的函数

__device__ float computeValue(float x, float y) {

// 这里是一个示例计算函数,可以是任何复杂的计算

// 例如,计算一个简单的二维函数值

return sinf(x * 10) * cosf(y * 10);

}

// 处理网格的内核函数

__global__ void processGridKernel(float x, float y, float size, int depth) {

// 检查是否达到最大递归深度

if (depth >= 5) {

return;

}

// 计算当前网格点的值

float value = computeValue(x, y);

// 打印当前处理的网格信息

printf("处理网格: (%.2f, %.2f) 尺寸: %.3f 深度: %d 值: %.3f\n",

x, y, size, depth, value);

// 检查是否需要进一步细化

if (needsRefinement(x, y, size)) {

// 计算新的尺寸(四等分)

float newSize = size / 2.0f;

// 为四个子网格启动新的内核

// 左下角子网格

processGridKernel<<<1, 1>>>(x, y, newSize, depth + 1);

// 右下角子网格

processGridKernel<<<1, 1>>>(x + newSize, y, newSize, depth + 1);

// 左上角子网格

processGridKernel<<<1, 1>>>(x, y + newSize, newSize, depth + 1);

// 右上角子网格

processGridKernel<<<1, 1>>>(x + newSize, y + newSize, newSize, depth + 1);

// 等待所有子内核完成

cudaDeviceSynchronize();

}

}

// 主函数

int main() {

// 初始网格参数

float startX = 0.0f;

float startY = 0.0f;

float initialSize = 1.0f; // 初始网格大小为1x1

int initialDepth = 0; // 初始递归深度为0

// 启动初始内核

processGridKernel<<<1, 1>>>(startX, startY, initialSize, initialDepth);

// 等待所有GPU操作完成

cudaDeviceSynchronize();

// 检查错误

cudaError_t error = cudaGetLastError();

if (error != cudaSuccess) {

printf("CUDA错误: %s\n", cudaGetErrorString(error));

return -1;

}

return 0;

}

这个示例展示了如何使用Dynamic Parallelism实现自适应网格细化。根据数据特性,算法会动态决定哪些区域需要更高的计算精度,并为这些区域启动新的内核进行细化计算。下图展示了这一过程:

5.4 自适应归约示例

最后,让我们看一个自适应归约的示例,展示如何使用Dynamic Parallelism实现高效的并行归约算法:

#include <stdio.h>

// 并行归约示例

// 这个示例展示了如何使用Dynamic Parallelism实现高效的并行归约算法

// 定义一个常量,表示每个线程块处理的元素数量

#define BLOCK_SIZE 256

// 归约内核函数

__global__ void reduceKernel(float* data, float* result, int n) {

// 分配共享内存,用于线程块内的归约

__shared__ float sdata[BLOCK_SIZE];

// 计算当前线程的全局索引

int tid = threadIdx.x;

int idx = blockIdx.x * blockDim.x + threadIdx.x;

// 初始化共享内存

sdata[tid] = (idx < n) ? data[idx] : 0;

// 确保所有线程都已加载数据到共享内存

__syncthreads();

// 执行归约(求和)

for (int stride = blockDim.x/2; stride > 0; stride >>= 1) {

if (tid < stride) {

sdata[tid] += sdata[tid + stride];

}

__syncthreads();

}

// 第一个线程写入该块的结果

if (tid == 0) {

result[blockIdx.x] = sdata[0];

}

}

// 自适应归约内核函数

__global__ void adaptiveReduceKernel(float* data, float* result, int n) {

// 如果数据量足够小,直接在单个块内进行归约

if (n <= BLOCK_SIZE) {

// 分配共享内存

__shared__ float sdata[BLOCK_SIZE];

// 加载数据到共享内存

int tid = threadIdx.x;

sdata[tid] = (tid < n) ? data[tid] : 0;

__syncthreads();

// 执行归约

for (int stride = blockDim.x/2; stride > 0; stride >>= 1) {

if (tid < stride) {

sdata[tid] += sdata[tid + stride];

}

__syncthreads();

}

// 第一个线程写入最终结果

if (tid == 0) {

*result = sdata[0];

}

} else {

// 数据量较大,需要多级归约

// 计算需要的块数

int numBlocks = (n + BLOCK_SIZE - 1) / BLOCK_SIZE;

// 分配临时结果数组

float* tempResult;

cudaMalloc(&tempResult, numBlocks * sizeof(float));

// 启动第一级归约

reduceKernel<<<numBlocks, BLOCK_SIZE>>>(data, tempResult, n);

// 递归调用自身处理中间结果

// 这里展示了Dynamic Parallelism的强大之处:内核可以根据数据规模动态决定启动策略

adaptiveReduceKernel<<<1, BLOCK_SIZE>>>(tempResult, result, numBlocks);

// 释放临时内存

cudaFree(tempResult);

}

}

// 主函数

int main() {

// 数据大小

int n = 1000000;

// 分配主机内存

float* h_data = new float[n];

float h_result = 0.0f;

// 初始化数据

for (int i = 0; i < n; i++) {

h_data[i] = 1.0f; // 所有元素设为1,方便验证结果

}

// 分配设备内存

float* d_data;

float* d_result;

cudaMalloc(&d_data, n * sizeof(float));

cudaMalloc(&d_result, sizeof(float));

// 将数据从主机复制到设备

cudaMemcpy(d_data, h_data, n * sizeof(float), cudaMemcpyHostToDevice);

// 启动自适应归约内核

adaptiveReduceKernel<<<1, BLOCK_SIZE>>>(d_data, d_result, n);

// 将结果从设备复制回主机

cudaMemcpy(&h_result, d_result, sizeof(float), cudaMemcpyDeviceToHost);

// 等待所有GPU操作完成

cudaDeviceSynchronize();

// 检查错误

cudaError_t error = cudaGetLastError();

if (error != cudaSuccess) {

printf("CUDA错误: %s\n", cudaGetErrorString(error));

return -1;

}

// 打印结果

printf("归约结果: %.0f (预期结果: %d)\n", h_result, n);

// 释放内存

delete[] h_data;

cudaFree(d_data);

cudaFree(d_result);

return 0;

}

这个示例展示了如何使用Dynamic Parallelism实现自适应归约算法。根据数据规模,算法会动态决定是直接在单个块内完成归约,还是启动多级归约过程。这种自适应方法可以高效处理各种规模的数据集。

6. 编程指南和最佳实践

6.1 性能考虑

虽然Dynamic Parallelism提供了强大的功能,但使用不当可能会导致性能下降。以下是一些性能优化建议:

-

避免过度细粒度的并行:启动内核有一定的开销,如果子任务太小,启动开销可能超过计算收益。

-

合理使用同步:过度同步会降低并行度,应尽量减少不必要的同步操作。

-

注意内存分配:在设备代码中分配内存的开销较大,应尽量在主机端预分配内存或使用共享内存。

-

考虑使用流:合理使用CUDA流可以提高并行度和资源利用率。

6.2 调试技巧

调试Dynamic Parallelism程序可能比传统CUDA程序更复杂,以下是一些调试建议:

-

使用printf进行调试:在设备代码中使用printf可以帮助理解程序执行流程。

-

检查错误代码:始终检查CUDA API调用的返回值,及时捕获错误。

-

使用CUDA调试工具:NVIDIA提供了多种调试工具,如CUDA-GDB和NVIDIA Nsight,可以帮助调试复杂的Dynamic Parallelism程序。

-

逐步构建:从简单的程序开始,逐步添加复杂性,这样更容易定位问题。

6.3 常见陷阱和限制

使用Dynamic Parallelism时,需要注意以下陷阱和限制:

-

嵌套深度限制:CUDA对内核嵌套深度有限制,过深的嵌套可能导致错误。

-

资源限制:每个设备有限的资源(如寄存器、共享内存),过多的并行内核可能导致资源耗尽。

-

同步问题:不正确的同步可能导致死锁或竞争条件。

-

内存管理:在设备代码中分配和释放内存需要特别小心,避免内存泄漏。

7. 实际应用场景

CUDA Dynamic Parallelism在许多实际应用场景中都有广泛应用,包括但不限于:

-

自适应网格细化:在计算流体动力学、有限元分析等领域,可以根据问题特性动态调整网格精度。

-

递归算法:如快速排序、树遍历、图搜索等递归算法可以直接在GPU上实现。

-

自适应采样:在光线追踪、路径追踪等渲染算法中,可以根据场景复杂度动态调整采样率。

-

不规则数据结构处理:处理稀疏矩阵、四叉树、八叉树等不规则数据结构时,Dynamic Parallelism可以提供更自然的编程模型。

-

机器学习:在某些机器学习算法中,如决策树构建、聚类算法等,可以利用Dynamic Parallelism提高性能。

8. 总结

CUDA Dynamic Parallelism作为CUDA编程模型的重要扩展,为开发者提供了更灵活、更强大的并行编程能力。它允许GPU线程直接启动新的内核,从而实现更复杂的并行算法和更高效的计算模式。

通过本文的介绍和代码示例,我们深入了解了Dynamic Parallelism的概念、工作原理、编程接口以及实际应用场景。希望这些内容能够帮助读者更好地理解和应用这一强大的技术,在自己的CUDA程序中充分发挥GPU的计算潜力。

在实际应用中,合理使用Dynamic Parallelism可以显著提高程序性能,简化复杂算法的实现,但也需要注意性能优化和避免常见陷阱。随着GPU硬件和CUDA工具链的不断发展,Dynamic Parallelism将在更多领域发挥重要作用。

831

831

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?