tensorboard --logdir runs 改为 tensorboard --logdir=D:\model\tensorboard\runs

重点

在网上看了很多方法后发现将原本链接中的计算机名改为localhost,即http://localhost:6006/后能成功解决该问题,显示结果

tensorboard --logdir=D:\model\tensorboard\runs

等号后面为模型保存的路径根目录

直接运行这个命令 然后在浏览器中直接打开网址 如果是本机就是本机地址 如果不是则输入目标主机地址

1 引言

我们都知道tensorflow框架可以使用tensorboard这一高级的可视化的工具,为了使用tensorboard这一套完美的可视化工具,未免可以将其应用到Pytorch中,用于Pytorch的可视化。这里特别感谢Github上的解决方案: https://github.com/lanpa/tensorboardX。

本文主要是针对该解决方案提供一些介绍。

TensorboardX支持scalar, image, figure, histogram, audio, text, graph, onnx_graph, embedding, pr_curve and videosummaries等不同的可视化展示方式,具体介绍移步至项目Github 观看详情。

2 环境安装

本教程代码环境依赖:

python 3.6+

Pytorch 0.4.0+

tensorboardX: pip install tensorboardX、pip install tensorflow

3 代码教程

TensorboardX可以提供中很多的可视化方式,本文主要介绍scalar 和 graph,其他类型相似。

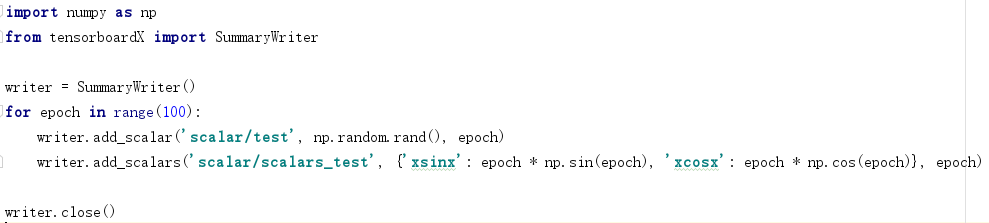

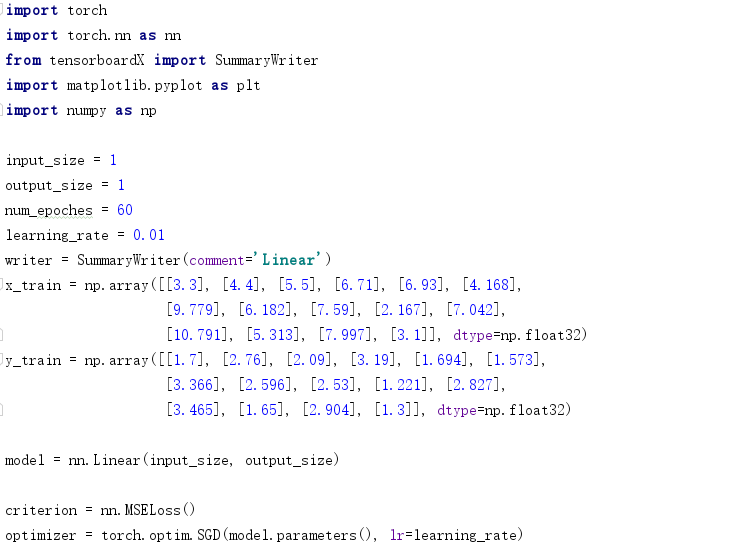

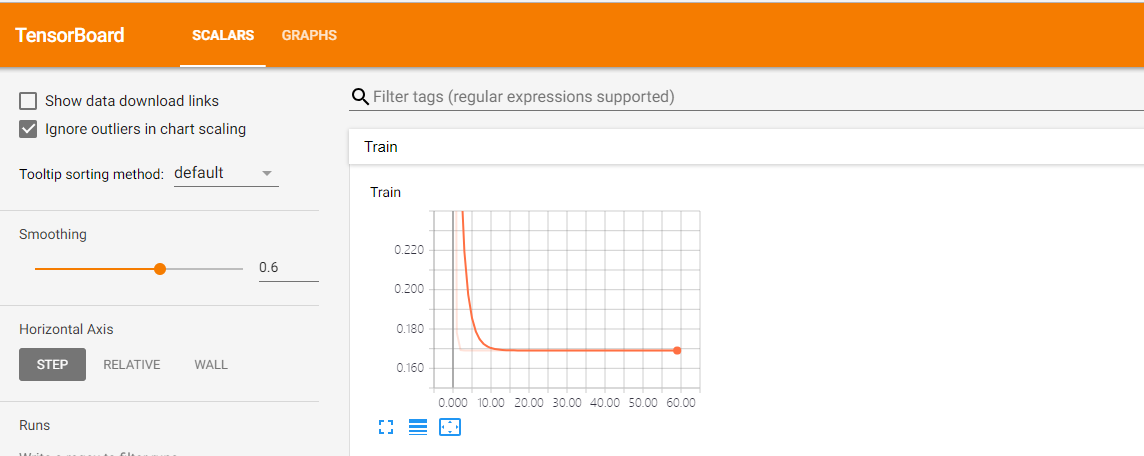

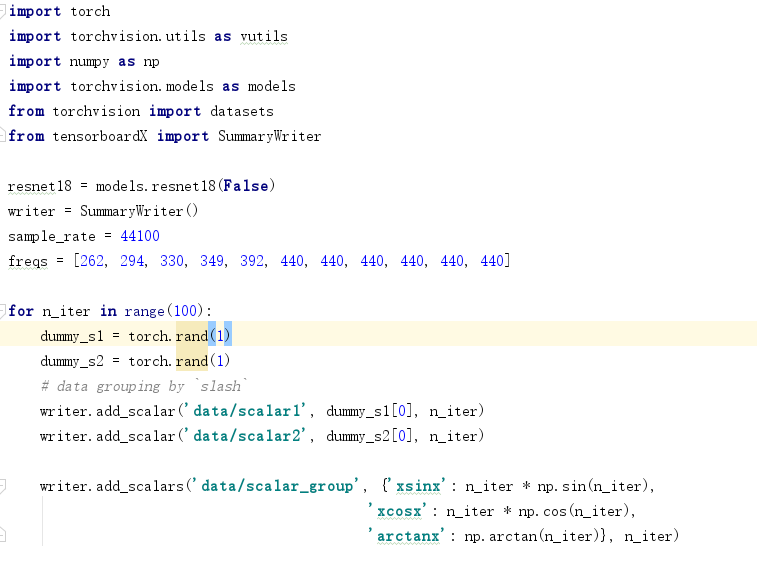

3.1 scalar教程

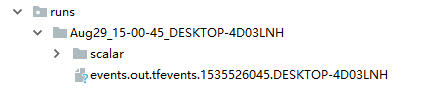

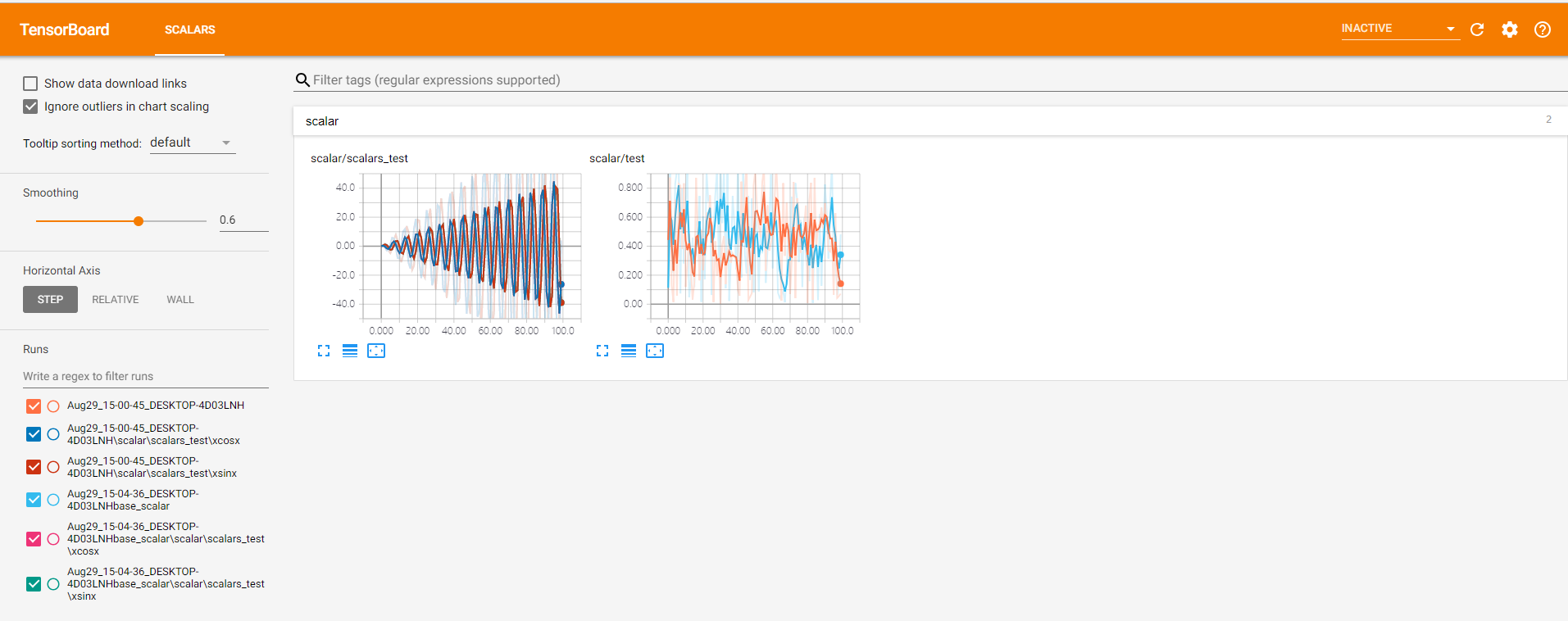

对上述代码进行解释,首先导入:from tensorboardXimport SummaryWriter,然后定义一个SummaryWriter() 实例。在SummaryWriter()上鼠标ctrl+b我们可以看到SummaryWriter()的参数为:def __init__(self, log_dir=None, comment='', **kwargs): 其中log_dir为生成的文件所放的目录,comment为文件名称。默认目录为生成runs文件夹目录。我们运行上述代码:生成结果为:

当我们为SummaryWriter(comment='base_scalar')。生成结果为:

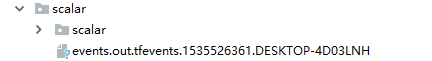

当我们为SummaryWriter(log_dir='scalar') 添加log_dir参数,可以看到第二条数据的文件名称包括了base_scalar值。生成结果目录为:

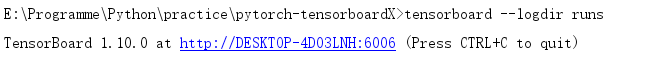

接着解释writer.add_scalar('scalar/test', np.random.rand(), epoch),这句代码的作用就是,将我们所需要的数据保存在文件里面供可视化使用。 这里是Scalar类型,所以使用writer.add_scalar(),其他的队形使用对应的函数。第一个参数可以简单理解为保存图的名称,第二个参数是可以理解为Y轴数据,第三个参数可以理解为X轴数据。当Y轴数据不止一个时,可以使用writer.add_scalars().运行代码之后生成文件之后,我们在runs同级目录下使用命令行:tensorboard --logdir runs. 当SummaryWriter(log_dir='scalar')的log_dir的参数值 存在时,将tensorboard --logdir runs 改为 tensorboard --logdir 参数值

最后调用writer.close()。

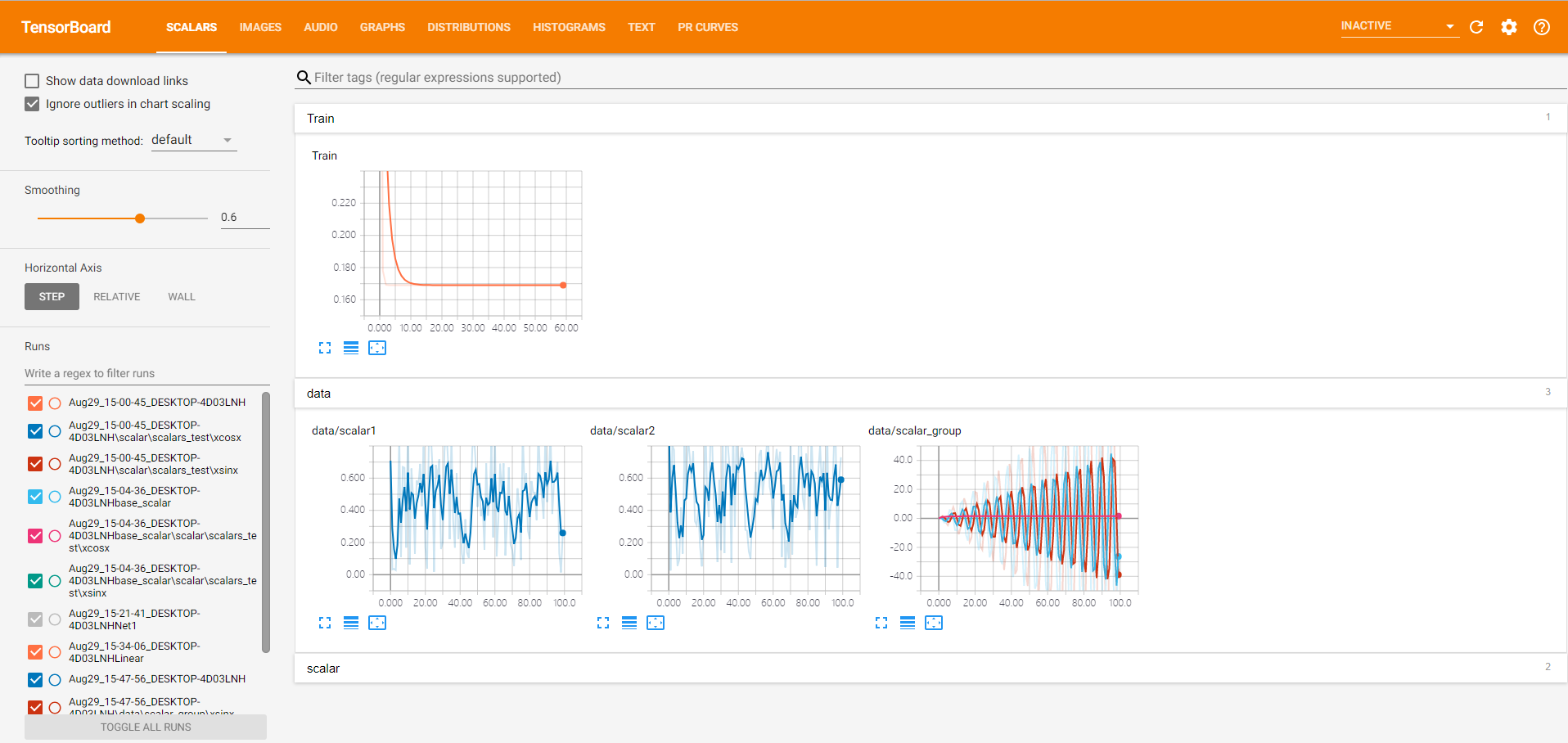

点击链接即可看到我们的最终需要的可视化结果。

可以分别点击对应的图片查看详情。可以看到生成的Scalar名称为'scalar/test'与'scalar/test'一致。注:可以使用左下角的文件选择你想显示的某个或者全部图片。

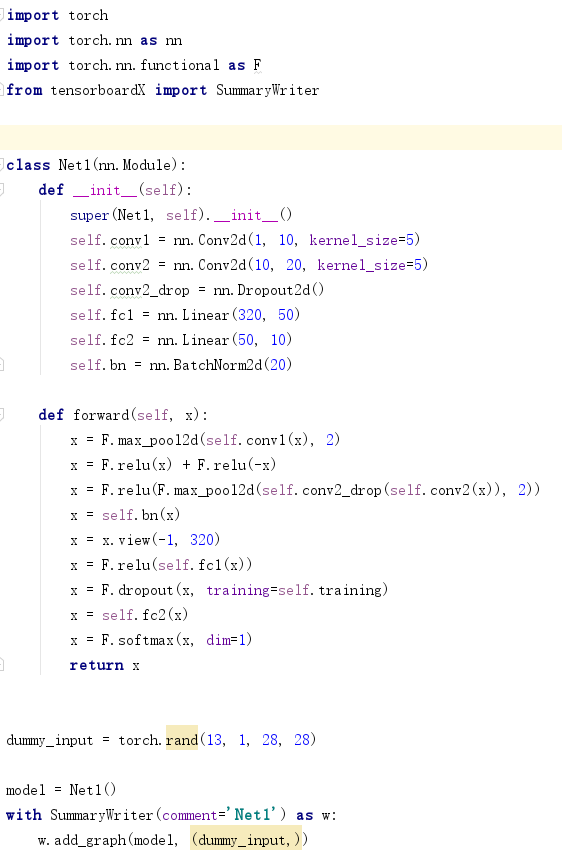

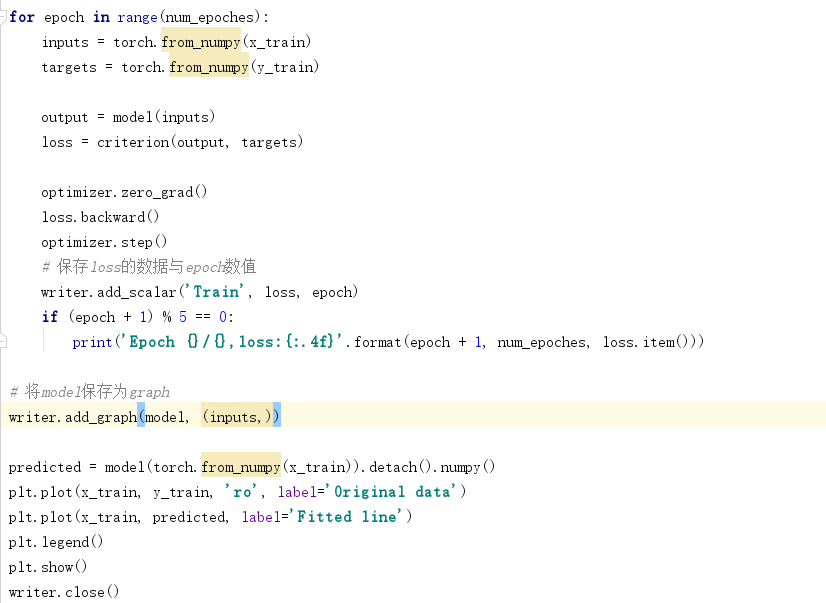

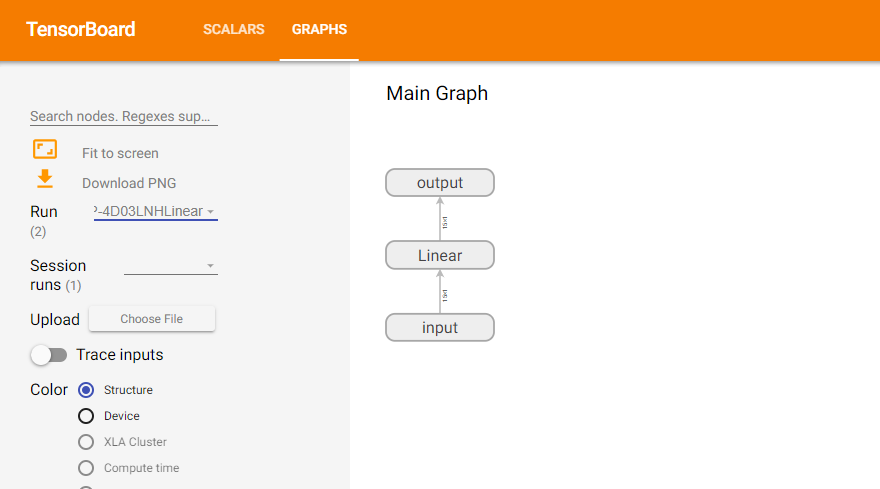

3.2 Graph教程

首先我们定义一个神经网络取名为Net1。然后将其添加到tensorboard可是可视化中。

with SummaryWriter(comment='Net1')as w:

w.add_graph(model, (dummy_input,))

我们重点关注最后两句话,其中使用了python的上下文管理,with 语句,可以避免因w.close未写造成的问题。推荐使用此方式。

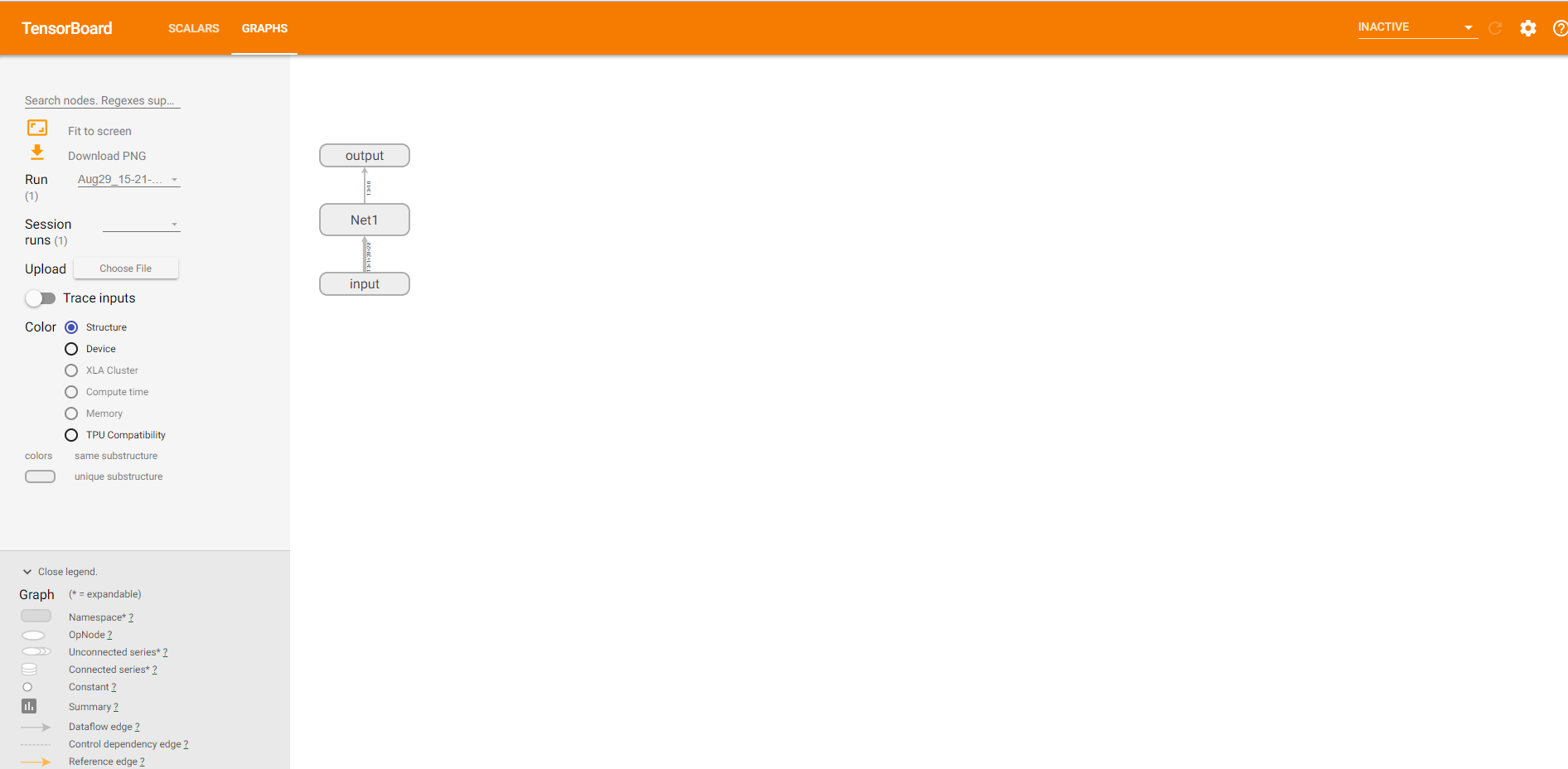

因为这是一个神经网络架构,所以使用 w.add_graph(model, (dummy_input,)),其中第一个参数为需要保存的模型,第二个参数为输入值,元祖类型。打开tensorvboard控制台,可得到如下结果。

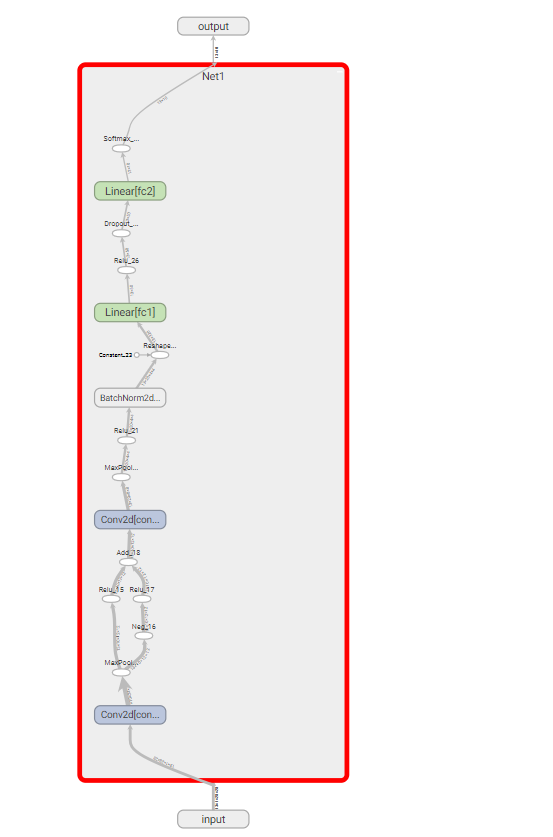

点击Net1部分可以将其网络展开,查看网络内部构造。

其他部分可以继续一次展开查看详情。

3.3 网络训练综合教程

解释完上述两部分知识之后,我们可以综合运用上述两部分内容,实现线性拟合的训练过程中的loss可视化和模型的保存。

我们将运行过程中loss和model分别保存,最后打开tensorboard控制台,可以得到模型结果和loss的结果为下图.

注:不同的graph的可视化可以使用上图Run旁边的下拉框选择。

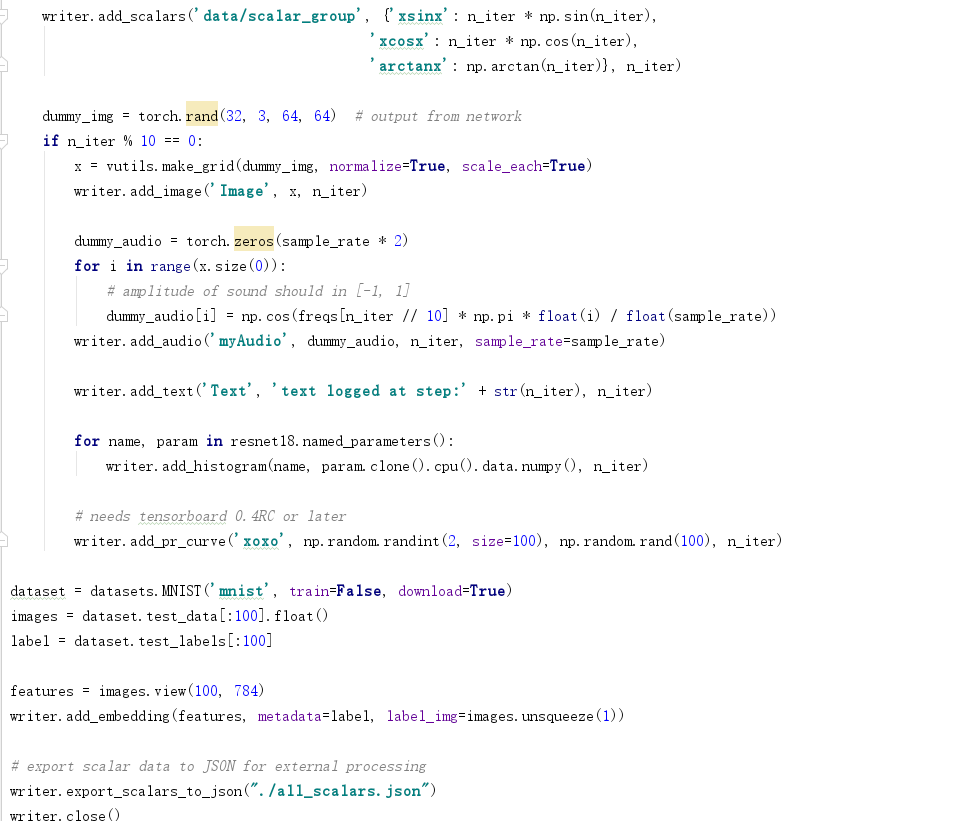

3.4 Tensorboard综合Demo

本Demo代码为TensorboardX提供的官方Demo代码。

最终运行的所有可视化结果为:

4 结束语

本文是我写的第一篇比较完整的文章,大家如果觉得帮助到了你,帮忙点个赞呗。

本文所有的代码链接为:https://github.com/miaoshuyu/pytorch-tensorboardx-visualization(对你有用的话,麻烦点个小星星呗)

13万+

13万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?