关于统计学习方法的知识,参考书《统计学习方法》,李航著,清华大学出版社。

第2章 感知机

第1节 感知机模型的概念

第2节 感知机的学习策略(或损失函数/目标函数)

第3节 感知机学习的原始形式与对偶形式

第4节 感知机模型的对偶形式

第1节 感知机模型的概念

感知机(perceptron)是二类分类的线性分类模型,输出为+1和-1。感知机对应于将输入空间(特征空间)中的实例划分为正负两类的分离超平面,属于判决模型。

感知机模型的假设空间是定义在特征空间中的所有线性分类模型。

第2节 感知机的学习策略

感知机模型建立在假设训练数据是线性可分的基础上,即假设存在这样一个超平面可以将特征空间划分为两部分,否则,训练数据将是线性不可分的,那么在线性不可分的数据上也就无法学习出一个感知机模型。

1、损失函数

能直接想到的一个简单的损失函数,就是误分类点的个数,但是这样的损失函数不是参数w和b的连续可导函数,优化问题不易求解,所以想到另一个损失函数的定义。

感知机所采用的损失函数就是,所有误分类点到超平面的总距离。

计算总距离:

首先,已知,一个点x0到超平面S的距离为:,这里分母表示w的L2范数,通常归一化到1。

其次,我们只需要计算误分类点到超平面的距离就可以了。对于误分类点(xi, yi),满足

所以,所有误分类点到平面wx+b=0的距离这样计算:

其中,M表示误分类点集合。这里把 yi 引进来,是因为损失函数中应该包括xi和yi,而y的取值是+1或-1,所以引入就很方便了。

当w的L2范数约束为等于1时,我们就可以略去分母,便得到更加简单紧凑的损失函数表达式。

第3节 感知机学习的原始形式

由上文可知,感知机模型的目标函数极小化问题是:

我们令w的L2范数为1了。

那么我们想到用梯度下降法求解这个最小化问题,这里采用随机梯度下降法(“随机”是相对于批量梯度下降法而言的,二者的区别在我转载的另一篇博文《

随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比、实现对比

》中可以看到)

那么,接下来就让我们看一下损失函数的梯度怎么求。

设学习率为eita,就是下面公式中的长尾巴n,那么选取一个误分类点(xi, yi),对w、b的更新公式为:

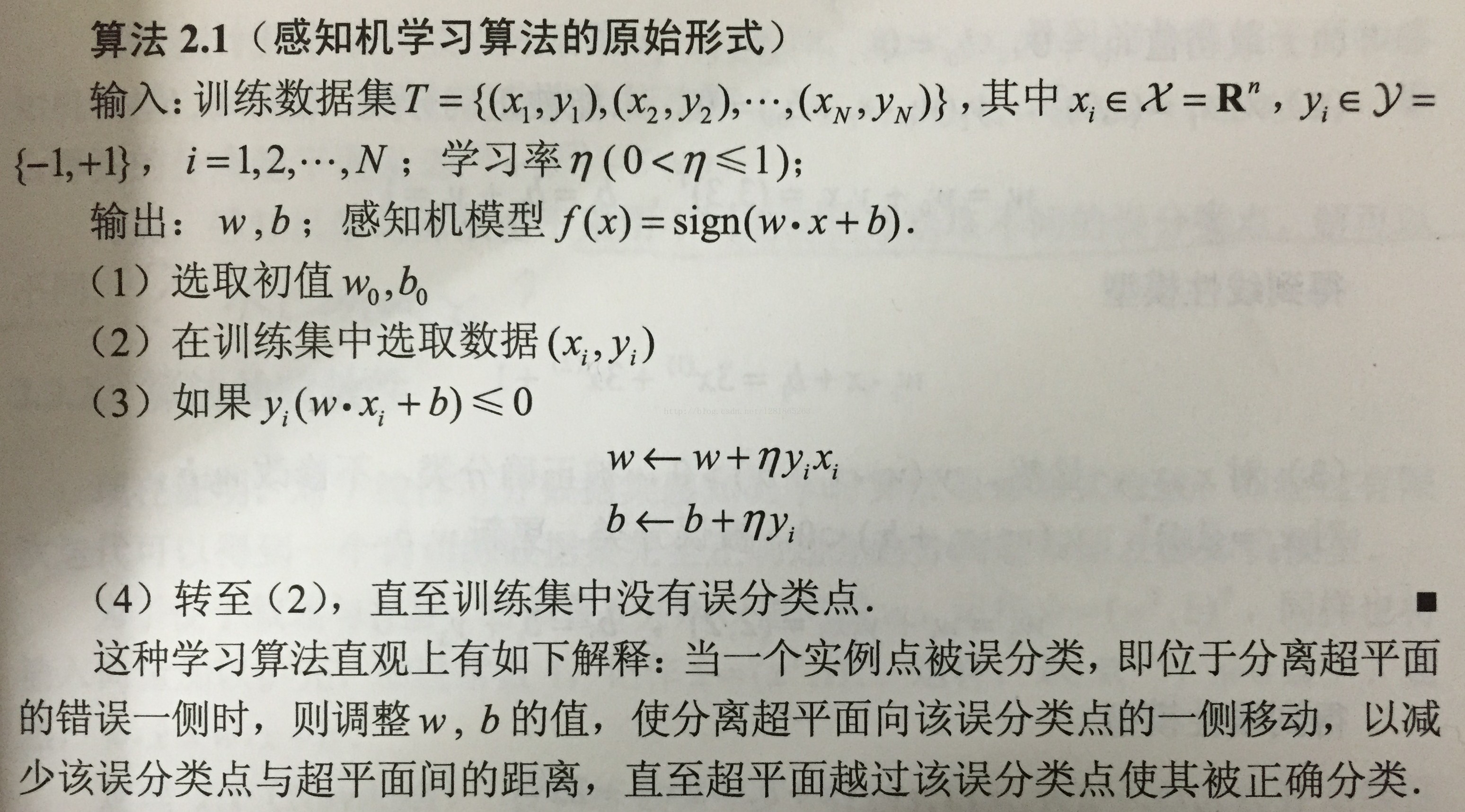

综上所述,得到感知机学习算法的原始形式:

选取不同的初始误分类点时,可能得到不同的感知机模型。

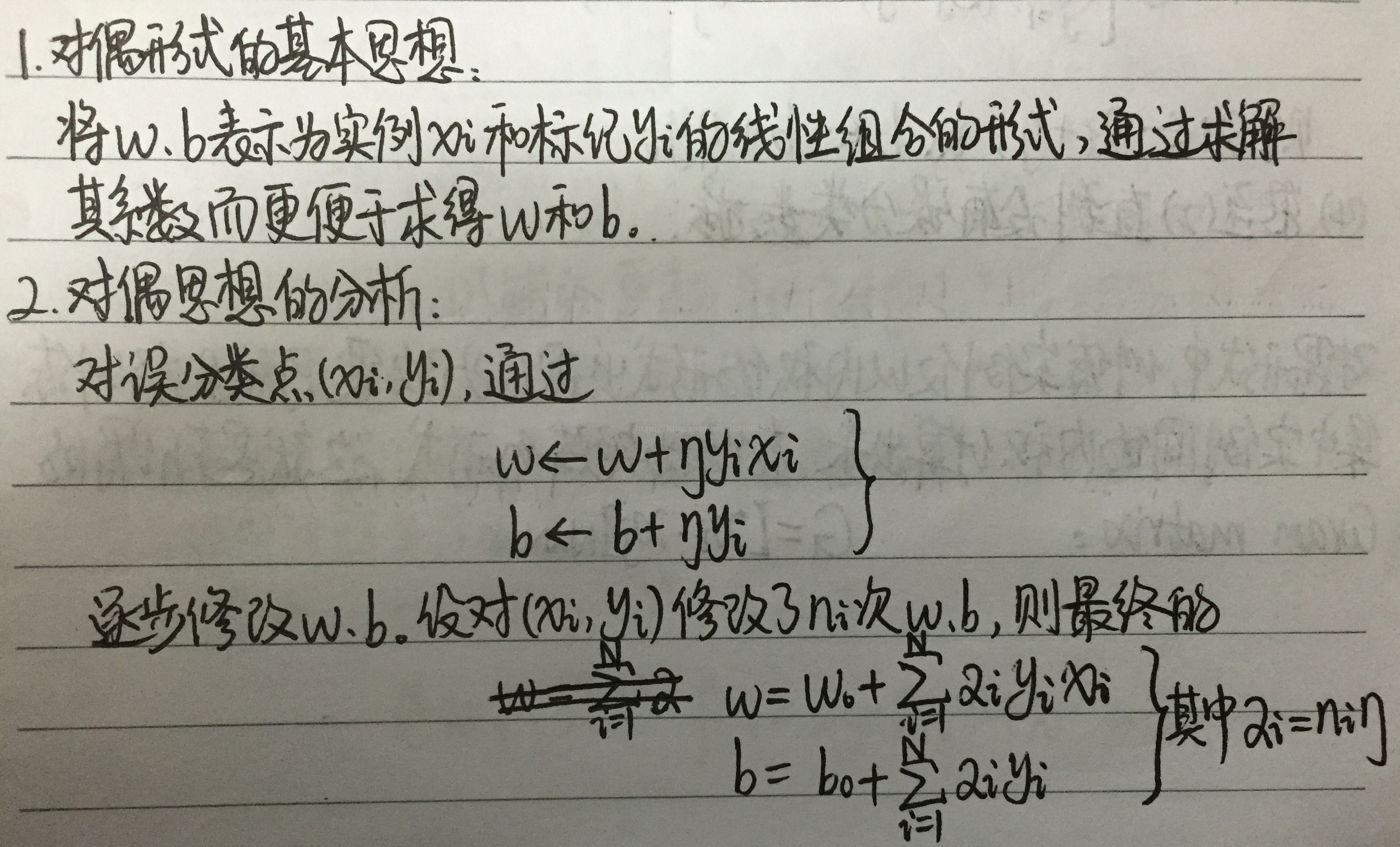

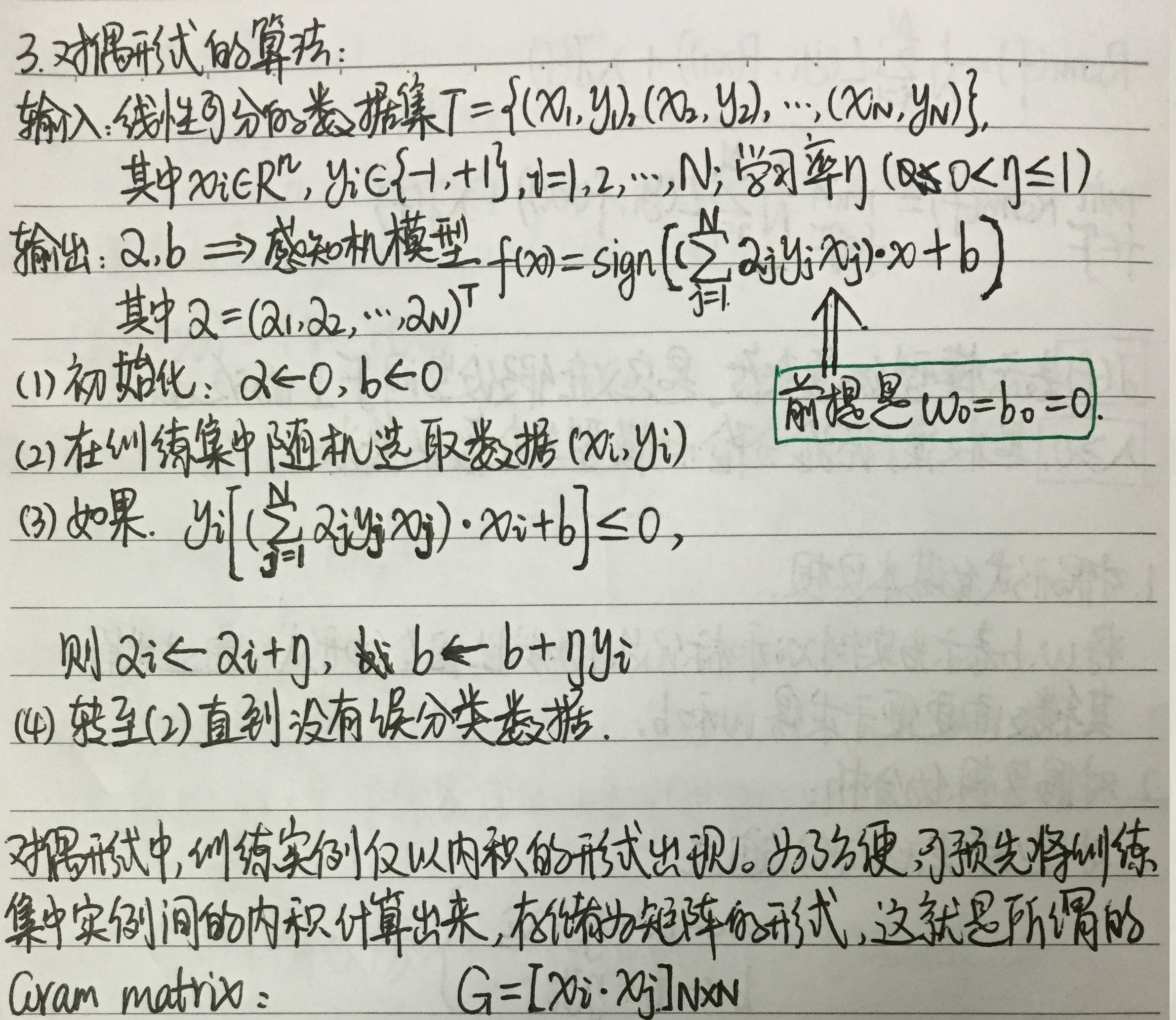

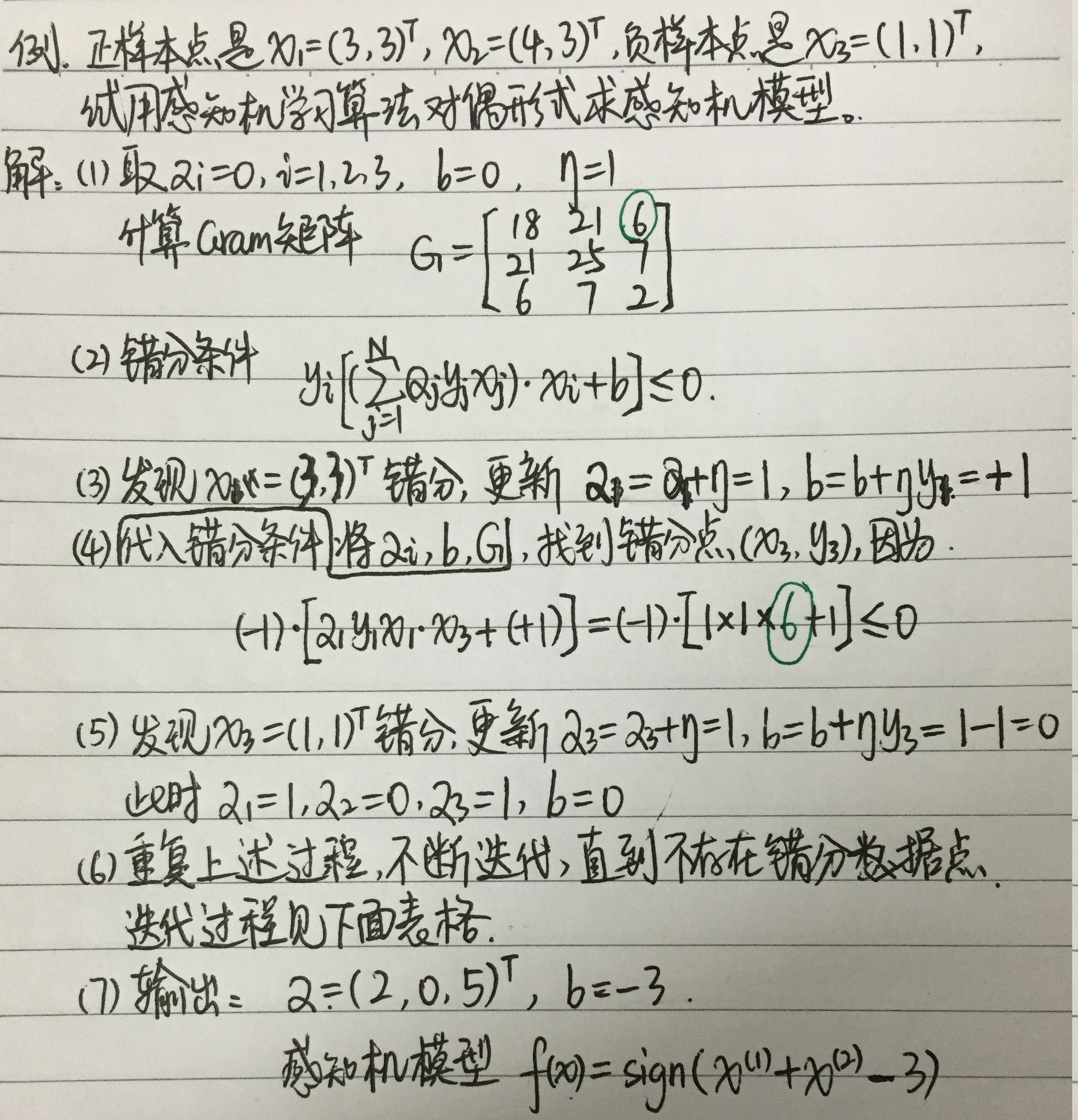

第4节 感知机模型的对偶形式

616

616

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?