Personalized Federated Learning with Theoretical Guarantees: A Model-Agnostic Meta-Learning Approach(联邦个性化元学习)

Guarantees: A Model-Agnostic Meta-Learning

Approach(联邦个性化元学习))

创新性

传统联邦学习的目标是跨多个计算单元(用户)训练模型,用户与一个公共的中央服务器进行通信,而无需交换他们的数据样本,利用了所有用户的计算能力,并使得用户们的模型在更大的数据点集上进行训练时获得更丰富的模型。**这种机制只为所有用户开发了一个共同的输出,并没有使模型适应每个用户。**特别是,在用户的基础数据分布不相同的异构环境中,通过最小化平均损失获得的全局模型一旦应用于每个用户的本地数据集,可能会表现得很差。

本文研究了联邦学习的一种个性化变体,受MAML的启发,将其联系到FedAvg,提出了Per-FedAvg。其目标是找到一个在所有用户之间共享的初始点,,当前或新用户可以通过执行一个或几个梯度下降步骤来轻松适应他们的本地数据集。从而保留了联邦学习体系结构的所有好处,并通过结构为每个用户提供了更个性化的模型。

本篇论文的贡献

研究了 FedAvg 算法的个性化变体,称为 Per-FedAvg,旨在解决提出的个性化 FL 问题。

①详细阐述了Per-FedAvg与原始 FedAvg 算法的联系,并讨论了实施 Per-FedAvg 时需要考虑的一些考虑因素。

②论述了提出的 Per-FedAvg 算法在非凸损失函数下的收敛特性。

③通过分布距离来衡量不同用户的数据异质性和数据分布的接近性,研究了其对 Per-FedAvg 的影响。

Per-FedAvg算法步骤

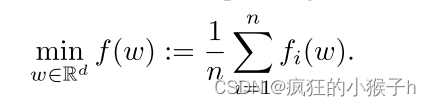

①FedAvg服务器优化目标:

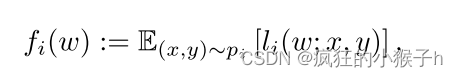

其中, f i f_{i} fi表示用户的本地损失函数:

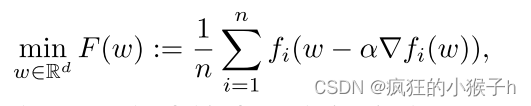

②Per-FedAvg:假设每个用户获取初始点并使用梯度下降的一步对其自己的损失函数进行更新,服务器优化目标转变为:

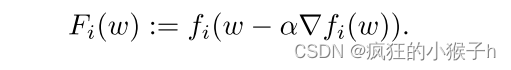

其中,中定义与用户 i 关联的元函数 F i ( w ) F_{i}(w) Fi(w)表示为:

第一步:在每一轮中,服务器选择一小部分大小为 rn (r ∈ (0, 1]) 的用户并将其当前模型参数 w k w_{k} wk<

论文笔记

论文笔记

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1978

1978

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?