联邦学习算法

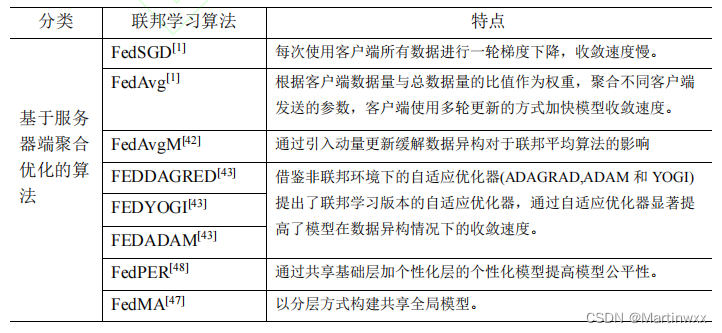

基于服务器端聚合方法优化的算法和基于客户端优化的算法。

(一)优化模型聚合的方法(基于服务器端聚合优化的算法)

- 文献[48]提出了一种基于迭代模型平均的深层网络联合学习方法,对于不平衡和非独立同分布是稳健的。

[48] ARIVAZHAGAN M G, AGGARWAL V, SINGH A K, et al. Federated learning with personalization layers[J]. arXiv preprint arXiv:1912.00818, 2019

- 联邦平均算法(FedAvg)[1]

客户端数据量相对于全体数据占比作为权重 - FedSGD[1]

使用客户端所有数据进行一轮梯度下降的方式 - FedAvgM[42]

引入动量的方法

[42] HSU T M H, QI H, BROWN M. Measuring the effects of non-identical data distribution for federated visual classification[J]. arXiv preprint arXiv:1909.06335, 2019.

- 联邦学习版本的自适应优化器

FEDADAGRAD[43],FEDYOGI[43],FEDADAM[43]

非联邦环境下的自适应优化器(ADAGRAD[44],ADAM[45]和YOGI[46])

[43] REDDI S, CHARLES Z, ZAHEER M, et al. Adaptive federated optimization[J]. arXiv preprint arXiv:2003.00295, 2020.

[44] DUCHI J, HAZAN E, SINGER Y. Adaptive subgradient methods for online learning and stochastic optimization[J]. Journal of machine learning research, 2011, 12(7).

[45] KINGMA D P, BA J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv:1412.6980, 2014.

[46] ZAHEER M, REDDI S, SACHAN D, et al. Adaptive methods for nonconvex optimization[J]. Advances in neural information processing systems, 2018, 31.

文献[47][48]提出两种分层聚合的方式

- FedPER[48]

共享基础层加个性化层的个性化联邦学习模型

其中基础层由不同客户端共同训练,个性化层由本地数据训练,

[47] WANG H, YUROCHKIN M, SUN Y, et al. Federated learning with matched averaging[J]. arXiv preprint arXiv:2002.06440, 2020.

[48] ARIVAZHAGAN M G, AGGARWAL V, SINGH A K, et al. Federated learning with personalization layers[J]. arXiv preprint arXiv:1912.00818, 2019

- 联邦匹配平均算法 FedMA[47]

以分层方式构建共享全局模型

(二)优化本地模型的更新过程(基于客户端优化的算法)

- FedProx[57]

在文献[57]中,作者进一步扩展联邦平均算法(FedAvg),提出了一种新的算法 FedProx[57],它规定客户有局部损失函数,进一步使用基于前一步权重的二次惩罚进行正则化,在 数据异构 的环境中显示出对于联邦平均算法的进步性

[57] LI T, SAHU A K, ZAHEER M, et al. Federated ptimization in heterogeneous networks[J]. Proceedings of Machine Learning and Systems, 2020, 2: 429-450.

- Fed-EMD[49]

创建一个在所有数据节点间共享的数据子集,来减少数据不平衡的影响。通讯成本高。

[49] ZHAO Y, LI M, LAI L, et al. Federated learning with non-iid data[J]. arXiv preprint arXiv:1806.00582, 2018.

- APFL[59]

通过推导全局模型和局部模型的一般边界找出最优混合参数

[59] DENG Y, KAMANI M M, MAHDAVI M. Adaptive ersonalized federated learning[J]. arXiv preprint arXiv:2003.13461, 2020.

-

联邦平均算法

受数据不平衡影响大,不同客户端本地更新的同时无法了解其他客户端的更新信息,数据异构导致更新方向漂移

利用正则化可以约束本地模型更新方向 -

SCAFFOLD[60]

控制变量(方差减少)来纠正本地更新中的“客户端漂移问题”

利用客户间的相似性,降低通信成本

[60] KARIMIREDDY S P, KALE S, MOHRI M, et al. SCAFFOLD: Stochastic Controlled Averaging for On-Device Federated Learning[J]. 2019.

- Ditto[61]

在不同客户端损失函数中引入正则化项,通过正则化项前系数控制模型在个性化和鲁棒性间的权衡

本地模型与全局模型的欧氏距离作为正则化项以鼓励个性化模型向全局最优模型靠近

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

922

922

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?