1. Compressing and regularizing deep neural networks

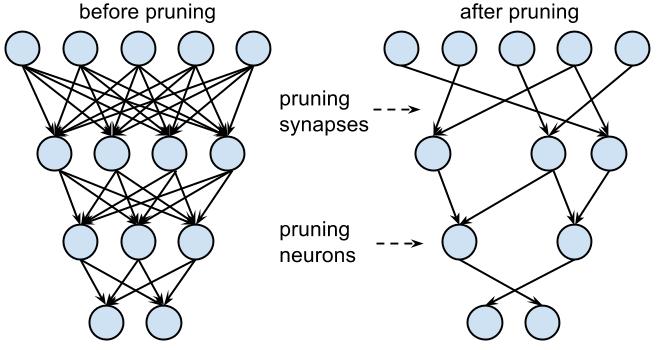

(1)权重值的大小反映了连接的重要性——删除不够重要的连接(called pruning)。

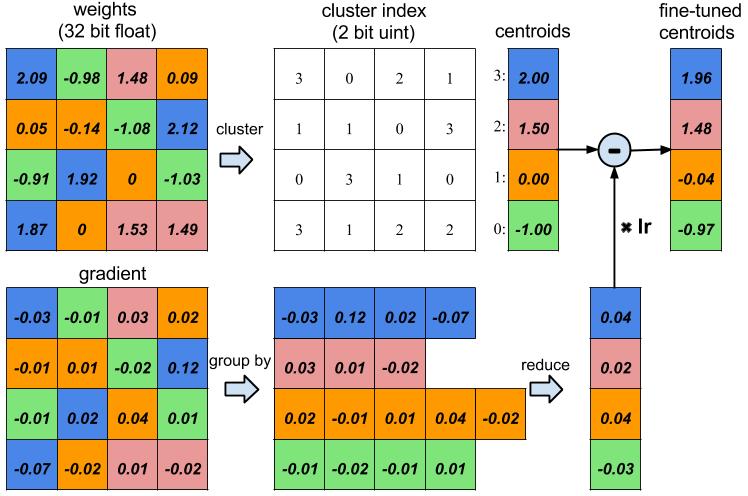

(2)权重值轻微的变动对模型的预测能力影响甚微——权重共享(值接近的权重共享同一个权重值,通过索引表查找)

——带来的好处是:减少过拟合,计算,存储,耗能。增加可解释性(私以为)。

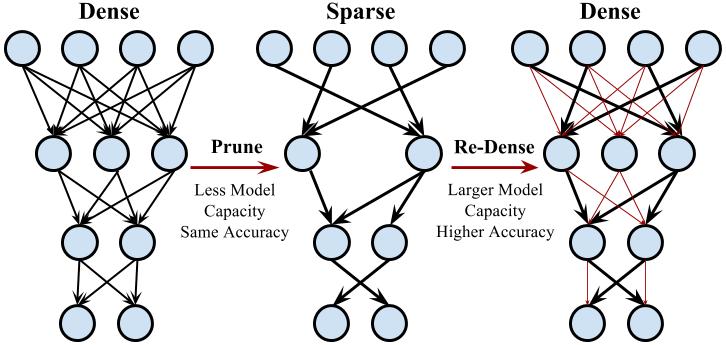

(3)Dense-Sparse-Dense(DSD):在高山参加短跑训练的运动员,回到平地跑的更快。同理,经过稀疏正则化训练的网络,重新进行稠密训练,准确率会更高。(重新稠密训练时,之前被删掉的连接权重被置为0)

参考文献:

(1)Compressing and regularizing deep neural networks

(3)DSD: DENSE-SPARSE-DENSE TRAINING FOR DEEP NEURAL NETWORKS

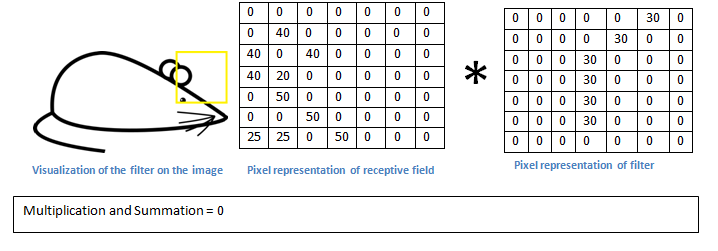

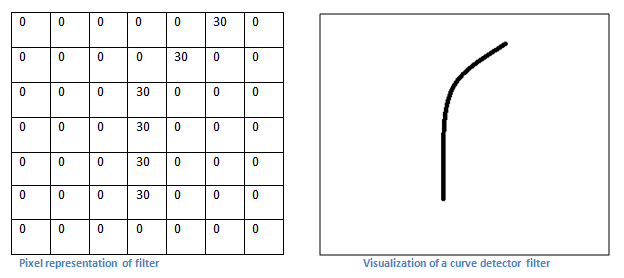

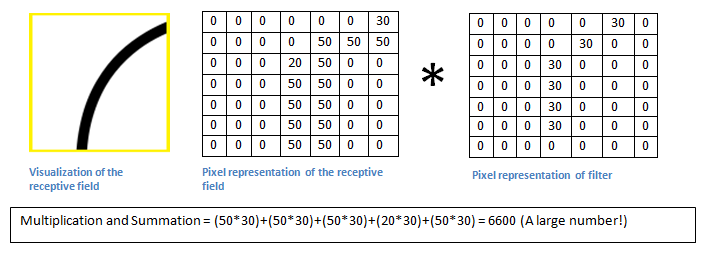

2.Filter/Kernel/Neuron in CNN:一个Filter其实应该被成为一个特殊的“feature detector”,因为其本身就代表了与某个感受野(receptive field)的匹配度。卷积的过程,实际上就是feature detector与receptive field匹配的过程,经过相应位置的相乘最后相加得到的值被输入激活函数,得到的激活值越大,则说明匹配度越高。

Filter/Neuron/Kernel/feature detector

靠谱的匹配得到更大的激活值

不靠谱的匹配得到更小的激活值

卷积结束,得到若干张特征图(一个Filter得到一张特征图,或者叫激活图)。每张特征图的每一个特征值都是前面一层每一次卷积得到的激活值。假设Filter都是5x5x1,那么第一层的Filter匹配原始图像25面积的区域特征,而当新的Filter对第一次卷积得到的特征图进行再次卷积操作时,就意味着对原始图像的25x25=625面积的区域特征进行匹配,而此时的Filter仍然是5x5x1!也就是说,此时的Filter是更抽象的“feature detector”!如果说第一层的Filter提取的特征是线条,则第二层的Filter提取的特征就是形状!网络层次越深,提取的特征越抽象。

RGB图像的Filter

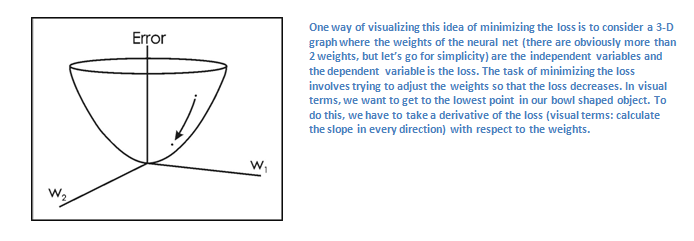

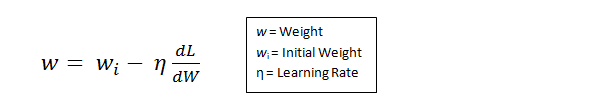

3. CNN的训练:forward pass,loss function,backward pass,upgrade weightsfor each iteration,each batch。forward pass 表示直观的学习;loss function 用于衡量学习效果;backw pass 把学习效果反馈回去,提醒下次学习注意;upgrade weights ,使用梯度下降法,找到最能改善loss function的weights,然后更新。

跟小孩子学习认人认物一样,大人在旁边教,这是爸爸,这是妈妈,这是哥哥,这是姐姐,。。。,哥哥老是认不对,于是重点练习。这样不断试错,直到学会为止。

参考文献:

(1)(2)Visualizing and Understanding Convolutional Networks

————人的幸福感主要来自健康和谐的人际关系。如果你总是跟身边的人格格不入,原因之一可能是你太在意这些人本身(长相,性格,品行,等等),但事实是,交流才是最重要的。交流是人际关系的实质所在。

735

735

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?